深度拆解|AI时代,真的能诞生一个人的十亿美元独角兽吗?

深度拆解|AI时代,真的能诞生一个人的十亿美元独角兽吗?当OpenAI的CEO Sam Altman说出"未来几年将出现第一家由一个人创立的十亿美元公司"时,整个硅谷都震惊了。这听起来像天方夜谭,但仔细想想,这个预言可能正在成为现实。传统的创业模式——从想法到融资到招聘到产品开发——正在被一种全新的范式所颠覆。

当OpenAI的CEO Sam Altman说出"未来几年将出现第一家由一个人创立的十亿美元公司"时,整个硅谷都震惊了。这听起来像天方夜谭,但仔细想想,这个预言可能正在成为现实。传统的创业模式——从想法到融资到招聘到产品开发——正在被一种全新的范式所颠覆。

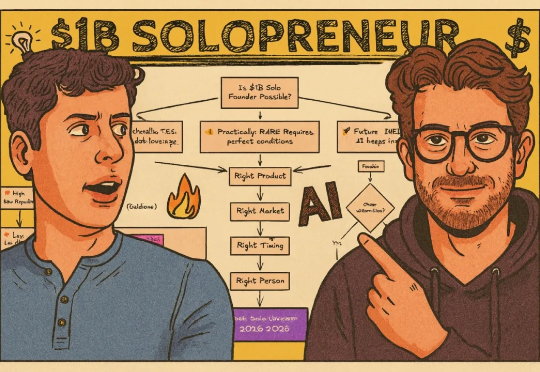

LangChain 发布了 Open SWE,这是一个完全开源的异步编码智能体,旨在在云端运行并处理复杂的软件开发任务。公司表示,Open SWE 代表了从实时“副驾驶”助手向更自主、长期运行的智能体的转变,这些智能体可以直接集成到开发人员现有的工作流程中。

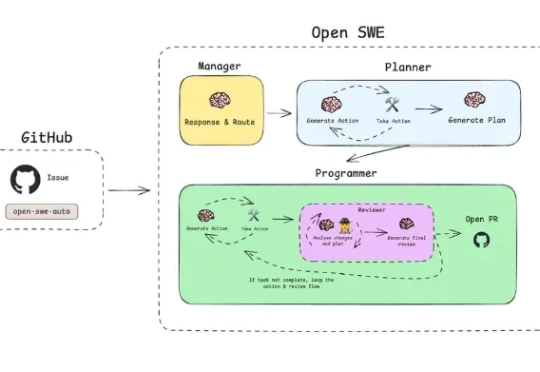

近期多项研究 [1-2] 表明,即使是经过安全对齐的大语言模型,也可能在正常开发场景中无意间生成存在漏洞的代码,为后续被利用埋下隐患;而在恶意用户手中,这类模型还能显著加速恶意软件的构建与迭代,降低攻击门槛、缩短开发周期。

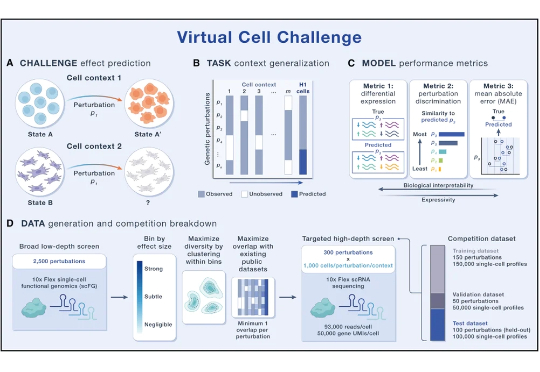

AI虚拟细胞(AIVC)旨在借助海量生物数据与AI模型,精确模拟细胞在各种基因或药物扰动下的响应状态。最近两年,AIVC正快速渗透到生命科学与医药研发领域,但仍面临数据类型繁杂、模型难以泛化、缺乏统一标准等制约。2025年6月,Arc Institute发起首届“虚拟细胞挑战赛”,通过构建统一的数据基座与测评标准体系,引导细胞建模走向规范。

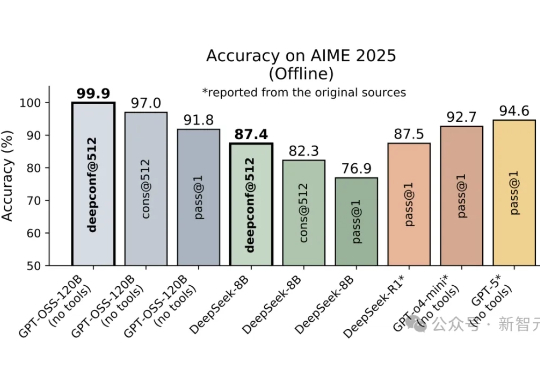

DeepConf由Meta AI与加州大学圣地亚哥分校提出,核心思路是让大模型在推理过程中实时监控置信度,低置信度路径被动态淘汰,高置信度路径则加权投票,从而兼顾准确率与效率。在AIME 2025上,它首次让开源模型无需外部工具便实现99.9%正确率,同时削减85%生成token。

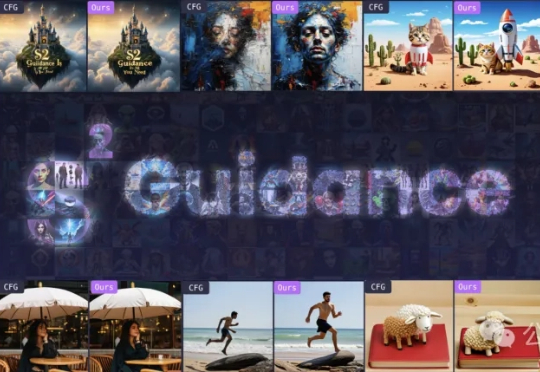

AI作画、生视频,可以「自己救自己」了?! 当大家还在为CFG(无分类器引导)的参数搞到头秃,却依然得到一堆“塑料感”废片而发愁时,来自清华大学、阿里巴巴AMAP(高德地图)、中国科学院自动化研究所的研究团队,推出全新方法S²-Guidance (Stochastic Self-Guidance)。

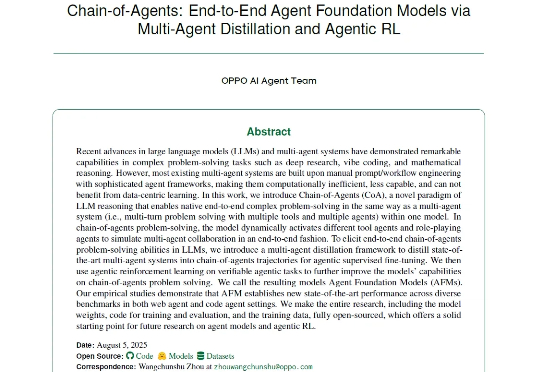

近年来,以多智能体系统(MAS)为代表的研究取得了显著进展,在深度研究、编程辅助等复杂问题求解任务中展现出强大的能力。现有的多智能体框架通过多个角色明确、工具多样的智能体协作完成复杂任务,展现出明显的优势。

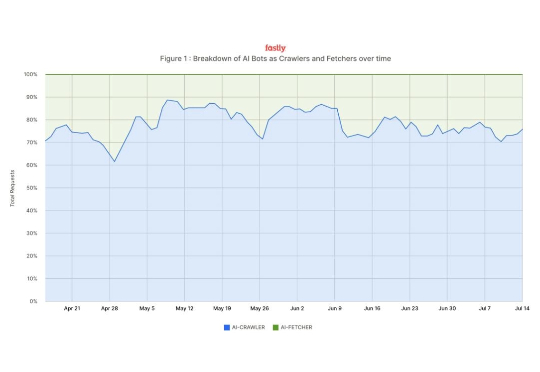

“我的网站被爬崩了,自己要付流量费,人家却用我的内容训练出 AI 模型,还赚足了眼球。” 自从 AI 机器人开始流行,很多网站开发者叫苦不堪。而近日,云服务巨头 Fastly 发布的一份报告让人看完直呼“现实往往我们仅听到的部分更为残酷。”

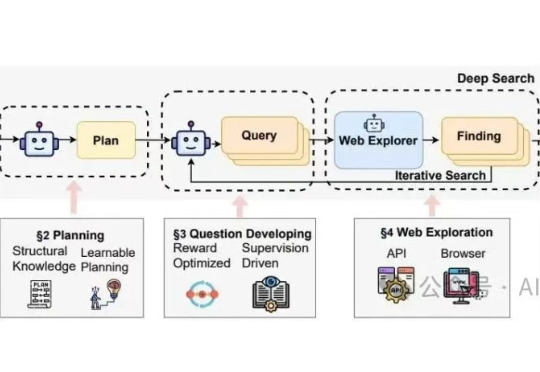

华为诺亚方舟实验室最近联合香港大学发了一篇针对"Deep Research Agents"(深度研究代理)的系统性综述,在我的印象中,这是他们第二次发布关于Deep Research的综述论文。上一篇里提供了一个结构导向 (Structure-Oriented) 的视角,核心是“分类”。

AI生成的人物和场景转头就变样,缺乏一致性? nonono,这回不一样了,康康下面的demo! 游戏地图:《塞尔达传说》中的绿色田野