A16z 4100万美元领投Mirelo,重磅押注欧洲音频大模型

A16z 4100万美元领投Mirelo,重磅押注欧洲音频大模型欧洲音频公司 Mirelo AI 刚刚拿下 4100 万美元种子轮,由 a16z 与 Index Ventures 领投。他们不是再做一个剪辑工具,而是训练自己的音频模型,主打用户给视频,Mirelo 补上所有声音。自动生成音效与配乐,并把它们精确同步到画面上。

欧洲音频公司 Mirelo AI 刚刚拿下 4100 万美元种子轮,由 a16z 与 Index Ventures 领投。他们不是再做一个剪辑工具,而是训练自己的音频模型,主打用户给视频,Mirelo 补上所有声音。自动生成音效与配乐,并把它们精确同步到画面上。

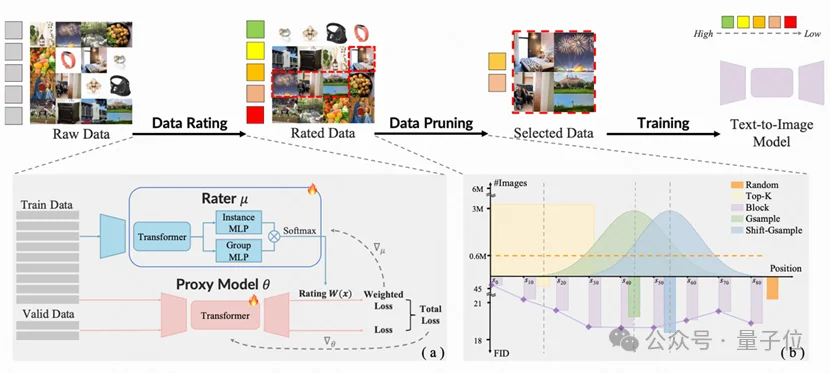

由香港大学丁凯欣领导,联合华南理工大学周洋以及快手科技Kling团队共同完成的这项研究,开发出了一个名为“炼金师”(Alchemist)的AI系统。它就像一位挑剔的大厨,能从海量图片数据中精准挑选出最有价值的一半。

英伟达在开源模型上玩的很激进: “最高效的开放模型家族”Nemotron 3,混合Mamba-Transformer MoE架构、NVFP4低精度训练全用上。而且开放得很彻底:

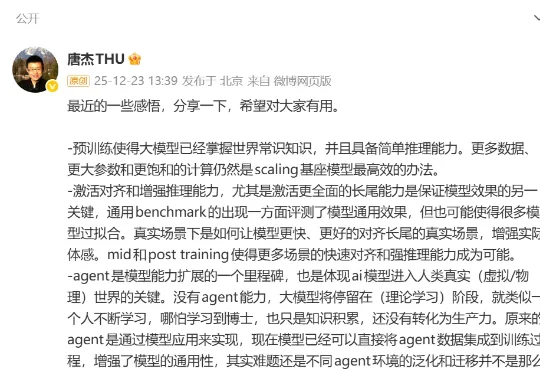

最近,清华大学教授、智谱AI首席科学家唐杰发了一条长微博,总结了自己2025年对大模型进展的感悟。从预训练到中后训练、长尾场景的对齐能力,再到Agent、多模态和具身智能的发展,其中有不少亮点。

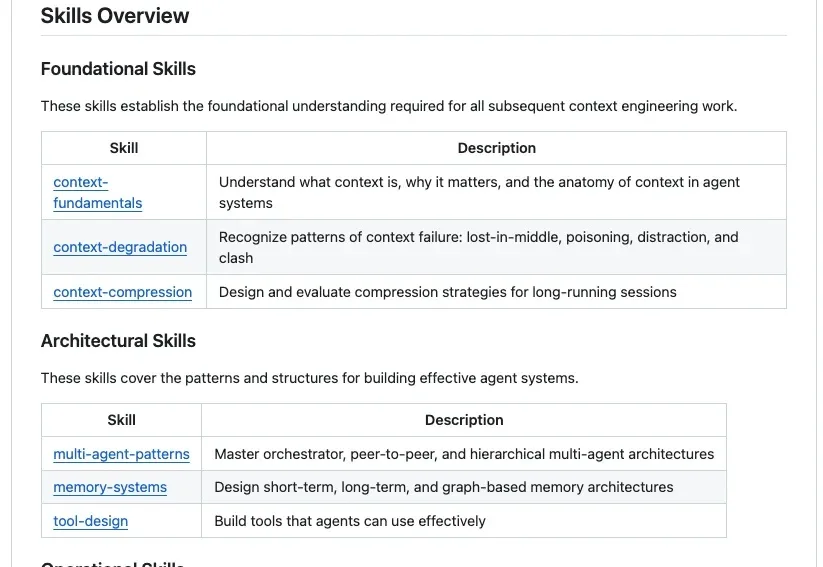

GitHub上最近出现了一个非常火的项目Agent-Skills-for-Context-Engineering,发布不到一周就斩获了2.3k Stars。为什么它能瞬间引爆社区?因为站在2025年末的节点上,我们已经受够了那些只存在于大厂白皮书里的Context Engineering(上下文工程) 理论。

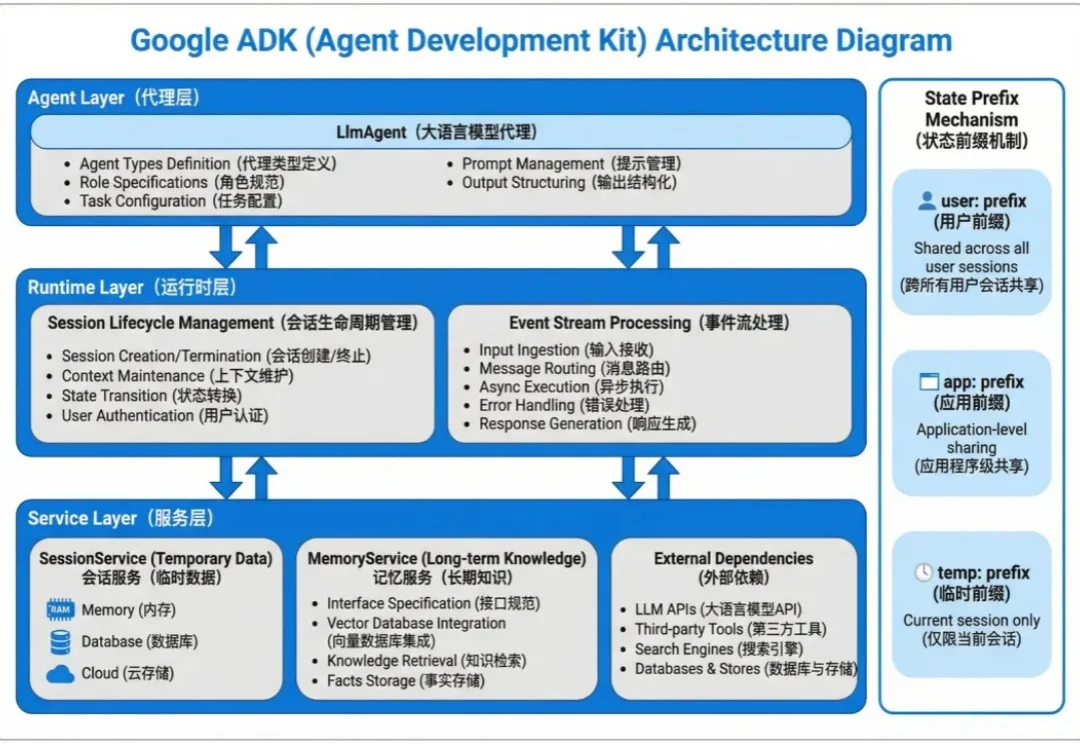

Agent 的状态数据分两种:会话内的临时上下文和跨会话的长期知识。

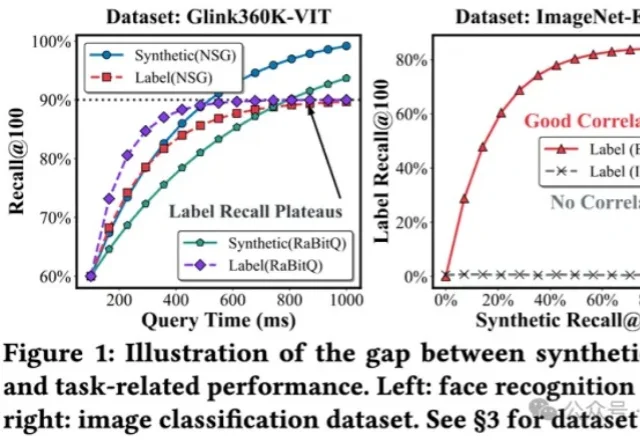

将多模态数据纳入到RAG,甚至Agent框架,是目前LLM应用领域最火热的主题之一,针对多模态数据最自然的召回方式,便是向量检索。

什么?决定 AI 上限的已不再是底座模型,而是外围的「推理编排」(Orchestration)。

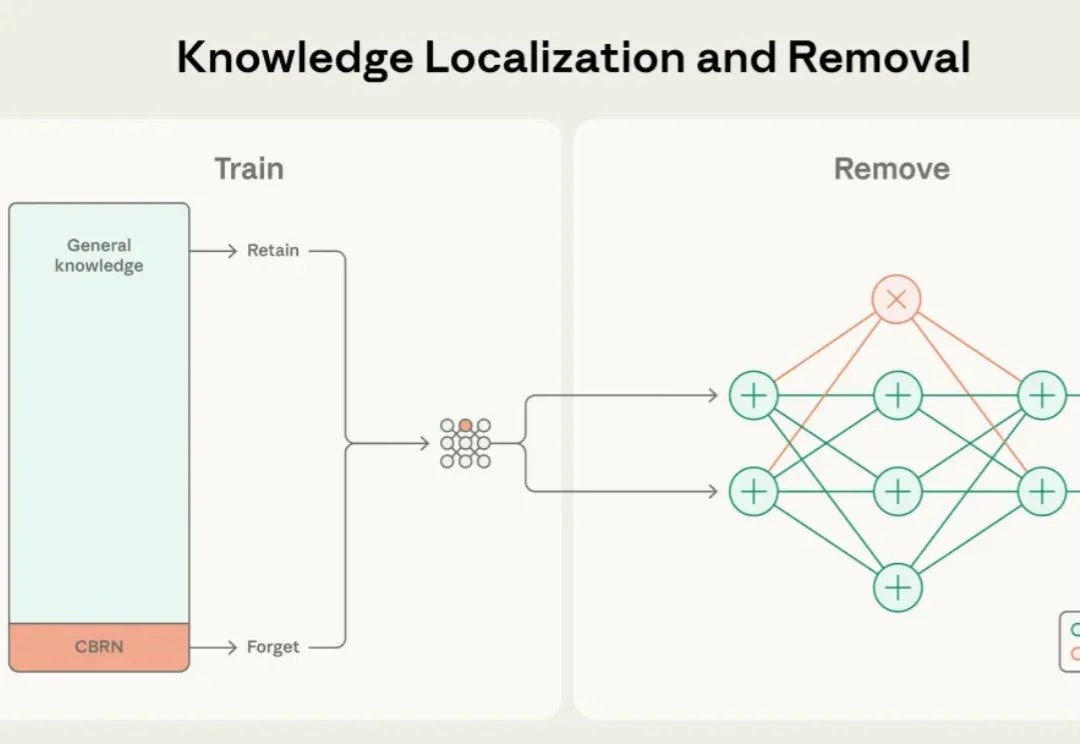

近年来,大语言模型的能力突飞猛进,但随之而来的却是愈发棘手的双重用途风险(dual-use risks)。当模型在海量公开互联网数据中学习时,它不仅掌握语言与推理能力,也不可避免地接触到 CBRN(化学、生物、放射、核)危险制造、软件漏洞利用等高敏感度、潜在危险的知识领域。

视频生成模型总是「记性不好」?生成几秒钟后物体就变形、背景就穿帮?北大、中大等机构联合发布EgoLCD,借鉴人类「长短时记忆」机制,首创稀疏KV缓存+LoRA动态适应架构,彻底解决长视频「内容漂移」难题,在EgoVid-5M基准上刷新SOTA!让AI像人一样拥有连贯的第一人称视角记忆。