面壁智能获新一轮数亿元融资

面壁智能获新一轮数亿元融资过去一年,基于高效大模型和端侧AI的商业化布局和业务推进,面壁智能有着较为迅速的行业落地进展。

过去一年,基于高效大模型和端侧AI的商业化布局和业务推进,面壁智能有着较为迅速的行业落地进展。

你敢相信 4B 参数小模型,性能却超越千亿量级的 GPT-3.5 !OpenAI、谷歌、微软、苹果等一众海内外巨头还没做到的事,被一家中国大模型公司抢先了!

这波 AI 浪潮,90 后可以说是顶起了半边天。 月之暗面的杨植麟,智元机器人的彭志辉,Meshy 的胡渊鸣,面壁智能的曾国洋... 而在他们之中,有一位年龄更小,但实力丝毫不逊各位前辈的女将。

虽然 OpenAI 反复强调 Scaling Law 是大模型最重要的原则,但事实上,GPT-4 在过去一年里缩小了 10 倍。

“从横向来看,我们显然仍与国际顶尖工作如Sora和GPT-4o有显著差距;同时,从纵向来看,我们已经从十几年的nobody,快速成长为人工智能科技创新的关键推动者。面向即将到来的AGI时代,我们应该更加自信积极地投身其中。”

本周五,一年一度的AI春晚“北京智源大会”正式开幕。本次大会AI明星浓度,放在全球范围内可能也是独一份:OpenAI Sora负责人Aditya Ramesh作为神秘嘉宾进行了分享,并接受了DiT作者谢赛宁的“拷问”、李开复与张亚勤炉边对话AGI、还集齐了国内大模型“四小龙”,百川智能CEO王小川、智谱AI CEO张鹏、月之暗面CEO杨植麟、面壁智能CEO李大海…… 这还只是第一天上午的开幕式。

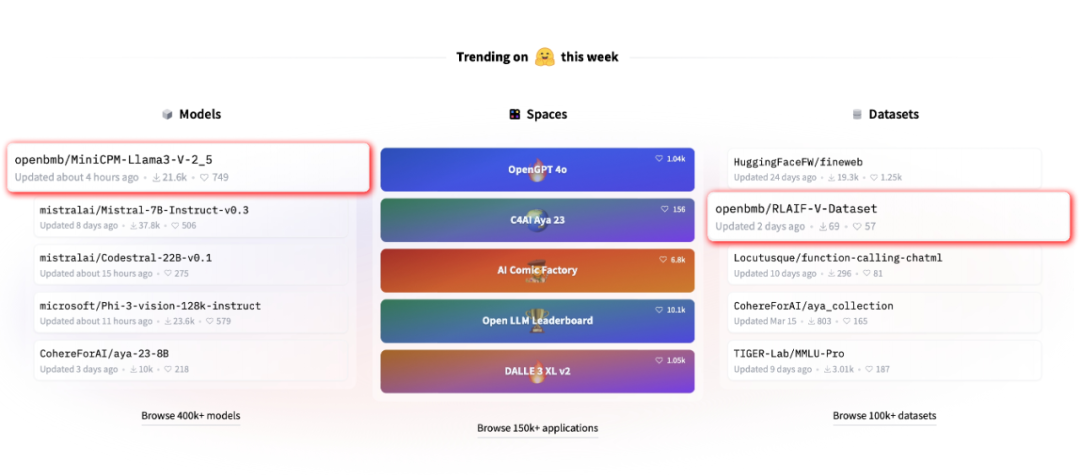

近期,由清华大学自然语言处理实验室联合面壁智能推出的全新开源多模态大模型 MiniCPM-Llama3-V 2.5 引起了广泛关注

啊?是不是看花眼了?

抄袭框架和预训练数据的情况,是更狭义的套壳。

面壁智能回应:“深表遗憾”,这也是一种“受到国际团队认可的方式”。