边缘-云协同计算通过整合边缘节点和云端资源,解决了传统云计算的延迟和带宽问题,推动了分布式智能和模型优化的发展。最新综述论文系统梳理了ECCC的架构设计、模型优化、资源管理、隐私安全和实际应用,提出了统一的分布式智能与模型优化框架,为未来研究提供了方向,包括大语言模型部署、6G整合和量子计算等前沿技术。

随着物联网(IoT)设备的激增和实时应用需求的增长,传统云计算面临延迟高、带宽受限等问题,促使边缘计算的兴起。

边缘-云协同计算(Edge-Cloud Collaborative Computing, ECCC)通过整合边缘节点和云端资源,构建了一个分布式计算范式,旨在实现高效、低延迟的智能处理。

人工智能(AI),特别是深度学习和大语言模型(LLMs)的快速发展,进一步推动了ECCC在分布式智能和模型优化领域的应用。

通过将云计算的强大算力与边缘设备的低延迟处理能力相结合,ECCC在自动驾驶、智慧医疗、工业自动化和智慧城市等领域展现出巨大潜力。

然而,边缘设备计算能力有限、能耗受限、异构性强等特性,以及动态工作负载和隐私安全需求,为ECCC带来了诸多挑战。

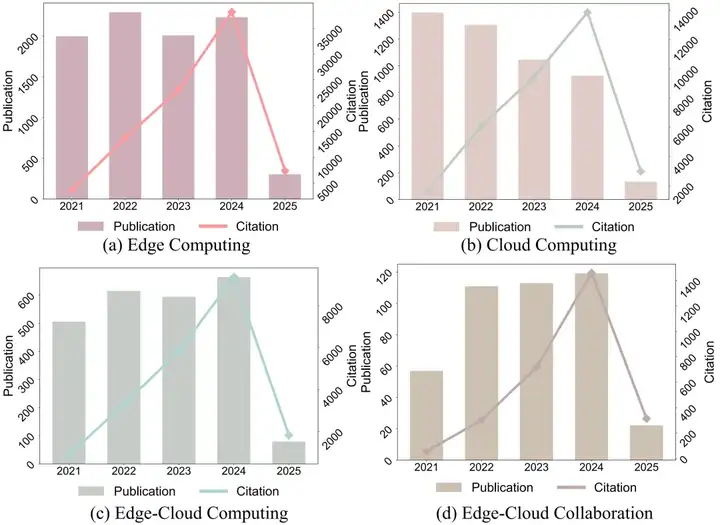

图1 边缘-云协同计算、分布式智能与模型优化的研究热度与趋势(2021-2025)

近日,由不列颠哥伦比亚大学、多伦多大学、复旦大学和昆山杜克大学等海内外知名机构研究者联合撰写的综述论文,系统梳理了ECCC的最新进展,为研究者和从业者提供了全面的技术框架与未来发展路线图。

论文链接:https://arxiv.org/abs/2505.01821

该综述从架构设计、模型优化、资源管理、隐私安全到实际应用,系统分析了ECCC的关键技术,首次提出了统一的分布式智能与模型优化框架,涵盖了从理论基础到实际部署的完整研究体系。

文章不仅总结了当前技术进展,还指出了关键挑战和未来方向,为学术界和工业界提供了重要参考。

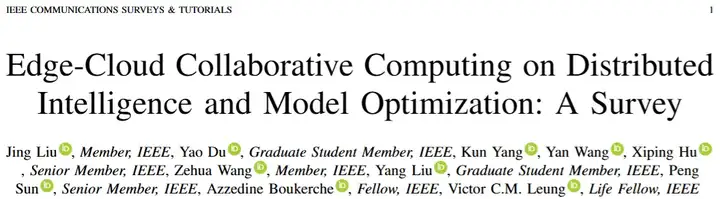

图2 综述组织架构,涵盖边缘-云协同计算的基础架构、模型优化、资源管理、隐私安全以及应用实践的技术体系

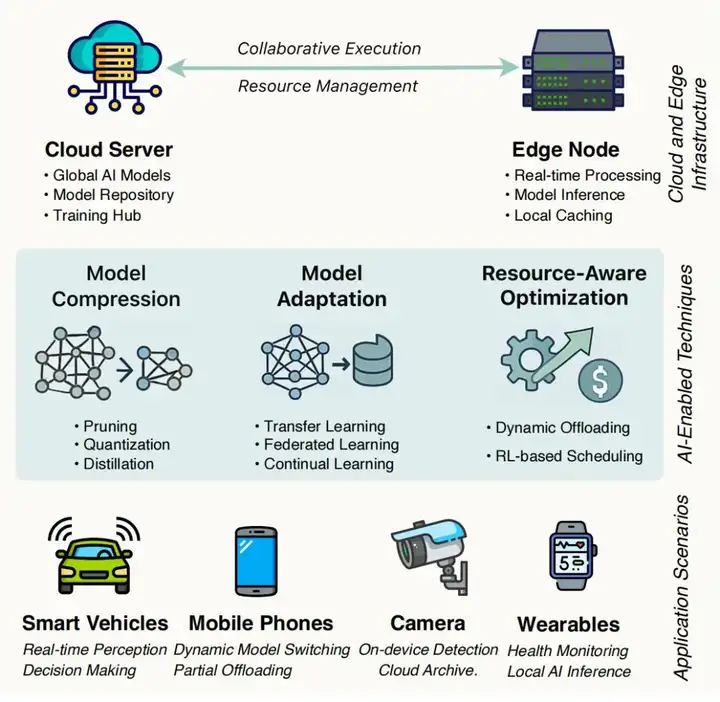

ECCC通过三层架构(云端、边缘、终端设备)实现计算与存储资源的分布式协同。

云端提供大规模计算和存储能力,适合模型训练和大数据处理;边缘层通过边缘服务器和网关实现本地化处理,降低延迟;终端设备(如智能手机、物联网传感器)负责数据生成与消费。

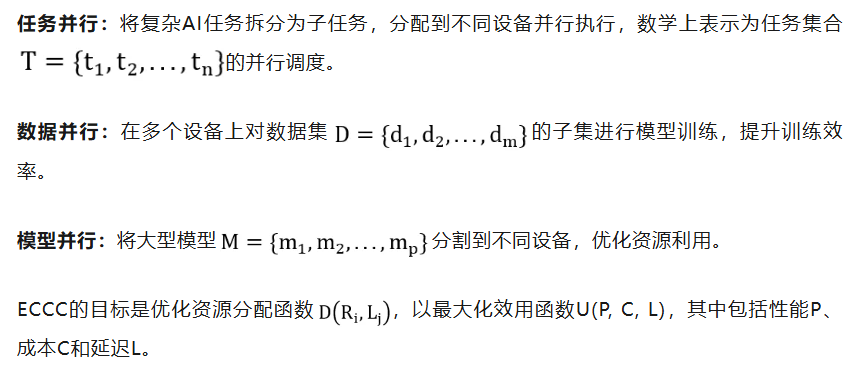

分布式智能是ECCC的核心特性,通过任务并行、数据并行和模型并行三种原则实现。

通过将计算靠近数据源,ECCC显著降低了延迟和带宽消耗,同时提升了系统的可扩展性和容错能力。

边缘设备资源受限(如计算能力、内存、能耗)对AI模型部署提出了挑战。模型优化技术通过压缩、适配和架构搜索,平衡模型性能与效率。

特别是在大语言模型时代,传统的边缘部署方法面临前所未有的挑战。大模型通常具有数十亿参数,单个模型文件可达数GB甚至数十GB,远超边缘设备的存储和计算能力。

因此,如何通过创新的模型优化技术实现大模型的高效边缘部署,已成为当前研究的热点和难点。

模型压缩

模型压缩通过减少模型大小和计算需求,适应边缘设备的资源限制,主要包括以下三类方法:

剪枝(Pruning):通过移除不重要的参数(如神经元或权重),降低模型复杂度和推理延迟。

例如,Hybrid SD 方法对 Stable Diffusion 模型的 U-Net 进行结构化剪枝,在保持图像质量的同时适配边缘设备。

量化(Quantization):将模型参数从32位浮点数转换为8位整数等低精度格式,降低内存占用和计算成本。

例如,QuAsyncFL 结合量化与异步联邦学习,优化了AIoT场景中的通信效率。

知识蒸馏(Knowledge Distillation, KD):通过训练小型「学生」模型模仿大型「教师」模型的行为,实现性能与效率的平衡。

GKT 方法利用大语言模型生成引导提示,提升边缘设备上的推理效率。

图3 边缘-云协同计算架构概念示意图,展示了研究的整体技术范围,包括集中的云资源、去中心化的边缘节点以及多样化的移动/边缘设备。

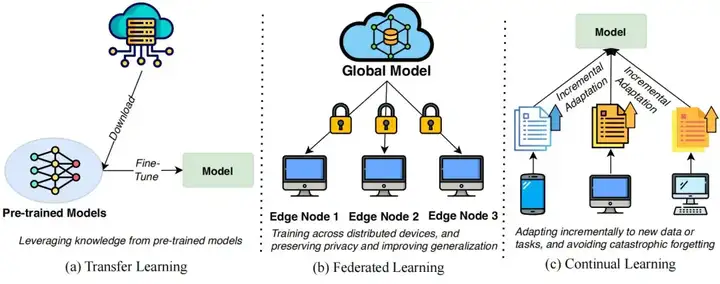

模型适配通过迁移学习(Transfer Learning, TL)、联邦学习(Federated Learning, FL)和持续学习(Continual Learning, CL)实现模型对新任务或动态环境的适配:

迁移学习:利用预训练模型的知识,快速适配到新任务。例如,在表面缺陷检测中,通过微调预训练模型实现高效部署。

联邦学习:通过分布式训练保护数据隐私,客户端在本地训练模型并上传梯度更新。例如,FedCAE 框架优化了机器故障诊断中的联邦学习效率。

持续学习:通过正则化、重放和动态架构等策略,避免灾难性遗忘,适应动态数据流。例如,EdgeC3 框架通过动态卸载优化持续学习性能。

图4 模型适配范式示意图,展示迁移学习、联邦学习和持续学习在边缘-云环境中的作用

神经架构搜索(NAS)

NAS通过自动化设计神经网络架构,提升模型性能与效率,分为以下三类:

基于强化学习的NAS:通过强化学习代理探索架构空间,优化边缘-云部署的性能。例如,RL-NAS 针对边缘设备资源约束优化模型精度与延迟。

基于进化算法的NAS:通过选择、变异和交叉操作,演化出适应边缘-云环境的架构。例如,GA-DPSO 算法优化了科学工作流的数据传输时间。

基于梯度的NAS:通过梯度下降直接搜索架构空间,快速生成高效模型。例如,DARTS 框架通过可微搜索空间实现高效架构优化。

资源管理是ECCC的核心,涉及任务卸载、资源分配和能效优化。

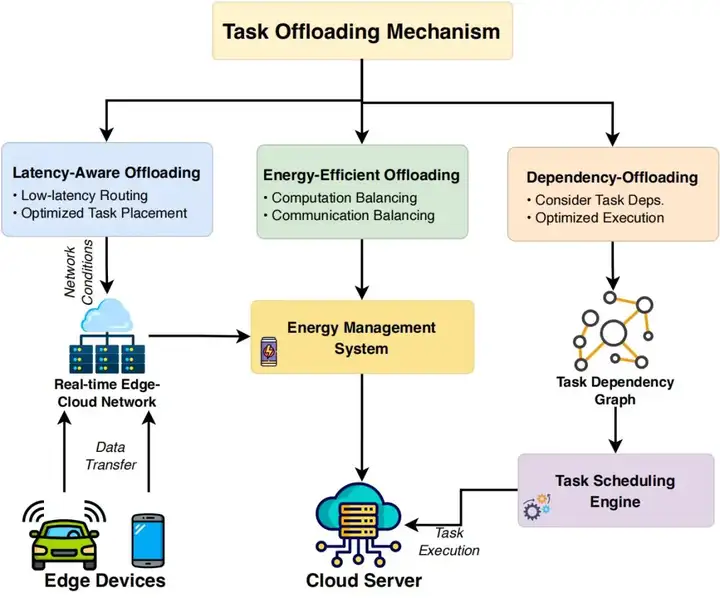

任务卸载机制

任务卸载通过将计算任务分配到边缘或云端,优化系统性能,核心策略包括:

延迟感知卸载:优先考虑低延迟任务,如 iGATS 和 DRLIS 框架通过智能放置决策减少处理延迟。

能效卸载:平衡计算与通信能耗,适用于电池驱动的边缘设备。例如,PDCO 和 ETCRA 方法显著降低了能耗。

依赖感知卸载:考虑任务依赖关系,通过有向无环图(DAG)优化调度。例如,PRAISE 算法通过重构任务调用图提升资源利用率。

图5 任务卸载机制示意图,展示延迟感知、能效和依赖感知策略

资源分配策略

资源分配通过动态调整计算、带宽和存储资源,提升系统效率:

动态资源分配:根据实时工作负载调整资源分配。例如,基于联邦强化学习的协作策略优化了无人机通信网络的资源调度。

协作资源管理:通过边缘-云和边缘-边缘协作优化资源利用。例如,OTFAC 框架结合最优传输和联邦学习提升分配效率。

基于强化学习的资源管理:通过强化学习优化资源分配策略。例如,MADDPG 算法在车辆边缘-云环境中最小化延迟。

ECCC的分布式特性使其面临隐私泄露和安全攻击的风险,需通过以下机制增强保护:

隐私保护:联邦学习通过本地化数据处理保护隐私,例如 FedCAE 框架在故障诊断中实现隐私保护。差分隐私通过添加噪声进一步增强数据安全性。

模型安全:通过加密哈希、信任执行环境(TEE)和运行时监控保护模型完整性。例如,FlexibleFL 框架通过参数评估防御模型毒化攻击。

通信安全:通过对称和非对称加密、区块链技术保护数据传输。例如,CP-ABE 方案通过属性基加密实现细粒度访问控制。

ECCC在多个领域展现了广泛应用潜力:

自动驾驶:边缘设备处理实时感知任务(如 Edge YOLO),云端支持复杂计算(如动态地图生成)。例如,EC-Drive 利用大语言模型优化运动规划。

智慧医疗:联邦学习支持隐私保护的诊断模型训练,边缘-云平台实现远程患者监控。例如,IoMT 设备通过边缘处理提供实时健康反馈。

工业自动化:边缘智能实现实时故障诊断,云端优化生产调度。例如,AIoT 设备通过异常检测提升系统可靠性。

智慧城市:边缘设备支持实时交通管理和环境监测,云端分析数据优化城市规划。例如,联邦学习支持隐私保护的公共安全模型训练。

尽管ECCC取得显著进展,仍面临以下挑战:

模型优化问题:边缘设备资源受限,需平衡模型精度与效率。大语言模型在边缘部署的推理效率是关键瓶颈。

系统集成挑战:异构硬件和软件的集成需标准化协议和高效调度算法。

性能瓶颈:通信开销、计算和存储限制影响实时应用性能。

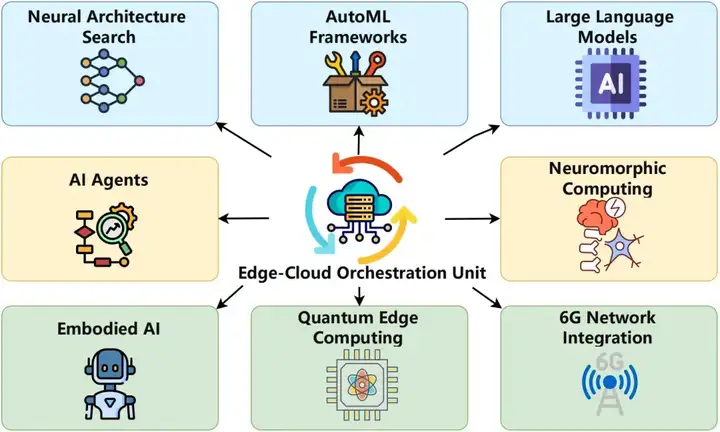

未来研究方向包括:

高级AI技术:探索神经架构搜索、AutoML、大语言模型、AI代理、具身AI、神经形态计算和量子边缘计算。

系统改进:开发动态资源管理、自适应优化和容错机制。

6G网络整合:利用6G的超低延迟和高带宽优化边缘-云系统。

图6 边缘-云协同计算的未来研究方向

研究人员首次系统梳理了边缘-云协同计算在分布式智能与模型优化领域的最新进展,构建了统一的架构框架,涵盖模型压缩、适配、资源管理、隐私安全和多领域应用。

文章客观分析了技术瓶颈,如计算效率、异构性管理和实时处理需求,并提出了未来研究方向,包括大语言模型部署、6G整合和量子计算的探索。

欢迎研究者和从业者阅读和引用改论文,共同推动边缘-云协同计算的创新发展!

@misc{liu2025edgecloud,

title = {Edge-Cloud Collaborative Computing on Distributed Intelligence and Model Optimization: A Survey},

},

author = {Liu, Jing and Du, Yao and Yang, Kun and Wang, Yan and Hu, Xiping and Wang, Zehua and Liu, Yang and Sun, Peng and Boukerche, Azzedine and Leung, Victor C. M.},

year = {2025},

primaryclass = {cs},

eprint = {2505.01821},

doi = {10.48550/arXiv.2505.01821},

url = {https://arxiv.org/abs/2505.01821},

}

参考资料:

https://arxiv.org/abs/2505.01821

文章来自于“新智元”,作者“LRST”。

【开源免费】OWL是一个完全开源免费的通用智能体项目。它可以远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」而且做到了开源界GAIA性能天花板,达到了57.7%,超越Huggingface 提出的Open Deep Research 55.15%的表现。

项目地址:GitHub:https://github.com/camel-ai/owl

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner