具身这么火,面向具身场景的生成式渲染器也来了。

中科院自动化所张兆翔教授团队研发的TC-Light,能够对具身训练任务中复杂和剧烈运动的长视频序列进行逼真的光照与纹理重渲染,同时具备良好的时序一致性和低计算成本开销。

它能够帮助减少Sim2Real Gap以及实现Real2Real的数据增强,帮助获得具身智能训练所需的海量高质量数据。

论文Demo代码均已公开。

光线及其与周围环境的交互共同塑造了人类以及具身智能体感知数字世界和现实世界的基本方式。

然而,在现实环境中采集不同光照与场景条件下的数据代价高昂,而仿真环境中尽管可以获得近乎无限的数据,但受限于算力资源,通常需要对光线的多次折射衍射以及纹理精度进行近似和简化,使得视觉真实性无可避免地受到损失,在视觉层面产生Sim2Real Gap。

而如果能够借助生成式模型根据所需的光照条件对现实或仿真环境下采集到的视频数据进行重渲染,不仅够帮助获得增加已有真实数据的多样性,并且能够弥合计算误差带来的CG感,使得从仿真器中能够得到视觉上高度真实的传感器数据,包括RL-CycleGAN在内的许多工作已经证实,这一策略能够帮助减少将具身模型迁移到真实环境中所需微调的数据量和训练量。

尽管这一任务意义重大,但实际解决过程面临许多挑战。

用于训练的视频数据往往伴随复杂的运动以及前景物体的频繁进出,同时视频序列有着较长的长度以及较高的分辨率,这使得已有的算法要么受制于训练所用视频数据的分布(如COSMOS-Transfer1,Relighting4D),要么难以承受巨大的计算开销(如Light-A-Video, RelightVid),要么难以保证良好的时序一致性(如VidToMe, RAVE等)。

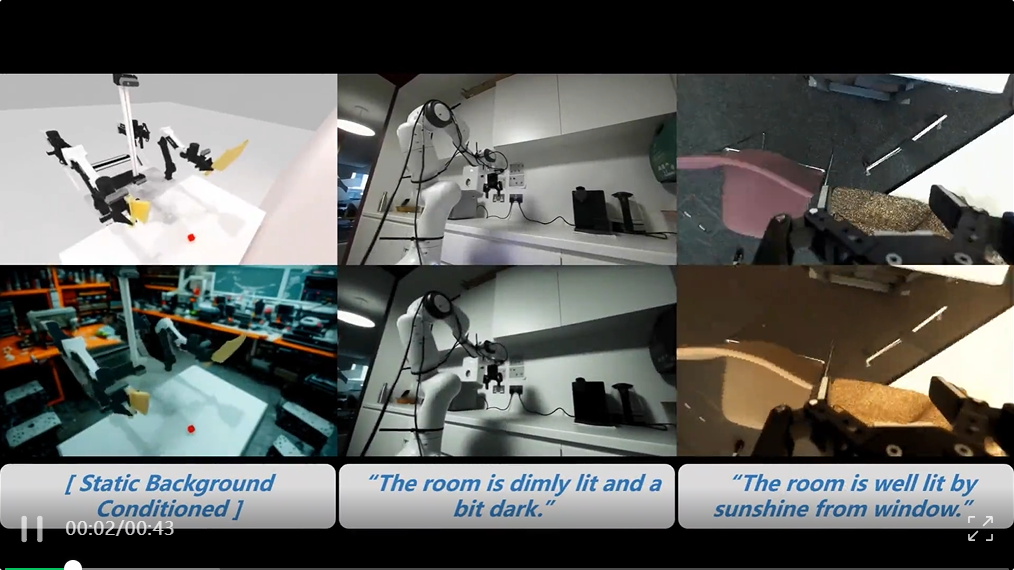

△图1 TC-Light效果展示

为了推动这一问题的解决,团队提出了TC-Light算法,在提升视频生成模型计算效率的同时,通过one-shot两阶段快速优化提升输出结果的一致性,本算法在保持重渲染真实性的同时,时序一致性和计算效率方面实现相比于已有算法的显著提高。下面对算法细节进行详细介绍。

零样本时序模型扩展

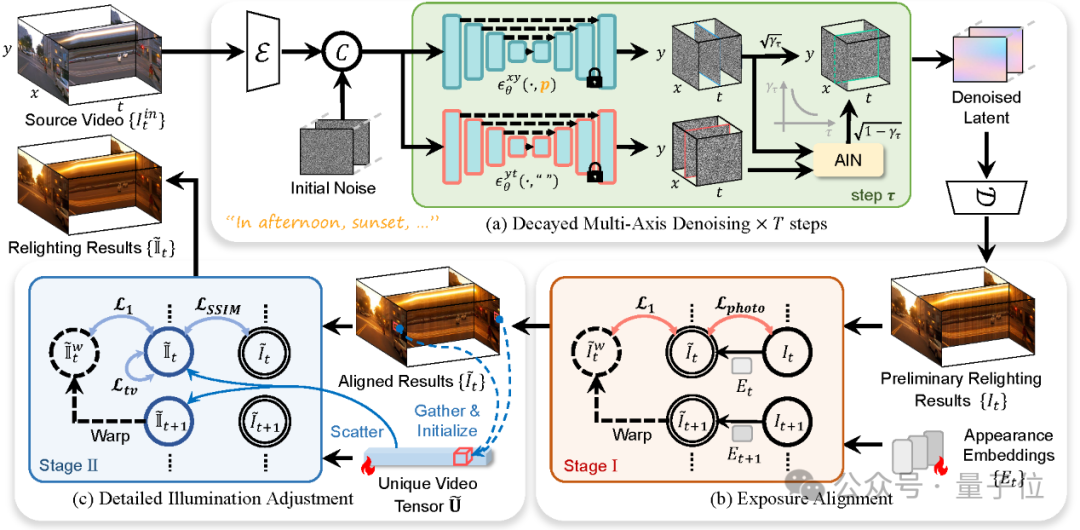

TC-Light首先使用视频扩散模型根据文本指令对输入视频进行初步的重渲染。基于预训练好的SOTA图像模型IC-Light以及VidToMe架构进行拓展,同时引入Decayed Multi-Axis Denoising模块增强时序一致性。

具体而言,VidToMe在模型的自注意力模块前后分别对来自不同帧的相似token进行聚合和拆分,从而增强时序一致性并减少计算开销;

如图2中(a)所示,类似Slicedit,Decayed Multi-Axis Denoising模块将输入视频分别视作图像(x-y平面)的序列和时空切片(y-t平面)的序列,分别用输入的文本指令和空文本指令进行去噪,并对两组噪声进行整合,从而使用原视频的运动信息指导去噪过程。

不同于Slicedit,团队在AIN模块对两组噪声的统计特性进行了对齐,同时时空切片部分的噪声权重随去噪步数指数下降,从而避免原视频光照和纹理分布对重渲染结果的过度影响。

△图2 TC-Light管线示意图

两阶段时序一致性优化策略

尽管通过引入前一小节的模型,视频生成式重渲染结果的一致性得到了有效改善,但输出结果仍然存在纹理和光照的跳变。

因此进一步引入两阶段的时序一致性优化策略,这同时也是TC-Light的核心模块。

在第一阶段,如图2中(b)所示,为每一帧引入Appearance Embedding以调整曝光度,并根据MemFlow从输入视频估计的光流或仿真器给出的光流优化帧间一致性,从而对齐全局光照。这一阶段的优化过程非常快速,A100上300帧960x540分辨率只需要数十秒的时间即可完成。

在第二阶段,进一步对光照和纹理细节进行优化。如图2中(c)所示,这里首先根据光流以及可能提供的每个像素在世界系下的位置信息,快速将视频压缩为码本(也即图中的Unique Video Tensor),即:

其中κ(x,y,t)为视频帧给定像素依据光流及空间信息得到的码本索引,这一基于时空先验的压缩方式在原视频上近乎可以保持无损。不同于Vector Quantization仅考虑颜色相似性的做法,这一压缩方案保证了被聚合的像素之间的时空关联性,保证对应同一个码本值的不同像素具有相似的时空一致性优化目标和梯度。

随后,以码本作为优化目标,以解码后的帧间一致性作为主要优化目标,并且以TV Loss抑制噪声,同时以SSIM Loss使得与一阶段优化结果保持一定程度的结构相似性。

实验结果表明,这一阶段的优化能显著改善时序一致性,同时非常快速,A100上300帧960x540分辨率通常只花费2分钟左右,且由于以压缩后的码本作为优化目标,不仅避免了以往工作以NeRF或3DGS为载体带来的10-30分钟的训练代价,显存开销上也能得到优化。

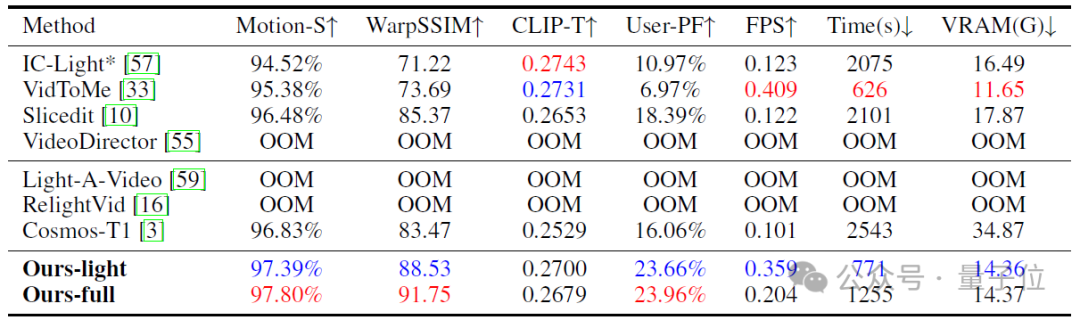

△表1 与主流算法的定量性能比较

其中VidToMe和Slicedit的基模型都换成了IC-Light以进行公平比较。Ours-light指不用Multi-Axis Denoising模块的结果,相当于对VidToMe直接应用两阶段优化算法。

为了验证算法在长动态序列的重渲染表现,从CARLA、Waymo、AgiBot-DigitalWorld、DROID等数据集收集了58个序列进行综合评测,结果如表1所示。可以看到该算法克服了已有算法在时序一致性和计算开销等方面的问题,取得了最佳的综合性能表现。

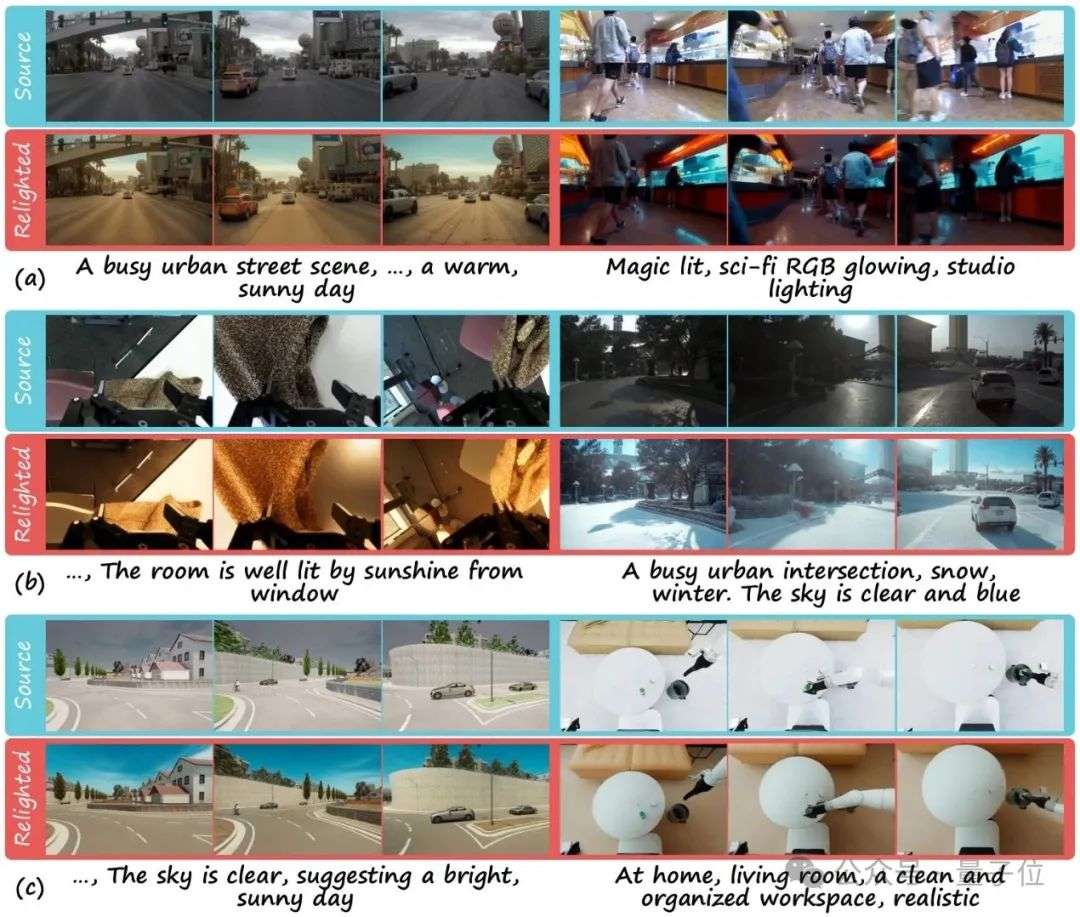

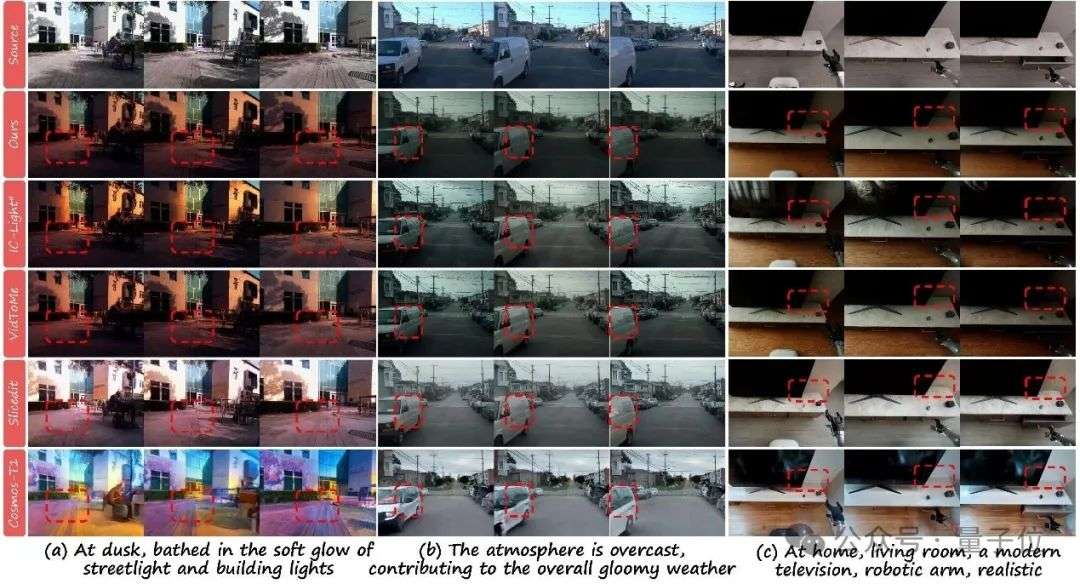

图3的可视化对比也表明,新算法在保持内容细节的同时得到了高质量的重渲染性能表现。

△图3 一致性与生成质量可视化对比。

TC-Light避免了(a)中像Slicedit和COSMOS-Transfer1那样不自然的重渲染结果和(b)中展现出的模糊失真,或(c)中像IC-Light和VidToMe那样的时序不一致性。量化以及video比较可以从project page找到。

最后总结一下,TC-Light作为一种新的生成式渲染器,克服了具身环境下视觉传感器数据重渲染面对的时序一致性和长序列计算开销两大挑战,在性能表现上优于现有技术,不仅为Sim2Real和Real2Real数据扩展带来了新的思路,也为视频编辑领域带来了新的模型范式。TC-Light的论文和代码均已开源,希望能够相关领域带来不同的思考和启发。

项目主页: https://dekuliutesla.github.io/tclight/

论文链接: https://arxiv.org/abs/2506.18904

代码链接: https://github.com/Linketic/TC-Light

文章来自于微信公众号“量子位”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner