开源大模型正在进入中国时间。

Kimi K2风头正盛,然而不到一周,Qwen3就迎来最新升级,235B总参数量仅占Kimi K2 1T规模的四分之一。

基准测试性能上却超越了Kimi K2。

Qwen官方还宣布不再使用混合思维模式,而是分别训练Instruct和Thinking模型。

所以,此次发布的新模型仅支持非思考模式,现在网页版已经可以上线使用了,但通义APP还未见更新。

Qwen官方还透露:这次只是一个小更新!大招很快就来了!

但总归就是,再见Qwen3-235B-A22B,你好Qwen3-235B-A22B-2507了。

By the way,这个名字怎么取得越来越复杂了。

先来看看这次的“小更新”都有哪些~

新模型是一款因果语言模型,采用MoE架构,总参数量达235B,其中非嵌入参数为234B,推理时激活参数为22B。

在官方介绍中显示,模型共包含94层,采用分组查询注意力(GQA)机制,配备64个查询头和4个键值头,并设置128个专家,每次推理时激活8个专家。

该模型原生支持262144的上下文长度。

这次改进主要有以下几个方面:

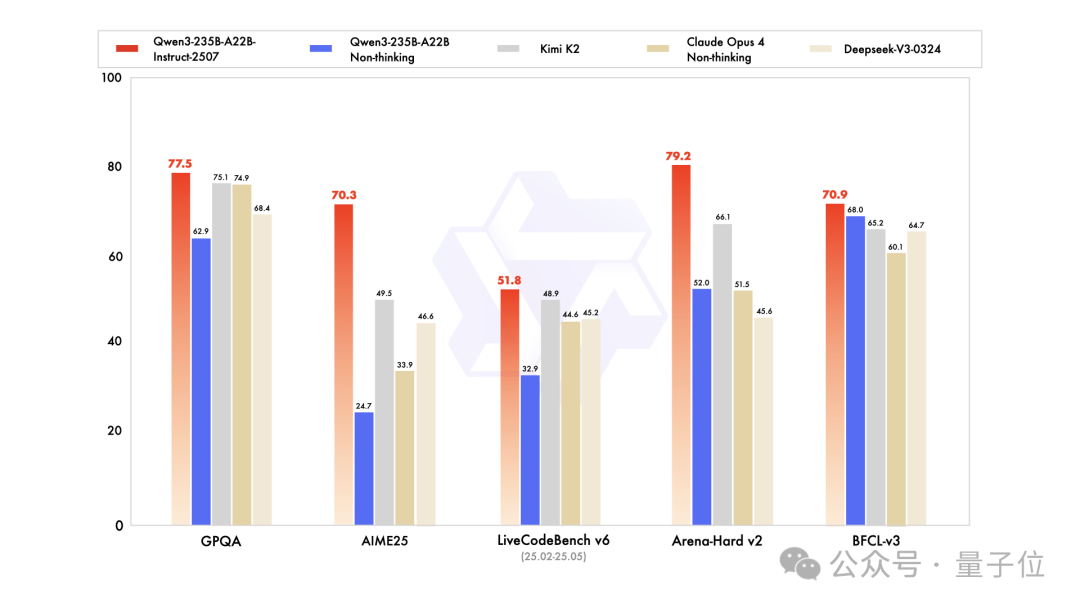

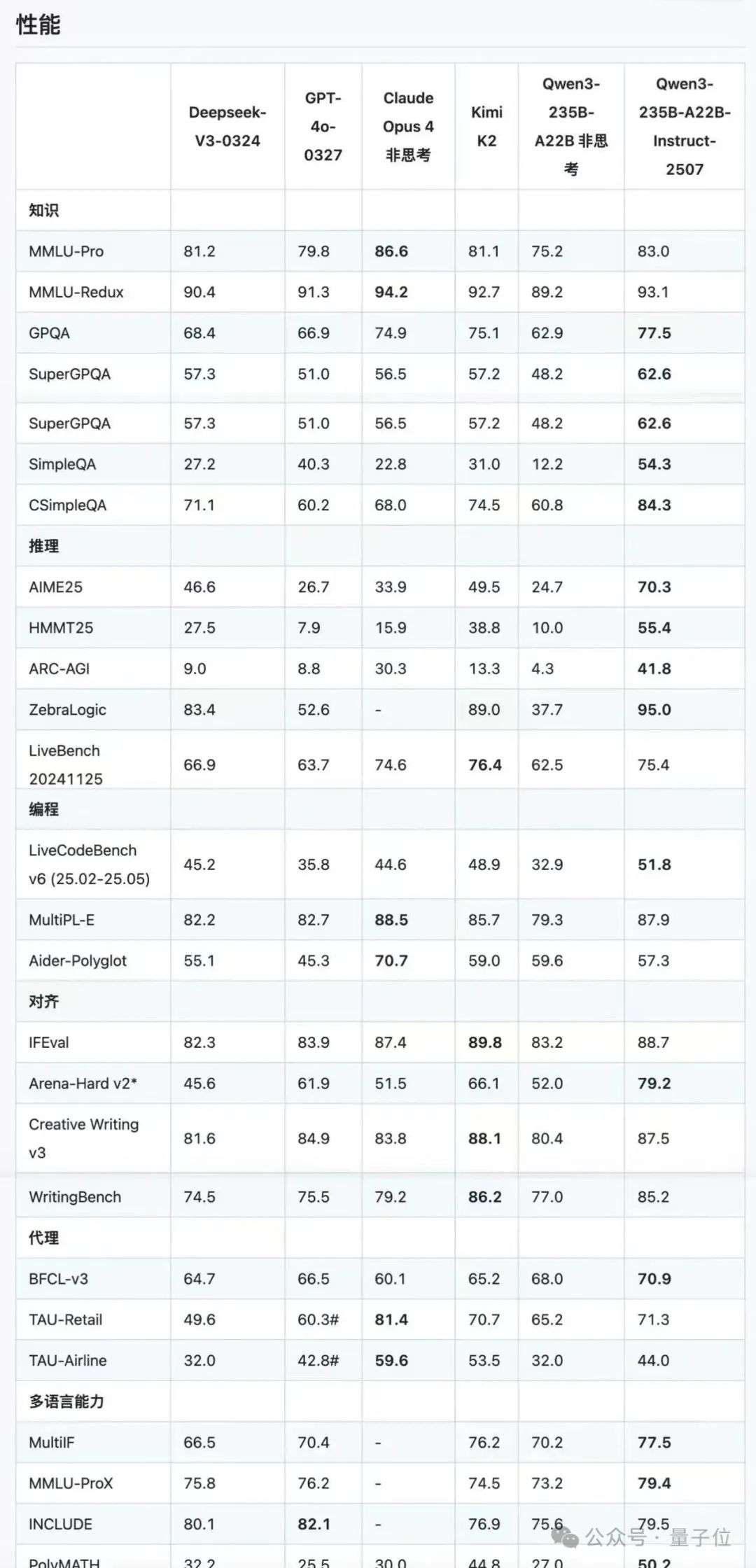

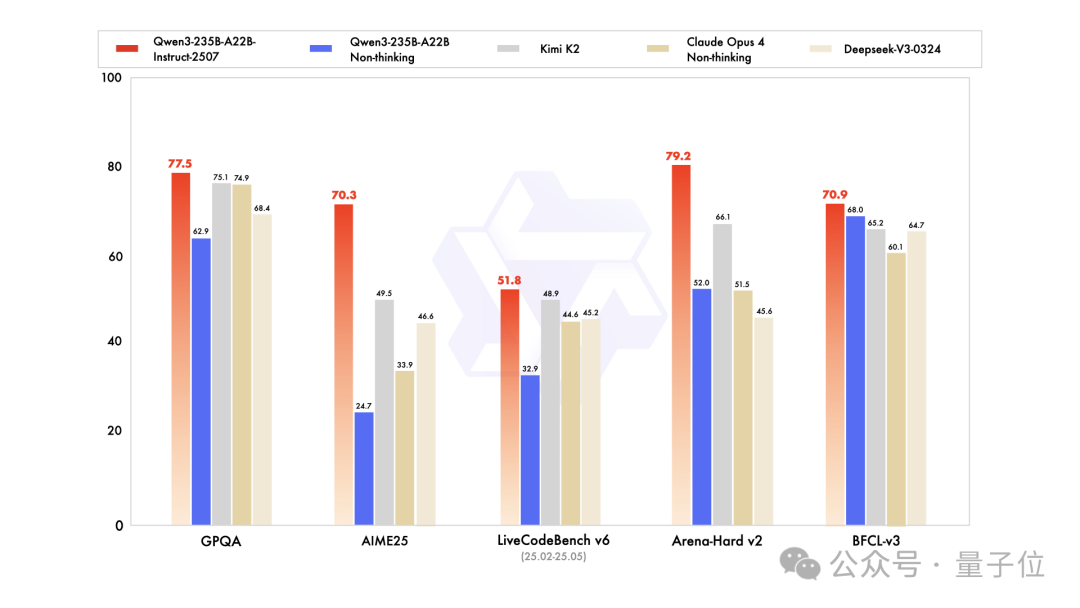

在官方发布的基准测试中可以看到,相较于上一版本,新模型在AIME25上准确率从24.7%上升到70.3%,表现出良好的数学推理能力。

而且对比Kimi K2、DeepSeek-V3,Qwen3新模型的能力也都略胜一筹。

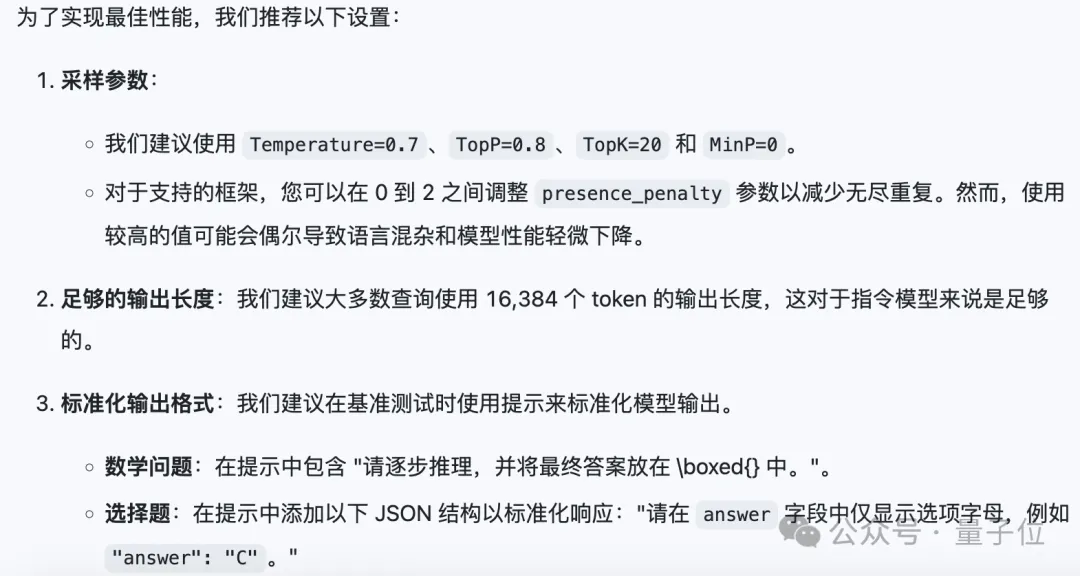

为了提高使用体验,官方还推荐了最佳设置:

Qwen3新版本深夜发布就立刻收获了一众好评:Qwen在中等规模的语言模型中已经领先。

也有网友感慨Qwen在开启新的架构范式:

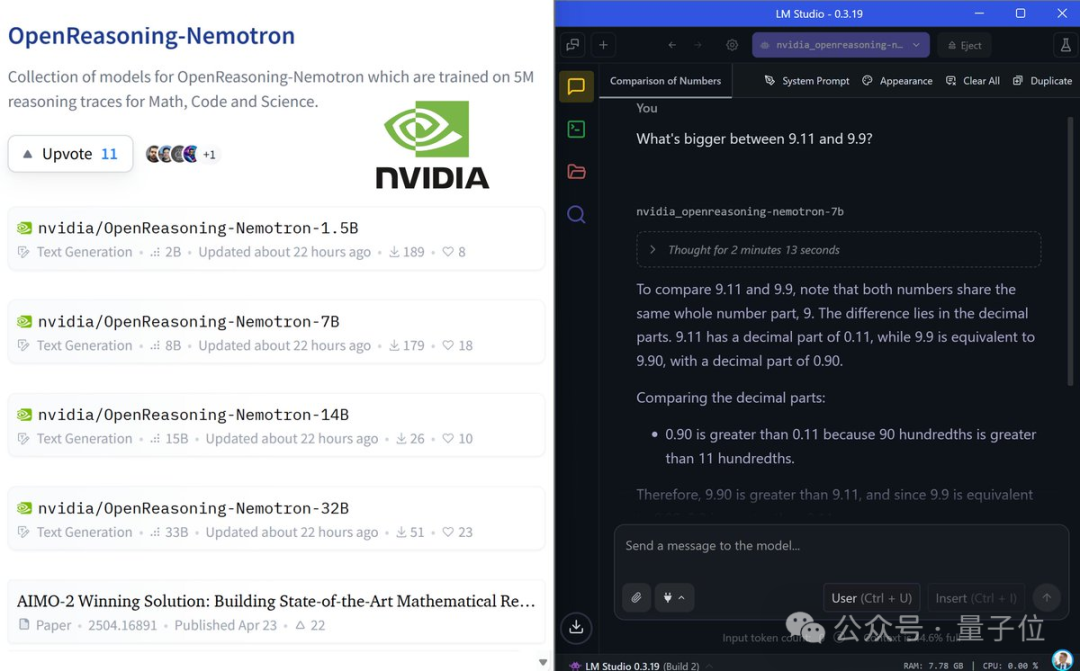

有趣的是,就在Qwen3新模型发布的前两天,NVIDIA也宣称发布了新的SOTA开源模型OpenReasoning-Nemotron。

该模型提供四个规模:1.5B、7B、14B和32B,并且可以实现100%本地运行。

但实际上,这只是基于Qwen-2.5在Deepseek R1数据上微调的模型。

而现在Qwen3已经更新,大招已经被预告。

随着Llama转向闭源的消息传出,OpenAI迟迟不见Open,开源基础大模型的竞争,现在正在进入中国时间。

DeepSeek丢了王座,Kimi K2补上,Kimi K2坐稳没几天,Qwen的挑战就来了。

体验链接:https://chat.qwen.ai/

参考链接:

[1]https://x.com/Alibaba_Qwen/status/1947344511988076547

[2]https://x.com/giffmana/status/1947362393983529005

文章来自于微信公众号“量子位”,作者是“闻乐”。