您可能已经在产品里放进了问答、总结、甚至自动报表模块,但表格一上来,体验就变味了,这不奇怪。表格是二维、带结构、还经常跨表跨文,和纯文本完全不一样;项目作者在《Tabular Data Understanding with LLMs》里把这件事掰开揉碎,从输入表示到任务版图,再到评测与未来方向都梳理清楚了。本文把论文要点翻译成工程语境,串成一条"能落地、可扩展、可评估"的闭环路线图,方便您直接对接研发节奏。

这篇文档服务的就是在做真实产品的您:要么接入表格问答(TQA)、要么自动写总结、要么从自然语言出SQL、要么想把论文里的表格抓出来做排行榜。我会把项目作者的关键发现拆成可执行的工程动作,同时补上决策边界,比如在哪些场景应果断从"纯检索"转向"高阶推理",以及何时考虑表格基础模型(如 TableGPT2)。顺带说一句,内容有点密,但不拗口,您可以按模块拎着走。

最底层是"表示一致性",也就是同一任务在不同输入表示下结果不飘,这在实践里经常被忽视;中层是"复杂输入鲁棒",能扛层级表、超长表、跨表、长文本;顶层才是"意图驱动的高阶推理",比如洞察、预测、图表选择与澄清式交互。项目作者的结论很直接:今天多数基准仍停留在检索与算子链层面,要想上线稳定可靠的产品,建议沿着这三层补齐短板再扩展功能。

论文并不引入单一新模型,而是给出一个工程上真正可复用的"共识层":表格输入该如何被表述、主流任务怎么拆、常见坑点在哪、未来怎么评估。对您来说,这意味着可以基于统一抽象来组织 Prompt、检索、工具使用与训练数据,而不是在不同子团队之间反复造轮子。我会按输入表示→任务版图→三大挑战→工程步骤的顺序展开。

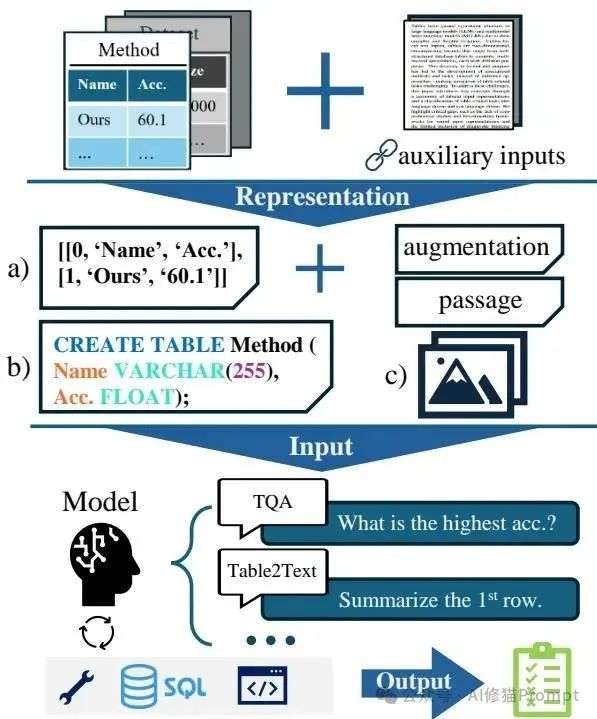

项目作者在图示里把整体流程串成了闭环:表或数据库经过"序列化/Schema/图像/专用编码器"等入口,被模型与外部工具协同处理,最后产出任务相关结果。工程落地建议对应拆为数据摄取与表示服务、规划器(LLM)、工具执行器(SQL/pandas/可视化)、证据与审计存储四层,方便扩展与回溯。您会发现,把工具调用与证据链固化下来,后续合规与质量分析会轻松很多。

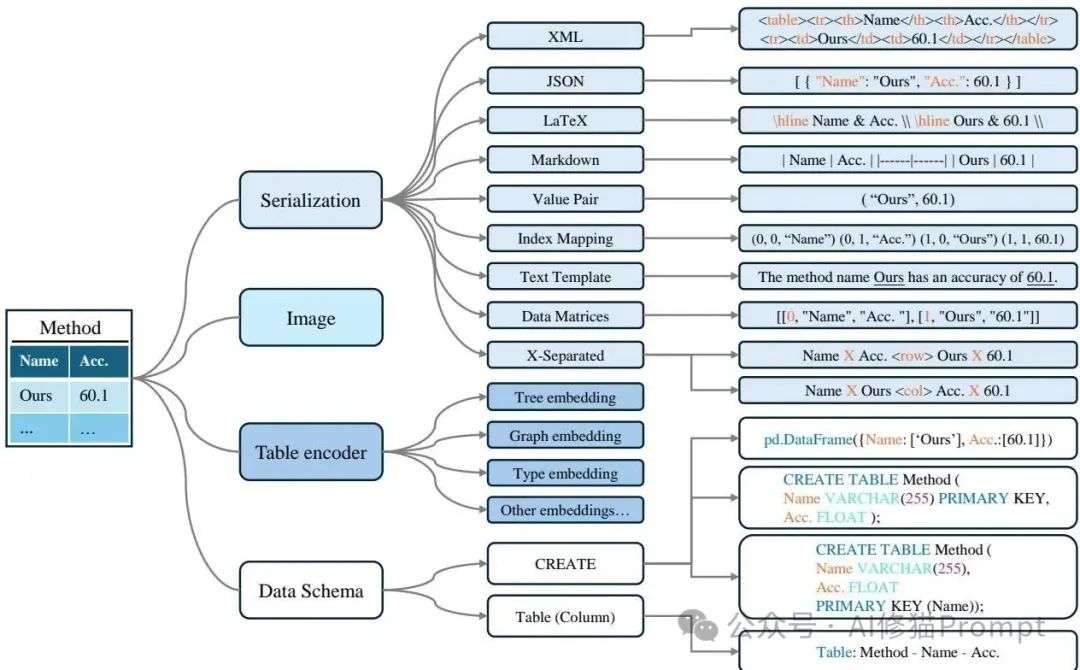

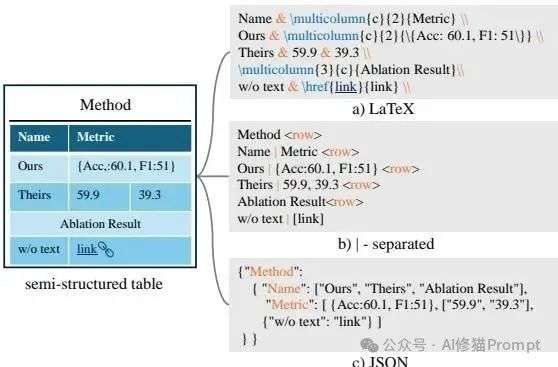

四种主流表示各有取舍:序列化(Markdown/LaTeX/JSON/HTML)、数据模式(SQL Schema/DataFrame)、图像(保持版式)、专用表格编码器(行/列/树/图)。序列化接入简单但对设计很敏感,Schema 绕过长度限制却依赖规范化,图像能保留层级与合并单元格但受分辨率约束,专用编码器最稳但工程门槛高。建议产品期用"序列化+Schema"双路输入起步,复杂表再叠图像作为结构补充,后期再评估是否引入表格基础模型。

项目作者指出,输入设计细节对效果影响很大,比如分区标注、行列顺序、示例行与否,变化一下就可能掉分 20%~50%。长表或多表经常超出上下文,需要做采样与增广,实践里可用语义中心或聚类质心采样,再拼接关键信息与关键词解释文本,以控制 Token 耗费。您可以把它当作"文本化的表格快照",但别忘了它不是原表本身,尤其遇到嵌套值、合并单元格、跨页表格时。

同是序列化,表达能力差异不小:LaTeX 的 \multicolumn/\multirow 能天然编码层级边界,JSON 在嵌套值与灵活类型上更自在,Markdown/行分隔在可读性与接入成本上占优。项目作者提醒过一个细节,表示内部结构即便同为 JSON 也可能千差万别,所以要把"JSON Schema 与示例片段"当成契约来管控。遇到层级与合并单元格较多的表,优先 LaTeX 或"图像+轻量 JSON"混合,再降级到纯 Markdown。

长表裁剪不是随便抽几行这么简单,比较稳的做法是先做语义向量,然后用质心或语义覆盖度来挑代表行与列,再补充关键词解释、统计摘要和采样策略说明。项目作者的证据显示,这种"采样+解释"的组合比纯截断更能保住答案正确性,同时还控制了 Token 成本。您可以把这套策略做成可配置的管道,灰度调节采样比例与解释详细度。

Schema 输入让模型直接"看结构",天然避开长表内容,但对主键外键、列名一致性、示例行的依赖更强。项目作者复盘显示,缺失主外键或示例行时性能会明显下滑,尤其跨表匹配更容易失真;另外,超长 Schema 会让模型在真实工业库上陡降。一个务实做法是把复杂数据先做"规范化快照",必要时补三行示例数据,让意图解析更稳。

图像能保留真实版式、层级、合并单元格等信息,我觉得这在财报、论文表格里格外关键;不过分辨率受限,表一大就糊,需要与文本/Schema联合输入。您可以用图像提供结构线索、用文本承载细节内容,尤其在层级表(HiTab)和长文本场景(MULTIHIERTT)里,这种"双通道"组合更靠谱。当前还缺少系统评测,工程上可以先做 A/B 做证据。

专用编码器在小模型时代就有效,行列注意力、树结构和图嵌入都有人做过;近年 TableGPT2 等把这类结构能力并入更大的基座,横跨多任务更稳定。现实里,团队在"标准 LLM+良好表示"跑到瓶颈时,再考虑引入表格基础模型,通常会换来跨任务一致性与鲁棒性提升。代价是训练与部署复杂度上升,注意权衡 ROI 与算力预算。

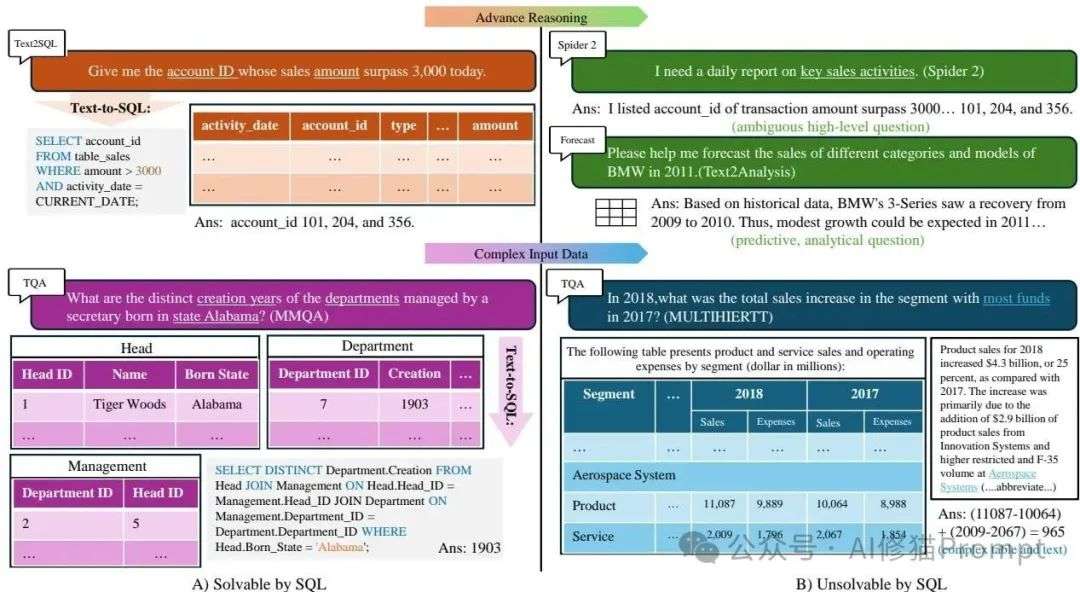

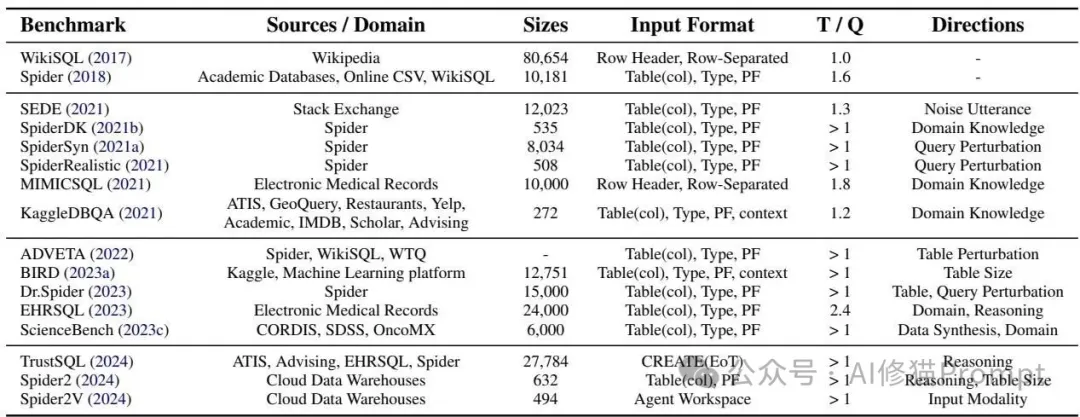

项目作者梳理了五类重点任务:表格问答(TQA)、表格到文本(总结)、表格事实核验(TFV)、Text-to-SQL,以及把论文结果表自动变成排行榜。TQA 的输入多为单表+可选段落,输出是单元格、计算值或短文本;总结任务会标注焦点区域或全表生成;TFV 输出支持/拒绝/证据不足并可带证据单元格。Text-to-SQL 现在更看执行正确(EX)而不只字符串完全匹配(EM),工业落地时建议以 EX+可靠性作为一等指标。

项目作者也关注文本生表这条路,思路可以是"先抽元组再对齐 Schema",缺字段就触发澄清或用知识库补全,最后导出规范化表并落到数据目录。现实里这很适合把法规条款、招股书细则或实验设置变成结构化数据,后续查询与可视化都能复用。您要重点盯两件事:一致性校验与来源溯源,别让"小错"混进核心数据域。

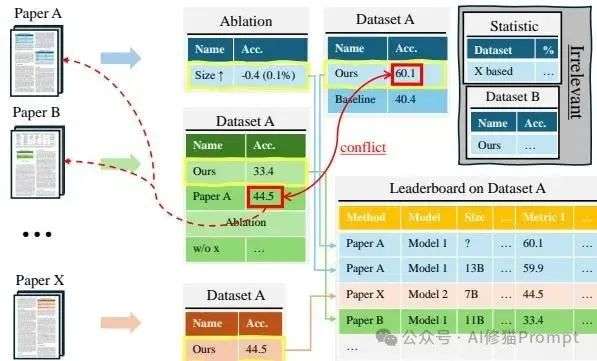

论文表格抽取可走"版面图像+OCR+结构化重建",然后将(任务,数据集,指标,分数)正规化为统一元组;不过不同论文写法不统一,您还得在正文里找注脚或实验设置。建议在抽取后做一次跨文一致性校验,比如对同一模型同一配置的差异分数进行比对与回溯,再给出"需人工复核"的标记清单,这一步能显著减少误导。

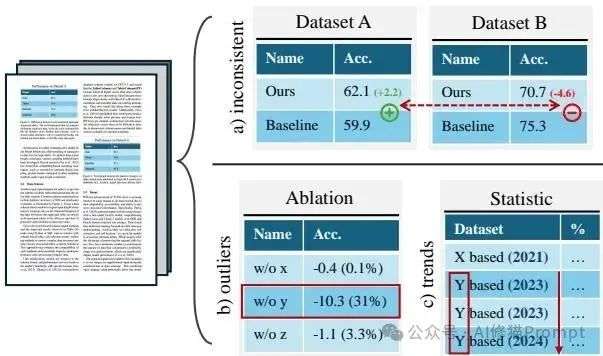

第一,很多基准可以被算子链或 SQL 快速覆盖,缺少更高阶的诊断、预测、处方式推理;第二,复杂输入一来模型就掉线,比如 MULTIHIERTT 上人类大约 83% 而模型不到一半,MMQA 上强模型 EM 也只在 50% 多一点;第三,同一任务换一种表示就掉点,输入风格差异会带来最高 5% 的摆动。说白了,要上线,您必须把"表示一致性"和"复杂输入鲁棒"当作 P0 事项,不然后面都白搭。

Spider 系列把跨表与函数复杂度提上来了,后续 Spider2 则把问题提成"意图级",诸如"我要一份每日关键销售活动的日报",模型得先还原真实需求再落到查询。现实数据库里 Schema 又长又乱,列名相似、示例行不足、缺主外键都很常见,所以 EX 分数会急剧下滑;一个靠谱做法是接入多轮澄清,把不确定字段和约束主动问清。别怕多一步互动,代价小,收益很稳。

项目作者点出表格到文本几乎没有多语基准,这会导致国际化产品上线后"说不清"的问题更频繁。工程上可以先做术语与单位对齐词表、列名同义别名库,再接入轻量翻译作为回退路径,同时为 Text-to-SQL 维护"跨语列名映射"与示例行。短期以内,建议把多语作为独立评测面板,别混在总体成绩里稀释了风险。

诊断‑预测‑处方是项目作者强调的高阶能力链,其实工程化也不难,把"图表处方器"做成一个工具,模型给出候选图型与分箱策略,工具产图并返回可复算脚本。模糊请求就先澄清目标与量纲,再落具体图与数值,这会比一句话描述更有说服力。长期看,您还可以把业务 KPI 的"推荐可视化"固化为策略模板,复用价值很高。

别把 Prompt 当唯一变量,输入设计才是杠杆:分区标注、顺序、示例行、关键词解释、表规模提示,都能显著改变行为。您知道吗,项目作者汇总的实验里,拿掉示例行会让一些任务的正确率腰斩,调换顺序或省略分区标注也会明显下滑。实践里建议把这些选项做成"可控开关",在灰度阶段按流量比例动态打开,记录差异再收敛到最优模板。

第一步,定义输出类型与验收口径,比如 TQA 要不要计算、是否接受近似数、评估用 EM 还是 EX;第二步,选表示与转换链路,优先"序列化+Schema",复杂表补一张结构图像,必要时做 JSON⇄Markdown⇄LaTeX 的表示互转;第三步,接入工具链与代码执行,SQL/pandas/可视化绘图都放到工具层,由模型做计划与调用。第四步,做采样与增广,把长表裁成语义代表性子表,同时附带关键词解释与统计摘要,以抵消截断损失;第五步,建立评测与线上监控,离线选用 HiTab、MULTIHIERTT、MMQA、Spider2、QTSUMM、Text2Analysis 等集合理解表现,线上则盯执行正确率、重跑一致性与澄清率。

Spider2V 把"代理工作台"作为输入形态之一,这与现实里的数据工程台很像,模型需要在工具、文件与环境之间来回协作。要把这一层评测进来,您需要记录工具选择、参数、执行日志与回放脚本,并把失败分为定位、计划、执行、解释四种。等这些轨迹稳定后,您再去调高阶推理,问题会更聚焦,不至于被基础设施噪声干扰。

先用"数据矩阵序列化+三行示例行的 Schema"做双路输入,财报里的合并单元格边界用一张 1024px 宽图像补充结构线索;工具层放一个带财务算子的 pandas 执行器,让模型按计划调用。问答之外再接 QTSUMM 做"问题驱动的小节总结",输出带计算过程与来源单元格,线上以 EX 与证据命中率为主指标,结果不确定时触发简短澄清提问,体验更稳。

"数据工程"维护表示与转换通道、采样与标注;"应用工程"编排多路输入、工具链、对话与澄清;"评测工程"管理基准集、指标口径与线上观测。三方之间要有一个"表示规范"共享库,哪怕只是 JSON Schema 与 Markdown 模板,也能减少大量扯皮与返工。简单说,先把共识层打平,后面的协作成本会小很多。

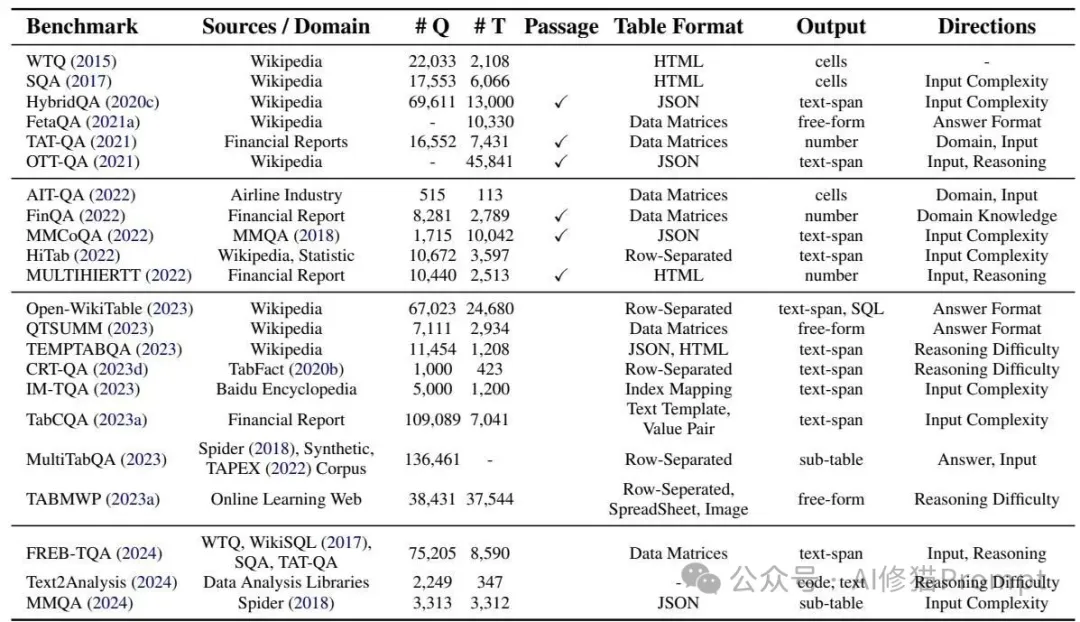

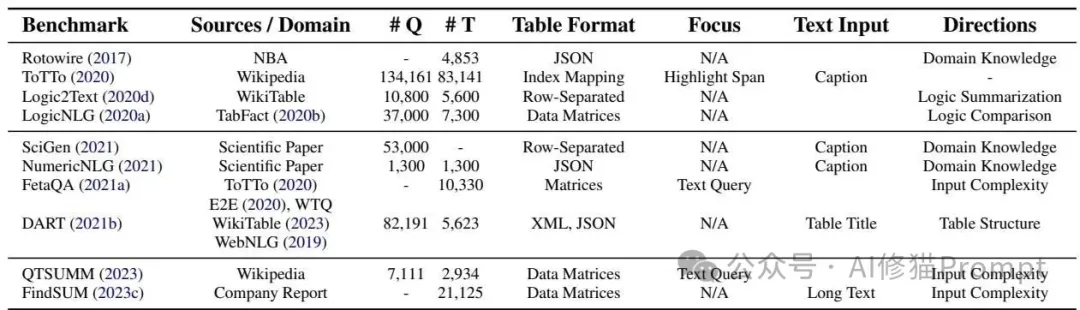

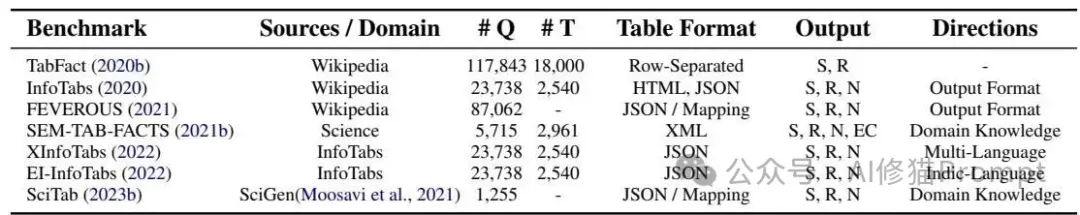

基准汇总表

入门可用 WTQ(单表)与 TabFact(核验)做基线,随后引入 HiTab(层级表)与 MULTIHIERTT(长文本+多表)验证复杂输入能力。需要跨库与真实意图时,Spider2 与 Text2Analysis 很贴近生产;若您做内容生成与总结,QTSUMM 的"问题驱动区域总结"很实用。MultiTableQA、MMQA 这类跨表问答也值得加入,它们和企业数据仓库的样貌更接近。

"图像+文本/Schema"的双通道在复杂表上更稳,但评测要讲规矩,建议固定随机种子、三次重复、按任务口径分别记 EM/EX/证据命中率。为看清结构贡献度,可做消融:只图像、只文本、联合输入、联合输入但遮蔽结构线索,分别记录波动区间。结果出来别只看均值,把方差与失败样例归类,您会更容易定位表示与工具链的共振点。

FREEB‑TQA 强调细粒度鲁棒评测,包含置换、扰动、格式变化等多类挑战,CRT‑QA 聚焦更复杂的推理链路,这两类都适合做回归测试集。建议把它们编入持续集成,结合"列顺序打乱、单位切换、小数精度浮动、拼写扰动"等企业侧真实噪声,形成您自己的鲁棒性画像。这样一来,版本升级的收益与代价就能量化呈现,而不是主观判断。

字符串完全匹配(EM)只是表象,我们更关心执行结果的正确与否(EX),以及在小扰动下能否稳定复现。对 Text-to-SQL,可加入惩罚型记分(如 TrustSQL),对 TQA 则用重采样一致性与证据溯源覆盖更多失效模式。线上建议对关键工单做"双判读",即模型回答与"工具执行结果"并置展示,异常时自动回退更保守的策略链路。

长回答在 TQA 与总结类任务越来越多,项目作者提到自动评估的瓶颈,这里建议混用规则、执行与模型评审。先对答案里的数值与单位做正则与执行校验,再由小模型做结构评分,最后抽样交给大模型与人工复核,这样既省钱又稳。评测口径里要明确"允许误差""必须给证据"的边界,别让评价标准在回归中飘来飘去。

当您已经把表示做对、工具接好、评测通过,瓶颈仍在跨任务一致性与复杂表鲁棒,才推荐评估 TableGPT2 一类;这一步通常带来泛化与稳定性的提升,尤其在多任务场景。代价包括训练数据准备、推理成本与平台兼容,务必在 A/B 中验证真实增益再推进,不然会被部署与成本"反向教育"。

别只在控制台里跑效果,找一个具体岗位的真实流程来绑定,比如运营需要的周度 KPI 表格分析。您可以让系统针对模糊请求先确认口径,再给出"解释+证据单元格+可复算脚本",并附一张清晰的图表,用户心里会更踏实。我们做过类似实验,用户对"可核查的过程"比对"更花哨的语言"更买账,这很接地气。

下一阶段可以重点推进三件事:一是做"表示到表示"的转换任务,练习模型在 JSON、Markdown、LaTeX 之间来回走动以提稳迁移;二是在高阶意图上练澄清与规划,比如 Spider2 风格的"目标导向问题"与 Text2Analysis 的分析型任务。三是拥抱"科学文献表格"场景,它天然要求趋势、异常、诊断与跨文本一致性,这些能力离真实业务很近。

项目作者也坦诚这是一份"快照",领域演进很快,所以请把基准集、表示模板、工具白名单与指标口径都版本化管理。每次上新能力都要跑一遍"能力金字塔"的三层回归,并记录代表性失败样例与修复策略,形成知识库。等知识与数据都滚起来,您的系统会越来越稳,而不是靠"手感"在前行。

可优先查表:Table 1(TQA 基准)、Table 2(总结)、Table 3(核验)、Table 4(Text-to-SQL),挑与您业务近的先落地;复杂输入验证选 HiTab、MULTIHIERTT、MMQA;真实意图与可靠性看 Spider2、TrustSQL。若要做视觉补充,可以参考"Table Cell Locating/Merged Cell Detection"这类结构任务,把它们作为训练或推理前的结构增强模块。

把以下条目变成工单就能跑起来:表示双路与互转、采样与解释管道、工具执行与审计、鲁棒性与多语评测、Spider2/2V 套件、长答混合评估与回滚策略。每周固定时间看三件事,复杂输入失败率、跨表示摆动幅度、高阶任务的澄清触发率,指标红了就从那一层补救。这样您的路线既能追前沿,又不会把团队带进不可控的技术债。

很多团队容易忽视输入表示,觉得那只是数据预处理的一环,但项目作者的数据把话说透了:表示选得好,后面一切都顺;选不好,再多 Prompt 技巧也不稳。您不妨把"表示模板与转换库"当成对外可见的功能模块去打磨,它会成为您后续多任务、多模态、跨领域的"公共地基"。

文章来自于微信公众号“AI修猫Prompt”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0