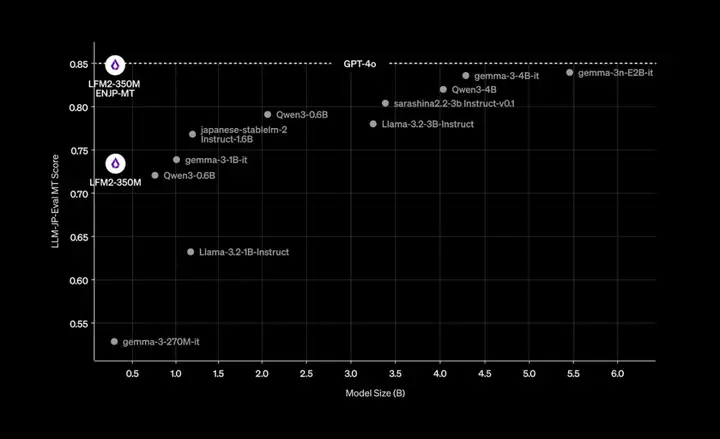

在大模型的竞赛中,参数规模往往被视为性能的决定性因素。但近期,Liquid AI 的研究团队提出了一个不同寻常的案例:一个仅有 3.5 亿参数的模型,经过微调后,竟能在中短上下文的实时日语英语翻译任务上,与 GPT-4o 竞争。

这一模型被命名为 LFM2-350M-ENJP-MT, 在多项评测中,它的表现不仅在同类模型中遥遥领先,甚至比其自身大 2 个数量级的模型表现更好。

图|不同模型日英翻译表现对比(来源:Liquid AI)

作为一个专攻日英翻译的模型,LFM2-350M-ENJP-MT 能够顺利完成日常文本、技术描述、商务沟通和新闻报道的翻译,并且具备着保留像口语化表达、新闻措辞和商业沟通方面语言的细微差别的能力。

LFM2-350M-ENJP-MT 是在 LFM2-350M 基础上微调得到的翻译模型,而 LFM2-350M 本身是 LFM2 的最小尺寸 350M 参数版本,相比于市面上大多数模型体积很小。LFM2 由 Liquid AI 于今年 7 月 10 号发布,为第二代 Liquid Foundation Model(LFM),提供 350M、700M 和 1.2B 三种规格,专为边缘 AI 和设备端部署设计。

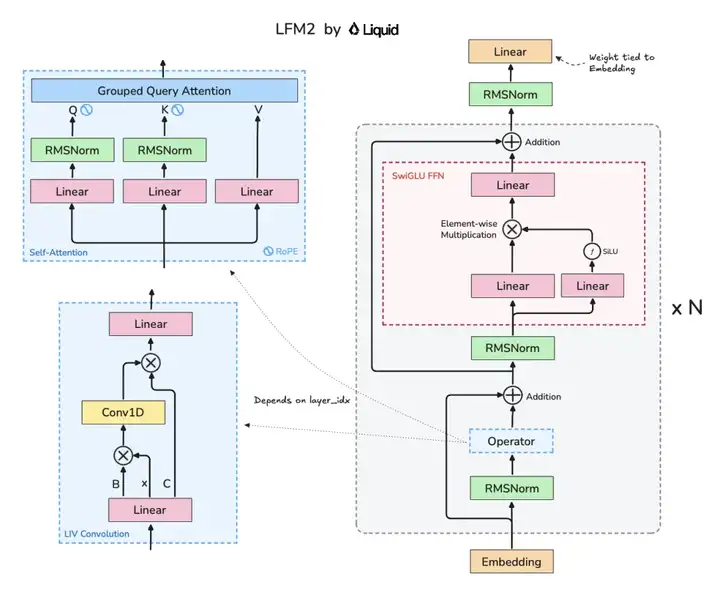

LFM2-350M-ENJP-MT 所用的模型架构与 LFM2 相同,采用了包含卷积和注意力模块的混合架构,结合 10 个双门控短程 LIV(Linear Input-Varying)卷积块和 6 个分组查询注意 (GQA) 块,这种方法在不牺牲准确率的情况下最大限度地提高了推理速度。线性输入变化 (LIV) 算子的概念则是由 Liquid AI 研究团队于 2024 年提出,作为一种线性算子,其权重由输入动态生成,从而使卷积、递归、注意力机制和其他结构层都归属于一个统一的、对输入敏感的框架。

同时团队还开发了一个叫 STAR 的神经架构搜索引擎,通过进化算法(evolutionary algorithm)来自动探索最优架构,满足精度、内存、延迟等需求。

图|LFM2 架构(来源:Omkaar Kamath)

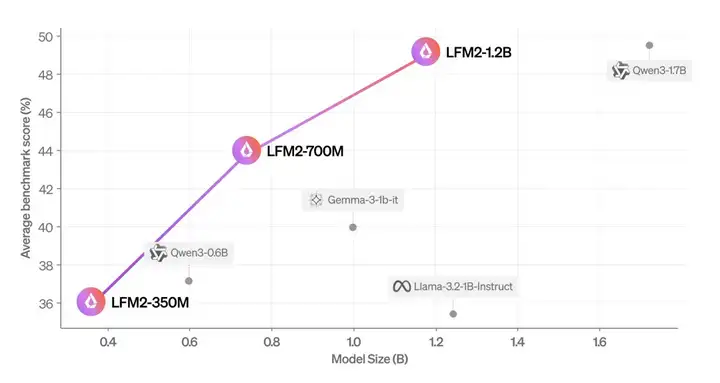

和 LFM2-350M-ENJP-MT 一样,LFM2 在基准测试中,展现了“四两拨千斤”的能力,性能超过很多同规格,甚至更大体积的模型。根据评估,LFM2-1.2B 的性能与 Qwen3-1.7B 相当,后者的参数数量比后者多 47%。LFM2-700M 的性能优于 Gemma 3 1B IT,而 LFM2-350M 与 Qwen3-0.6B 和 Llama 3.2 1B Instruct 相当。

而本次微调版本 LFM2-350M-ENJP-MT,更是将“小模型”的潜力发挥到了极致。在中短文日英翻译上,表现比肩 ChatGPT-4o。

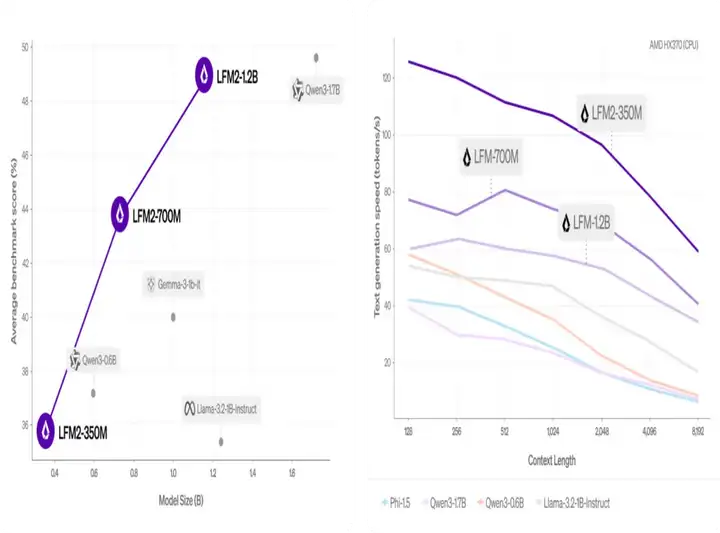

图|LFM2 基准测试平均得分(MMLU、IFEval、IFBENCH、GSM8K、MMMLU)vs 模型大小(左)(来源:Liquid AI)

图|LFM2 速度与其他模型速度对比(来源:Liquid AI)

与 LFM2-350M-ENJP-MT 一同发布的是 LFM2-350M-ENJP-MT-GGUF,也就是该模型的 GGUF 格式版本。GGUF 是一种经过优化等二进制格式,能加快模型的加载与存储,从而提高推理效率。GGUF 专为 GGML 及其他执行器设计,而 GGML 等执行器可以帮助大模型在商用硬件上实现高性能运作。

这一点,契合了 Liquid AI 的战略:打造真正能在移动端与边缘设备落地的 AI 系统。成立于 2023 年的 Liquid AI,由来自 MIT 的研究员 Ramin Hasani 和 Mathias Lechner 创办。团队的目标就是致力于打造兼具性能与效率的基础模型,并推动其在设备端的普及应用。

图|Liquid AI 创始人(来源:LinkedIn)

当前,LFM2-350M-ENJP-MT 还在特定方面有所不足,尤其是其处理超长文本以及专业或语境敏感的翻译的能力,例如: 技术及专业用语(医学、法律、工程);新专有名词(新产品、品牌、文化);或行业、领域内部特有的术语。

Liquid AI 表示,他们将与开源社区合作,持续微调改进 LFM2-350M-ENJP-MT。未来,或许有越来越多这样的“小模型”在更多复杂场景中发挥作用。

参考资料:

https://www.liquid.ai/blog/liquid-foundation-models-v2-our-second-series-of-generative-ai-models

https://huggingface.co/LiquidAI/LFM2-350M-ENJP-MT

文章来自于“DeepTech深科技”,作者“dlm”。

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner