这项工作由伊利诺伊大学香槟分校 (UIUC)、哈佛大学、哥伦比亚大学和麻省理工学院 (MIT) 的合作完成 。

为什么特征拼接 (Feature Concatenation)会在机器人感知和决策中失效?

想象一下,你在黑漆漆的背包里找钥匙。你的眼睛此时毫无用处,全靠指尖的触觉,这对你来说轻而易举 ,但在机器人领域,这却是一个非常困难的问题。

残酷的真相: 目前的机器人学习主流的多传感器融合的算法(Feature Concatenation)在处理这种任务时彻底失败了。我们的实验数据显示,当你给机器人加上触觉数据试图让它更聪明时,它的抓取成功率竟然从 35% 暴跌至 5%!为什么? 因为传统的方法把偶尔出现的关键触觉信号当作了 “噪音” 直接过滤掉了。

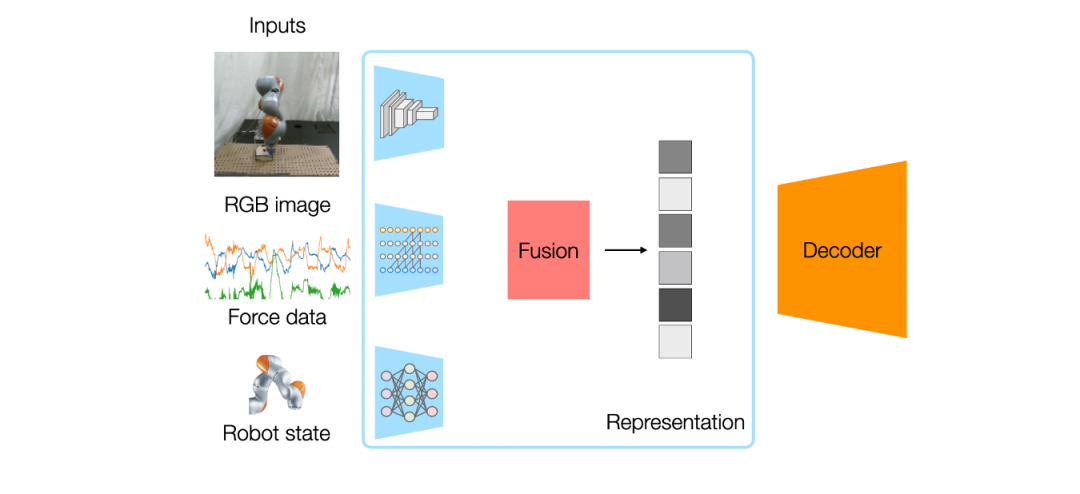

目前的多模态机器人学习方法通常使用特征拼接 (Feature Concatenation):提取所有传感器的嵌入 (embeddings),将其拼接成一个大向量,然后输入到一个单一的神经网络策略中 。

这种方法看似合理,但存在两个根本缺陷:

问题 1:稀疏模态被视为噪声

问题 2:无法灵活添加或移除模态

我们的解决方案是重新思考模态的结合方式。我们不将所有传感器强制输入单一网络,而是为每个模态训练单独的专家策略,并学习如何在策略层面组合它们的动作预测 。

组合式策略框架概述

解决稀疏性:每个专家学习自己的动作分布,互不干扰。触觉专家不再与视觉竞争表示模型的表征能力,从而在富含接触的操作中变得高度专业化。

模块化设计:专家是独立训练的。添加新传感器只需训练一个新的专家,并使用固定权重或快速微调将其与现有专家组合,无需重训练整个系统 。

简单的实现(implementation)方式:组合多个策略对应于概率分布相乘,在扩散模型(基于分数的能量模型)中,这等同于简单的分数函数相加 (summing score functions) 。

为了展示模块化,我们完全独立地训练了 RGB 和触觉策略,然后使用固定的相等权重将它们组合,没有进行任何联合训练。

运行时扰动:在执行过程中突然抢走物体,机器人能适应并完成任务。

传感器损坏:遮挡一个摄像头模拟故障,路由器简单地将权重转移到剩余的功能传感器上,表现保持稳定。

物体重新定位:移动任务相关物体,策略能成功泛化。

我们使用了配备双 RealSense 摄像头和 FlexiTac 触觉传感器的 UR5e 机器人进行验证 。

RLBench 模拟任务:在四个操作任务上,我们的方法平均成功率为 66%,显著优于单模态策略 (49%) 和特征拼接 (56%) 。

真实世界:

通过从特征级拼接转向策略级组合,我们为模态稀疏性问题提供了一个系统性的解决方案,同时实现了增量学习和鲁棒部署 。我们的 core insights 很简单:让每个模态拥有自己的 “专家” 并学习各自的相对影响力,而不是将所有传感器强制输入单一网络。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner