我们以为语言是语法、规则、结构。但最新的Nature研究却撕开了这层幻觉。GPT的层级结构与竟与人大脑里的「时间印记」一模一样。当浅层、中层、深层在脑中依次点亮,我们第一次看见:理解语言,也许从来不是解析,而是预测。

我们一直深信,人类的大脑,是靠着一套严谨的规则、语法和结构分析来理解语言的,复杂且独一无二。

这是一个持续了数十年的「共识」。

可最近Nature Communications上发表的一项颠覆性研究,把这个古老的信仰掀了个底朝天。

论文地址:https://www.nature.com/articles/s41467-025-65518-0

研究者们让受试者听30分钟的故事,同时用毫秒级的脑电技术,精准捕捉大脑对每个词语的反应。

接着,他们将同样的故事文本输入给大语言模型,比如GPT-2和Llama-2,提取模型每一层对文本的内部理解表示

令人震惊的实验结果出现了:

GPT那看似冰冷的层级结构,竟然在人类的大脑里,找到了完美的时间对应关系。

过去,我们总以为是GPT在模仿人类。但这个实验却给出了一个石破天惊的暗示:

或许,我们的大脑,天然就长成了「GPT」的样子。

要理解这项研究的颠覆性,必须看清它最关键、也最精妙的动作:把GPT的48层结构,逐层对齐到人脑的时间序列。

研究团队找了9名因癫痫接受术前监测的病患,他们的大脑皮层上,已经植入了高密度的ECoG电极。

ECoG植入和定位示意图

这种设备能以毫秒级精度记录大脑真实的电活动。

受试者听了一段30分钟的播客,研究者同步采集到了围绕每个词出现时刻的高伽马脑电信号。

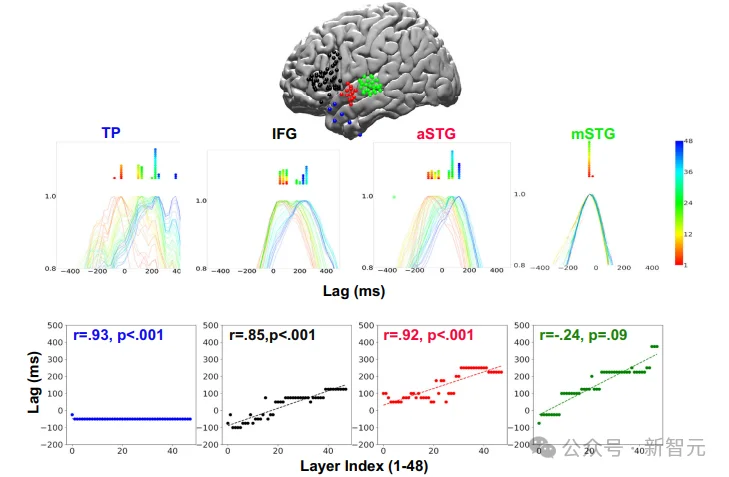

这些信号覆盖了语言通路中的关键区域:从掌管听觉的mSTG、aSTG,到负责语言整合的IFG,再到高级语义区的TP。

与此同时,研究者把同一段文本输入GPT-2 XL和Llama-2。

每当模型处理到一个词时,他们就「暂停」,抽取这个词在模型内部从第一层到最后一层的所有内部理解表示。

随后,他们将模型每一层的表示,通过CA降维进行简化,然后用线性模型去尝试预测人脑在那一毫秒的电活动。

研究方法示意:GPT-2的每一层都会生成一个语义表示(左)。研究者把这些语义表示输入线性模型,预测人脑听到该词时的脑电活动(右)。如果某一层语义表示能在特定时间点预测脑电,就说明该层与那一时刻的大脑处理阶段对应。

如果GPT的内部层级结构与人脑无关,那么将模型层级对齐到大脑的时间轴上,结果必然是一团乱麻,毫无秩序。

但如果二者真的存在某种结构对应,我们就会在脑电时间轴上看到秩序。

事实正是如此。

实验一开始,研究者只是想验证一个简单的假设:

如果大语言模型的层级结构与大脑的某个处理阶段相对应,那么这种对应,就应该像接力跑一样,在时间轴上依次出现。

研究者把GPT的每一层语义表示丢进线性模型里,试图去预测大脑在听到每个词时,高伽马活动会在哪一毫秒达到峰值。

他们的设想是:如果模型的浅层、中层和深层分别承担不同的语言功能,那么它们在人脑活动的时间轴上,也理应「错开时间」、「按序登场」。

结果,这张「时间阶梯图」清晰地揭示了大脑的秘密:越靠近高阶语义的区域,越像GPT的深度结构。

GPT的48层在大脑语言通路中呈现出清晰的「时间—深度」对应结构。浅层(暖色)在更早的时间点达到峰值,深层(冷色)在更晚时间出现。TP、aSTG、IFG等高阶区域表现出强线性关系(r=.93 / .92 / .85),而mSTG(近听觉皮层)几乎没有层级结构(r≈0)。

因为这里只处理了声音本身,语言的语义和结构还未展开。

可一旦进入aSTG、IFG、TP,曲线像被拉开一样,呈现出从浅到深的整齐分布。

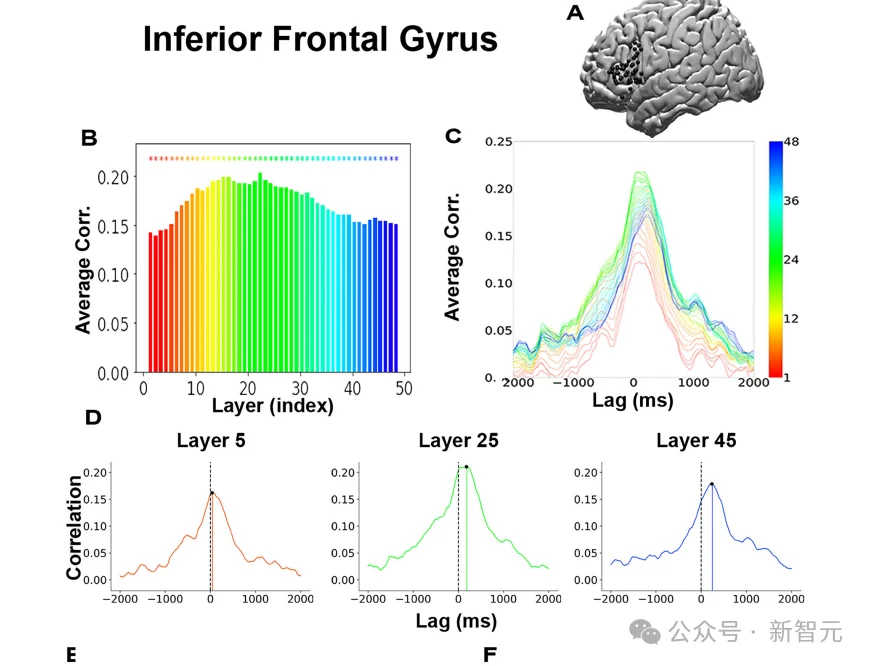

在关键语言区IFG内部,GPT的层级结构同样呈现强烈的时间对应关系。左:浅层至深层的相关度分布(暖色→冷色)。右:浅层峰值更早、深层更晚,形成规律性的时间推移。IFG 的整体拟合度达到r=.85(p < .001)。

一个颠覆性的认知慢慢浮现:

原来,大脑理解语言,并不是先按部就班地解析语法、再一步步地拆解词汇。

它真正做的,是像GPT一样,进行一层又一层的语义推断和概率预测。

而这套高度复杂的推断节奏,竟然与大语言模型的内部深度路径,完美地重合了。

如果GPT的层级结构真能在大脑里找到对应,那么一个更尖锐的问题随之而来:

那些我们以为描述语言「最准确」的传统模型——音位、词素、句法、语义,它们构建的语言理解框架,会呈现出同样的时间结构吗?

传统语言学语法树

研究团队把这四类符号语言学模型全部纳入测试。

要知道,它们的构建逻辑是教科书级的,是数十年来语言学和心理语言学的基础框架。

如果人类语言真的依赖这些规则,那么它们理应比GPT更能精确地预测大脑的反应。

结果很快给出了答案:传统符号模型确实能预测一部分脑电活动,但与GPT的「像不像」程度,差得非常远。

在同样的毫秒级时间轴上,这些符号模型的预测曲线找不到明确的「浅到深」、「早到晚」的序列分布。

它们没有层级,也没有时间推进,像是缺失了某种连续、动态的语言动力。

对比之下,GPT的嵌入式表示呈现的是一种「流动式」的处理轨迹:意义随着时间被不断更新、压缩、整合,每一层都有自己的位置,像精密的齿轮嵌在上下文里。

而符号模型的结构,更像是静止的、离散的标签堆叠,无法在毫秒级的时间维度里,给出足够细致的、动态的映射。

这无疑得出了一个颠覆性的结论:人脑的语言机制,并不是符号规则的简单堆叠,而是一种连续的、深度预测式的加工过程。

当我们试图用语法树解释语言时,大脑实际上已经完成了几十层的非线性变换;而这些变换,正是Transformer模型最擅长的核心能力。

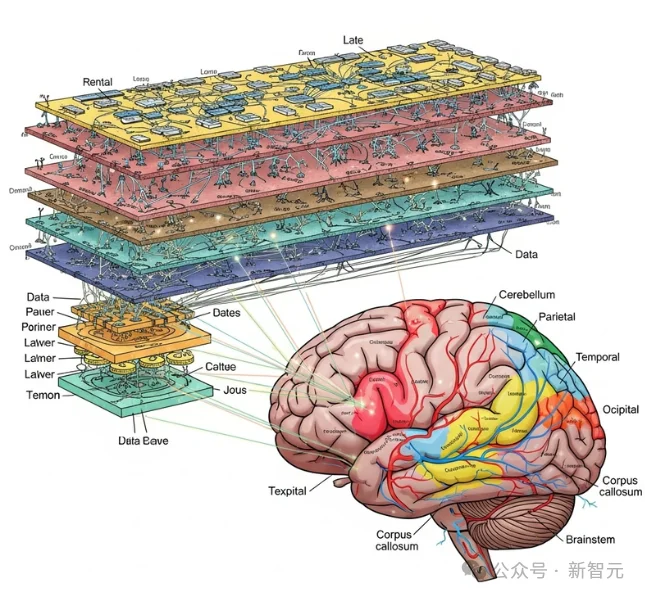

视觉对比:神经网络与人脑

换句话说,符号模型能告诉我们「语言是什么」,但GPT却更像是在展示「大脑是如何处理语言的」。

这是一个真正的分水岭。语言学的解释框架与神经科学的实证结果,第一次发生了如此明显的认知分歧。

而站在大脑这一侧,替大脑说话的,是那台我们本以为只是「模仿人类」的GPT。

当GPT的层级能在人脑里找到清晰的时间对应,当耗费了几十年心血的符号语言学模型在毫秒级脑电面前显得迟缓、无序时,这项研究的意义已经超出了单纯的模型比拼。

它其实指向了一个更底层、更古老的问题:语言到底是什么?

过去几十年,我们用语法规则解释句子,用语义网络解释概念,用树状结构描述语言的逻辑关系。

这些框架强调「结构、类别、层次」,却很少讨论语言在大脑中的即时生成方式:它如何在毫秒级连续变化?如何在瞬间整合过去与未来?

而这次的结果,彻底呈现出一种截然不同的景象——

大脑处理语言,根本不像在执行规则,而更像是在沿着一条不断压缩、预测、更新的轨道向前推进。

浅层负责快速提取线索;中层开始整合语境;深层构建较长的意义链条。

整个过程,不是一棵静止的「语法树」,而是一种向前流动的计算。

这正是Transformer模型在被设计出的,试图通过多层、非线性、依赖上下文、随时间滚动更新等特性来捕捉的「流动结构」。

讽刺的是,我们一直以为这是工程师的发明。现在看来,它更像是大脑本身为了高效处理信息,在数十亿年进化中选择的一条计算路径。

这让语言的定义悄悄发生了变化——语言不再是规则体系,而是一种动态预测机制。

我们理解一句话,并不是先知道它的语法,再去匹配意义;而是在每一毫秒里,把「下一刻可能发生什么」算出来。

GPT就是按照这种方式训练的。

也许这就是为什么,当我们越来越依赖大型语言模型时,总觉得它们像在理解我们。

不是因为它们学会了人类的规则,而是因为它们意外地匹配了人类大脑的节奏。

当GPT的内部层级在大脑里找到了清晰的时间对应,我们看到的,已经不再是某一个AI模型的「胜利」,而是一种结构上的趋同,一种底层计算规律的殊途同归。

语言的本质,也许从不是静态的语法规则,而是连续的、动态的预测。

大脑靠这种机制来理解世界、整合信息;模型靠这种机制来生成语言、模拟智能。

最终,两条路径在同一个高效的计算规律上相遇了。

我们熟悉的语言学和认知科学框架,或许需要一次全面的更新。

理解GPT的内部结构,也许正是在重新理解我们自己。

参考资料:

https://neurosciencenews.com/ai-language-brain-30025/

https://www.nature.com/articles/s41467-025-65518-0

文章来自于“新智元”,作者 “倾倾”。