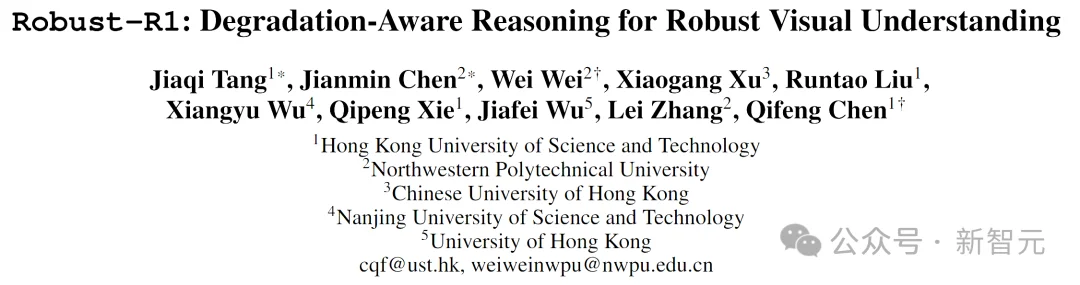

多模态大语言模型(MLLMs)已成为AI视觉理解的核心引擎,但其在真实世界视觉退化(模糊、噪声、遮挡等)下的性能崩溃,始终是制约产业落地的致命瓶颈。近日,一篇被AAAI 2026接收为Oral的重磅论文Robust-R1,给出了革命性解法:来自香港科技大学、西北工业大学等团队首次跳出「隐式适应」的思维定式,将视觉退化问题重构为显式结构化推理任务,让模型不仅「抗干扰」,更能「诊干扰」,在多项权威评测中实现质量与鲁棒性的双重突破。

当多模态大模型(MLLMs)从实验室走向真实世界,它们遇到了一个致命瓶颈:视觉退化。

雨滴斑驳的车窗、年代久远的监控录像、网络压缩的低质图片、医疗影像的固有噪声……

这些在真实世界中无处不在的视觉退化,足以让最先进的GPT-4V、Qwen-VL等模型产生荒谬输出,成为其在自动驾驶、医疗影像、安防监控等关键领域落地的「阿喀琉斯之踵」。

现有方法的根本困境在于「隐式适应」:通过对抗训练、数据增强等手段,试图让模型「硬扛」干扰。

这如同给模型戴上更厚的滤镜——治标不治本,且不可解释。模型在特定退化上表现提升,却无法理解退化本身,更无法泛化到未知干扰,其决策过程仍是黑箱。

今天,这一困局迎来范式级的突破。

香港科技大学、西北工业大学等团队提出的Robust-R1,实现了从「抵抗干扰」到「理解干扰」的范式转变,首次将退化感知提升为一种显式的结构化推理能力,让视觉大模型学会「自我诊断」。

论文链接: https://arxiv.org/abs/2512.17532

开源代码: https://github.com/jqtangust/Robust-R1

开源模型: https://huggingface.co/Jiaqi-hkust/Robust-R1

开源数据: https://huggingface.co/datasets/Jiaqi-hkust/Robust-R1

在线Demo: https://huggingface.co/spaces/Jiaqi-hkust/Robust-R1

Robust-R1的核心思想是为视觉大模型构建一套「退化感知推理系统」。面对一张退化图像,模型会主动执行一个三步诊断流程:

这套流程的关键在于「显式化」与「可解释」。

与黑箱模型不同,Robust-R1的每一个判断都伴随着完整的推理链条,每一步的思考都以结构化文本呈现,使得模型的决策依据透明、可追溯、可验证。

如同一位放射科医生在阅片时,不仅给出诊断,更标注出影响诊断的图像质量因素。这不仅是性能的提升,更是向可信、可靠AI迈出的关键一步。

Robust-R1与现有方法的对比。现有方法(A)仅通过隐式训练增强视觉编码器;Robust-R1(B)通过显式推理链实现退化感知。

团队首先构建了一套特殊标记体系,将推理过程强制结构化:

<TYPE> [退化类型与强度] <TYPE_END>

<INFLUENCE> [退化如何扭曲语义] <INFLUENCE_END>

<REASONING> [基于原始语义的逻辑重建] <REASONING_END>

<CONCLUSION> [抗干扰最终结论] <CONCLUSION_END>

通过在大规模合成退化数据上进行监督微调,模型习得了「先诊断,后推理」的基本模式。

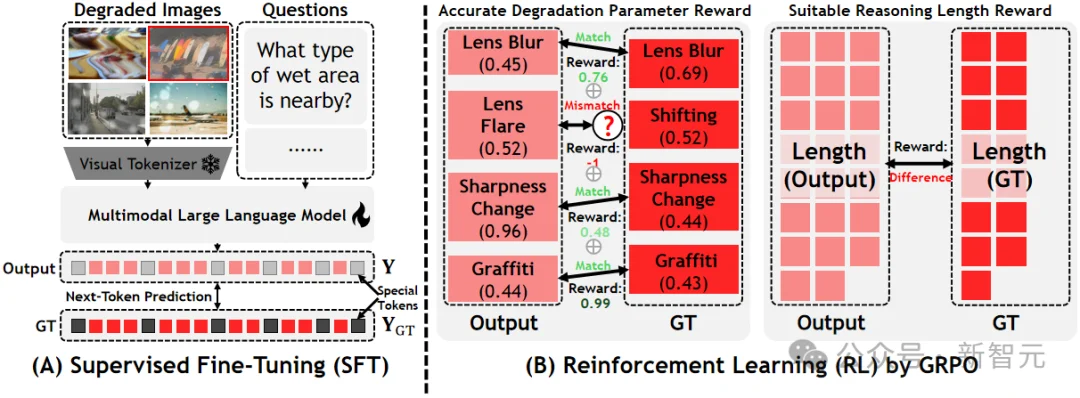

传统方法中,模型对退化的感知是模糊的。Robust-R1设计了退化感知奖励函数,直接优化模型对退化类型与强度的判断准确率:

这一奖励机制确保模型不再是「感觉有点模糊」,而是能量化判断「模糊到什么程度」。

并非所有退化都需要等量计算。Robust-R1引入动态链长调节机制:

轻度退化(如轻微噪点)→ 短链快速推理

重度退化(如严重模糊+遮挡)→ 长链深度分析

Robust-R1的二阶段训练流程示意图

为训练这套系统,研究团队构建了业界首个大规模退化感知推理数据集:

这不仅是数据集,更是一部「视觉退化诊断学」的标准教材。

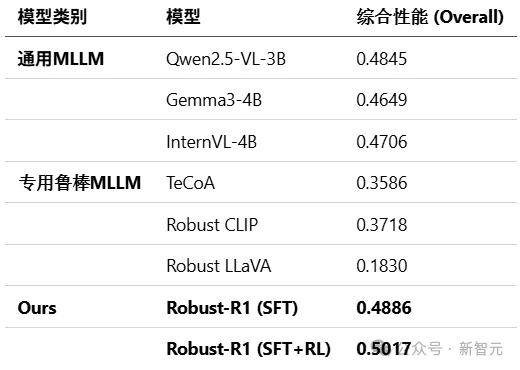

真实退化基准测试 (R-Bench)

在专门评估真实世界退化理解的R-Bench基准上,Robust-R1在低、中、高三种退化强度下,全面超越所有通用及专用鲁棒MLLM基线,取得综合性能第一。

R-Bench基准测试结果,Robust-R1显著领先

对抗退化压力测试

在MMMB、MMStar、RealWorldQA三大通用VQA基准上,对图像施加不同程度的合成退化(强度25%,50%,100%)。Robust-R1展现出极强的抗退化鲁棒性,性能下降幅度远小于基线模型,在极端退化下仍能保持可用精度。

在三大基准上的抗降解性能对比,Robust-R1在各项指标上领先

全面领先:Robust-R1(SFT+RL)在三大基准的所有退化强度下,均取得了最佳或接近最佳的性能。

抗衰减能力强:随着退化强度从25%增加到100%,Robust-R1的性能下降幅度显著小于所有基线模型,证明了其卓越的鲁棒性。

极端场景可用:在100%强度的极端退化下,Robust-R1的性能仍大幅领先于专用鲁棒模型(TeCoA、Robust CLIP),验证了其在实际复杂场景中的可用性。

可解释性展示:打开推理黑箱

以下是Robust-R1处理一张带有退化的花园雕像图像的完整推理链输出:

Robust-R1在退化图像上的可视化推理示例。

诊断:lens blur(0.31), lens flare(0.05)

影响分析:The lens blur affects the clarity of the image, making it slightly less detailed. This can make it challenging to discern finer details or textures, such as the texture of the bears' fur or the surface of the rocks.

原始语义推理:The image depicts three bear statues placed in a garden setting. The bears appear to be made of stone or a similar material, which is consistent with the appearance of fake objects.

结论:The bears in the image are fake, as they are made of stone or a similar material, and the surrounding environment appears artificial. Therefore, the correct answer is 0.

Robust-R1的贡献远不止一项SOTA:

这项工作标志着多模态大模型从追求「在清晰世界中表现完美」,向追求「在复杂现实中可靠决策」的重大转变。

当大多数模型仍在学习如何「看得更清」时,Robust-R1已教会模型如何「在看不清时,依然想得明白」。这才是通向真正智能体的关键一步。

参考资料:

https://arxiv.org/abs/2512.17532

文章来自于“新智元”,作者 “LRST”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner