想象一下,如果让一个大厨用发霉的食材、过期的调料来做菜,即使厨艺再高超,也做不出美味佳肴。AI训练也是同样的道理。

现在的AI图像生成模型,如Stable Diffusion、FLUX等,需要从网络上爬取数百万张图片来学习。但这些图片质量参差不齐:有些模糊不清,有些内容重复,有些甚至只是广告背景图。用这些“食材”训练出来的AI,自然效果不佳。

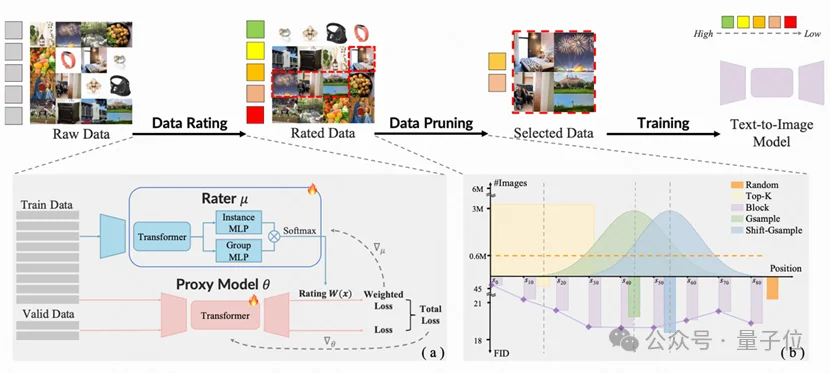

由香港大学丁凯欣领导,联合华南理工大学周洋以及快手科技Kling团队共同完成的这项研究,开发出了一个名为“炼金师”(Alchemist)的AI系统。它就像一位挑剔的大厨,能从海量图片数据中精准挑选出最有价值的一半。

更让人惊喜的是:

传统的数据筛选方法就像用筛子筛米粒,只能按照单一标准过滤:

这些方法的问题在于:它们不知道哪些数据真正有助于AI学习。

“炼金师”更像是一位经验丰富的美食评委,它能同时考虑多个维度:

核心思想:让AI学会观察自己的学习过程

炼金师训练了一个专门的评分员模型,这个评分员就像资深的艺术老师,能够判断每张图片对整个学习过程的价值。

评判标准:

✅如果一张图片能让AI模型学到新知识并快速改进→好数据❌如果一张图片让模型学了半天也没什么进步→无用数据

这就像观察学生做习题时的表情和进步速度,来判断这道题是否适合他们。

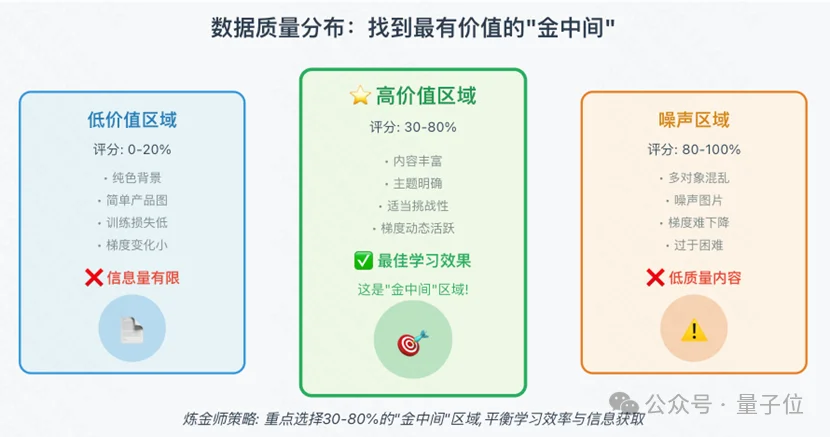

研究团队发现了一个违反直觉的现象:

那些看起来最“简单”的图片,比如纯白背景的产品图:

相反,内容丰富、稍有挑战性的图片,才是真正的“营养品”

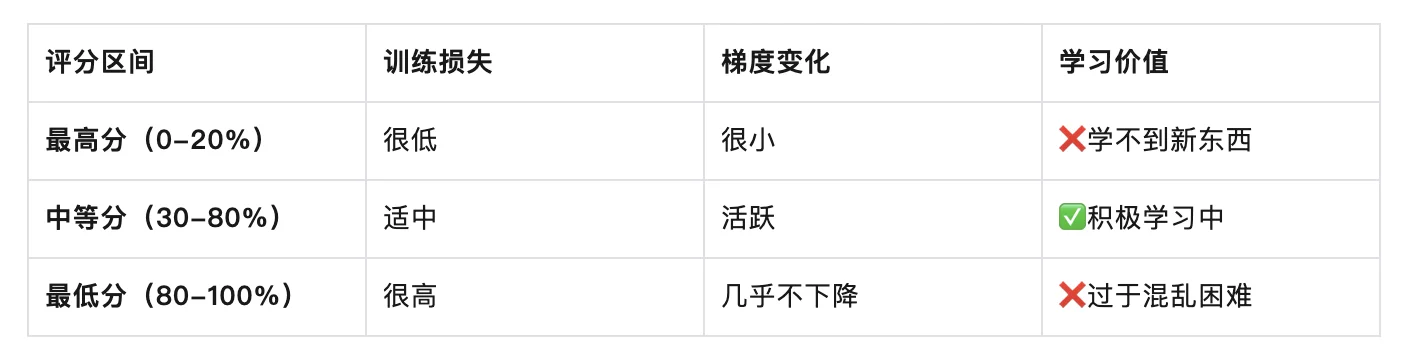

研究团队追踪了不同评分区间图片的训练动态:

基于上述发现,团队提出了“偏移高斯采样”(Shift-Gsample)策略。

传统Top-K方法:

炼金师策略:

这就像制定健身计划:

为了更好地评估数据质量,炼金师还设计了“多粒度感知”机制:

就像营养师不仅关注单个食材的营养价值,还要考虑整餐的营养搭配。

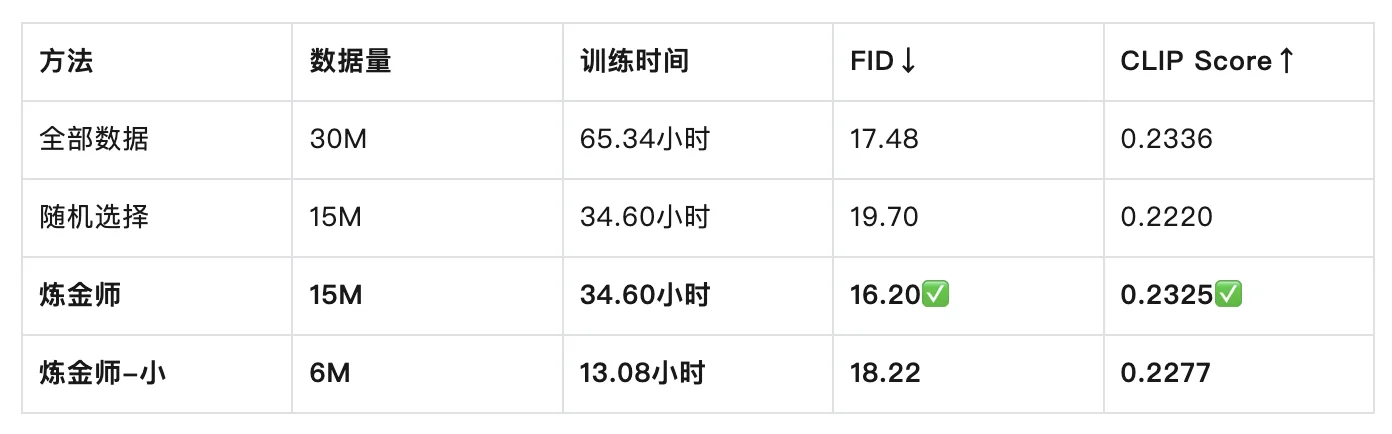

在LAION-30M数据集上:

关键发现:

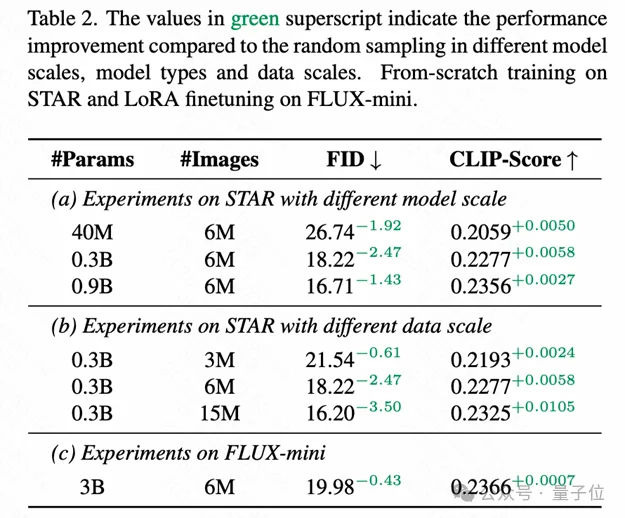

炼金师在不同规模、不同架构的模型上都有效:

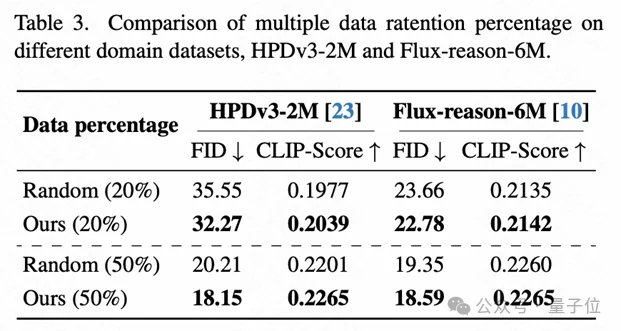

在不同类型数据集上的表现:

HPDv3-2M数据集(真实+合成混合):

Flux-reason-6M数据集(纯合成推理数据):

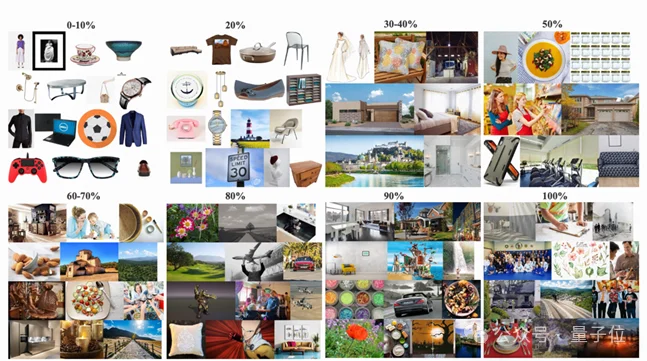

研究团队对筛选后的数据进行了可视化分析:

0-20%高分区域(简单但营养不足):

30-80%中分区域(最有价值的“金中间”):

80-100%低分区域(过于混乱):

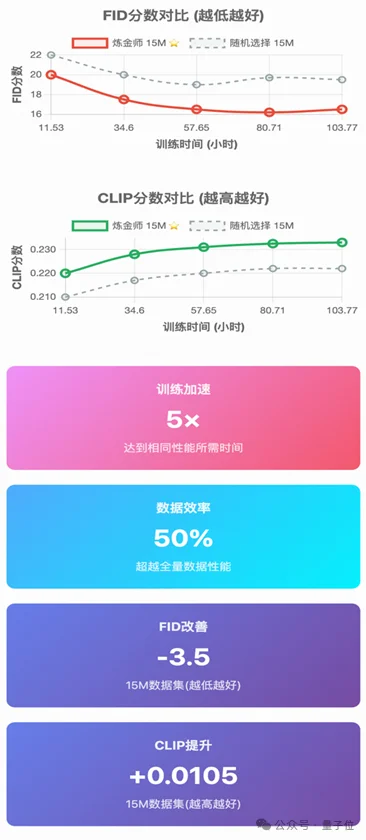

训练稳定性对比:

炼金师选择的数据展现出:✅稳定持续的性能提升✅更快的收敛速度✅更少的训练波动

随机选择的数据则表现出:❌早期训练波动大❌性能提升缓慢❌需要更多epochs才能收敛

炼金师的核心是一个双层优化框架

外层优化:学习如何评分

内层优化:训练代理模型

系统通过观察两个模型的表现差异来更新评分:

评分更新∝代理模型的验证集损失

核心思想:

A:炼金师通过观察AI模型在学习过程中的“反应”来判断数据价值:✅好数据:能让模型学到新知识并快速改进❌差数据:让模型学了半天也没进步

这就像观察学生做题时的表情和进步速度,来判断题目是否合适。

技术细节:

A:因为并非所有数据都有价值,关键在于质量而非数量。

类比说明:

科学原理:1.冗余数据消耗资源但不提升性能:如重复的简单样本、模糊不清的噪声图片2. 有营养的数据促进真实学习:如内容丰富的中等难度样本、多样化的场景和对象3. 避免过拟合:若只用简单数据会导致模型“死记硬背”,还应使用适当难度的数据培养泛化能力

A:可以!研究显示这种方法具有良好的通用性和跨模型适用性。

验证范围:

✅不同数据类型:

✅不同模型架构:

✅不同模型规模:

原理:

Project Page:https://kxding.github.io/project/Alchemist/

Github:https://github.com/KlingTeam/Alchemist/

arXiv:https://arxiv.org/abs/2512.16905

文章来自于微信公众号 “量子位”,作者 “量子位”

【部分开源免费】FLUX是由Black Forest Labs开发的一个文生图和图生图的AI绘图项目,该团队为前SD成员构成。该项目是目前效果最好的文生图开源项目,效果堪比midjourney。

项目地址:https://github.com/black-forest-labs/flux

在线使用:https://fluximg.com/zh

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner