更懂中文还兼顾SD生态,360开源文生图模型结构,寡姐秒变中国新娘 | AAAI

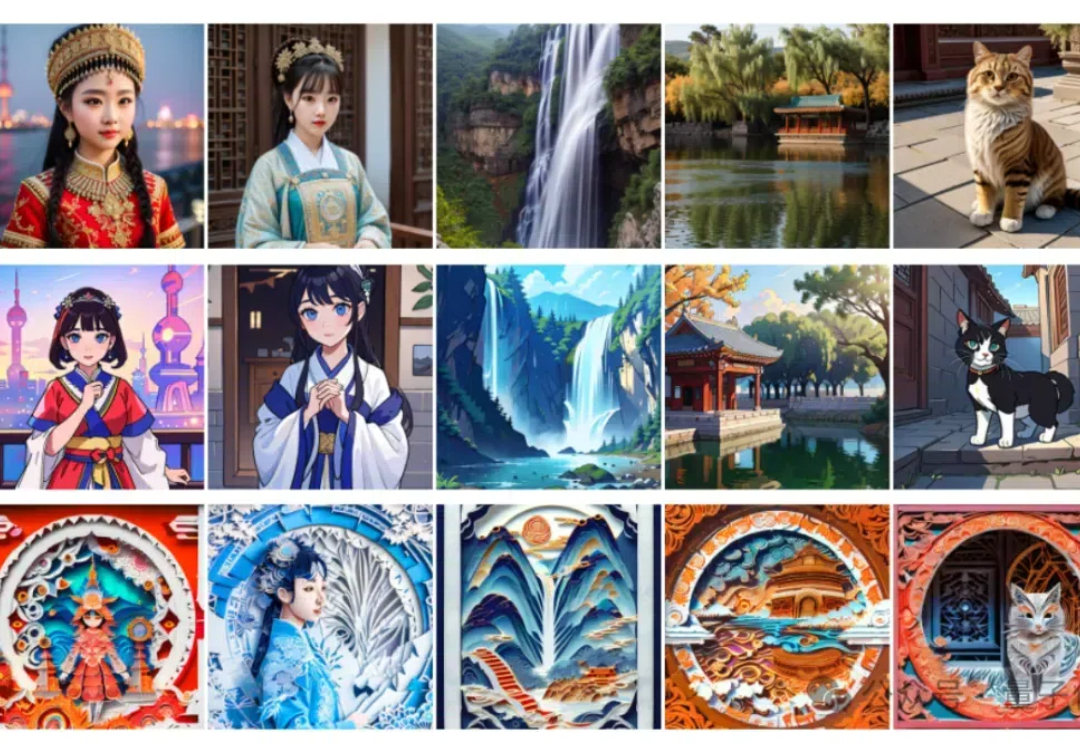

更懂中文还兼顾SD生态,360开源文生图模型结构,寡姐秒变中国新娘 | AAAI具备原生中文理解能力,还兼容Stable Diffusion生态。 最新模型结构Bridge Diffusion Model来了。 与Dreambooth模型结合,它生成的穿中式婚礼礼服的歪国明星长这样。

具备原生中文理解能力,还兼容Stable Diffusion生态。 最新模型结构Bridge Diffusion Model来了。 与Dreambooth模型结合,它生成的穿中式婚礼礼服的歪国明星长这样。

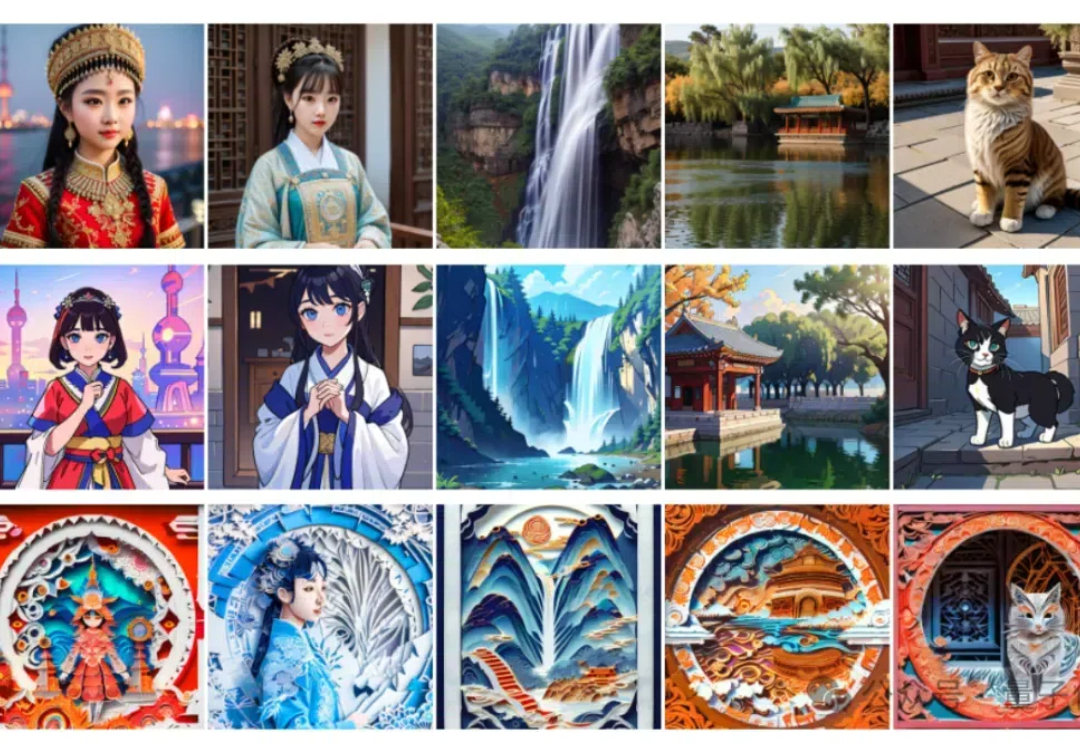

多模态大模型内嵌语言模型总是出现灾难性遗忘怎么办?

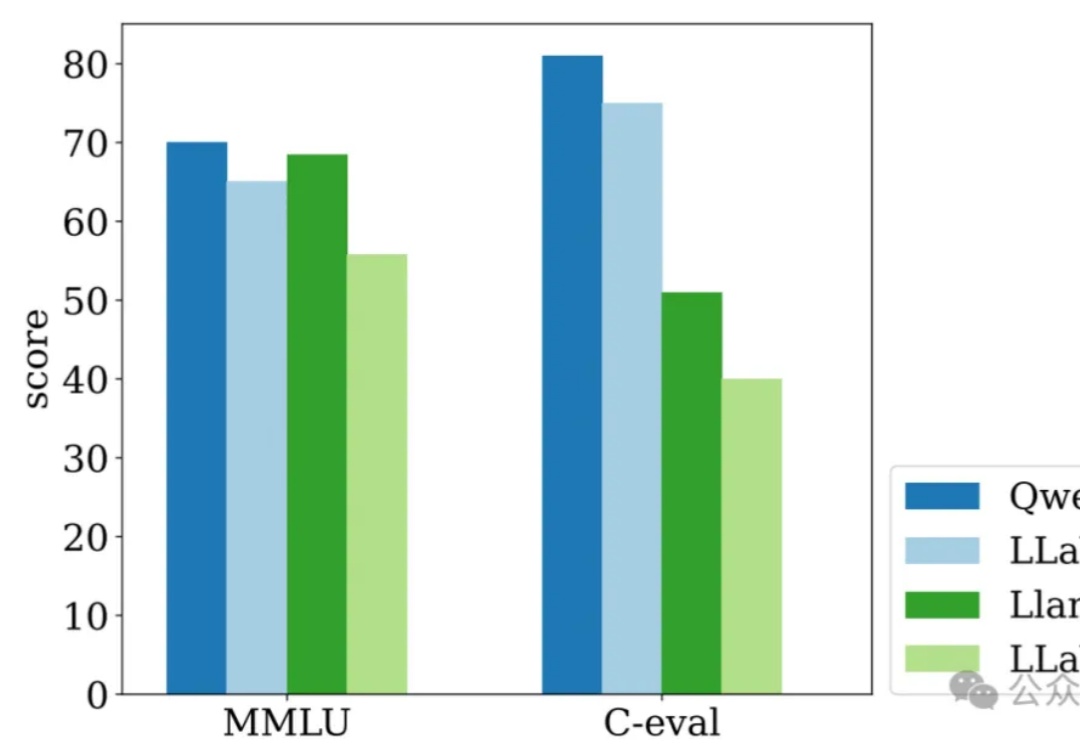

该论文的第一作者和通讯作者均来自北京大学王选计算机研究所的 MIPL实验室,第一作者为博士生徐铸,通讯作者为博士生导师刘洋。MIPL 实验室近年来在 IJCV、CVPR、AAAI、ICCV、ICML、ECCV 等顶会上有多项代表性成果发表,多次荣获国内外 CV 领域重量级竞赛的冠军奖项,和国内外知名高校、科研机构广泛开展合作。

AAAI 2024 奖项陆续公布,继杰出论文奖后,今天博士论文奖也公布了。

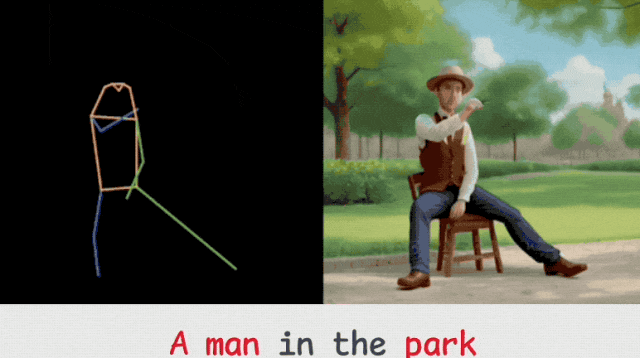

视频生成还可以这么玩?来一个“火柴人”做做动作示范,再加文本描述,即可让各种形象惟妙惟肖地跟着动起来。

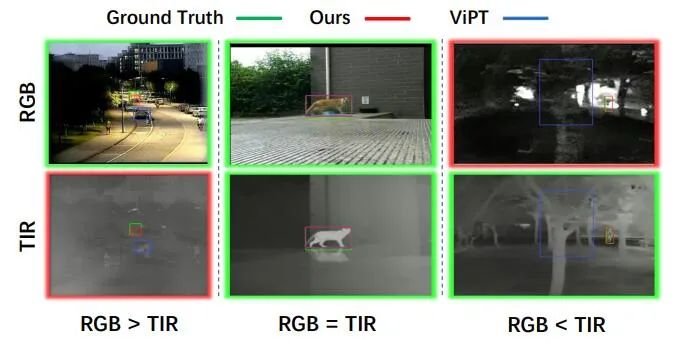

目标跟踪是计算机视觉的一项基础视觉任务,由于计算机视觉的快速发展,单模态 (RGB) 目标跟踪近年来取得了重大进展。考虑到单一成像传感器的局限性,我们需要引入多模态图像 (RGB、红外等) 来弥补这一缺陷,以实现复杂环境下全天候目标跟踪。

自从ChatGPT发布后,各种基于大模型的产品也快速融入了普通人的生活中,但即便非AI从业者在使用过几次后也可以发现,大模型经常会胡编乱造,生成错误的事实。

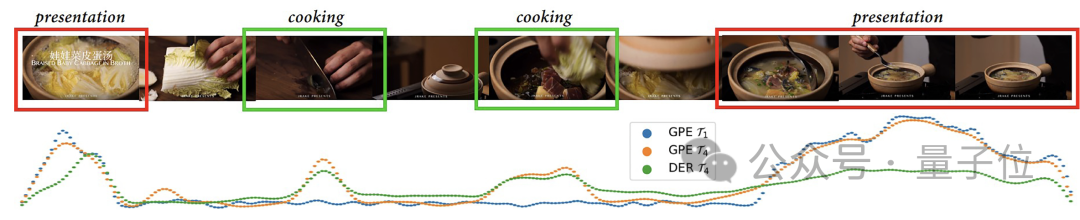

字节跳动联合中科院自动化研究所提出新方法,用AI快速检测出视频中的高光片段,对输入视频的长度以及期望提取的高光长度都具有极高的灵活性,相关论文已被AAAI 2024收录。

如何从一段视频中找出感兴趣的片段?时序行为检测(Temporal Action Localization,TAL)是一种常用方法。过去TAL中的建模是片段甚至实例级的,而现在只要视频里的一帧就能实现,效果媲美全监督。

今日,AAAI 公布了 2024 年度的 Fellow 评选结果,共 12 位学者入选,其中包括清华大学教授朱军。