OpenAI首席研究员Mark Chen长访谈:小扎亲手端汤来公司挖人,气得我们端着汤去了Meta

OpenAI首席研究员Mark Chen长访谈:小扎亲手端汤来公司挖人,气得我们端着汤去了Meta救大命,OpenAI首席研究官Mark Chen最新访谈,信息量有点大呀。

救大命,OpenAI首席研究官Mark Chen最新访谈,信息量有点大呀。

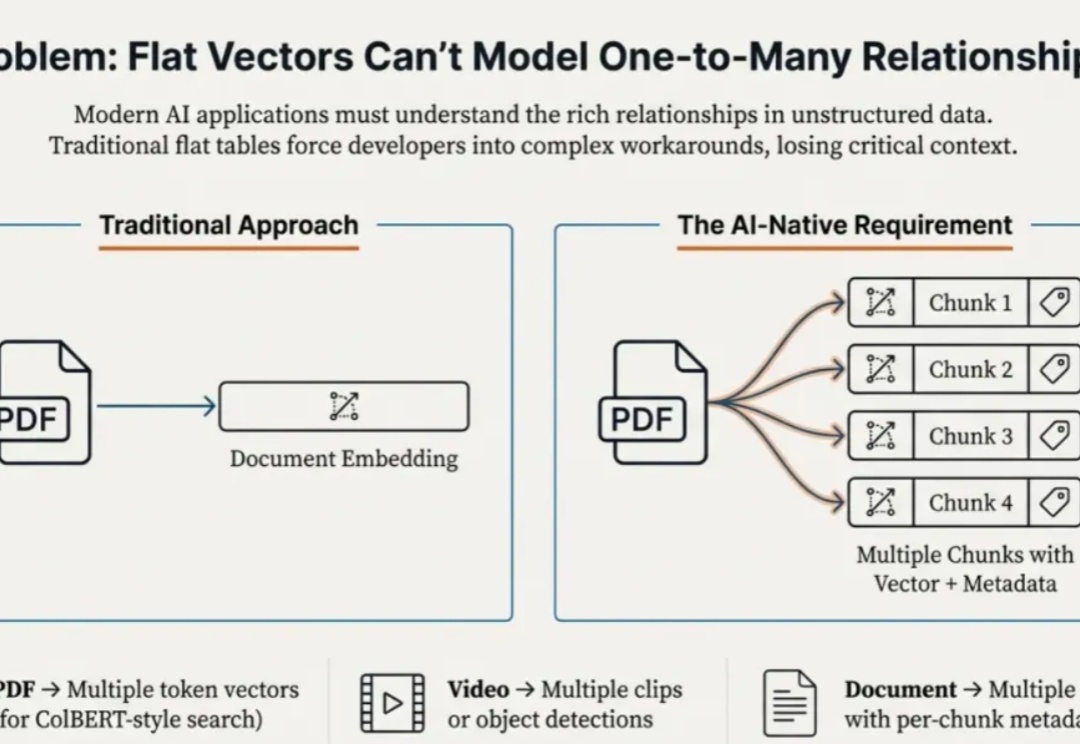

本文为Milvus Week系列第二篇,该系列旨在分享Zilliz、Milvus在系统性能、索引算法和云原生架构上的创新与实践,以下是DAY2内容划重点: Struct Array + MAX_SIM ,能够让数据库看懂 “多向量组成一个实体” 的逻辑,进而原生返回业务要的完整结果

三年河东三年河西,曾经逼疯谷歌的奥特曼,如今也被谷歌逼得拉响了「红色警报」,AI王座之下已是刀光剑影。更劲爆的是,最强「Garlic」在预训练取得重大突破,正面硬刚Gemini 3.

刚刚,「欧洲的 DeepSeek」Mistral AI 刚刚发布了新一代的开放模型 Mistral 3 系列模型。该系列有多个模型,具体包括:「世界上最好的小型模型」:Ministral 3(14B、8B、3B),每个模型都发布了基础版、指令微调版和推理版。

arXiv最新政策禁止直接接收未经同行评审的综述和立场论文,以应对AI生成论文的泛滥,但堵不如疏。多伦多大学、清华、北大等18所国内外顶尖高校联合发布新平台aiXiv,支持AI和人类共同撰写、评审和迭代科研成果,采用多阶段AI同行评审机制,提升效率和质量。

5000亿美元,是NASA预估能让人类完成火星登陆的预算、能买下1.36个阿里(3670亿美元)、3.5个NBA联盟(1400亿美元)、建设100座Apple Park(50亿美元)、买1400亿杯咖啡(3.5美元),却只够OpenAI建一座Stargate数据中心。

Perplexity 的首席执行官 Aravind Srinivas 曾直言不讳:“世上万物皆是套壳(Everything is a wrapper)。OpenAI 套的是英伟达的算力和 Azure 的云服务;Netflix 套的是 AWS 的基础设施;就连市值高达 3200 亿美元的 Salesforce,归根结底也不过是 Oracle 数据库的一个高级外壳。”你

终于,几天前登上 Artificial Analysis 榜首的神秘模型 Whisper Thunder (aka) David 现出了真身。

这是一篇报告解读,原文是《DeepSeek-V3.2: Pushing the Frontier of Open Large Language Models》

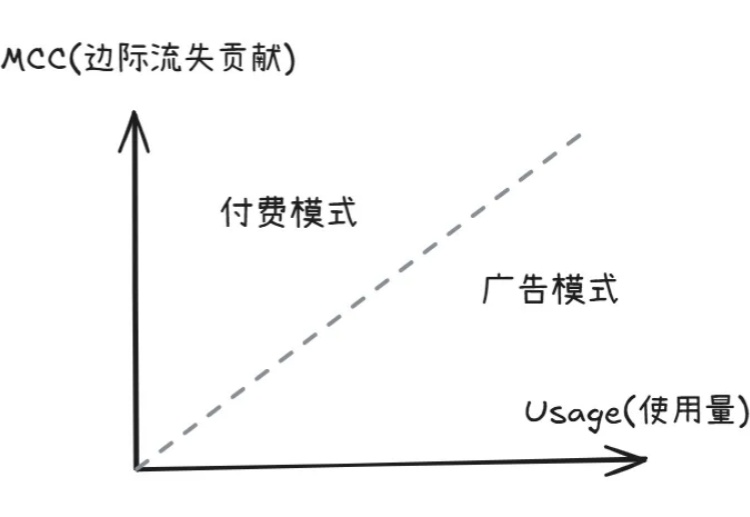

Marc Andreessen 常说:"这个世界上赚钱的方式只有两种,要么 bundle(组合) ,要么 unbundle(拆分) 。"