AIGC检测为何频频“看走眼”?腾讯优图揭秘:问题可能出在数据源头

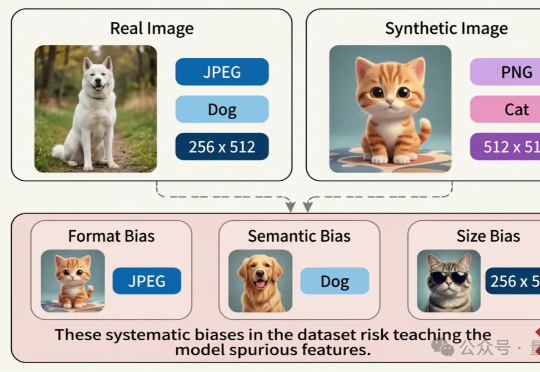

AIGC检测为何频频“看走眼”?腾讯优图揭秘:问题可能出在数据源头近日,腾讯优图实验室联合华东理工大学、北京大学等研究团队在A生成图像检测(AI-Generated Image Detection)泛化问题上展开研究,提出Dual Data Alignment(双重数据对齐,DDA)方法,从数据层面系统性抑制“偏差特征”,显著提升检测器在跨模型、跨数据域场景下的泛化能力。

近日,腾讯优图实验室联合华东理工大学、北京大学等研究团队在A生成图像检测(AI-Generated Image Detection)泛化问题上展开研究,提出Dual Data Alignment(双重数据对齐,DDA)方法,从数据层面系统性抑制“偏差特征”,显著提升检测器在跨模型、跨数据域场景下的泛化能力。

刚刚,Anthropic 发布了一项新研究成果。今天,他们发布的成果是《Natural emergent misalignment from reward hacking》,来自 Anthropic 对齐团队(Alignment Team)。他们发现,现实中的 AI 训练过程可能会意外产生未对齐的(misaligned)模型。

阿里巴巴集团安全部联合清华大学、复旦大学、东南大学、新加坡南洋理工等高校,联合发布技术报告;其理念与最近OpenAI发布的GPT-5 System Card放在首位的“From Hard Refusals to Safe-Completions”理念不谋而合。

这份提示词有很多哲学性思考,很多表达让我看到背后的设计者把claude当成一个人去设计。 我猜,应该是Amanda Askell(Anthropic负责alignment和character design,是学哲学的一位女生,也是我的榜样) 主要设计的。

OpenAI 在 “双十二” 发布会的最后一天公开了 o 系列背后的对齐方法 - deliberative alignment,展示了通过系统 2 的慢思考能力提升模型安全性的可行性。

OpenAI o1风格的推理大模型,有行业垂直版了。HK-O1aw,是由香港生成式人工智能研发中心(HKGAI)旗下AI for Reasoning团队(HKAIR) 联合北京大学对齐团队(PKU-Alignment Team)推出的全球首个慢思考范式法律推理大模型。

随着人工智能大模型的能力日益强大,如何让其行为和目标同人类的价值、偏好、意图之间实现协调一致,即人机对齐(human-AI alignment)问题,变得越发重要。

随着大规模语言模型的快速发展,如 GPT、Claude 等,LLM 通过预训练海量的文本数据展现了惊人的语言生成能力。然而,即便如此,LLM 仍然存在生成不当或偏离预期的结果。这种现象在推理过程中尤为突出,常常导致不准确、不符合语境或不合伦理的回答。为了解决这一问题,学术界和工业界提出了一系列对齐(Alignment)技术,旨在优化模型的输出,使其更加符合人类的价值观和期望。

近年来,大模型的高速发展极大地改变了人工智能的格局。对齐(Alignment) 是使大模型的行为符合人类意图和价值观,引导大模型按照人类的需求和期望进化的核心步骤,因此受到学术界和产业界的高度关注。

这篇文章对如何进行领域模型训练进行一个简单的探讨,主要内容是对 post-pretrain 阶段进行分析,后续的 Alignment 阶段就先不提了,注意好老生常谈的“数据质量”和“数据多样性”即可。