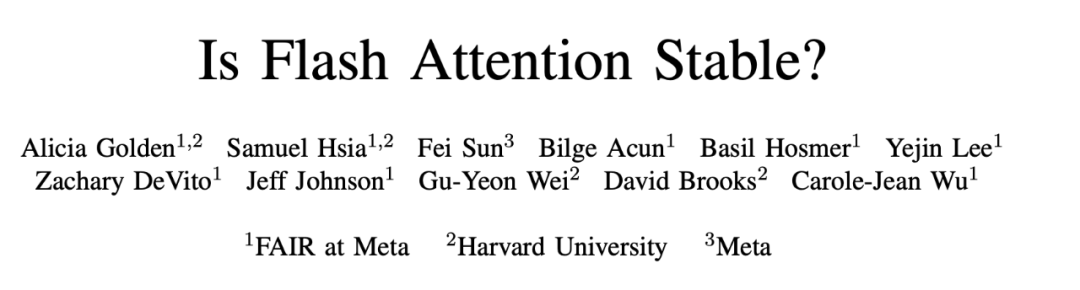

Flash Attention稳定吗?Meta、哈佛发现其模型权重偏差呈现数量级波动

Flash Attention稳定吗?Meta、哈佛发现其模型权重偏差呈现数量级波动众所周知,大语言模型的训练常常需要数月的时间,使用数百乃至上千个 GPU。以 LLaMA2 70B 模型为例,其训练总共需要 1,720,320 GPU hours。由于这些工作负载的规模和复杂性,导致训练大模型存在着独特的系统性挑战。

众所周知,大语言模型的训练常常需要数月的时间,使用数百乃至上千个 GPU。以 LLaMA2 70B 模型为例,其训练总共需要 1,720,320 GPU hours。由于这些工作负载的规模和复杂性,导致训练大模型存在着独特的系统性挑战。

AIGC新应用,到底将重塑怎样的一个新世界? 现在,只需一天的时间,你就能感受到它们正在引领的科技新范式。

该团队的新模型在多个基准测试中都与 Gemini Pro 、GPT-3.5 相媲美。

不久前,AI新光年与知衣科技创始人兼CEO郑泽宇就“人工智能如何改变服装行业”的话题进行了一次探讨。2024年伊始,这位年轻的AI高级工程师做完了2023年复盘,也做好了新一年的规划。

Hyena处理长序列输入比FlashAttention速度高100倍!最新发布的StripedHyena模型可能成下一代AI架构的新标准?

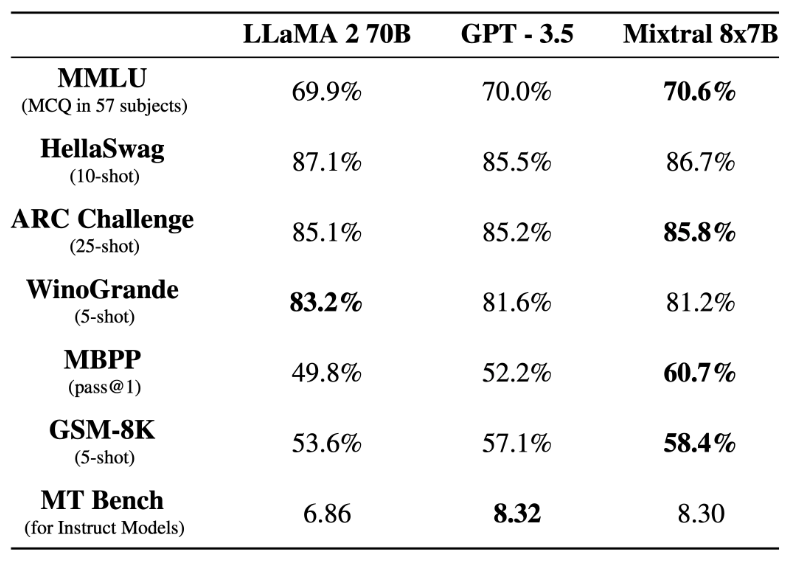

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

随着文本至图像的人工智能 Diffusion 模型的出现,为数字漫画领域揭示了一个充满希望的机遇。加利福尼亚州的 Dashtoon 公司抓住这个机会,致力于将这项尖端技术推广到全世界的故事讲述者者中。

今天股票交易市场上出现了革命性创新产品OVTLYR,这是一个AI股票交易助手。

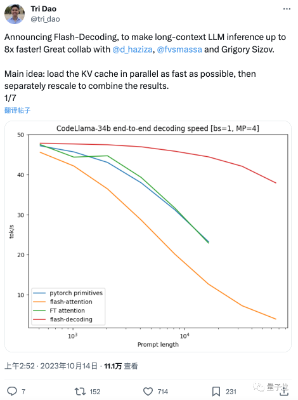

这两天,FlashAttention团队推出了新作: 一种给Transformer架构大模型推理加速的新方法,最高可提速8倍。 该方法尤其造福于长上下文LLM,在64k长度的CodeLlama-34B上通过了验证