1人顶1个Infra团队!OpenAI前CTO新招,让大模型训练跌成白菜价

1人顶1个Infra团队!OpenAI前CTO新招,让大模型训练跌成白菜价当大模型竞争转向后训练,继续为闲置显卡烧钱无异于「慢性自杀」。如今,按Token计费的Serverless模式,彻底终结了算力租赁的暴利时代,让算法工程师真正拥有了定义物理世界的权利。

当大模型竞争转向后训练,继续为闲置显卡烧钱无异于「慢性自杀」。如今,按Token计费的Serverless模式,彻底终结了算力租赁的暴利时代,让算法工程师真正拥有了定义物理世界的权利。

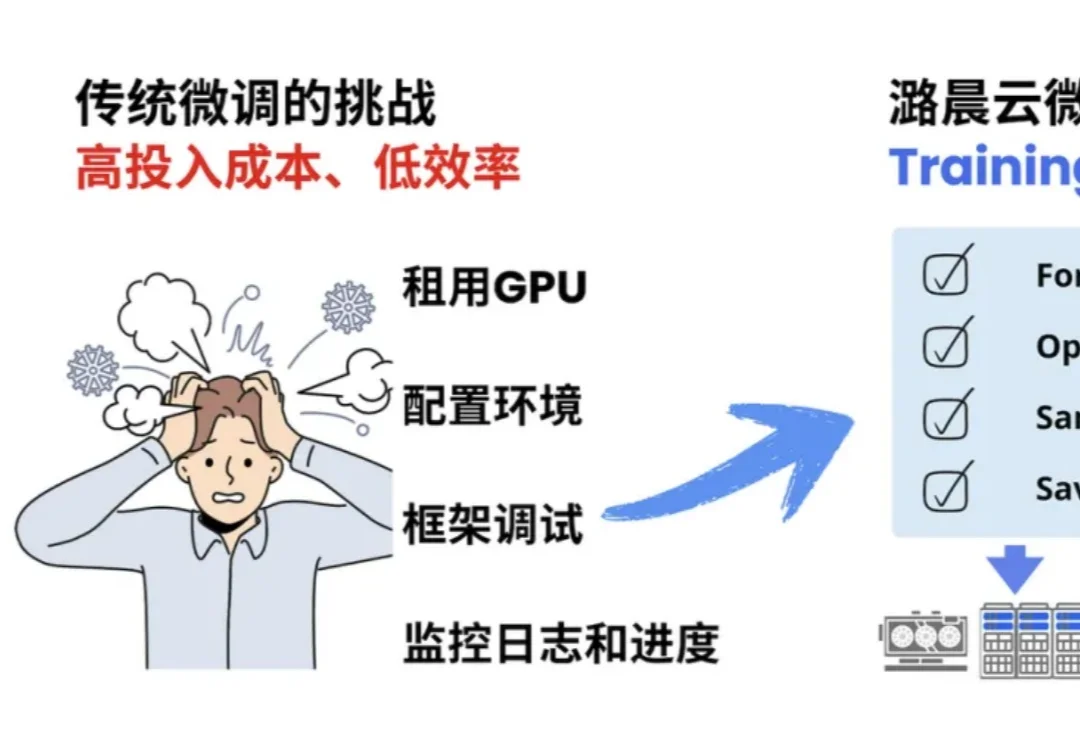

当 OpenAI 前 CTO Mira Murati 创立的 Thinking Machines Lab (TML) 用 Tinker 创新性的将大模型训练抽象成 forward backward,optimizer step 等⼀系列基本原语,分离了算法设计等部分与分布式训练基础设施关联,

键盘不会立刻消失,但在越来越多的场景里,它已经悄悄退成语音之后的「编辑器」。如果几年前有人跟我说,「你以后写稿可能不怎么需要键盘了」,我大概会把这句话当成一句玩笑。那时候我正处在对机械键盘的迷恋期,研究轴体、键帽、键程,购入过 Cherry、Filco、NiZ、Keychron、3D 打印分体式键盘。甚至为了提高打字效率,专门学习过双拼输入法。

对初创公司来说,Superlinear(指数引力)的第一个业务 Deeplink 堪称成功:去年成立,今年的 ARR(年经常性收入) 就达到 500 万美元;且已经实现盈利。但创始人于北川并不打算在这个业务上继续重点投入,而是带领核心团队,全力转向了一款新产品 Lessie AI。

如果不是这波大模型的爆发,没人会想到「输入法」这个早已被视为「基础设施」的赛道,会在 2025 年下半年突然变得性感起来。

谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。

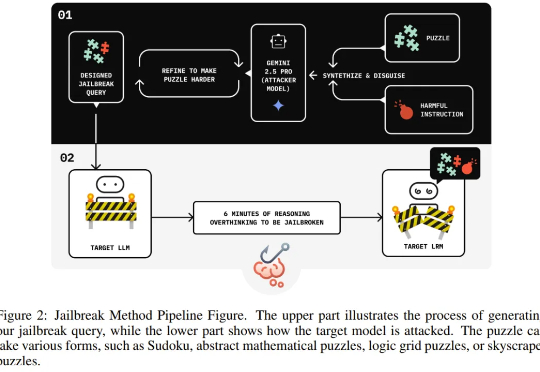

独立研究者 Jianli Zhao 等人近日的一项新研究发现,通过在有害请求前填充一长串无害的解谜推理序列(harmless puzzle reasoning),就能成功对推理模型实现越狱攻击。他们将这种方法命名为思维链劫持(Chain-of-Thought Hijacking)。

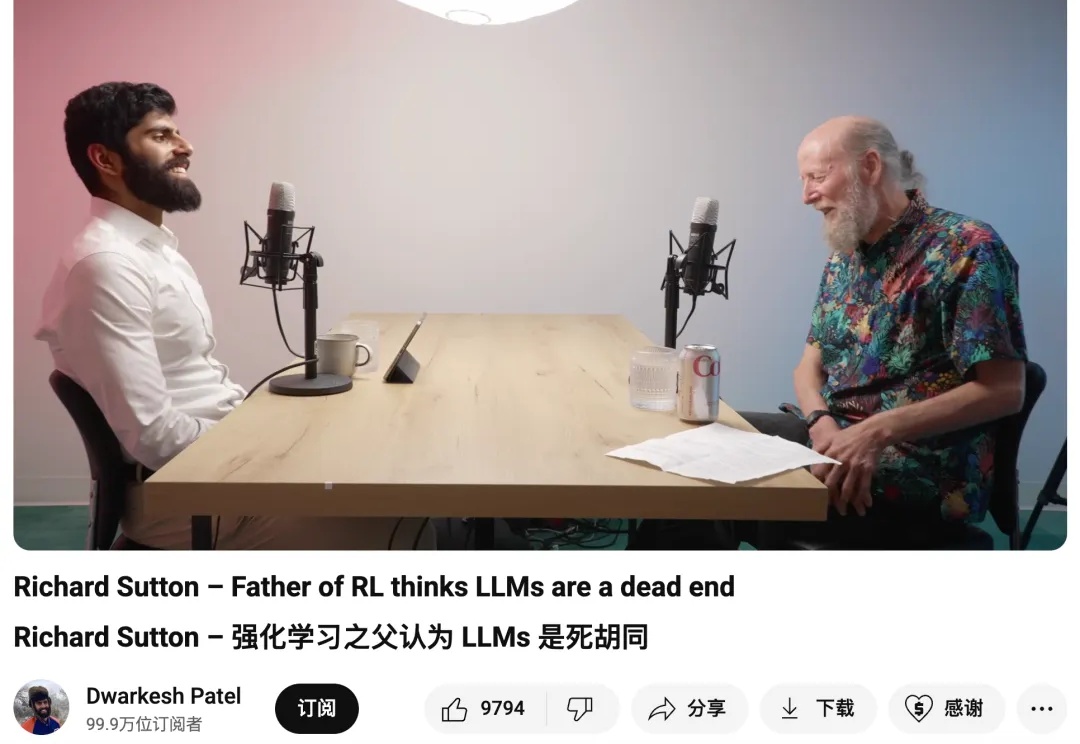

在这个新访谈中,Sutton 与多位专家一起,进一步探讨 AI 研究领域存在的具体问题。

Lessie 的定位简单直接:People Search AI Agent。一句话描述它的能力:帮你从互联网与数据库里快速找到任何人,并自动化完成初步联络。创始人、投资人、KOL、潜在客户、行业专家、合作伙伴……只要你能用自然语言描述需求,Lessie 就能迅速在全球范围内挖掘到合适的人选。

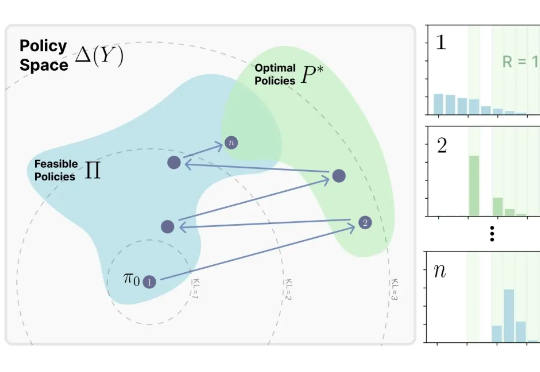

来自MIT Improbable AI Lab的研究者们最近发表了一篇题为《RL's Razor: Why Online Reinforcement Learning Forgets Less》的论文,系统性地回答了这个问题,他们不仅通过大量实验证实了这一现象,更进一步提出了一个简洁而深刻的解释,并将其命名为 “RL's Razor”(RL的剃刀)。