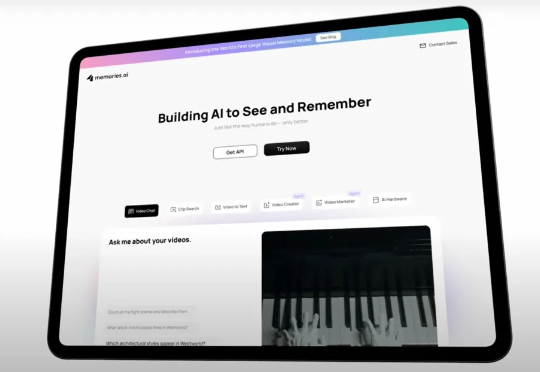

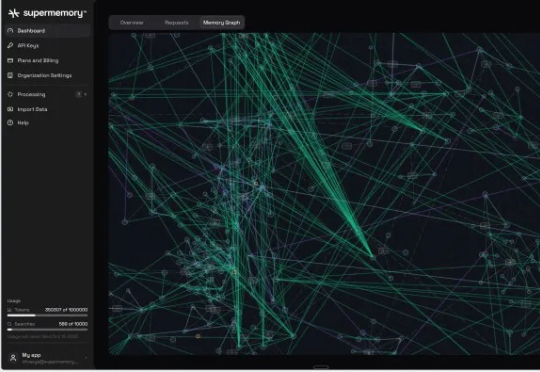

速递|19岁少年获谷歌AI掌门人投资,Supermemory用知识图谱为AI构建长期记忆

速递|19岁少年获谷歌AI掌门人投资,Supermemory用知识图谱为AI构建长期记忆Supermemory 已获得由 Susa Ventures、Browder Capital 和 SF1.vc 领投的 260 万美元种子轮融资。此轮融资还包括 Cloudflare 的 Knecht、谷歌人工智能负责人 Jeff Dean、DeepMind 产品经理 Logan Kilpatrick、Sentry 创始人 David Cramer 以及来自 OpenAI、