黄仁勋CES放出大杀器:下一代Rubin架构推理成本降10倍

黄仁勋CES放出大杀器:下一代Rubin架构推理成本降10倍「每隔 10 到 15 年,计算行业就会革新一次,每次都会催生出新形态的平台。现在,有两个转变在同时进行:应用将会构建于 AI 之上,你构建软件的方式也将改变。」

「每隔 10 到 15 年,计算行业就会革新一次,每次都会催生出新形态的平台。现在,有两个转变在同时进行:应用将会构建于 AI 之上,你构建软件的方式也将改变。」

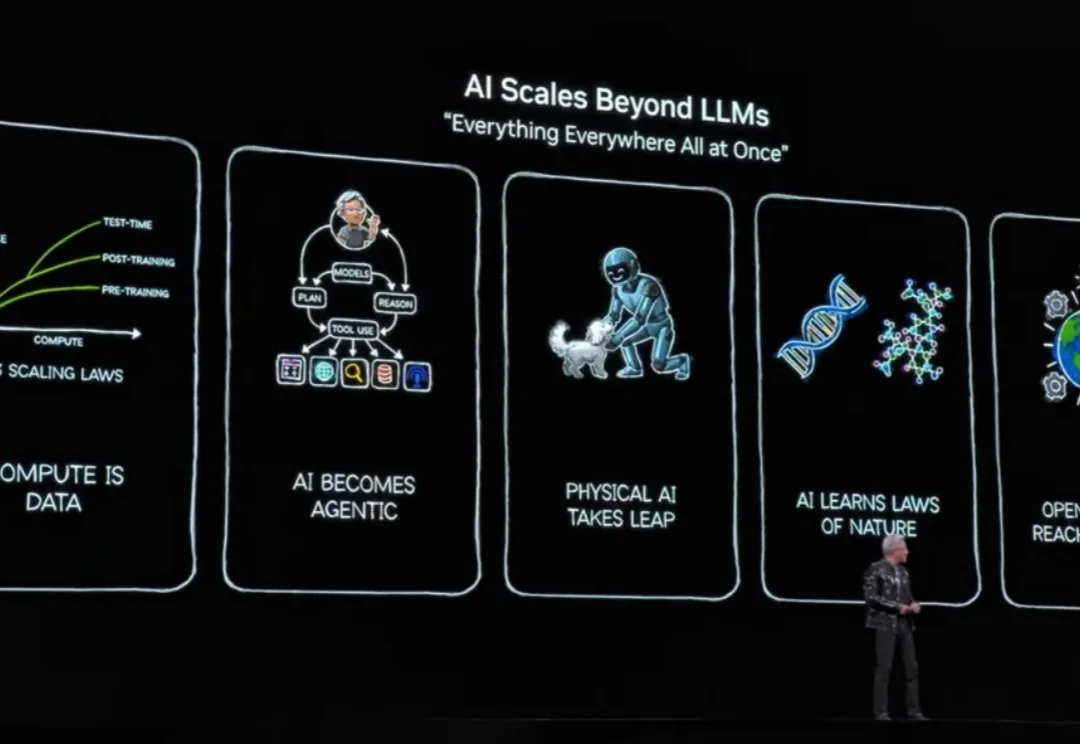

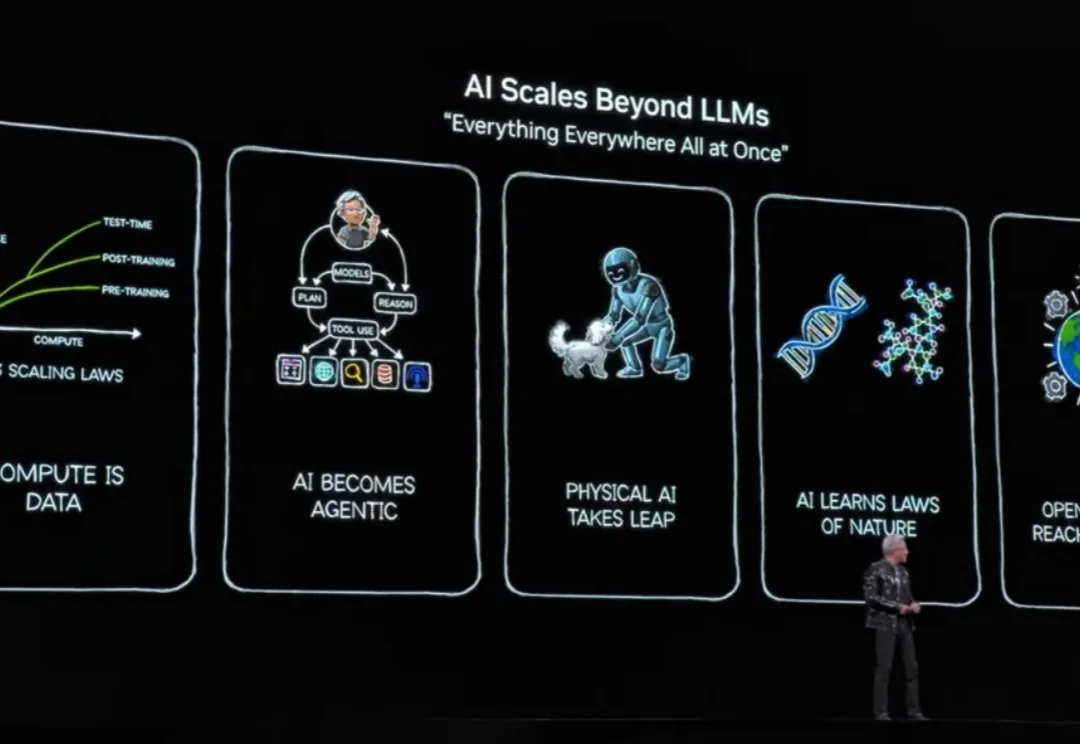

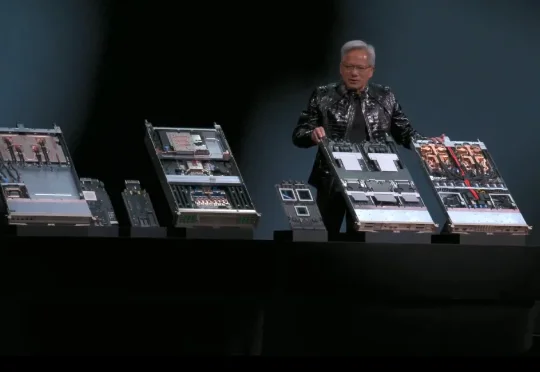

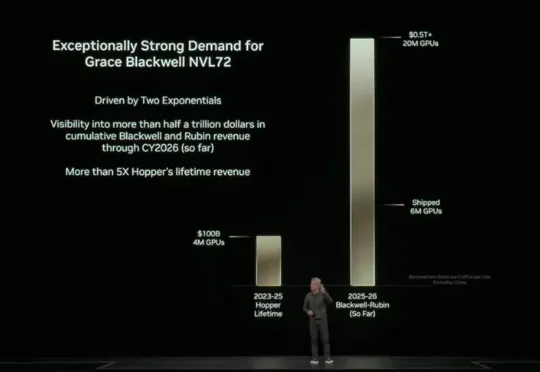

北京时间 1 月 6 日凌晨 5 点多,英伟达创始人兼 CEO 黄仁勋在 CES 2026 发表了主题演讲,演讲核心只有几个字——物理 AI。期间有一页 PPT 暂时没展示出来,他自嘲道演讲场地在拉斯维加斯所以应该是有人中了头奖导致的。期间,他和两台小机器人的互动,成为了本次演讲的名场面之一。

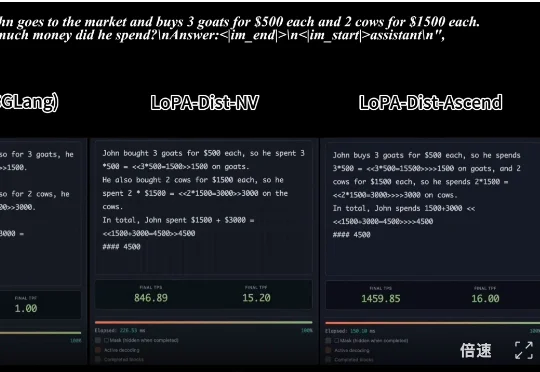

,时长 00:20 视频 1:单样例推理速度对比:SGLang 部署的 Qwen3-8B (NVIDIA) vs. LoPA-Dist 部署 (NVIDIA & Ascend)(注:NVIDIA 平台

Metronome成立于2019年的旧金山,专注于为AI与软件公司提供实时计费基础设施,解决从传统按Seat收费转向按用量、Token等复杂定价的工程难题。目前其融资总额达1.28亿美元,已服务OpenAI、NVIDIA、Databricks等头部企业,终端用户超1.5亿,成为AI时代“按价值收费”的关键基础设施。

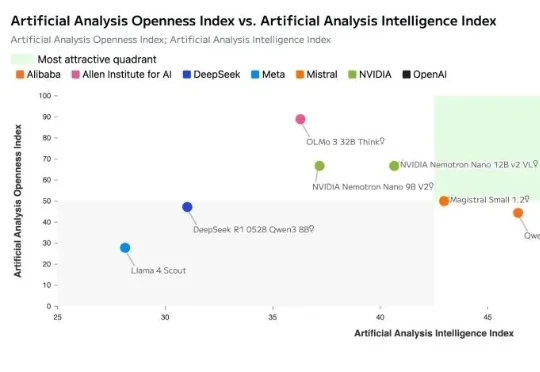

就在刚刚,英伟达正式开源发布了其新一代AI模型:NVIDIA Nemotron 3。Nemotron 3 系列由三种型号组成:Nano、Super 和 Ultra。官方介绍其具备强大的智能体、推理和对话能力。

软银、英伟达联手注资机器人独角兽Skild AI。 据报道,软银集团(SoftBank Group)与英伟达(Nvidia)正洽谈联合领投Skild AI一轮超10亿美元的融资。本轮融资后,Skild AI公司估值将达140亿美元。

据特朗普最新社交媒体消息透露,美国政府计划允许英伟达(Nvidia)对华出口其H200芯片,这是这家AI芯片设计公司为维持其在世界第二大经济体的市场准入所做努力的最新转折。该芯片的性能高于此前获准销售的H20,但不如该公司今年发布的顶级Blackwell产品,也不如明年将推出的Rubin系列芯片。

几个小时前,NVIDIA CUDA Toolkit 13.1 正式发布,英伟达官方表示:「这是 20 年来最大的一次更新。」CUDA Tile 是 NVIDIA CUDA Toolkit 13.1 最核心的更新。它是一种基于 tile 的编程模型,能够以更高的层次编写算法,并抽象化专用硬件(例如张量核心)的细节。

一年一度的英伟达奖学金出炉了。二十五年来,英伟达研究生奖学金计划(NVIDIA Graduate Fellowship Program)一直为研究生提供与英伟达技术相关的杰出工作支持。

2000 亿参数、3 万块人民币、128GB 内存,这台被称作「全球最小超算」的机器,真的能让我们在桌面上跑起大模型吗? 向左滑动查看更多内容,图片来自 x@nvidia 前段时间,黄仁勋正式把这台超