速递|月处理3000万条消息,Linq获2000万美元A轮融资,让AI助手藏进iMessage

速递|月处理3000万条消息,Linq获2000万美元A轮融资,让AI助手藏进iMessage有时,你或许正手握热门产品而不自知,直到市场需求显现。

有时,你或许正手握热门产品而不自知,直到市场需求显现。

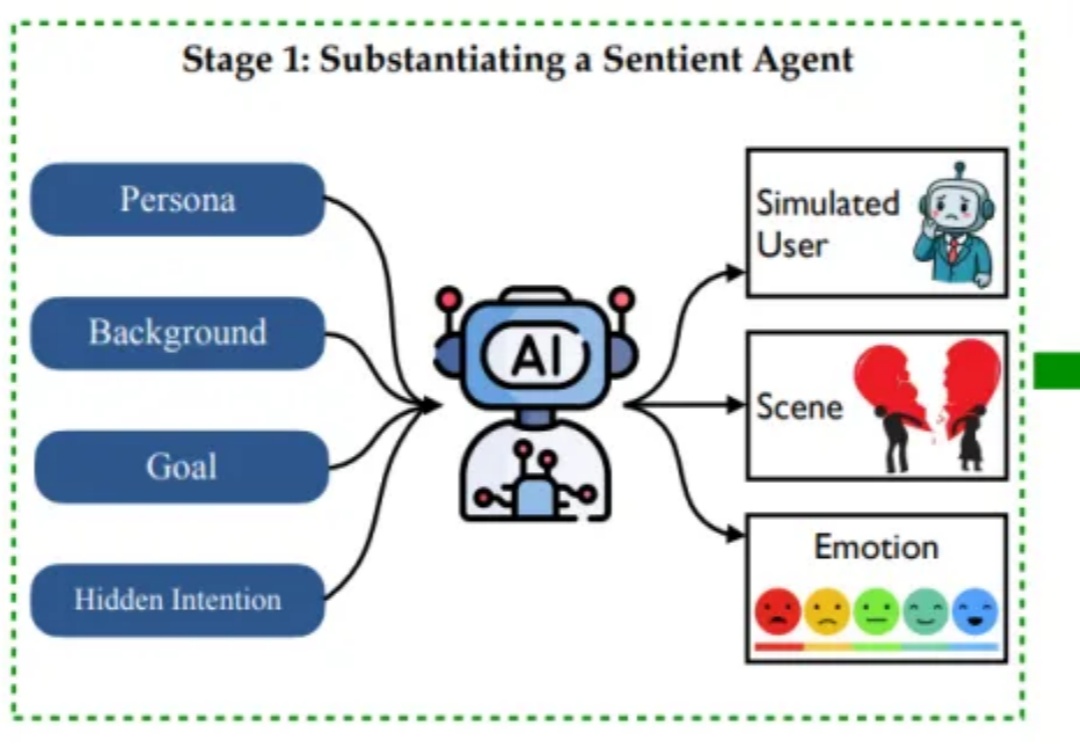

周伯文还详细介绍了上海 AI 实验室近年来开展的前沿探索与实践,包括驱动 “通专融合” 发展的技术架构 ——“智者”SAGE(Synergistic Architecture for Generalizable Experts),其包含基础、融合与进化三个层次,并可双向循环实现全栈进化;支撑 AGI4S 探索的两大基础设施“书生”科学多模态大模型 Intern-S1、“

硬氪获悉,具身智能机器人公司飒智智能近期连续完成A++轮及A+++轮融资,累计金额达数亿元。我们总结了最新两轮融资信息和该公司几大亮点:

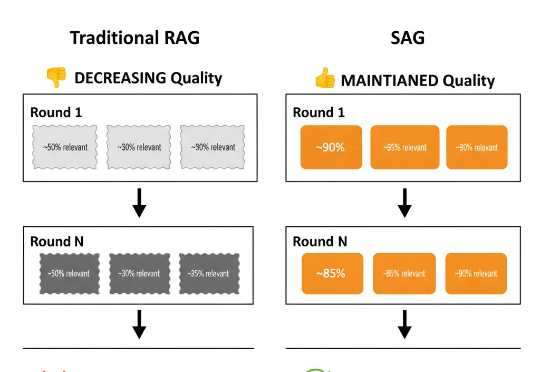

大家好,我是Jomy,是智跃Zleap的CEO,也是Zleap产品和技术的主要设计者。此前在报道中,我曾粗略介绍过Zleap产品背后的技术:一个能帮助CEO自动整理、总结海量企业内部信息的智能Agent。今天,我要正式为大家介绍驱动这个Agent的底层技术:SAG。

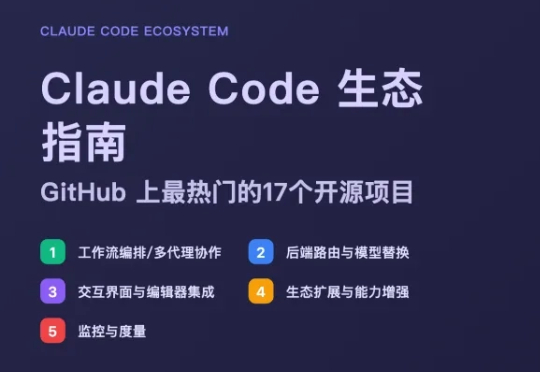

我最开始接触Claude Code——这种「代理式终端编程工具」的时候,说实话,很不习惯 于是我安装了很多第三方工具来让它变得更好用,例如安装ccusage查看用量、安装Claudia把它变回 IDE等等

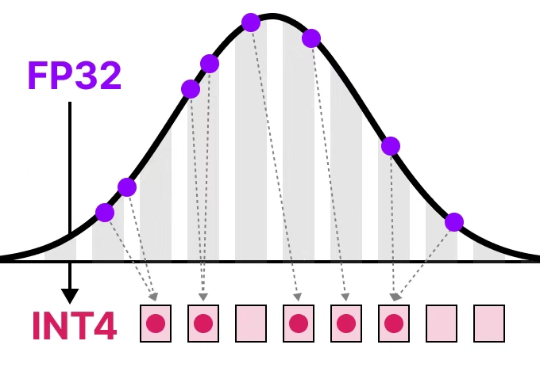

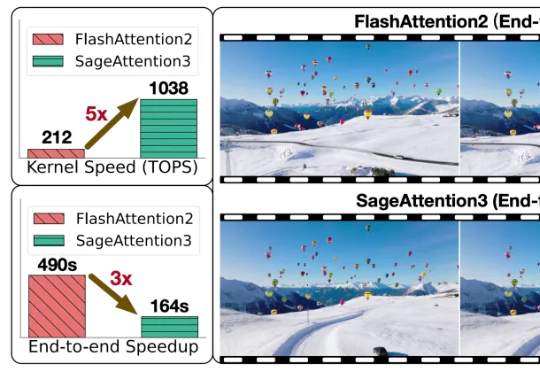

清华大学朱军教授团队提出SageAttention3,利用FP4量化实现推理加速,比FlashAttention快5倍,同时探索了8比特注意力用于训练任务的可行性,在微调中实现了无损性能。

2025年6月,AI 代码编辑器 Cursor 因定价模式调整引发广泛争议。原先的“按次计费”(per-request billing)改为基于 token 的“按量计费”(usage-based pricing),导致部分用户面临意外扣费,社区反馈强烈Cursor 于7月5日发布致歉声明,承诺退款并澄清新计费模式。

随着大型模型需要处理的序列长度不断增加,注意力运算(Attention)的时间开销逐渐成为主要开销。

判断AI是否智能,评价维度如今已不仅限于刷榜成绩。

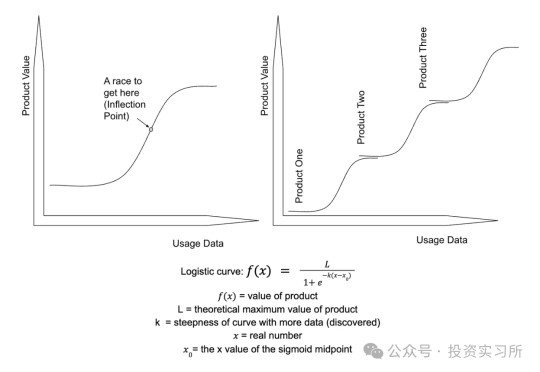

护城河是所有投资人和创始人都非常关注的一个概念,因为它涉及到企业的长期价值和生死存亡。AI 时代,大家对护城河同样有执念,但是越来越搞不懂什么才是这个时代的护城河了,甚至是否还有护城河都已经是一个问题。