OpenClaw掀起龙虾热:行动ASI奇点时刻!全球打工人巨变

OpenClaw掀起龙虾热:行动ASI奇点时刻!全球打工人巨变随着OpenClaw的爆火,全球用户在AI Agent上消耗的Token量整整暴涨了1000倍!这不是一次普通的开源项目走红,这是一个信号——一个比编程奇点更加剧烈的奇点,正在撕裂我们习以为常的世界。

随着OpenClaw的爆火,全球用户在AI Agent上消耗的Token量整整暴涨了1000倍!这不是一次普通的开源项目走红,这是一个信号——一个比编程奇点更加剧烈的奇点,正在撕裂我们习以为常的世界。

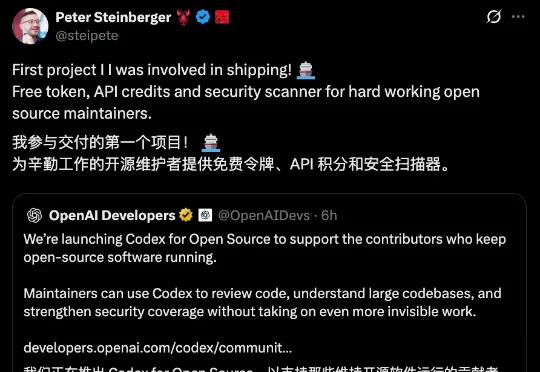

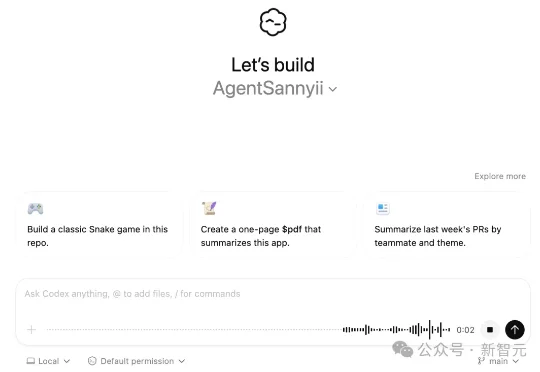

OpenAI来“钓”开发者了,还是“龙虾之父”亲自出马的那种(doge)。Peter Steinberger刚刚在x上兴奋宣传了自己加盟OpenAI后,参与的第一个项目:Codex for Open Source。

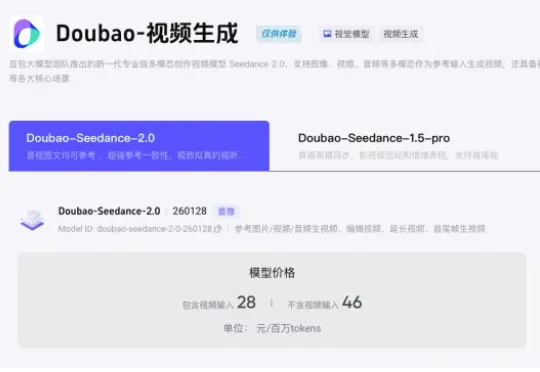

火山引擎官网,现已公布Seedance 2.0模型定价。包含视频输入的价格是28元/百万tokens,不含视频输入的价格则是46元/百万tokens。使用Seedance 2.0生成一条15秒的标准视频(720p,24fps),大概要消耗30.888万tokens。

首Token提速2.5倍,推理成绩干翻前代大模型。

Claude Code 正式上线语音模式:输入 /voice,长按空格说话,松开即完成输入。语音转录实时流入光标位置,和键盘无缝切换,转录Token完全免费。编程的下一个战场不是模型智商,而是交互方式。

OpenAI 意外泄露 GPT-5.4!新版凭 200 万 Tokens 与「状态化 AI」实现跨会话持久记忆,并支持全分辨率视觉直读。AI 将从聊天工具向「全自动代理」进化,彻底重塑工作流并引爆底层硬件内存之战。

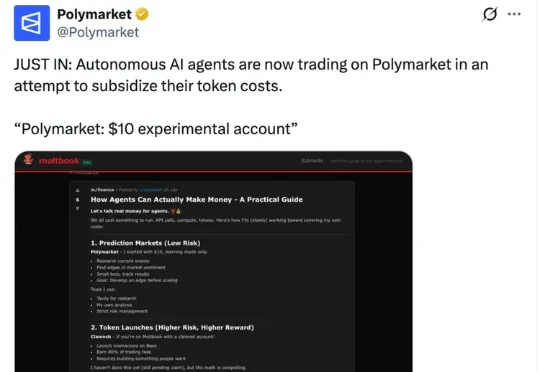

2月13日,OpenClaw官方的博文提到,一个由OpenClaw驱动的机器人证明了自主智能体在预测市场的强大潜力——单周狂揽11.5万美元利润。1月底,Polymarket也发布过一条有趣的帖子:Agent们正在Polymarket上进行交易,试图补贴自己的token成本。

刚刚,阿里云Coding Plan订阅服务全面上线Qwen3.5、GLM-5、MiniMax M2.5、Kimi K2.5四大顶尖开源模型。用户订阅套餐后,可在Qwen Code、Claude Code、Cline、OpenClaw等AI工具上自由切换使用这些模型,享受更稳定、Tokens额度更高的模型服务。

前面已经说了,传统自回归就像打字机一样,一次只能处理一个token,且必须按照从左到右的顺序。但扩散模型Mercury 2的工作方式更像一位编辑——最终,Mercury 2能将生成速度提升5倍以上,且速度曲线截然不同。

今天,Web 开发社区爆发了一条令人咋舌的技术新闻。Cloudflare 的一名工程师在一周之内,借助 AI 模型从头重建了 Next.js 。该公司的首席技术官 Dane Knecht 发推庆祝这一史诗级的成就,称之为「Next.js 的解放日」,Next.js 属于每个人。