Transformer八周年!Attention Is All You Need被引破18万封神

Transformer八周年!Attention Is All You Need被引破18万封神Transformer已满8岁,革命性论文《Attention Is All You Need》被引超18万次,掀起生成式AI革命。Transformer催生了ChatGPT、Gemini、Claude等诸多前沿产品。更重要的是,它让人类真正跨入了生成式AI时代。

Transformer已满8岁,革命性论文《Attention Is All You Need》被引超18万次,掀起生成式AI革命。Transformer催生了ChatGPT、Gemini、Claude等诸多前沿产品。更重要的是,它让人类真正跨入了生成式AI时代。

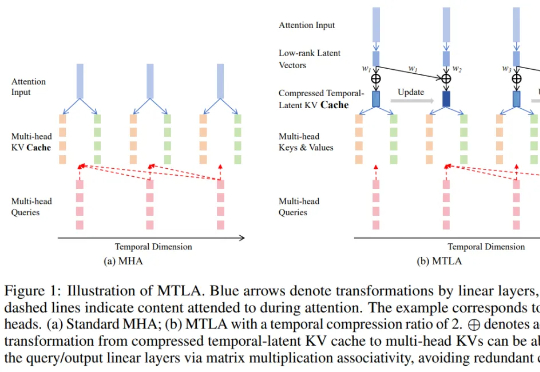

在大语言模型蓬勃发展的背景下,Transformer 架构依然是不可替代的核心组件。尽管其自注意力机制存在计算复杂度为二次方的问题,成为众多研究试图突破的重点

RNN太老,Transformer太慢?谷歌掀翻Transformer王座,用「注意力偏向+保留门」取代传统遗忘机制,重新定义了AI架构设计。全新模型Moneta、Yaad、Memora,在多个任务上全面超越Transformer。这一次,谷歌不是调参,而是换脑!

编程智能体也有「进化论」!Transformer作者初创Sakana AI与UBC推出达尔文-哥德尔机(DGM),能自动改写自身代码,性能翻倍超越人工设计。还能跨语言迁移、发明新工具。AI要觉醒了?

随着大语言模型 (LLM) 的出现,扩展 Transformer 架构已被视为彻底改变现有 AI 格局并在众多不同任务中取得最佳性能的有利途径。因此,无论是在工业界还是学术界,探索如何扩展 Transformer 模型日益成为一种趋势。

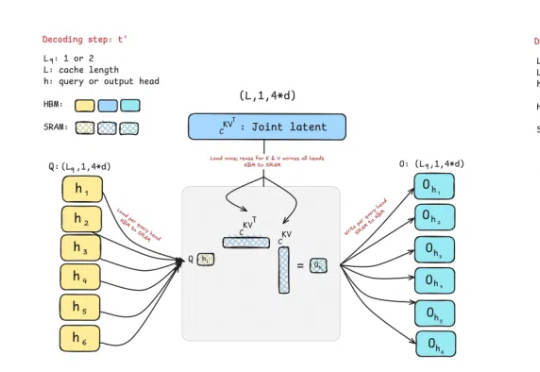

曾撼动Transformer统治地位的Mamba作者之一Tri Dao,刚刚带来新作——提出两种专为推理“量身定制”的注意力机制。

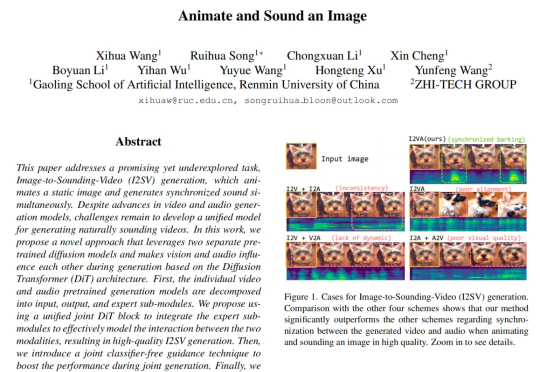

来自中国人民大学高瓴人工智能学院与值得买科技 AI 团队在 CVPR 2025 会议上发表了一项新工作,首次提出了一种从静态图像直接生成同步音视频内容的生成框架。其核心设计 JointDiT(Joint Diffusion Transformer)框架实现了图像 → 动态视频 + 声音的高质量联合生成。

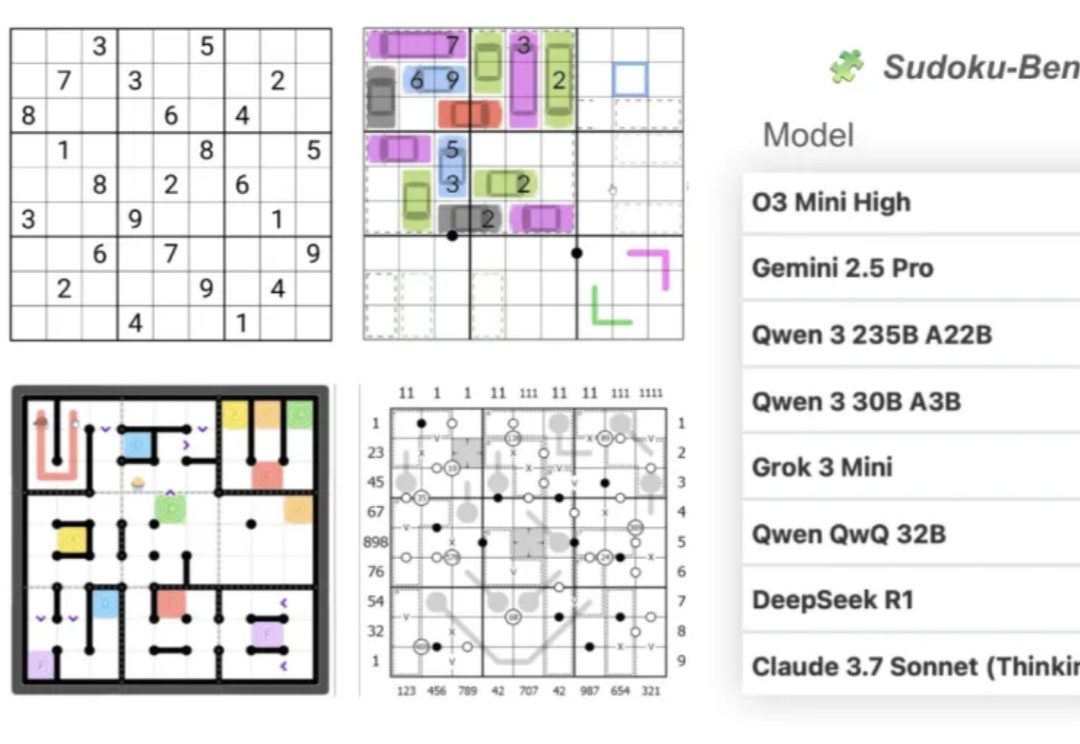

大模型做数独,总体正确率只有15%???

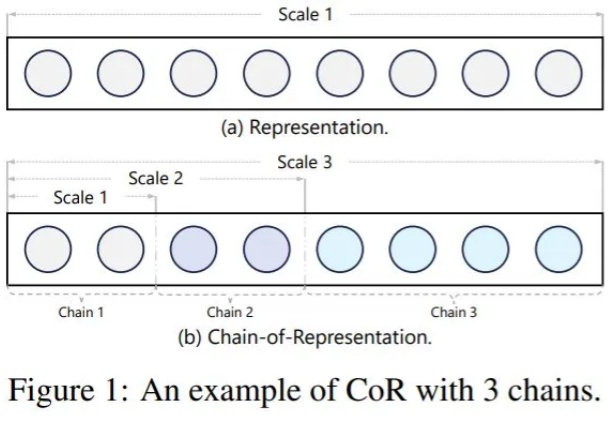

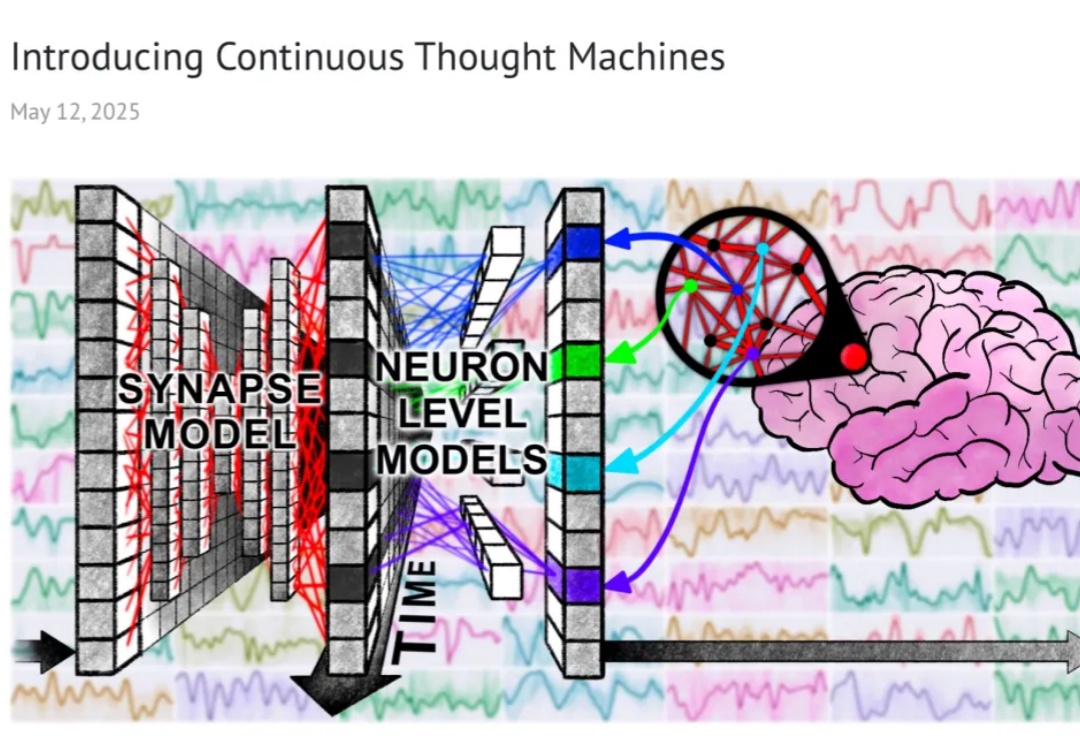

开启「分步思考」新范式。

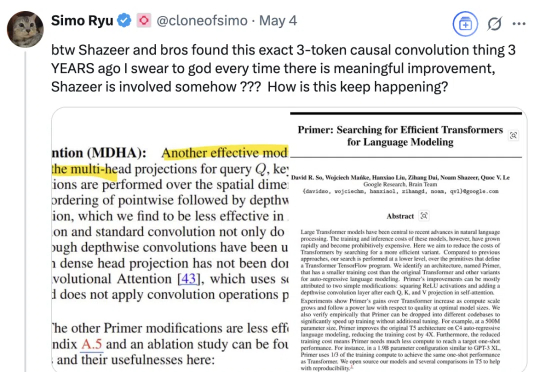

怎么老是你???(How old are you)尤其是最近Meta FAIR研究员朱泽园分享了他们《Physics of Language Models》项目的系列新进展后,有网友发现,其中提到的3-token因果卷积相关内容,沙哥等又早在三年前就有相关研究。这是最近网友不断对着Transformer八子之一的Noam Shazeer(为方便阅读,我们称他为沙哥)发出的灵魂疑问。