被Transformer光芒掩盖的论文,Meta科学家回顾十年前创新之作

被Transformer光芒掩盖的论文,Meta科学家回顾十年前创新之作这篇论文包含了当前 LLM 的许多要素,十年后的今天或许仍值得一读。

这篇论文包含了当前 LLM 的许多要素,十年后的今天或许仍值得一读。

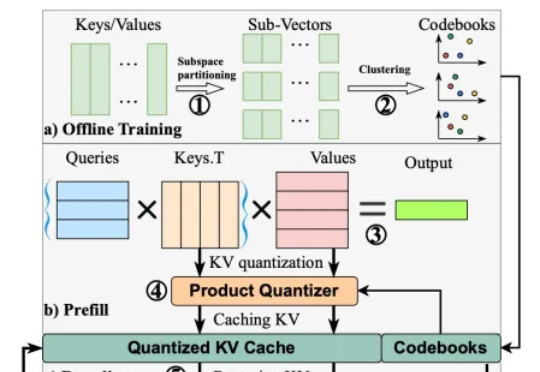

在以 transformer 模型为基础的大模型中,键值缓存虽然用以存代算的思想显著加速了推理速度,但在长上下文场景中成为了存储瓶颈。为此,本文的研究者提出了 MILLION,一种基于乘积量化的键值缓存压缩和推理加速设计。

最近,DeepSeek-R1 和 OpenAI o1/03 等推理大模型在后训练阶段探索了长度扩展(length scaling),通过强化学习(比如 PPO、GPRO)训练模型生成很长的推理链(CoT),并在奥数等高难度推理任务上取得了显著的效果提升。

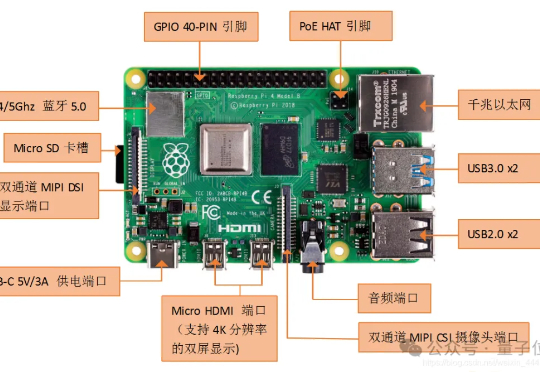

他们打造的端侧大模型已经可以在树莓派这样的微型设备上流畅运行,首批搭载Yan架构大模型的具身智能机器人也已经面世。当下AI算力竞赛愈演愈烈之际,他们的“低算力”“群体智能”之路正在获得更多关注。本期「大模型创新架构」主题访谈,量子位邀请到RockAI CEO刘凡平,聊聊他们选择非Transformer架构路线背后的故事,以及通过架构及算法创新实现AGI的技术愿景。

在斯坦福,有一门专门讲 Transformer 的课程,名叫 CS 25。

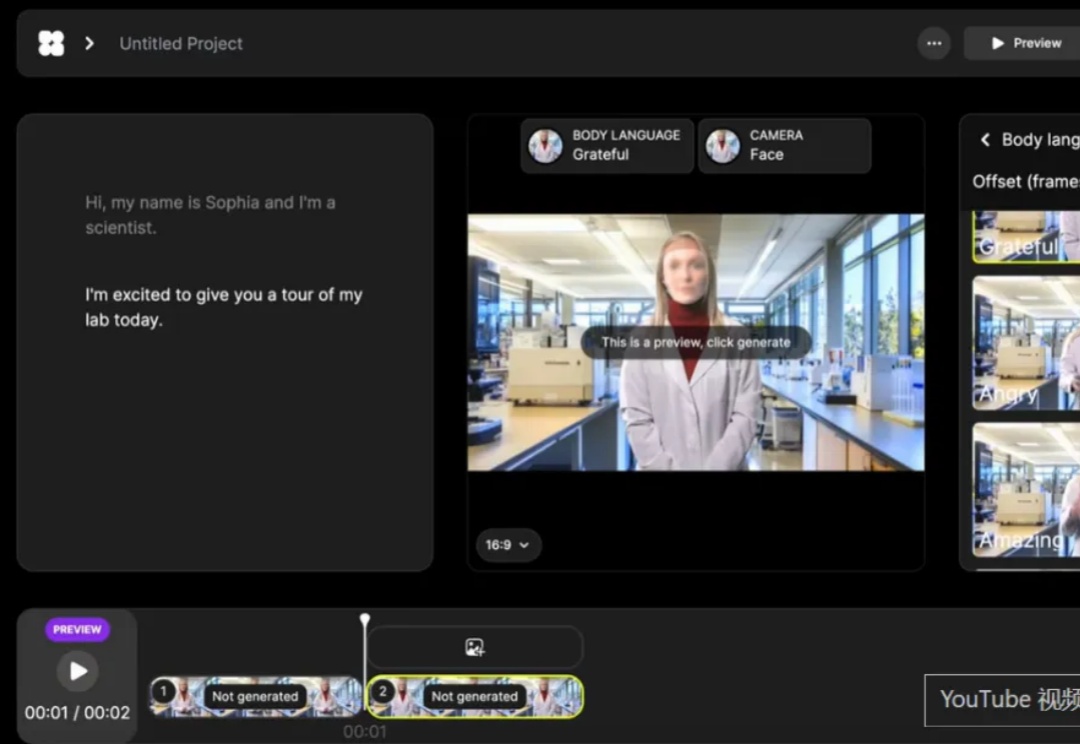

AI虚拟人模型架构从CNN、GANs演进至Transformer+扩散模型,实现从单一面部驱动到半身/全身动态生成的跨越,口型同步与多模态协同表现显著提升。

Transformer作者Ashish Vaswani团队重磅LLM研究!简单指令:「Wait,」就能有效激发LLM显式反思,表现堪比直接告知模型存在错误。

视频生成领域,又出现一位重量级开源选手。

还在用搜索和规则训练AI游戏?现在直接「看回放」学打宝可梦了!德州大学奥斯汀分校的研究团队用Transformer和离线强化学习打造出一个智能体,不靠规则、没用启发式算法,纯靠47.5万场人类对战回放训练出来,居然打上了Pokémon Showdown全球前10%!

Nemotron-H模型混合了Transformer和Mamba架构,使长文本推理速度提升3倍,同时还能保持高性能,开源版本包括8B和56B尺寸。训练过程采用FP8训练和压缩技术,进一步提高了20%推理速度