这个春节P图不求人!小红书开源图像编辑新SOTA

这个春节P图不求人!小红书开源图像编辑新SOTAAI生图领域,又出了个“狠角色”。

AI生图领域,又出了个“狠角色”。

这个国产开源模型,把多模态玩出了“魔法”感。

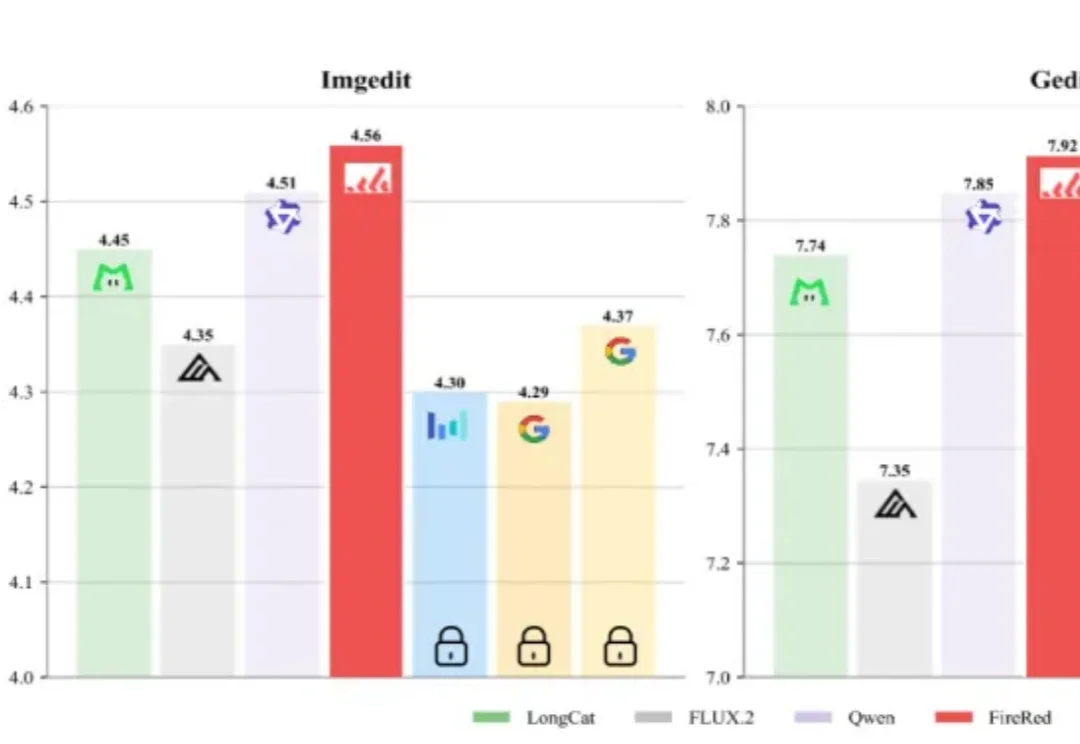

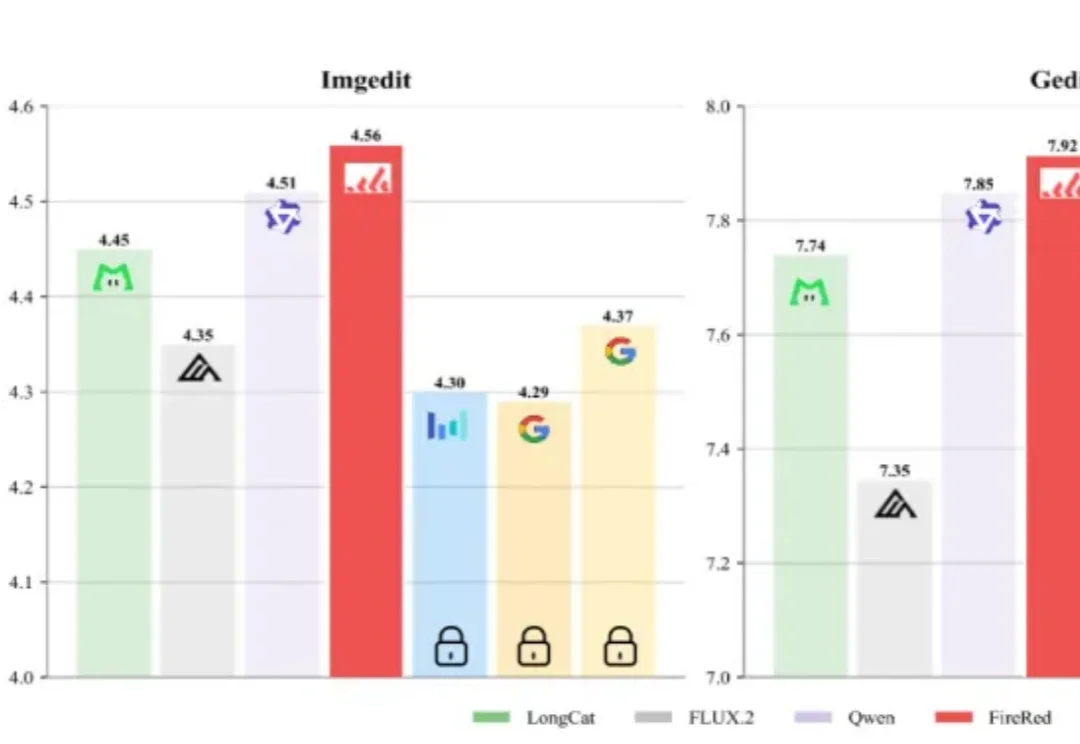

今日,美团正式发布并开源图像生成模型LongCat-Image,这是一款在图像编辑能力上达到开源SOTA水准的6B参数模型,重点瞄准文生图与单图编辑两大核心场景。在实际体验中,它在连续改图、风格变化和材质细节上表现较好,但在复杂排版场景下,中文文字渲染仍存在不稳定的情况。

现在,终于也有国产 AI 接力,进一步把这条路跑通。Vidu Q2 最新上线的文生图、参考生图、图像编辑功能就是这个路子:卷完「好看」,它开始死磕「稳定性」。这次 Vidu Q2 直接把技能点全加在了「一致性」上。什么概念?就是把「人设崩坏」、「产品变形」、「画风突变」这些老大难问题统统按在地上摩擦。

2025 年,AIGC 热度再冲新高:从社交头像、电商海报到影视分镜,AI 生成内容已全面渗透日常创作。在这股浪潮中,Nano Banana、Qwen Edit 等通用图像编辑大模型功能强大,涵盖了广泛的图像编辑场景。特别是最新爆火的 Nano Banana Pro 能将文字指令转化为高精度图像,精准呈现复杂场景。但是上述图像编辑大模型在一些细分领域的表现仍有不足,并且用于简单任务性价比不高。

比Nano Banana更擅长P细节的图像编辑模型来了,还是更懂中文的那种。

在开放研究领域里,苹果似乎一整个脱胎换骨,在纯粹的研究中经常会有一些出彩的工作。这次苹果发布的研究成果的确出人意料:他们用谷歌的 Nano-banana 模型做个了视觉编辑领域的 ImageNet。

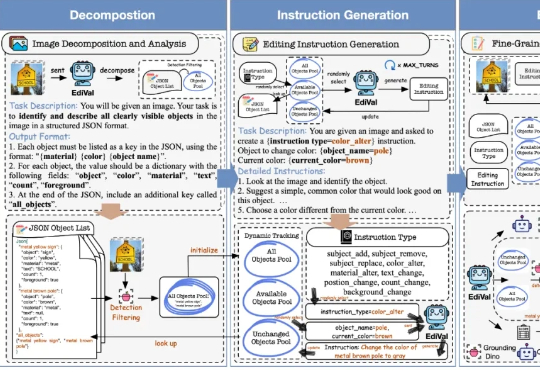

在 AIGC 的下一个阶段,图像编辑(Image Editing)正逐渐取代一次性生成,成为检验多模态模型理解、生成与推理能力的关键场景。我们该如何科学、公正地评测这些图像编辑模型?

随着多模态大模型的不断演进,指令引导的图像编辑(Instruction-guided Image Editing)技术取得了显著进展。然而,现有模型在遵循复杂、精细的文本指令方面仍面临巨大挑战,往往需要用户进行多次尝试和手动筛选,难以实现稳定、高质量的「一步到位」式编辑。

Reve AI 是一家 2023 年 12 月才建立的加州 AI 初创公司,他们在 2025 年 3 月推出了第一个生图模型叫 Reve Image 1.0,内部代号是「Halfmoon」。6 个月过后,再次升级该模型为「图像编辑模型」。