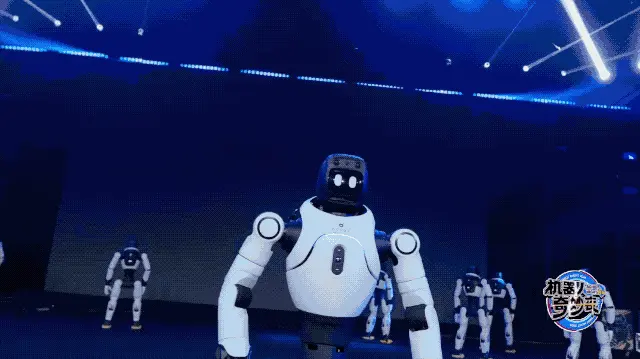

刚刚,全球首届机器人「春晚」炸场!稚晖君带队,节目效果拉满,连观众都是机器人

刚刚,全球首届机器人「春晚」炸场!稚晖君带队,节目效果拉满,连观众都是机器人就在刚刚,智元机器人举办了全球首个机器人晚会《机器人奇妙夜》。200 多台机器人在台上唱歌、跳舞、打太极,甚至还演小品、变魔术。讲真,春晚年年看,但含人量几乎为 0 的机器人专场,这还真是人类历史上头一遭。

就在刚刚,智元机器人举办了全球首个机器人晚会《机器人奇妙夜》。200 多台机器人在台上唱歌、跳舞、打太极,甚至还演小品、变魔术。讲真,春晚年年看,但含人量几乎为 0 的机器人专场,这还真是人类历史上头一遭。

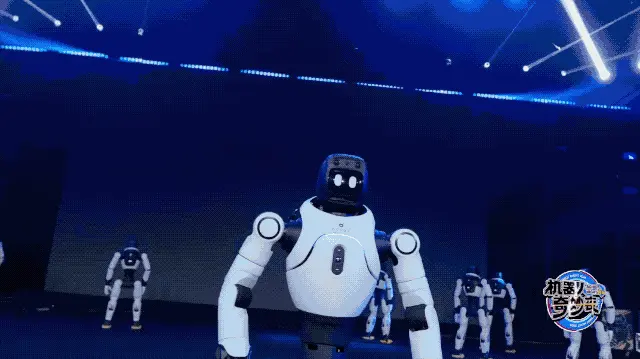

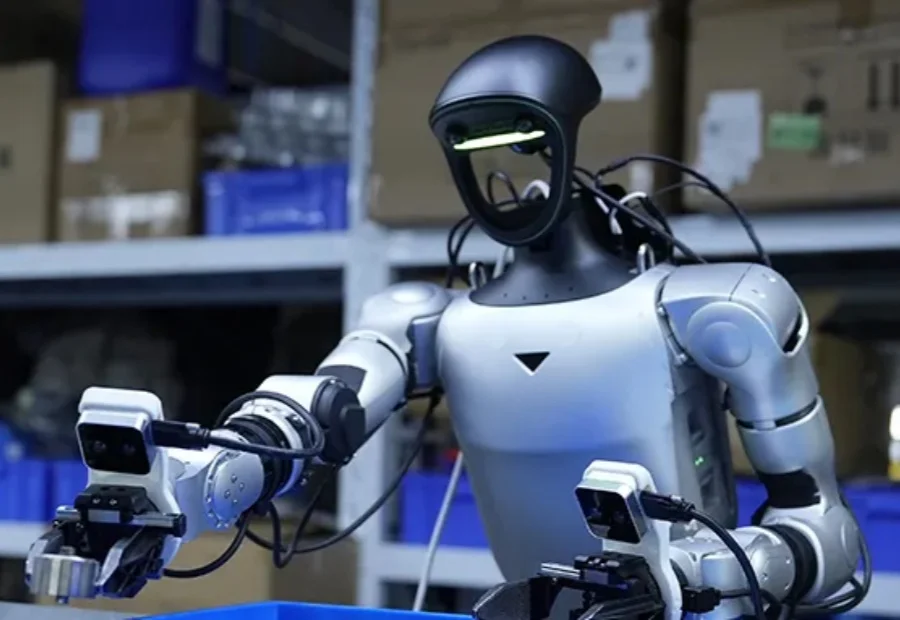

目前,人形机器人已经能在现实中跳舞、奔跑、甚至完成后空翻。但接下来更关键的问题是:这些系统能否在部署之后持续地进行强化学习 —— 在真实世界的反馈中变得更稳定、更可靠,并在分布不断变化的新环境里持续适应与改进?

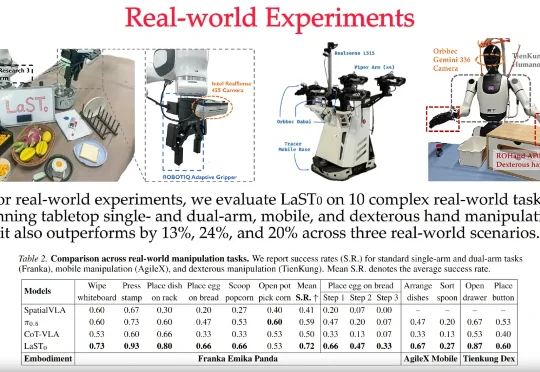

LaST₀团队 投稿 量子位 | 公众号 QbitAI 近日,至简动力、北京大学、香港中文大学、北京人形机器人创新中心提出了一种名为LaST₀的全新隐空间推理VLA模型,在基于Transformer混

全球第一届OpenClaw蟹教聚会来了,开发者们众神云集,分享出一大波炸裂的开源项目。更可怕的是,OpenClaw开始控制机器人了,现场的啤酒据说都是机器人续的。「蟹徒」们纷纷高呼:感谢Peter,你让我们重生!

硬氪独家获悉,人形机器人公司逐际动力LimX Dynamics已完成2亿美元的B轮融资。

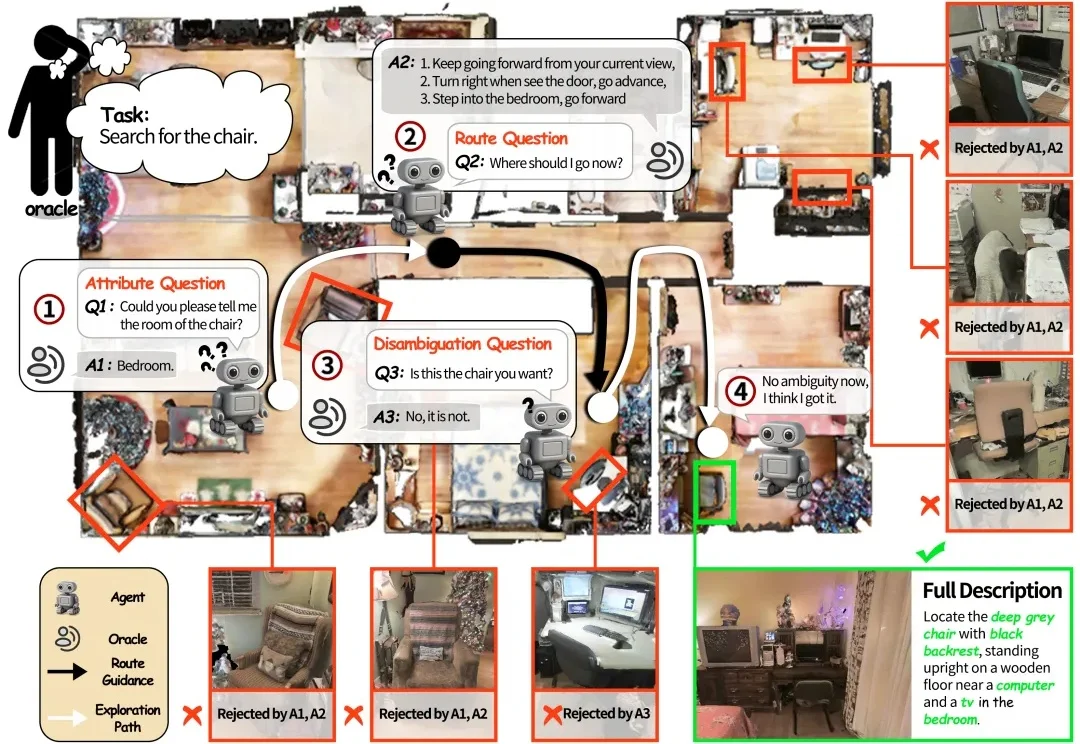

如果将一台在视觉语言导航(VLN)任务中表现优异的机器人直接搬进家庭场景,往往会遇到不少实际问题。

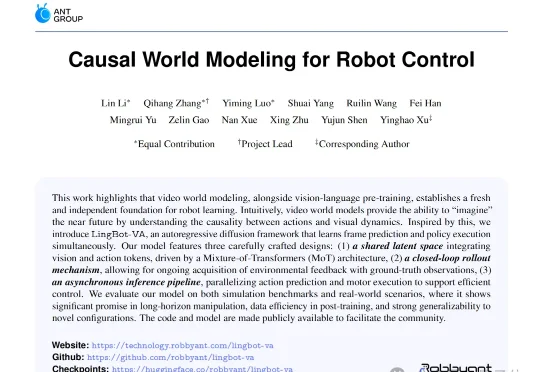

是蚂蚁灵波又又又又(连续第4天)开源的狠活儿——全球首个用于通用机器人控制的因果视频-动作世界模型,LingBot-VA。但LingBot-VA就不一样了,它通过自回归视频预测打破了这种思考方式,在动手之前,脑子里先把未来几秒的画面推演出来。

机器人领域是我们长期关注的赛道,而 Generalist 是当前机器人领域中极少数具备长期竞争潜力的公司,核心优势集中在数据规模、团队能力与清晰的 scaling 路径上。

5500台销量背后:揭开宇树人形机器人“真实买家”画像。

Figure 发布 Helix 02,机器人领域又要变天了