AI推理基础设施公司Baseten完成 3 亿美元融资,英伟达、Alphabet联手下注

AI推理基础设施公司Baseten完成 3 亿美元融资,英伟达、Alphabet联手下注AI 推理基础设施公司 Baseten 近日完成一轮 3 亿美元的成长型融资,投后估值约 50 亿美元。与不到六个月前的一轮重要融资相比,公司估值几乎翻倍。 这一交易清晰地表明,在大模型训练之外,推理

AI 推理基础设施公司 Baseten 近日完成一轮 3 亿美元的成长型融资,投后估值约 50 亿美元。与不到六个月前的一轮重要融资相比,公司估值几乎翻倍。 这一交易清晰地表明,在大模型训练之外,推理

编辑|Panda 在文生图模型的技术版图中,VAE 几乎已经成为共识。从 Stable Diffusion 到 FLUX,再到一系列扩散 Transformer,主流路线高度一致:先用 VAE 压缩视

这篇新论文提出了一种非常简单的新激活层 Derf(Dynamic erf),让「无归一化(Normalization-Free)」的 Transformer 不仅能稳定训练,还在多个设置下性能超过了带 LayerNorm 的标准 Transformer。

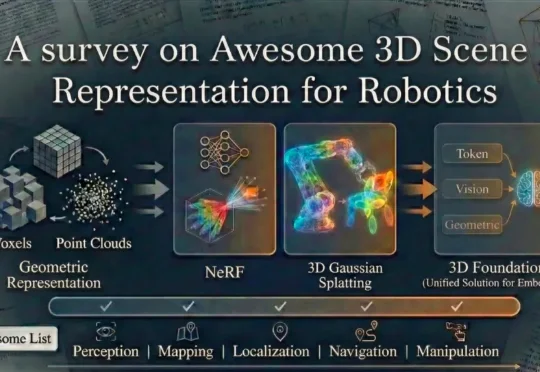

上海交通大学、波恩大学等院校的研究团队全面总结了当前机器人技术中常用的场景表示方法。这些方法包括传统的点云、体素栅格、符号距离函数以及场景图等传统几何表示方式,同时也涵盖了最新的神经网络表示技术,如神经辐射场、3D 高斯散布模型以及新兴的 3D 基础模型。

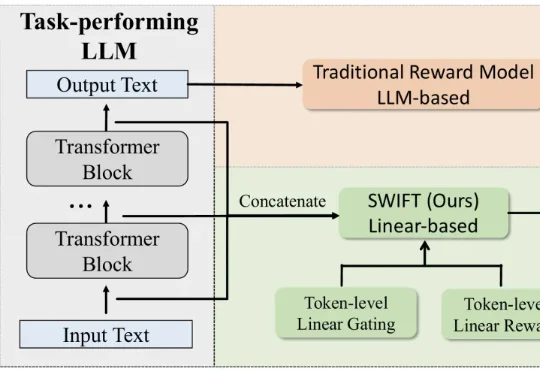

最新奖励模型SWIFT直接利用模型生成过程中的隐藏状态,参数规模极小,仅占传统模型的不到0.005%。SWIFT在多个基准测试中表现优异,推理速度提升1.7×–6.7×,且在对齐评估中稳定可靠,展现出高效、通用的奖励建模新范式。

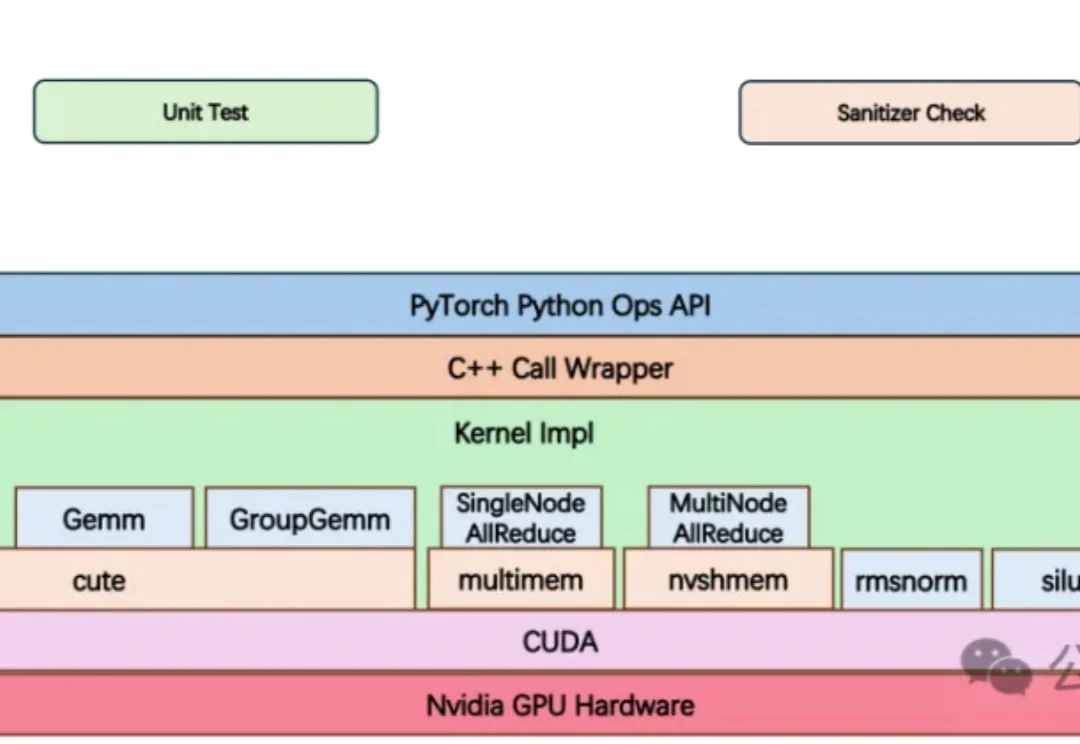

大模型竞赛中,算力不再只是堆显卡,更是抢效率。

GEM框架利用认知科学原理,从少量人类偏好中提取多维认知评估,让AI在极少标注下精准理解人类思维,提高了数据效率,在医疗等专业领域表现优异,为AI与人类偏好对齐提供新思路。

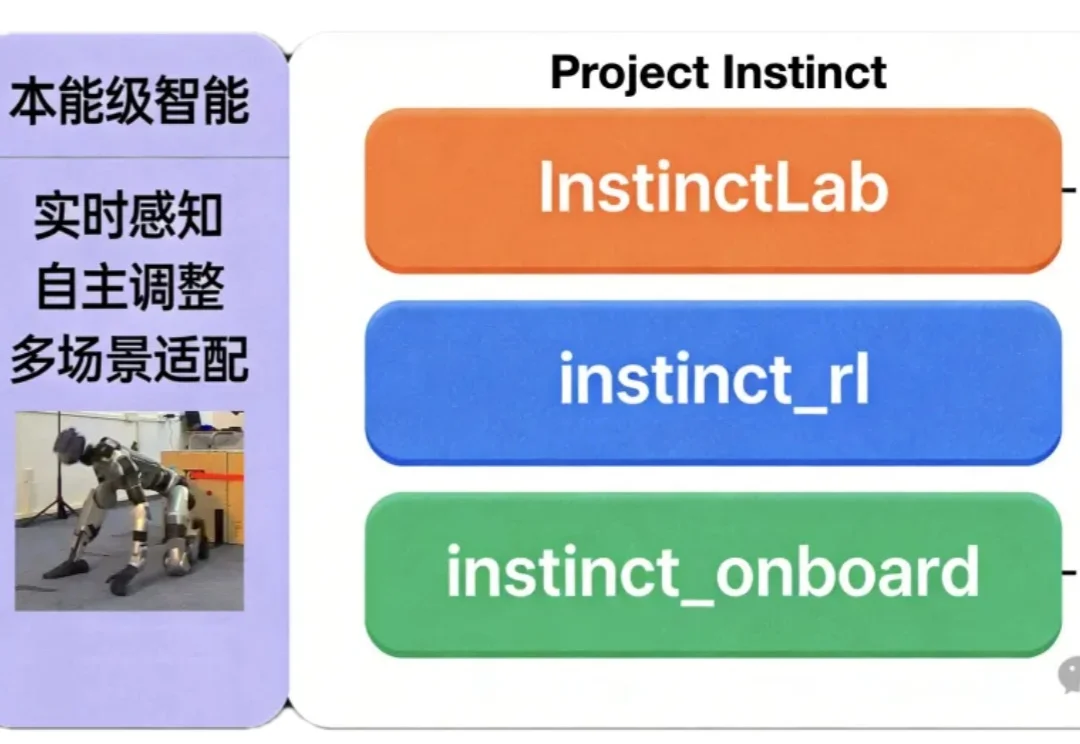

如何让机器人同时具备“本能反应”与复杂运动能力?

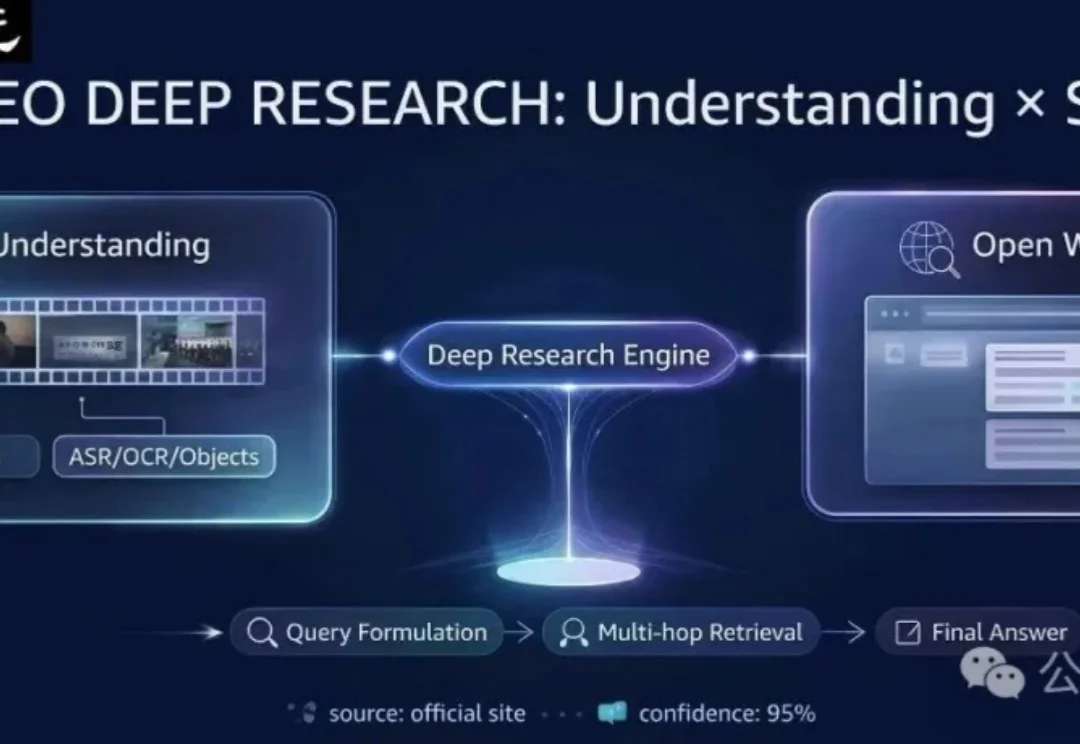

现有的多模态模型往往被困在「视频」的孤岛里——它们只能回答视频内的问题。但在真实世界中,人类解决问题往往是「看视频找线索 -> 上网搜证 -> 综合推理」。

竟然只需要一次Ctrl+V?这可能是深度学习领域为数不多的“免费午餐”。