AI数据服务公司「整数智能」完成数千万元A轮融资,业务拓展至全球范围

AI数据服务公司「整数智能」完成数千万元A轮融资,业务拓展至全球范围高质量数据对于提升AI模型的准确性和泛化能力至关重要。

高质量数据对于提升AI模型的准确性和泛化能力至关重要。

UrbanGPT是一种创新的时空大型语言模型,它通过结合时空依赖编码器和指令微调技术,展现出在多种城市任务中卓越的泛化能力和预测精度。这项技术突破了传统模型对大量标记数据的依赖,即使在数据稀缺的情况下也能提供准确的预测,为城市管理和规划提供了强大的支持。

华南理工大学和香港大学的研究人员在ICML 2024上提出了一个简单而通用的时空提示调整框架FlashST,通过轻量级的时空提示网络和分布映射机制,使预训练模型能够适应不同的下游数据集特征,显著提高了模型在多种交通预测场景中的泛化能力。

通过提示查询生成模块和任务感知适配器,大一统框架VimTS在不同任务间实现更好的协同作用,显著提升了模型的泛化能力。该方法在多个跨域基准测试中表现优异,尤其在视频级跨域自适应方面,仅使用图像数据就实现了比现有端到端视频识别方法更高的性能。

第一个以「泛化」能力为核心设计原则的可学习图像匹配器来了!

近日,又一惊人结论登上Hacker News热榜:没有指数级数据,就没有Zero-shot!多模态模型被扒实际上没有什么泛化能力,生成式AI的未来面临严峻挑战。

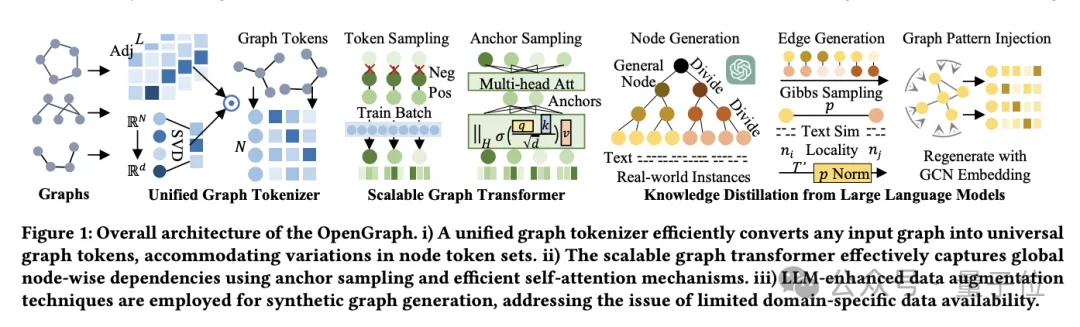

图学习领域的数据饥荒问题,又有能缓解的新花活了!

第一个针对「Segment Anything」大模型的域适应策略来了!相关论文已被CVPR 2024 接收。

近年来,LLM 已经一统所有文本任务,展现了基础模型的强大潜力。一些视觉基础模型如 CLIP 在多模态理解任务上同样展现出了强大的泛化能力,其统一的视觉语言空间带动了一系列多模态理解、生成、开放词表等任务的发展。然而针对更细粒度的目标级别的感知任务,目前依然缺乏一个强大的基础模型。

深度学习模型因其能够从大量数据中学习潜在关系的能力而「彻底改变了科学研究领域」。然而,纯粹依赖数据驱动的模型逐渐暴露出其局限性,如过度依赖数据、泛化能力受限以及与物理现实的一致性问题。