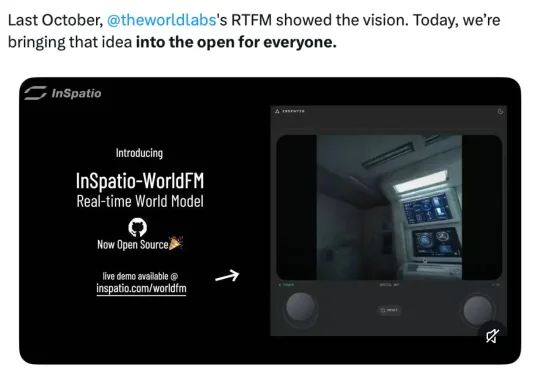

李飞飞50亿美金赛道被开源!浙大教授章国锋带队创业,打造无限时长实时3D世界模型

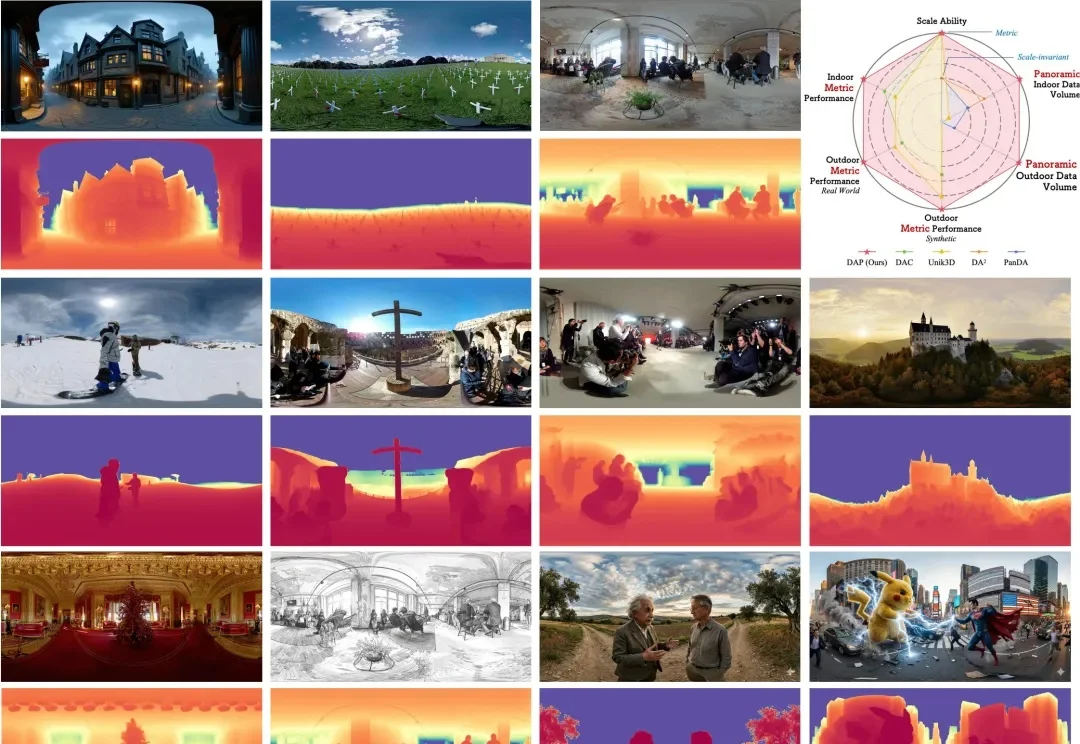

李飞飞50亿美金赛道被开源!浙大教授章国锋带队创业,打造无限时长实时3D世界模型在 50 亿美元估值神话的背后,这一空间智能的最新高地正被国内创业公司攻克并推向产业纵深。近日,影溯(InSpatio)正式发布并开源了其实时帧生成模型 InSpatio-WorldFM,一个实时交互的 3D 世界模型。这标志着中国团队在空间智能底层技术上取得了奠基性突破,而且以开放的姿态,正成为推动 AI 从虚拟屏幕走向物理现实的关键破局者。