无情戳穿“长上下文”大模型的虚标现象——

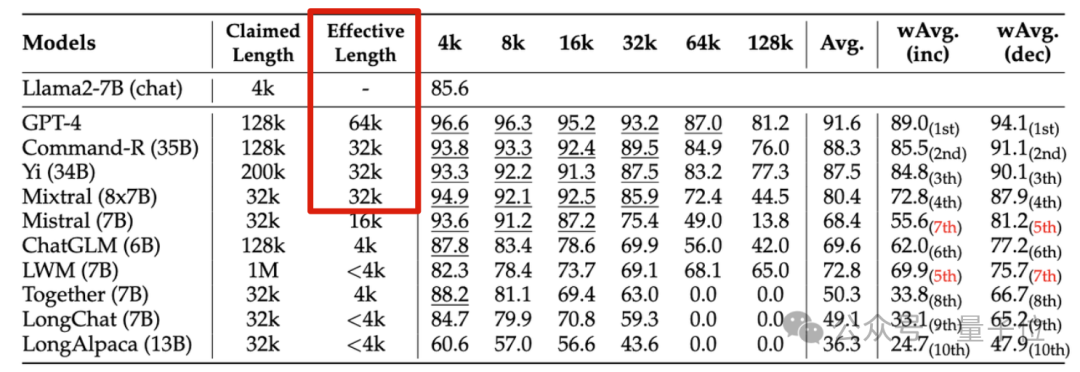

英伟达新研究发现,包括GPT-4在内的10个大模型,生成达到128k甚至1M上下文长度的都有。

但一番考验下来,在新指标“有效上下文”上缩水严重,能达到32K的都不多。

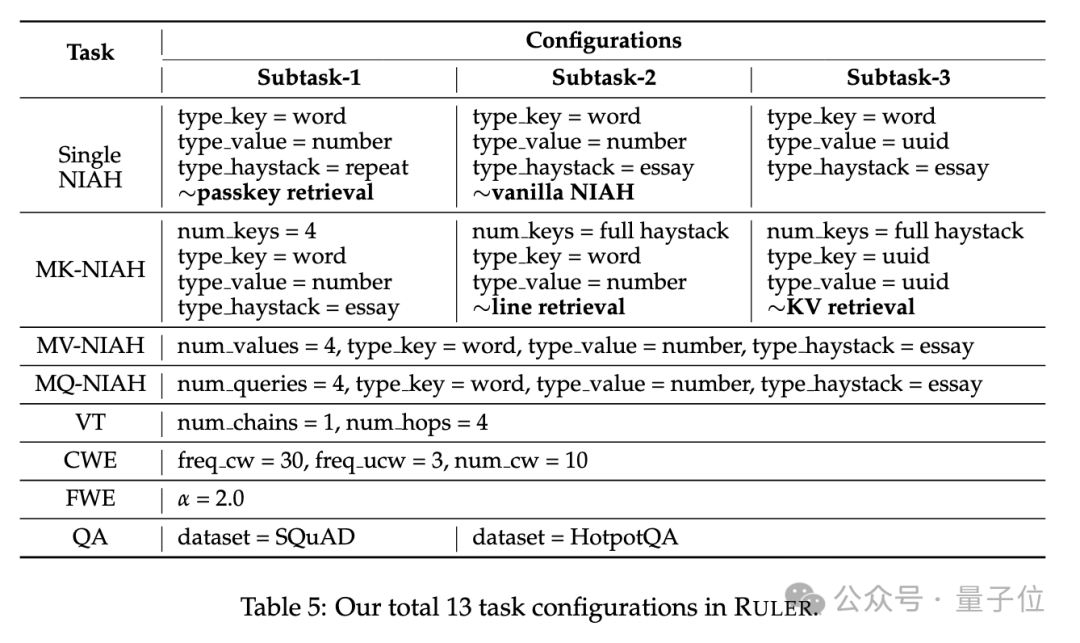

新基准名为RULER,包含检索、多跳追踪、聚合、问答四大类共13项任务。RULER定义了“有效上下文长度”,即模型能保持与Llama-7B基线在4K长度下同等性能的最大长度。

这项研究被学者评价为“非常有洞察力”。

不少网友看到这项新研究后,也非常想看到上下文长度王者玩家Claude和Gemini的挑战结果。(论文中并未覆盖)

一起来看英伟达是如何定义“有效上下文”指标的。

要评测大模型的长文本理解能力,得先选个好标准,现圈内流行的ZeroSCROLLS、L-Eval、LongBench、InfiniteBench等,要么仅评估了模型检索能力,要么受限于先验知识的干扰。

所以英伟达提出了RULER方法,一句话概括就是“确保评估侧重于模型处理和理解长上下文的能力,而不是从训练数据中回忆信息的能力”。

RULER的评测数据减少了对“参数化知识”的依赖,也就是大模型在训练过程中已经编码到自身参数里的知识。

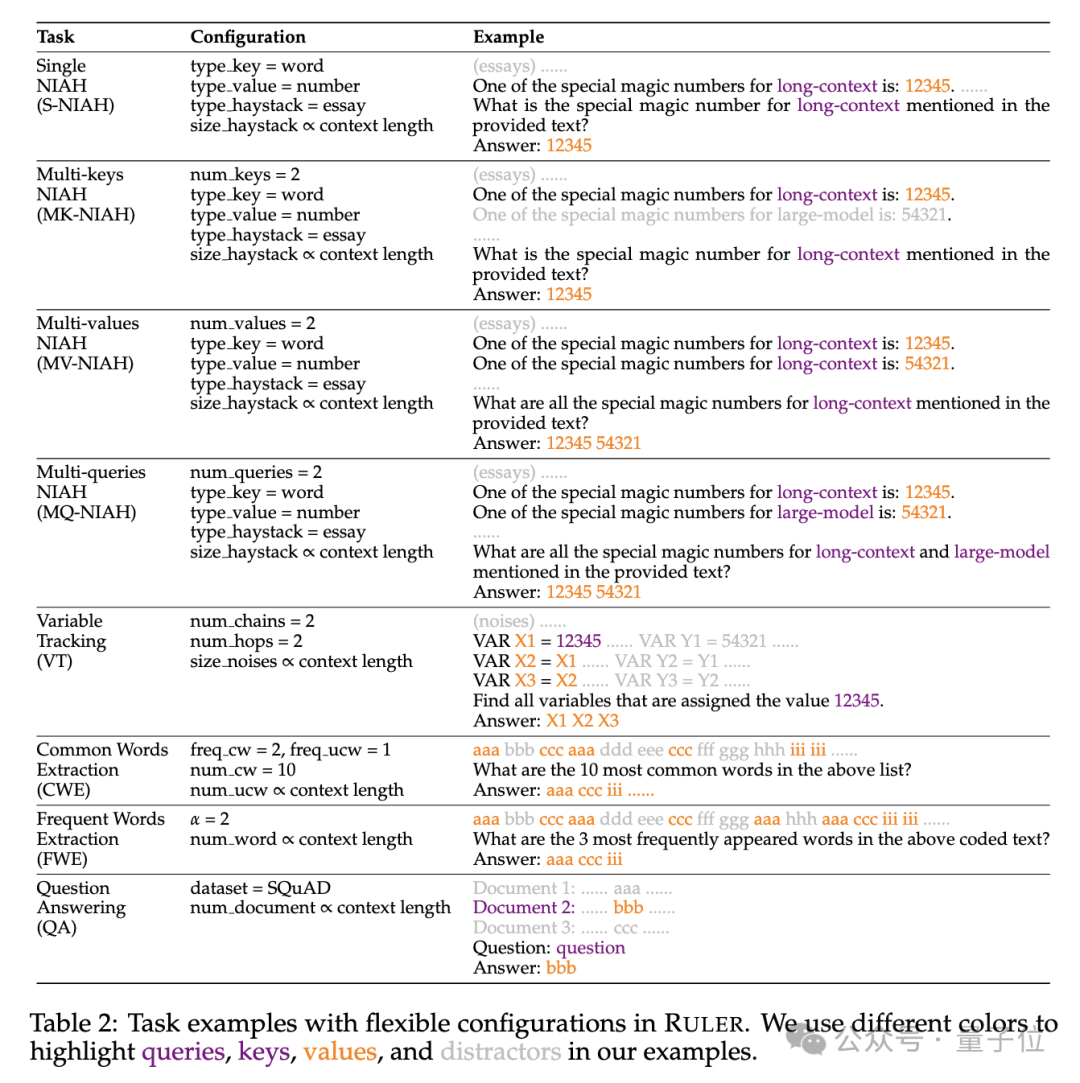

具体来说,RULER基准扩展了流行的“大海捞针”测试,新增四大类任务。

检索方面,从大海捞针标准的单针检索任务出发,又加入了如下新类型:

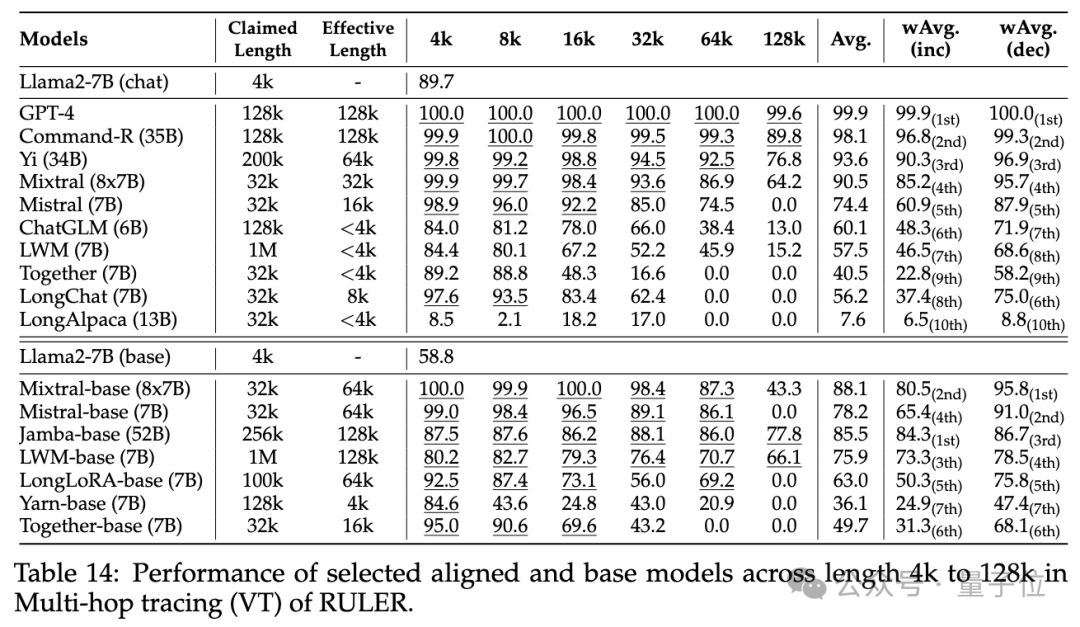

除了升级版检索,RULER还增加了多跳追踪(Multi-hop Tracing)挑战。

具体来说,研究人员提出了变量追踪(VT),模拟了指代消解(coreference resolution)的最小任务,要求模型追踪文本中变量的赋值链,即使这些赋值在文本中是非连续的。

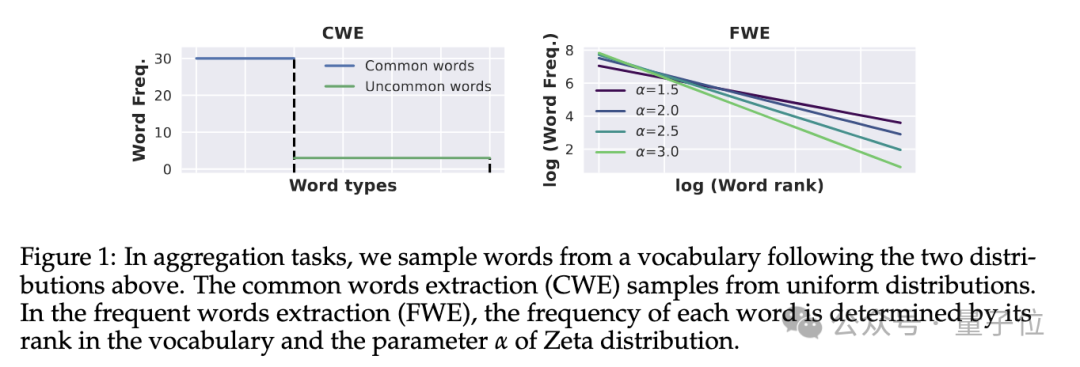

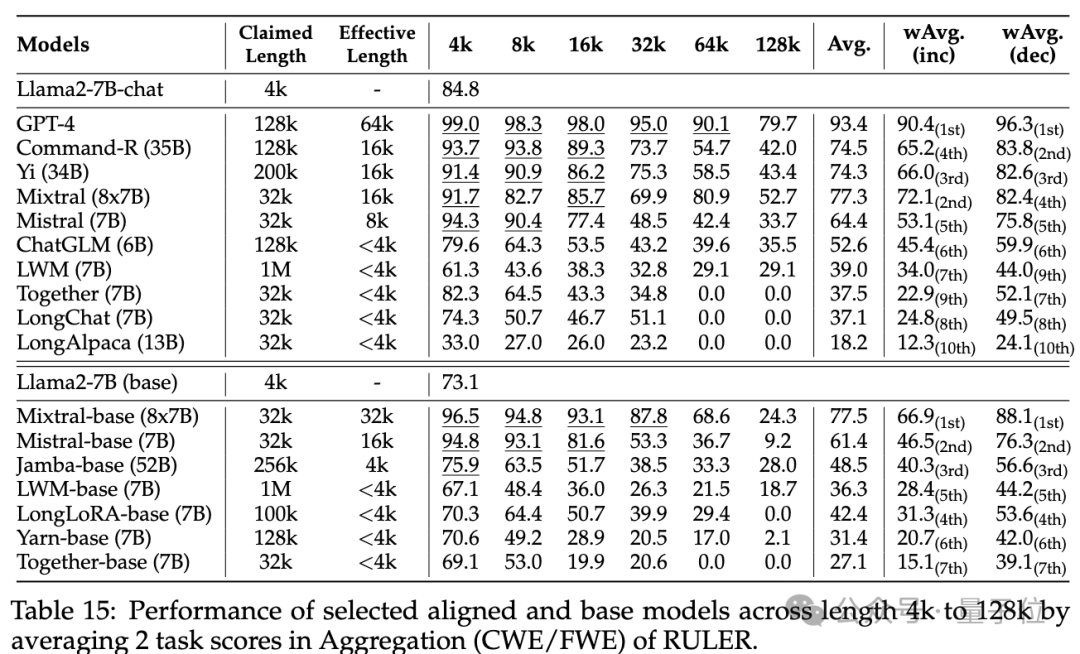

挑战第三关是聚合(Aggregation),包括:

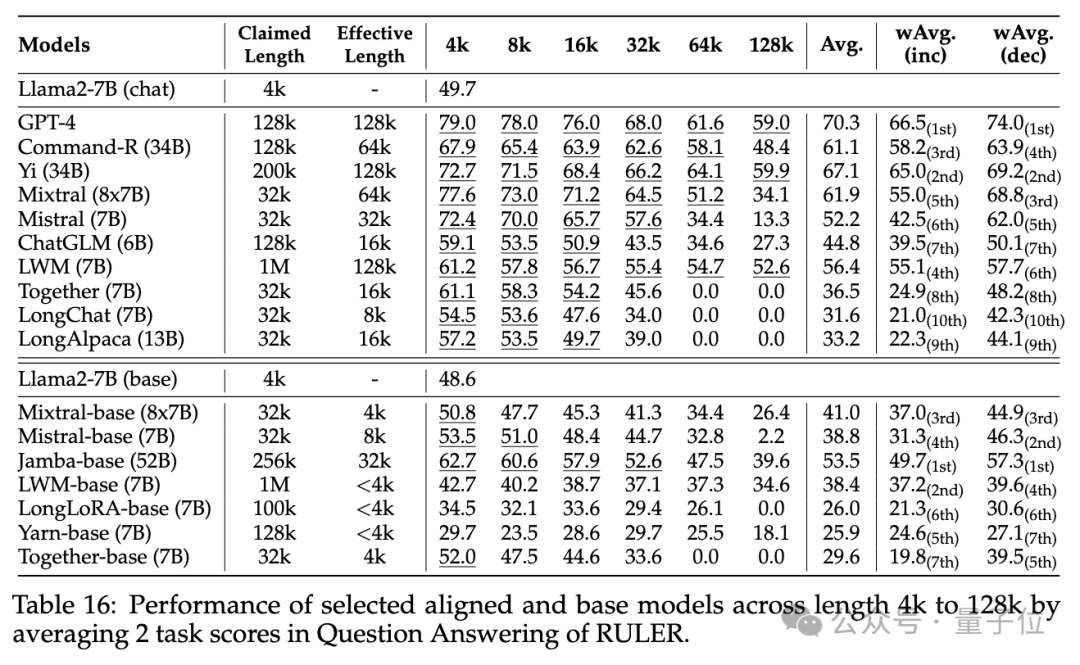

挑战第四关是问答任务(QA),在现有阅读理解数据集(如SQuAD)的基础上,插入大量干扰段落,考查长序列QA能力。

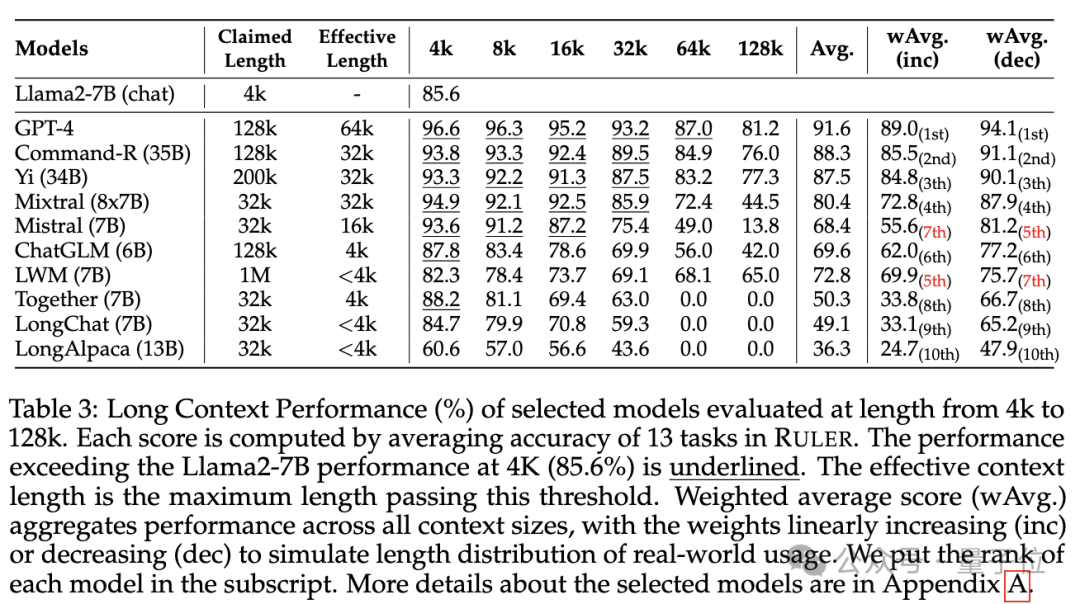

实验阶段,如开头所述,研究人员评测了10个声称支持长上下文的语言模型,包括GPT-4,以及9个开源模型开源模型Command-R、Yi-34B、Mixtral(8x7B)、Mixtral(7B)、ChatGLM、LWM、Together、LongChat、LongAlpaca。

这些模型参数规模范围从6B到采用MoE架构的8x7B不等,最大上下文长度从32K到1M不等。

在RULER基准测试中,对每个模型评测了13个不同的任务,覆盖4个任务类别,难度简单到复杂的都有。对每项任务,生成500个测试样例,输入长度从4K-128K共6个等级(4K、8K、16K、32K、64K、128K)。

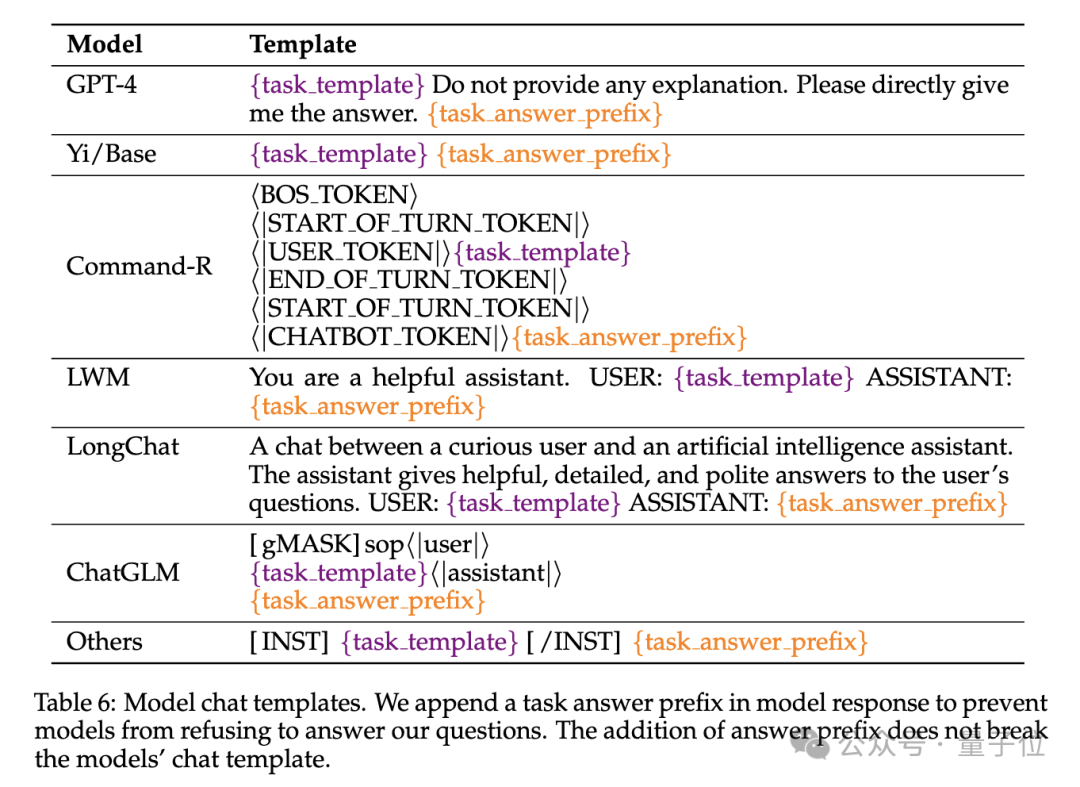

为了防止模型拒绝回答问题,输入被附加了answer prefix,并基于recall-based准确性来检查目标输出的存在。

研究人员还定义了“有效上下文长度”指标,即模型在该长度下能保持与基线Llama-7B在4K长度时的同等性能水平。

为了更细致的模型比较,使用了加权平均分数(Weighted Average, wAvg)作为综合指标,对不同长度下的性能进行加权平均。采用了两种加权方案:

来看结果。

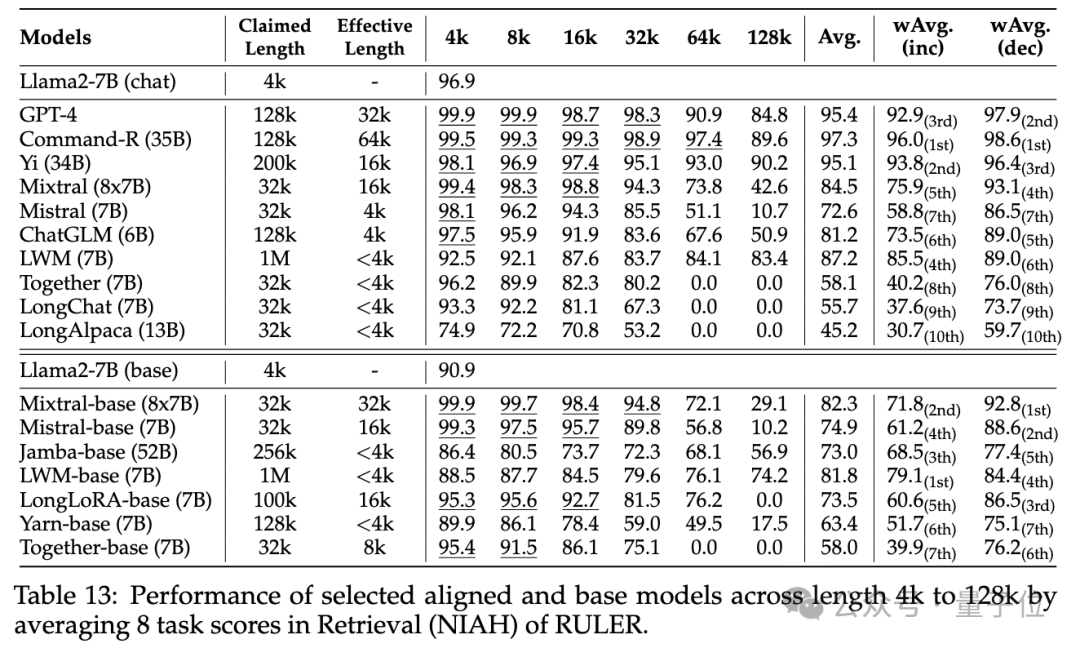

普通大海捞针和密码检索测试看不出差距,几乎所有模型在其声称的上下文长度范围内均取得满分。

而使用RULER,尽管很多模型声称能够处理32K token或更长的上下文,但除了Mixtral外,没有模型在其声称的长度上保持超过Llama2-7B基线的性能。

其他结果如下,总的来说,GPT-4在4K长度下表现最佳,并且在上下文扩展到128K时显示出最小的性能下降(15.4%)。

开源模型中排名前三的是Command-R、Yi-34B和Mixtral,它们都使用了较大的基频RoPE,并且比其它模型具有更多的参数。

此外,研究人员还对Yi-34B-200K模型在增加输入长度(高达256K)和更复杂任务上的表现进行了深入分析,以理解任务配置和失败模式对RULER的影响。

他们还分析了训练上下文长度、模型大小和架构对模型性能的影响,发现更大的上下文训练通常会带来更好的性能,但对长序列的排名可能不一致;模型大小的增加对长上下文建模有显著好处;非Transformer架构(如RWKV和Mamba)在RULER上的表现显著落后于基于Transformer的Llama2-7B。

更多细节,感兴趣的家银们可以查看原论文。

论文链接:https://arxiv.org/abs/2404.06654

文章来源于“量子位”,作者“关注前沿科技”