近年来兴起的第一人称视角视频研究为理解人类社交行为提供了无法取代的直观视角,然而,绝大多数的既往工作都侧重于分析与摄像机佩戴者相关的行为,并未关注处于社交场景中其他社交对象的状态。此外,多数现有模型能理解一种社交行为信号,而人类的实际社交行为是多样且密集的:在一个嘈杂的面对面多人对话场景中,我们总是在主动判断自己究竟在和谁说话,谁又在试图听我说话,也完全有能力推测这一群组中其他人之间的对话状态。不难想象,如果有一个算法可以帮助快速准确地做出对当前社交状态的判断,将会极大助力我们日常沟通的质量和效率。

在今年 CVPR 上,来自佐治亚理工学院、Meta 和伊利诺伊香槟分校的研究者们提出了新问题:一个同时应用第一人称视角音 - 视频信号的多模态框架是否可以像人类一样识别讨论组里同时存在的、错综复杂的对话状态?

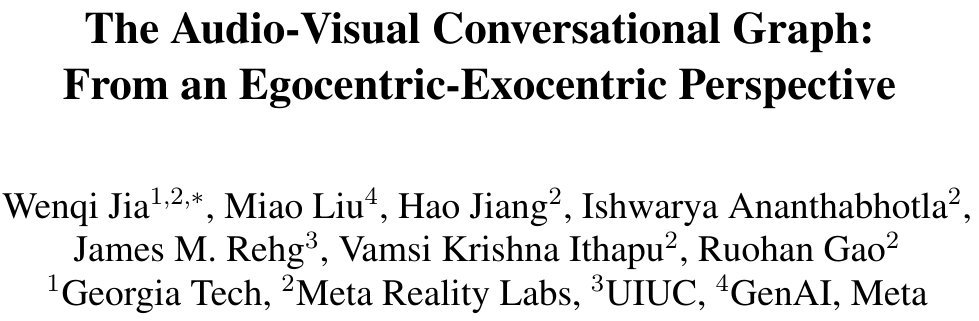

第一 (Ego) --- 第三 (Exo) 人称对话行为

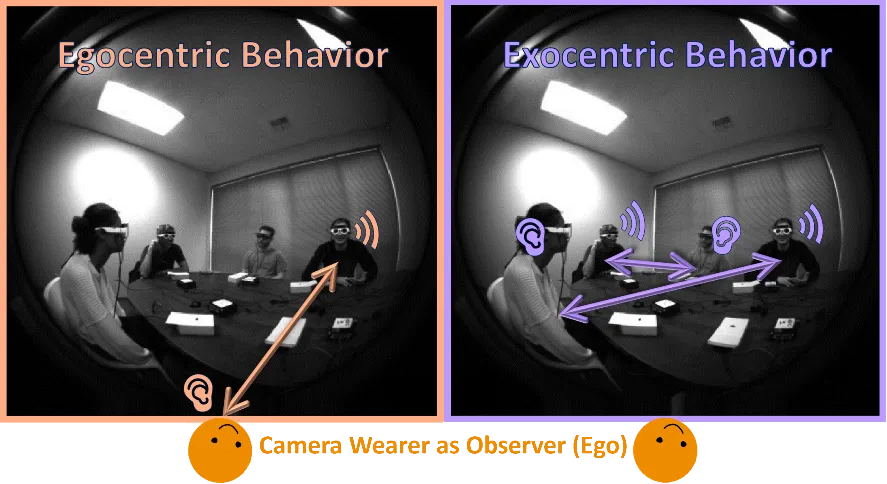

Ego-Exo 对话图

对此,他们引入了一个有向的第一 (Ego) --- 第三 (Exo) 人称对话图的概念来进行社交行为建模。与视觉关系场景图识别任务概念类似,这一任务旨在识别目标对之间的对话行为关系。具体来说,多人对话场景中包括相机佩戴者在内的每一个人都被表示为一个节点(node),当给定任意两个节点 AB 时,对话图利用连接他们的有向社交关系边(directional edge)表示这个社交对之间存在怎样的倾听和讲话属性(A 是否在对 B 说话 / 倾听,反之同理)。

第一 (Ego) --- 第三 (Exo) 人称对话图 两个社交对的有向社交关系边属性

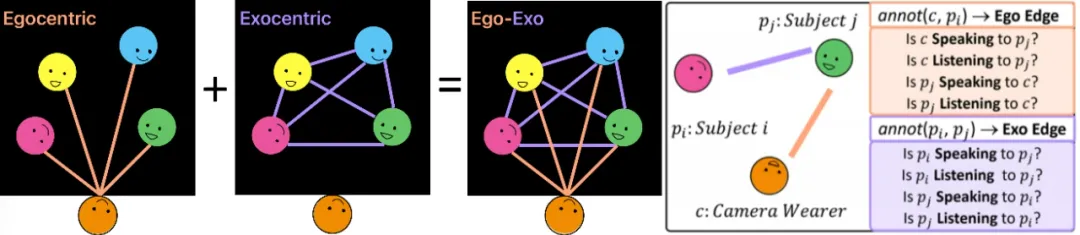

多模态对话注意力方法

人类在进行多人对话的社交活动时自然地利用着音视频信号的协同:我们需要视觉输入帮助识别社交对象的位置和外观,同时需要音频信号帮助确认哪些社交对象在发言。受此启发,该研究提出了一个统一的端到端多模态框架 --- 音视频对话注意力(AV-CONV),通过采用自注意力机制来建模跨时间、跨主体和全局 - 局部跨模态的表示来帮助解决这一对话图识别任务。

音视频对话注意力(AV-CONV)模型结构

这一框架包含了两个主要组件:1)社交对象多模态特征的生成;2)利用对话注意力模块(Conversational Attention)对多模态特征的增强,特征对的组装及输出预测。

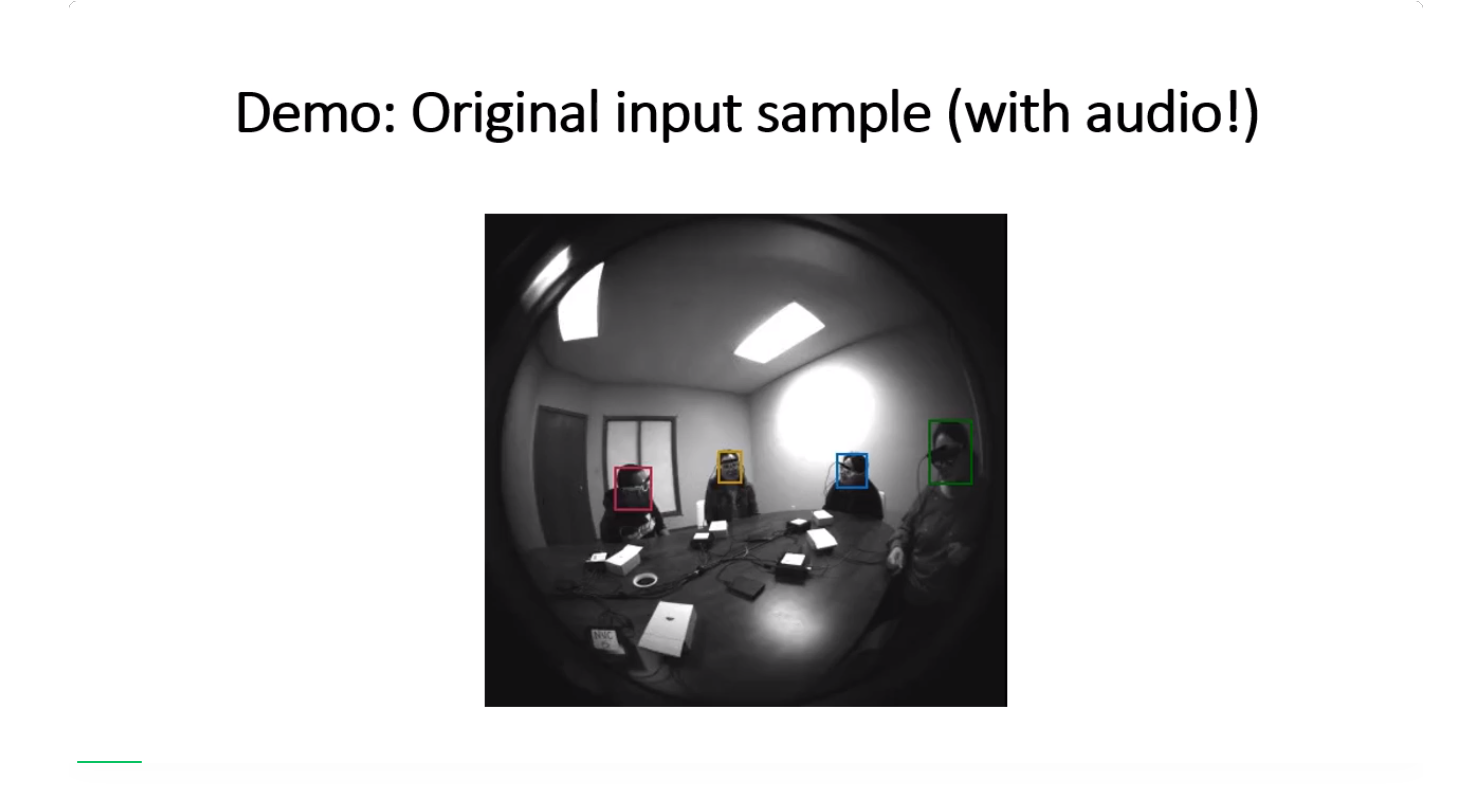

对于每个时长为 3 秒钟的视频输入,AV-CONV 接收 6 个均匀采样的第一人称视频帧和相应的多通道音频信号。在每一帧上,人脸检测算法帮助裁剪出所有可见的社交对象面部作为视觉信号。同时,这些人脸在视频帧上的相对位置以二值掩膜(binary mask)的形式与音频信号串连,生成具有位置敏感性的听觉输入。这些视觉和音频信号由两个独立的 ResNet18 网络编码,然后连接起来形成多模态音视频特征。

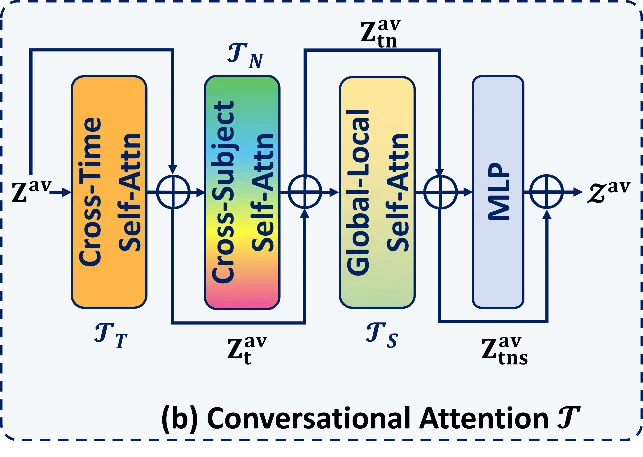

对话注意力模块(Conversational Attention)细节

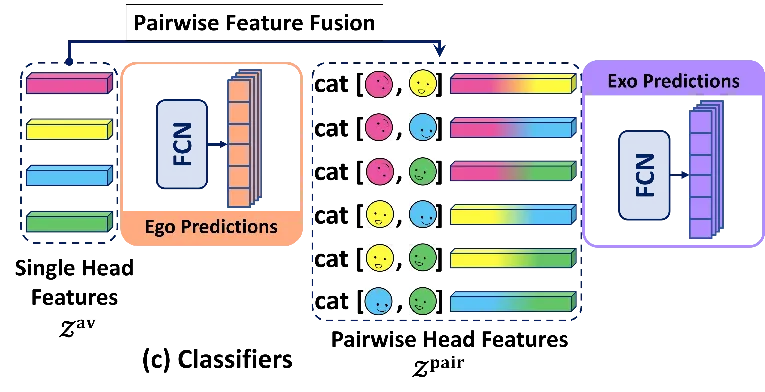

社交对象特征对组装及预测头

接下来,由三个双层自注意力子模块组成的对话注意力模块会从时间维度、不同社交对象维度和不同模态维度对这些多模态特征进行增强,这些特征会被直接输入一组分类器,以得到对包含相机佩戴者在内的社交对的关系预测结果。

此外,任意两个社交对象特征被组合成第三人称视角下的社交特征对。它们被输入另一组分类器,以得到对不包含相机佩戴者在内的其它社交对的关系预测结果。

对比及消融实验

这一方法在第一人称并发对话数据集 (Egocentric Concurrent Conversations Dataset) 上进行实验以验证其有效性。在这个数据集中,每个数据采集场景由被分为两组同时分别进行对话的 5 个人组成。该数据集收集了来自 50 名不同参与者的第一人称视频,总时长约为 20 小时。

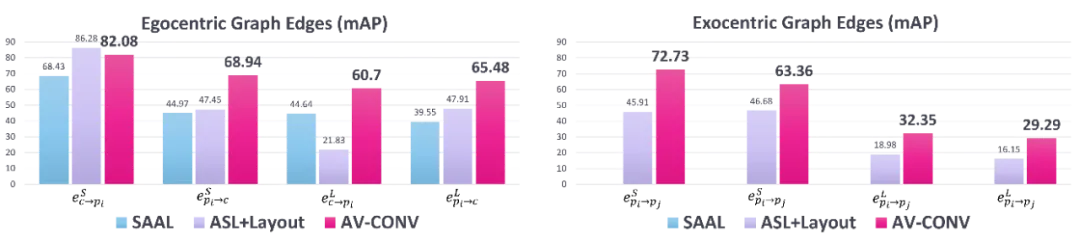

基准比较实验结果

对比实验采用了两个相关工作的扩展变体(SAAL, ASL+Layout)作为基准。实验结果表明,AV-CONV 在所有任务和指标上都大幅领先基准值。此外,一系列针对对话注意力模块和模型输入的消融实验进一步探索了模型设计细节的有效性。

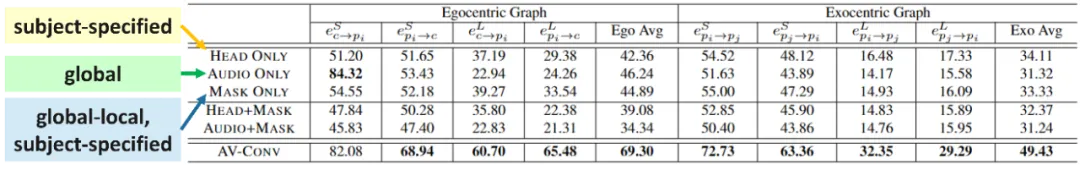

具体来说,对话注意力模块中每个组件及其不同的组合都会对整体性能产生影响。可以看到,完全去掉整个注意力模块的直接连接(DIRECT CONCAT)方法在几乎所有任务中都表现最差,而单独使用跨时间注意力(Cross-Time attention)、跨主体注意力(Cross-Subject attention)或全局 - 局部(Global-Local attention)跨模态注意力都对提升性能有积极的贡献。值得注意的是,跨时间的注意力带来了最大的增益,表明从相邻帧中聚合信息对于更可靠地检测语音活动至关重要。

针对模型输入的消融实验也揭示了不同模态对整体性能的影响。AV-CONV 的输入模态包括三个部分:1) 从第一人称视频帧裁剪的社交对象头部图像。2) 包含来自第一人称视频的多通道音频的全局特征。3) 头部图像的二值掩码,指定了帧中每个个体的位置,并作为一种介于全局和局部信息之间的表示。实验结果表明,仅使用头部图像会导致所有与说话相关的任务性能显著下降,因为理解说话行为需要音频信息的输入。另一方面,仅使用音频有助于识别相机佩戴者的声音活动,但在其他需要与对话伙伴相关的局部特征的任务上表现不佳。仅使用位置掩码的表现与仅使用头部图像相似,但它可以通过整个场景中头部位置的抽象表示推断出社交伙伴之间的潜在关系。例如,在与倾听相关的子任务上,它的表现优于仅使用头部图像,可能是因为这些任务更多地依赖于空间中社交对象的位置信息。

在这个示例中,摄像机佩戴者和其他两个社交对象同时与他人进行对话。在整个 3 秒的时间窗口内,一些发言者保持持续的对话,而其他人则暂停后继续。从预测值(黄色框)和真实值(绿色框)的对比中可以看到,AV-CONV 能够迅速捕捉到样本中发生的每一个动态演变,并给出准确的预测。

后续工作展望

受限于数据集类型和采集设备,这一工作局限于对话中的社交行为。然而提出的社交图概念可以轻松推广到对其他人类行为,如眼神交流或身体语言的分析。其他可能的后续工作包括使用大生成对话群组的提要及情感分析,以及从未经预定义群组的自由多人对话中挖掘对话群组的分裂、合并等复杂群体动态。

文章来源于“机器之心”