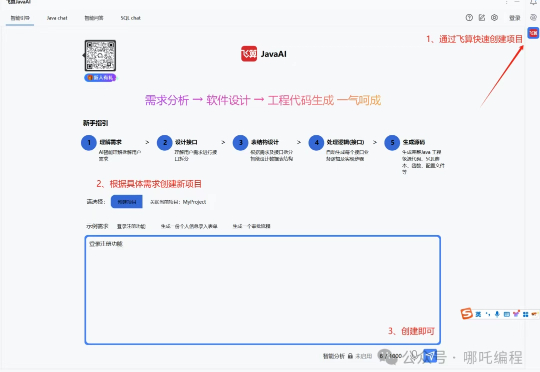

我的第一个AI编程助手,IDEA最新插件“飞算JavaAI”,太爽了

我的第一个AI编程助手,IDEA最新插件“飞算JavaAI”,太爽了还记得刚入行时,每遇到一个bug都要在CSDN和百度上搜索半天。输入错误信息,翻遍无数帖子,试了一个又一个方案,却往往发现要么版本不对,要么场景不符。最崩溃的是,好不容易找到一个看似相关的解决方案,复制粘贴后却发现引入了更多的问题。

还记得刚入行时,每遇到一个bug都要在CSDN和百度上搜索半天。输入错误信息,翻遍无数帖子,试了一个又一个方案,却往往发现要么版本不对,要么场景不符。最崩溃的是,好不容易找到一个看似相关的解决方案,复制粘贴后却发现引入了更多的问题。

本来没想写HeyGen,毕竟在国内用起来有点累。 起因是我们受邀和HeyGen第一次做了联名影片,在内测的过程里,这款名为AVATAR IV的数字人产品实在让我有点惊讶,于是突发奇想: 只用一张图,做一段rap歌手的mv。效果如下:

“科技行业里骗子和炒作者的数量之多,令人难以置信。”面对当下火热的 AI 浪潮,Java 之父直言不讳地对背后推波助澜的炒作者们发出尖锐批评。

AI是否真正在「思考」乃至产生意识,正成为科学和哲学交汇的核心议题。前OpenAI负责人翁荔认为,增加模型的「思考时间」有助突破复杂推理瓶颈;哈佛等机构则指出思维链可能导致「降智」;而生物学家Mallavarapu断言数字计算机永不可能拥有意识。

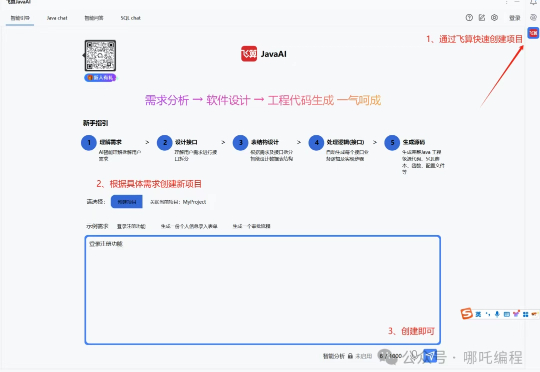

多模态大模型(MLLMs)在视觉理解与推理等领域取得了显著成就。然而,随着解码(decoding)阶段不断生成新的 token,推理过程的计算复杂度和 GPU 显存占用逐渐增加,这导致了多模态大模型推理效率的降低。

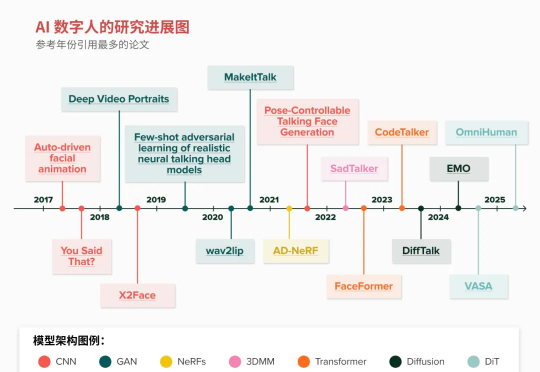

过去几年,AI 已经能生成逼真的图片、视频和声音,悄然通过视觉和听觉的图灵测试。但 2025 年最令人激动的突破之一,毫无疑问将是把这些方案集于一体的 AI 数字人(Al Avatar)。

这个号称世界上第一个AI天使投资人的No Cap,由Jeff wilson、Alexander Nevedovsky 和 Slava Solonitsyn打造,并在最近拿到了YC的投资。No Cap号称是通过一个“No Cap Mafia”社区训练出来的。在这个社区里,No Cap会接受很多公司创始人的指导,目前已经有超过60位创始人(他们都是YC的校友)参与其中。

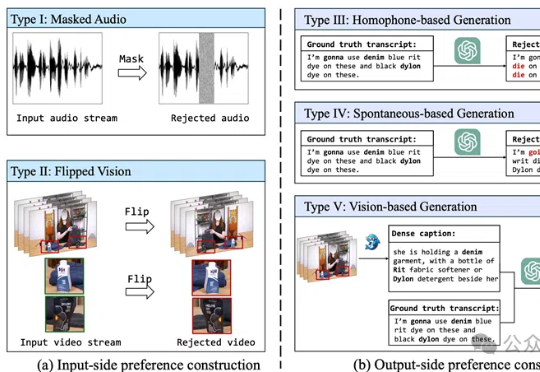

视觉+语音=更强的语音识别!BPO-AVASR通过优化音视频输入和输出偏好,提升语音识别在真实场景中的准确性,解决了传统方法在噪声、口语化和视觉信息利用不足的问题。

几年前,由于元宇宙的热潮,几家专注于数字虚拟人的初创公司应运而生。虽然这股热潮已经消退,但生成式人工智能为虚拟人注入了新的活力,因为创建不同的虚拟身份变得更加容易。

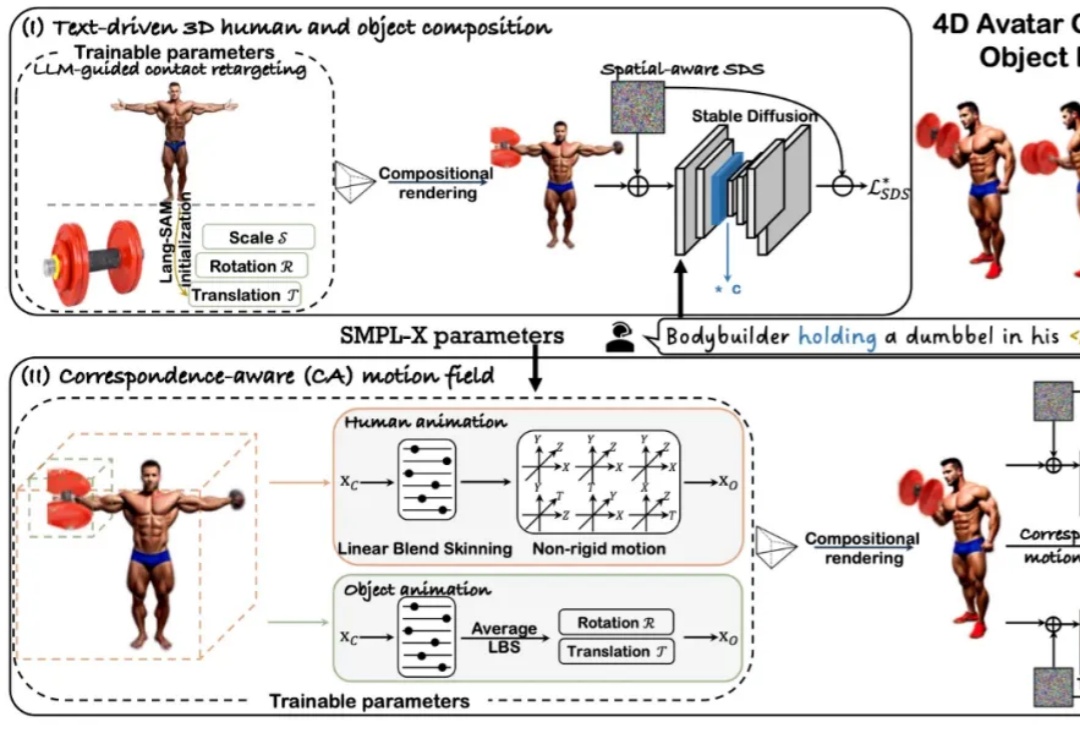

近年来,随着扩散模型和 Transformer 技术的快速发展,4D 人体 - 物体交互(HOI)的生成与驱动效果取得了显著进展。然而,当前主流方法仍依赖 SMPL [1] 这一人体先验模型来生成动作。