微软开源上千行代码PromptWizard,开启提示词工程的全自动时代

微软开源上千行代码PromptWizard,开启提示词工程的全自动时代在大语言模型(LLM)蓬勃发展的今天,提示词工程(Prompt Engineering)已经成为AI应用开发中不可或缺的关键环节。

在大语言模型(LLM)蓬勃发展的今天,提示词工程(Prompt Engineering)已经成为AI应用开发中不可或缺的关键环节。

1822 年,电学之父法拉第在日记中写到“既然通电能够产生磁力,为什么不能用磁铁产生电流呢?我一定要反过来试试!”。于是在 1831 年,第一台发电机被发明,推动了人类进入电气化时代。

在当今迅速发展的人工智能时代,大语言模型(LLMs)在各种应用中发挥着至关重要的作用。然而,随着其应用的广泛化,模型的安全性问题也引起了广泛关注。

最近,类 o1 模型的出现,验证了长思维链 (CoT) 在数学和编码等推理任务中的有效性。在长思考(long thought)的帮助下,LLM 倾向于探索、反思和自我改进推理过程,以获得更准确的答案。

2024年,AI Agent称得上最火热的概念。一方面,大模型赛道降温,并呈现出赢家通吃的局面;另一方面,AI Agent则是大模型应用落地的最佳形式,其能够解决LLMs在具体应用场景中的局限性。

近年来,基于大型语言模型(LLMs)的多智能体系统(MAS)已成为人工智能领域的研究热点。

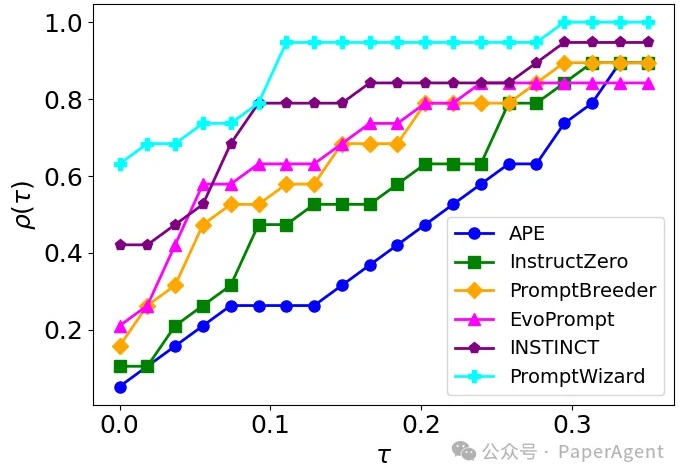

PromptWizard (PW) 旨在自动化和简化提示优化。它将 LLM 的迭代反馈与高效的探索和改进技术相结合,在几分钟内创建高效的prompts。

Hippocratic AI 的使命是打造首个以安全性为核心的医疗领域大语言模型(LLM)。

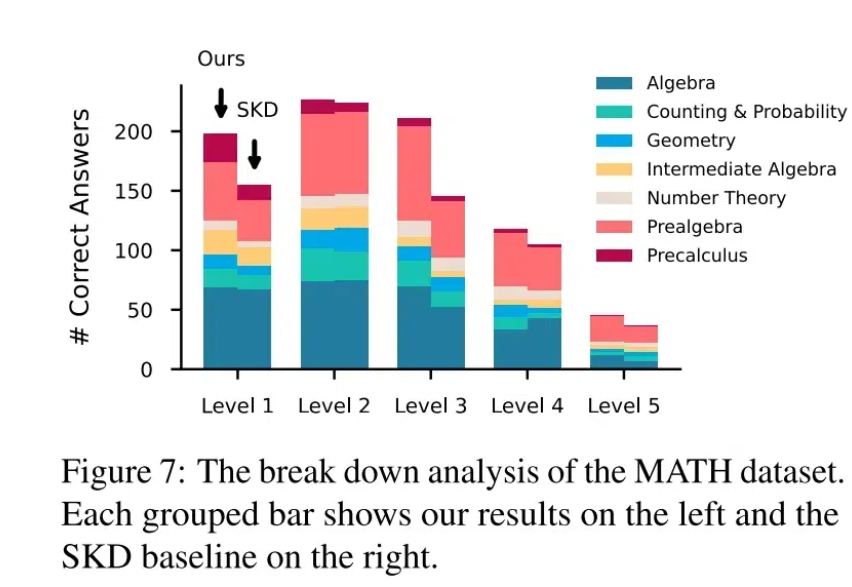

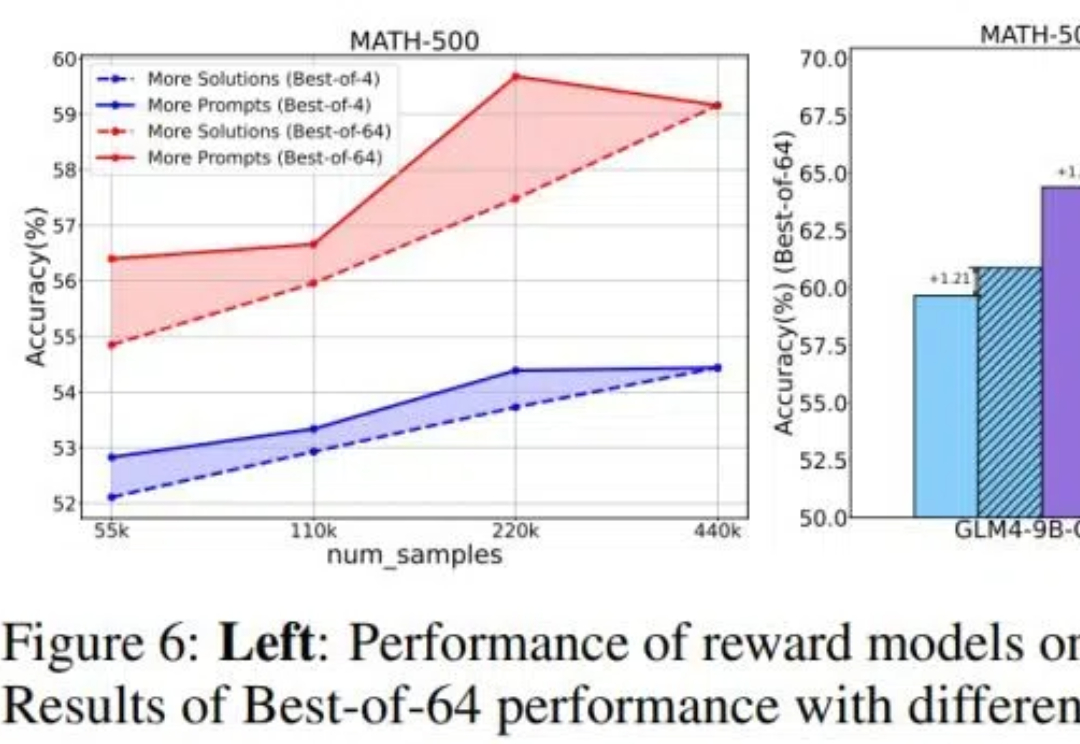

目前关于 RLHF 的 scaling(扩展)潜力研究仍然相对缺乏,尤其是在模型大小、数据组成和推理预算等关键因素上的影响尚未被系统性探索。 针对这一问题,来自清华大学与智谱的研究团队对 RLHF 在 LLM 中的 scaling 性能进行了全面研究,并提出了优化策略。

在大语言模型(LLM)的发展历程中,思维链(Chain of Thought,CoT)推理无疑是一个重要的里程碑。