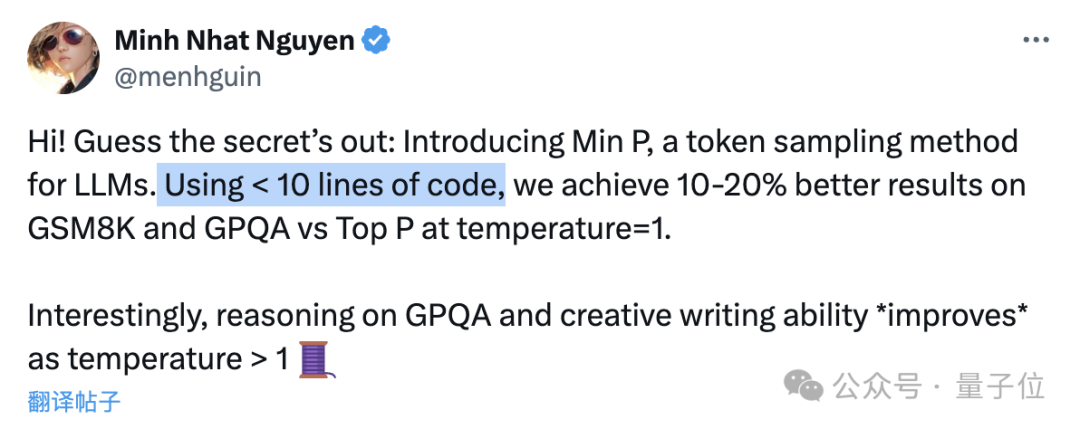

10行代码让大模型数学提升20%,“野路子”研究谷歌也测上了,主要作者全靠自学成才

10行代码让大模型数学提升20%,“野路子”研究谷歌也测上了,主要作者全靠自学成才只要不到10行代码,就能让大模型数学能力(GSM8k)提升20%!

只要不到10行代码,就能让大模型数学能力(GSM8k)提升20%!

小模型时代来了?OpenAI带着GPT-4o mini首次入局小模型战场,Mistral AI、HuggingFace本周接连发布了小模型。如今,苹果也发布了70亿参数小模型DCLM,性能碾压Mistral-7B。

小模型成趋势?

近日,西交微软北大联合提出信息密集型训练大法,使用纯数据驱动的方式,矫正LLM训练过程产生的偏见,在一定程度上治疗了大语言模型丢失中间信息的问题。

对于小型语言模型(SLM)来说,数学应用题求解是一项很复杂的任务。

大模型内卷时代,也不断有人跳出来挑战Transformer的统治地位,RWKV最新发布的Eagle 7B模型登顶了多语言基准测试,同时成本降低了数十倍

在 AI 赛道中,与动辄上千亿参数的模型相比,最近,小模型开始受到大家的青睐。比如法国 AI 初创公司发布的 Mistral-7B 模型,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 1 34B。

2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!