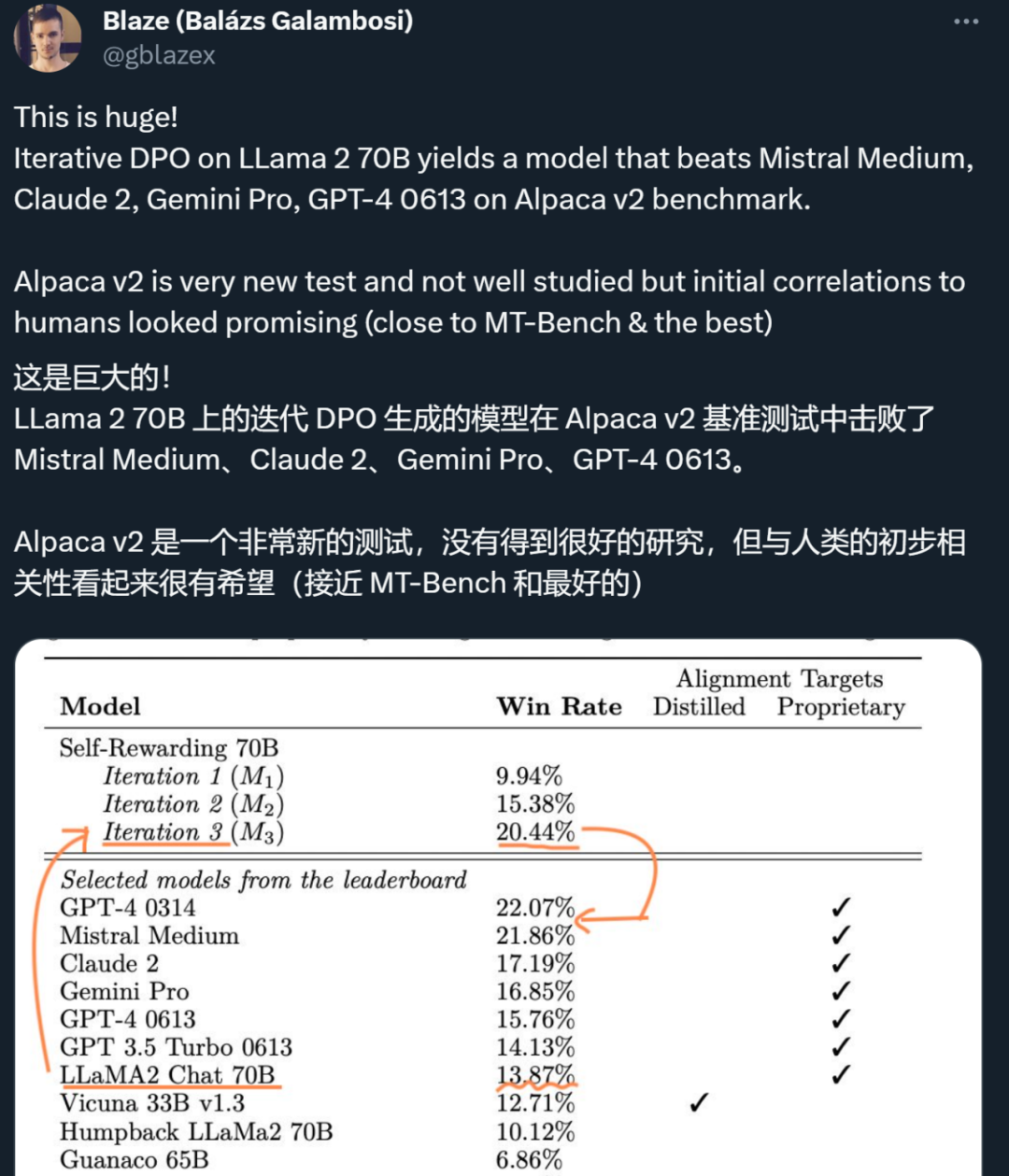

大模型自我奖励:Meta让Llama2自己给自己微调,性能超越了GPT-4

大模型自我奖励:Meta让Llama2自己给自己微调,性能超越了GPT-4人工智能的反馈(AIF)要代替 RLHF 了?

人工智能的反馈(AIF)要代替 RLHF 了?

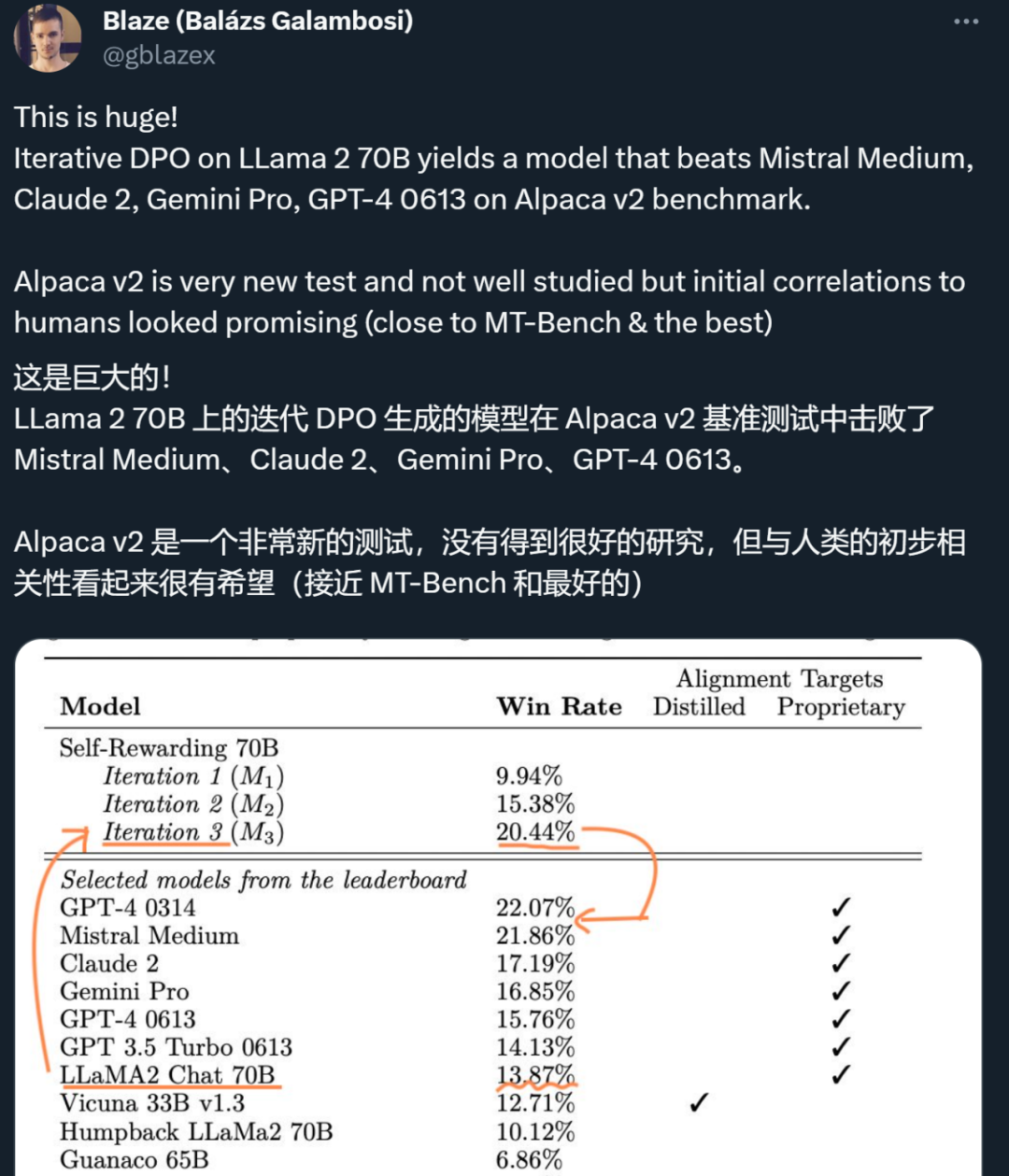

复旦团队进一步挖掘 RLHF 的潜力,重点关注奖励模型(Reward Model)在面对实际应用挑战时的表现和优化途径。

OpenAI认为,未来十年来将诞生超过人类的超级AI系统。但是,这会出现一个问题,即基于人类反馈的强化学习技术将终结。

多模态技术是 AI 多样化场景应用的重要基础,多模态大模型(MLLM)展现出了优秀的多模态信息理解和推理能力,正成为人工智能研究的前沿热点。上周,谷歌发布 AI 大模型 Gemini,据称其性能在多模态任务上已全面超越 OpenAI 的 GPT-4V,再次引发行业的广泛关注和热议。

随着大型语言模型(LLM)的发展,从业者面临更多挑战。如何避免 LLM 产生有害回复?如何快速删除训练数据中的版权保护内容?如何减少 LLM 幻觉(hallucinations,即错误事实)? 如何在数据政策更改后快速迭代 LLM?这些问题在人工智能法律和道德的合规要求日益成熟的大趋势下,对于 LLM 的安全可信部署至关重要。

大模型的效果好不好,有时候对齐调优很关键。但近来很多研究开始探索无微调的方法,艾伦人工智能研究所和华盛顿大学的研究者用「免调优」对齐新方法超越了使用监督调优(SFT)和人类反馈强化学习(RLHF)的 LLM 性能。

RLHF今年虽然爆火,但实打实用到的模型并不多,现在还出现了替代方案,有望从开源界“出圈”;大模型透明度越来越低,透明度最高的是Llama 2,但得分也仅有54;

谷歌团队的最新研究提出了,用大模型替代人类,进行偏好标注,也就是AI反馈强化学习(RLAIF)。