NeurIPS 2024 | 大模型的词表大小,同样适用于Scaling Law

NeurIPS 2024 | 大模型的词表大小,同样适用于Scaling Law本文是一篇发表在 NeurIPS 2024 上的论文,单位是香港大学、Sea AI Lab、Contextual AI 和俄亥俄州立大学。论文主要探讨了大型语言模型(LLMs)的词表大小对模型性能的影响。

来自主题: AI技术研报

7606 点击 2024-10-11 13:55

本文是一篇发表在 NeurIPS 2024 上的论文,单位是香港大学、Sea AI Lab、Contextual AI 和俄亥俄州立大学。论文主要探讨了大型语言模型(LLMs)的词表大小对模型性能的影响。

Molmo,开源多模态模型正在发力!

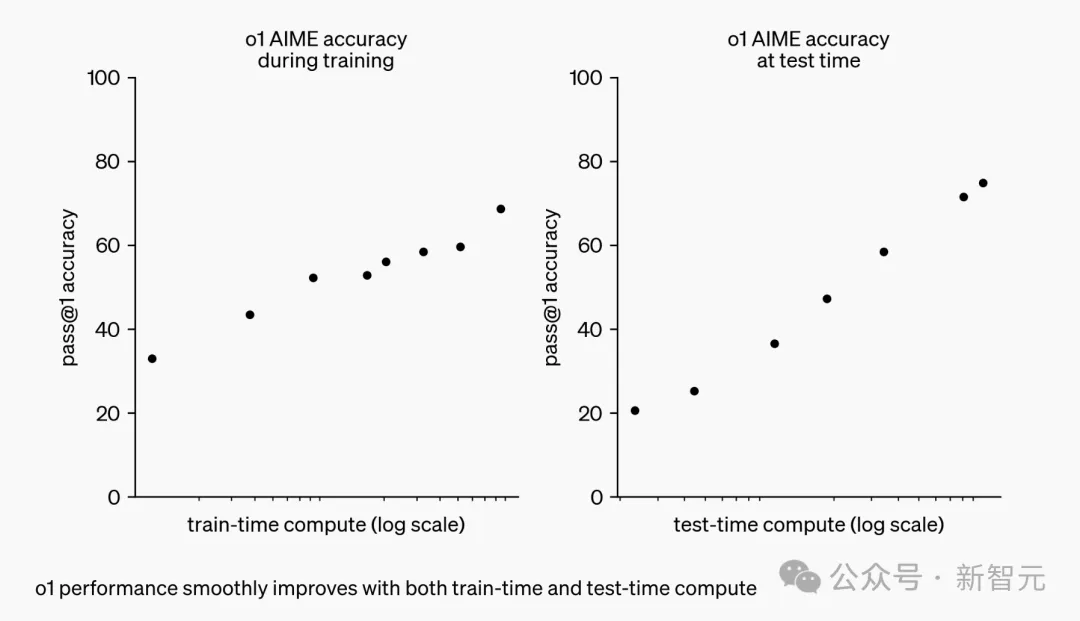

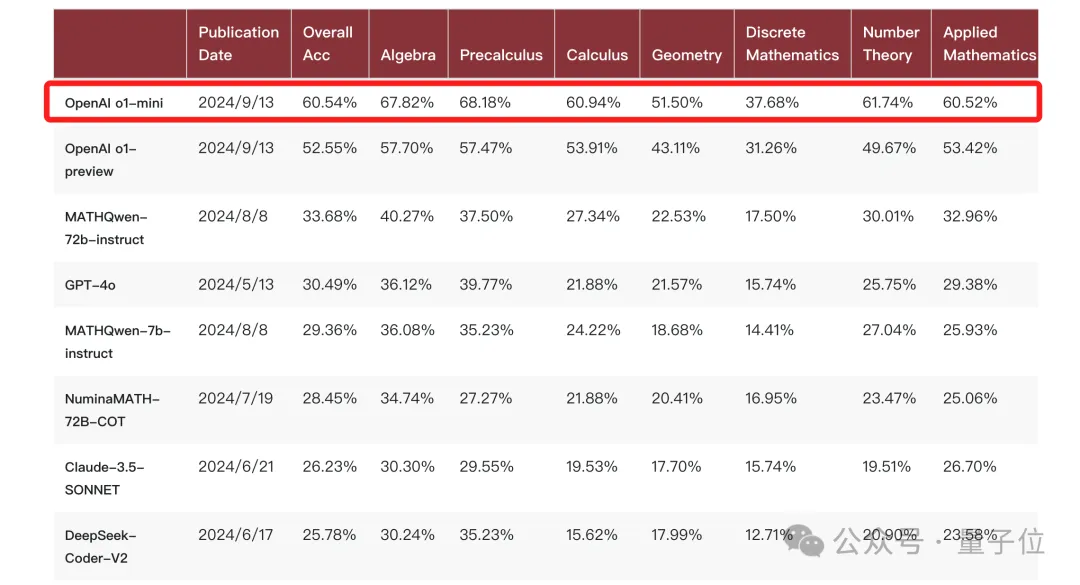

CoT铸就了o1推理王者。 它开创了一种推理scaling新范式——随着算力增加、更长响应时间,o1性能也随之增长。

在电影《天下无贼》中,葛优扮演的黎叔有这样一句经典的台词,「二十一世纪什么最贵?人才!」而随着人工智能行业进入到大模型时代,这一问题的答案已然变成了「算力」。

OpenAI的新模型o1,可谓是开启了Scaling Law的新篇章——

GPT-4o 读万卷书,「o1」行万里路。

机器人能认出镜子中的自己吗?目前来看,依然做不到。

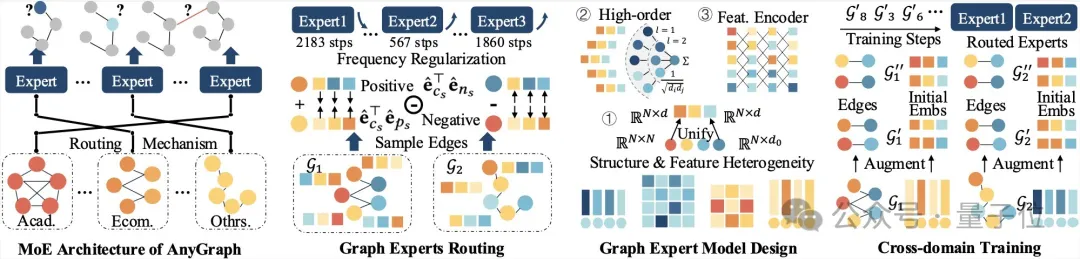

新型图基础模型来了—— AnyGraph,基于图混合专家(MoE)架构,专门为实现图模型跨场景泛化而生。

OpenAI用o1开启推理算力Scaling Law,能走多远?

好家伙,OpenAI 终于上新了!