长短大小样样精通!原始分辨率、超长视频输入:更灵活的全开源多模态架构Oryx

长短大小样样精通!原始分辨率、超长视频输入:更灵活的全开源多模态架构Oryx视觉数据的种类极其多样,囊括像素级别的图标到数小时的视频。现有的多模态大语言模型(MLLM)通常将视觉输入进行分辨率的标准化或进行动态切分等操作,以便视觉编码器处理。然而,这些方法对多模态理解并不理想,在处理不同长度的视觉输入时效率较低。

视觉数据的种类极其多样,囊括像素级别的图标到数小时的视频。现有的多模态大语言模型(MLLM)通常将视觉输入进行分辨率的标准化或进行动态切分等操作,以便视觉编码器处理。然而,这些方法对多模态理解并不理想,在处理不同长度的视觉输入时效率较低。

近日,清华大学电子系城市科学与计算研究中心的研究论文《EconAgent: Large Language Model-Empowered Agents for Simulating Macroeconomic Activities》获得自然语言处理顶会 ACL 2024杰出论文奖(Outstanding Paper Award)。

来自复旦大学视觉与学习实验室的研究者们提出了一种新型的面向视频模型的对抗攻击方法 - 基于扩散模型的视频非限制迁移攻击(ReToMe-VA)。该方法采用逐时间步对抗隐变量优化策略,以实现生成对抗样本的空间不可感知性;同时,在生成对抗帧的去噪过程中引入了递归 token 合并策略,通过匹配及合并视频帧之间的自注意力 token,显著提升了对抗视频的迁移性和时序一致性。

过去几年间,Transformer 架构已经取得了巨大的成功,同时其也衍生出了大量变体,比如擅长处理视觉任务的 Vision Transformer(ViT)。本文要介绍的 Body Transformer(BoT) 则是非常适合机器人策略学习的 Transformer 变体。

大语言模型 (LLM) 经历了重大的演变,最近,我们也目睹了多模态大语言模型 (MLLM) 的蓬勃发展,它们表现出令人惊讶的多模态能力。 特别是,GPT-4o 的出现显著推动了 MLLM 领域的发展。然而,与这些模型相对应的开源模型却明显不足。开源社区迫切需要进一步促进该领域的发展,这一点怎么强调也不为过。

下一代视觉模型会摒弃patch吗?Meta AI最近发表的一篇论文就质疑了视觉模型中局部关系的必要性。他们提出了PiT架构,让Transformer直接学习单个像素而不是16×16的patch,结果在多个下游任务中取得了全面超越ViT模型的性能。

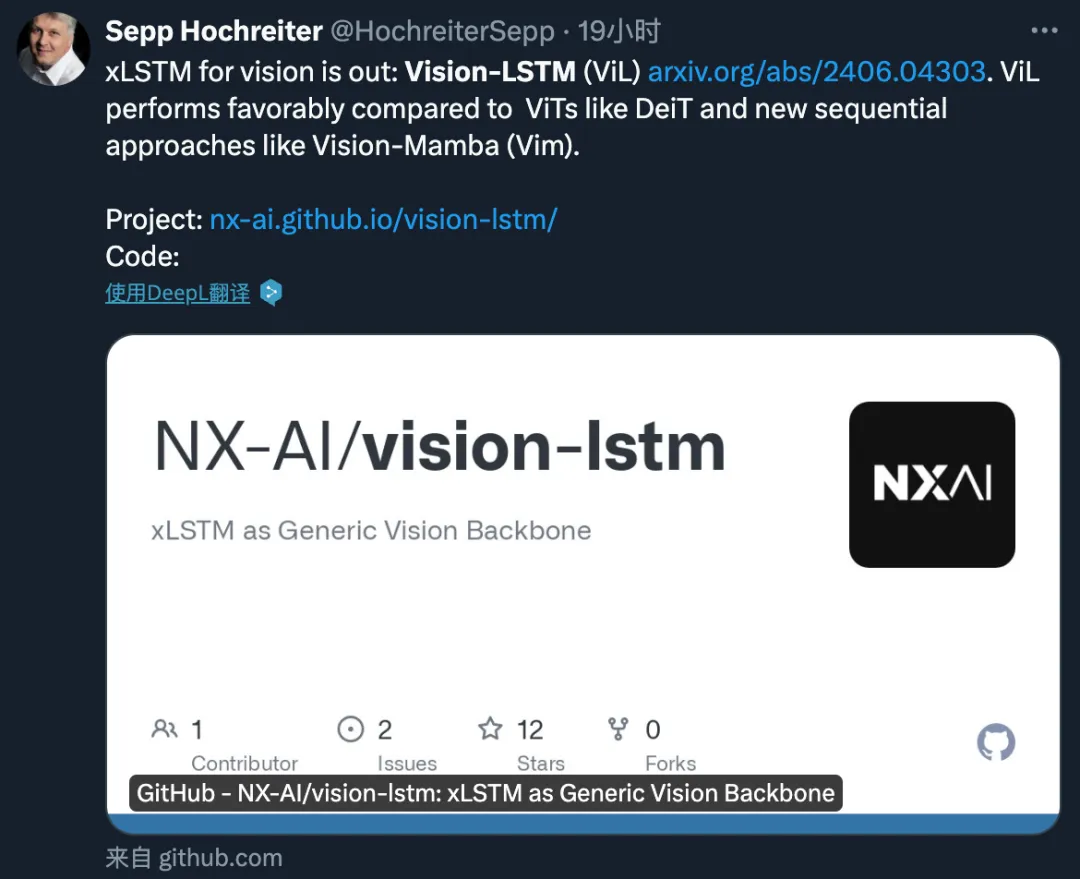

与 DeiT 等使用 ViT 和 Vision-Mamba (Vim) 方法的模型相比,ViL 的性能更胜一筹。

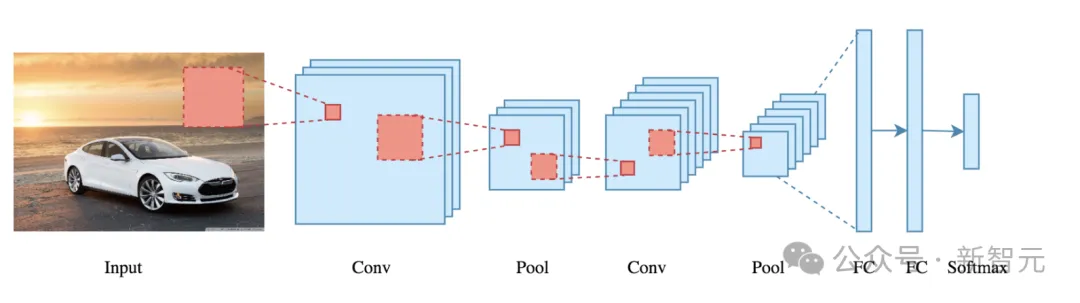

用卷积能做出一样好的效果。

昨天刚刚在顶会ICLR作为特邀演讲(Invited Talk)中“国内唯一”的大模型玩家智谱AI,今天又放出了一个好消息

奔向通用人工智能,大模型又迈出一大步。