一块显卡理解一部电影,最新超长视频理解大模型出炉!“大海捞针”准确率近95%,代码已开源

一块显卡理解一部电影,最新超长视频理解大模型出炉!“大海捞针”准确率近95%,代码已开源仅需1块80G显卡,大模型理解小时级超长视频。 智源研究院联合上海交通大学、中国人民大学、北京大学和北京邮电大学等多所高校带来最新成果超长视频理解大模型Video-XL。

仅需1块80G显卡,大模型理解小时级超长视频。 智源研究院联合上海交通大学、中国人民大学、北京大学和北京邮电大学等多所高校带来最新成果超长视频理解大模型Video-XL。

开源数字人实时对话Demo来了~

视频多模态大模型(LMMs)的发展受限于从网络获取大量高质量视频数据。为解决这一问题,我们提出了一种替代方法,创建一个专为视频指令跟随任务设计的高质量合成数据集,名为 LLaVA-Video-178K。

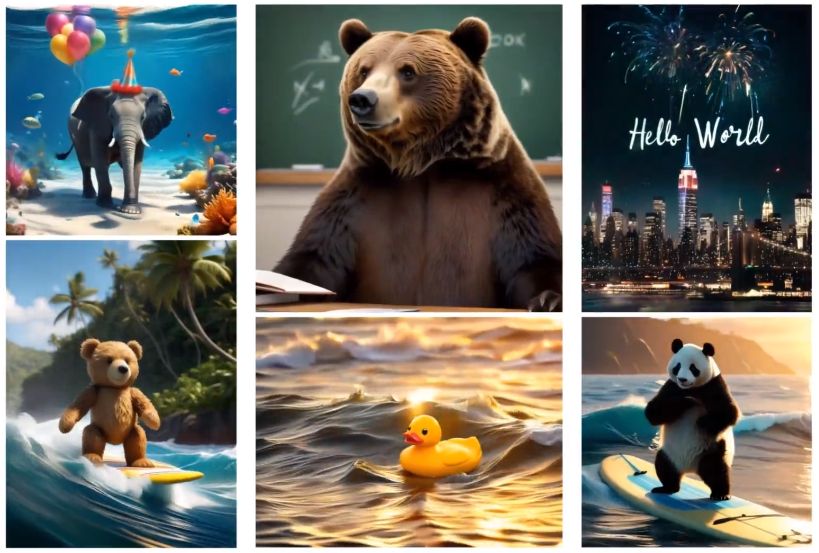

现在正是「文本生视频」赛道百花齐放的时代,而且其应用场景非常多,比如生成创意视频内容、创建游戏场景、制作动画和电影。

现在,人人皆导演,正在成为现实!

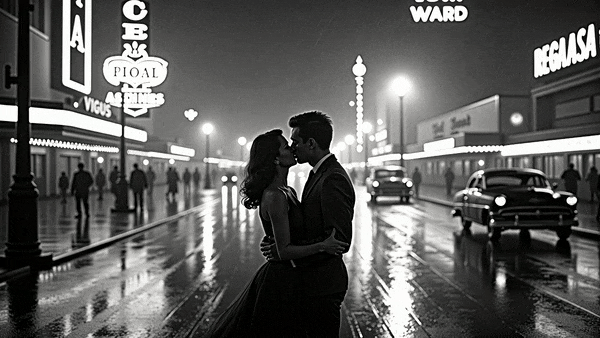

这是由潞晨 Video Ocean 生成的黑白电影片段,全新升级的模型现已正式上线,任意角色任意风格,并带来三大突破性功能 —— 文生视频、图生视频、角色生视频,解锁创意的无限可能。

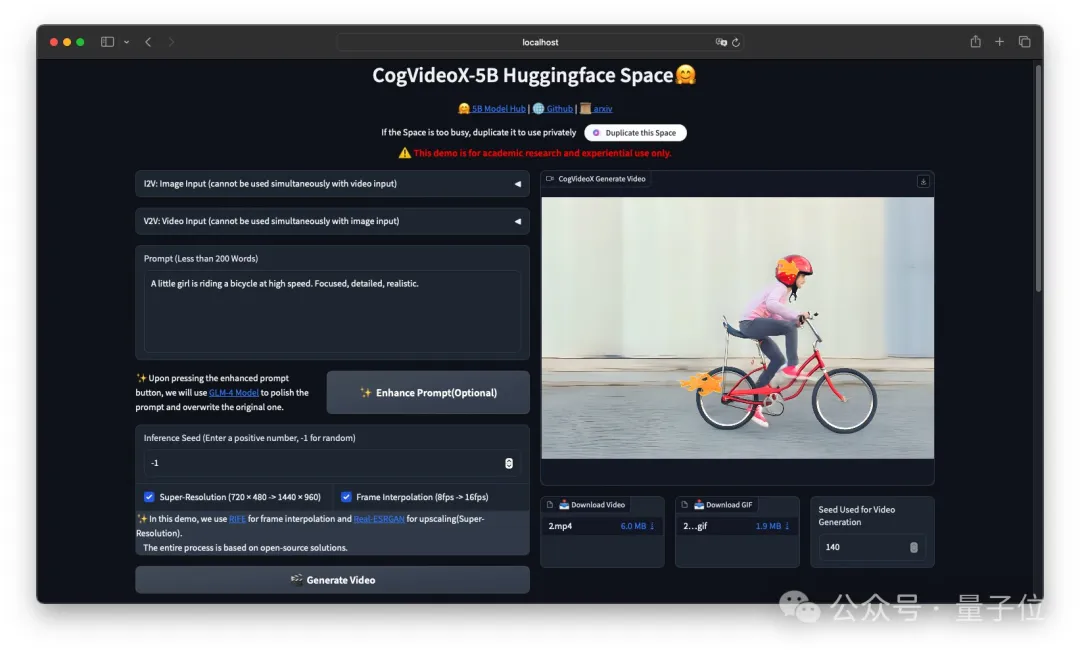

刚刚,智谱把清影背后的图生视频模型CogVideoX-5B-I2V给开源了!(在线可玩) 一起开源的还有它的标注模型cogvlm2-llama3-caption。

前几天 MiniMax 发布了海螺视频生成模型 abab-video-1,现场体验非常炸裂。很多朋友跑来问我,这个海螺视频模型和可灵的区别主要是什么?于是我做了一个短片,来从六个维度展现这两个视频模型的不同之处。一句话总结海螺视频就是:美学升级,运镜加分,表情丰富,文字突出。

两天前, 国内 AI 独角兽 MiniMax 重磅发布的视频生成模型video-01,因其能够生成超逼真的人类视频,特别是在手部动作的精准模拟方面表现卓越,迅速引起了业界的广泛关注。这款 AI 工具的问世标志着生成式 AI 领域的又一次重要突破。但它到底表现如何呢?

近日,开源社区又迎来一款强力的「视频生成」工作,可以在消费级显卡 (如 GeForce RTX 3090) 上生成任意分辨率、任意宽高比、不同风格、不同运动幅度的视频,其衍生模型还能够完成视频扩展、视频回溯的功能…… 这便是 360AI 团队和中山大学联合研发的 FancyVideo,一种基于 UNet 架构的视频生成模型。