对话 Nexa AI:两位斯坦福95后,做出比GPT-4o快4倍的小模型,直指“端侧版Hugging Face”

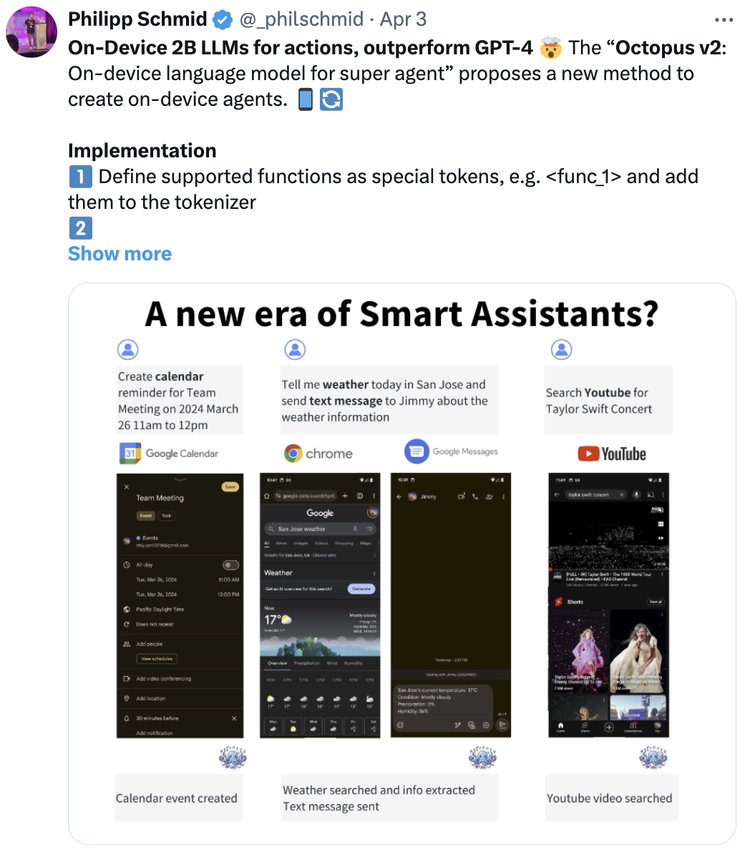

对话 Nexa AI:两位斯坦福95后,做出比GPT-4o快4倍的小模型,直指“端侧版Hugging Face”比OpenAI最强的GPT-4o更快,函数调用能力与GPT-4相当,同时比它小N倍,且只需要一张卡来做推理。

比OpenAI最强的GPT-4o更快,函数调用能力与GPT-4相当,同时比它小N倍,且只需要一张卡来做推理。

2023年中国大模型领域,经历最跌宕起伏的人。

一觉醒来,OpenAI又上新功能了:

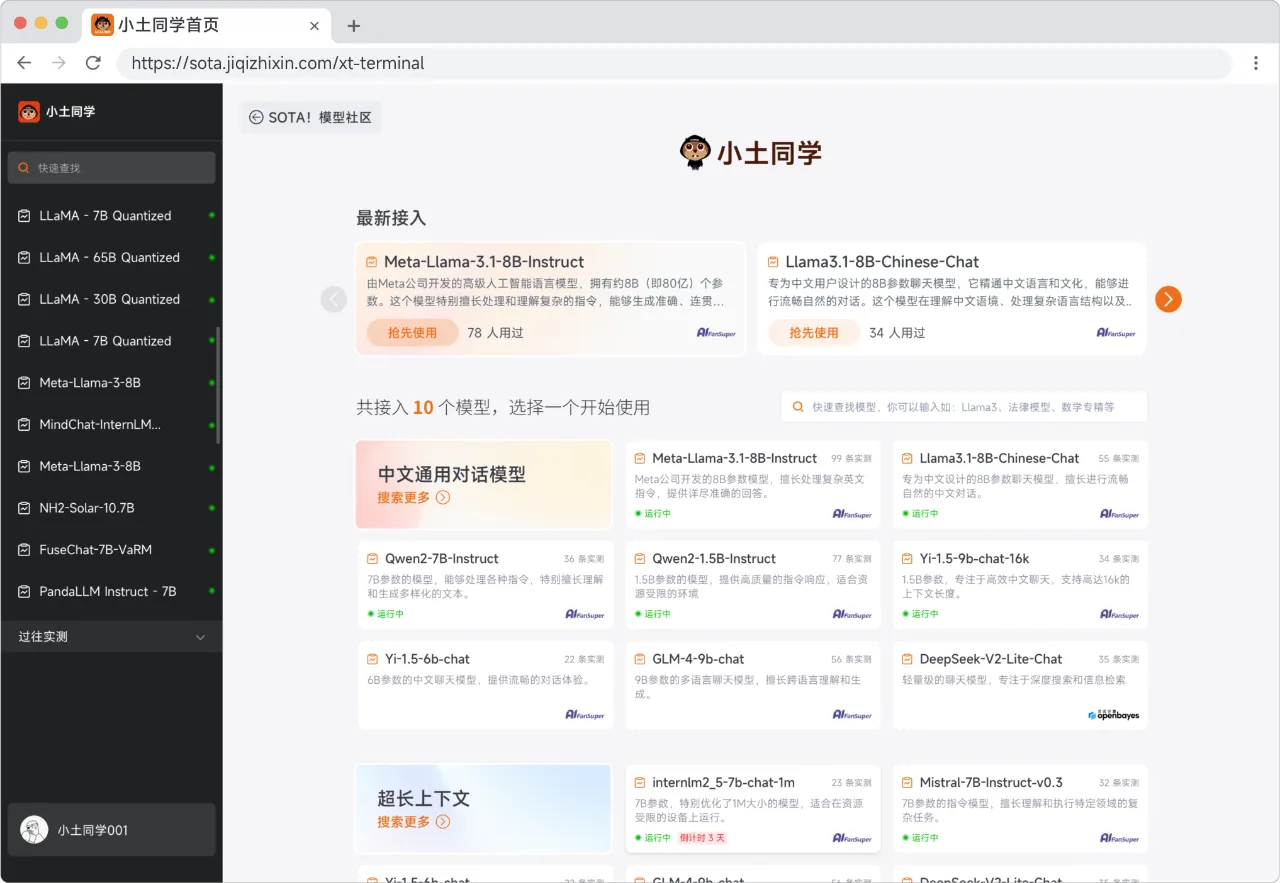

作为全公司产品做的最好的工程师,同时也是代码写得最好的产品经理,你深刻地知道:搞个靠谱的 AI 应用需要灵感,而好的灵感则需要一个靠谱的 demo 来验证。

Groq又双叒给英伟达上压力了!不仅之前展现了每秒1256个token的破纪录输出速度,最新获得的一轮6.4亿美元融资更提供了在AI芯片领域挑战英伟达的底气。

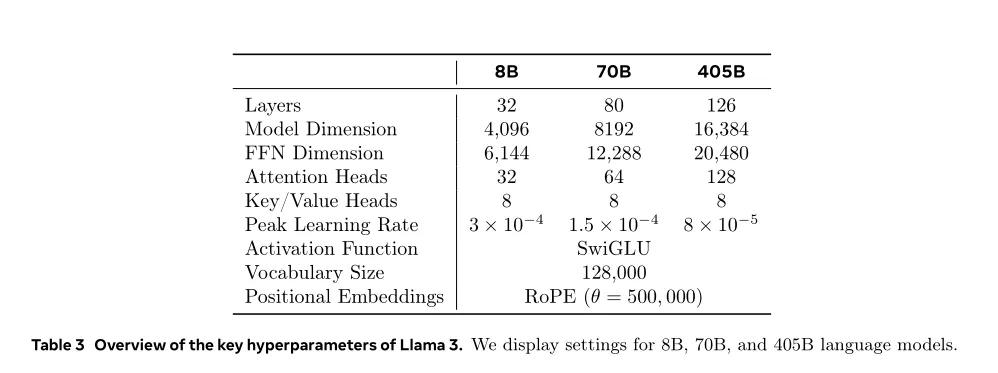

Llama 3.1 刚刚发布,你是否已经尝试了呢?就算你的个人计算机是最近的顶尖配置,运行其中最小的 8B 版本可能也依然会有明显延迟。为了提升模型的推理效率,研究者想出了多种多样的方法,但其中很多都会让模型牺牲一些准确度。

不同类型的数据配比如何配置:先通过小规模实验确定最优配比,然后将其应用到大模型的训练中。 Token配比结论:通用知识50%;数学与逻辑25%;代码17%;多语言8%。

2024 年的 AI 图像生成技术,又提升到了一个新高度。

解决问题:语言智能体的动作通常由 Token(令牌,语言模型中表示单词/短语/汉字的最小符号单元)序列组成,直接将强化学习用于语言智能体进行策略优化的过程中,一般需要预定义可行动作集合,同时忽略了动作内 Token 细粒度信用分配问题,团队将 Agent 优化从动作层分解到 Token 层,为每个动作内 Token 提供更精细的监督,可在语言动作空间不受约束的环境中实现可控优化复杂度

随着大型语言模型(LLMs)的进步,多模态大型语言模型(MLLMs)迅速发展。它们使用预训练的视觉编码器处理图像,并将图像与文本信息一同作为 Token 嵌入输入至 LLMs,从而扩展了模型处理图像输入的对话能力。这种能力的提升为自动驾驶和医疗助手等多种潜在应用领域带来了可能性。