DeepSeek V3获竞技场最强开源认证!与Claude 3.5 Sonnet对比实测来了

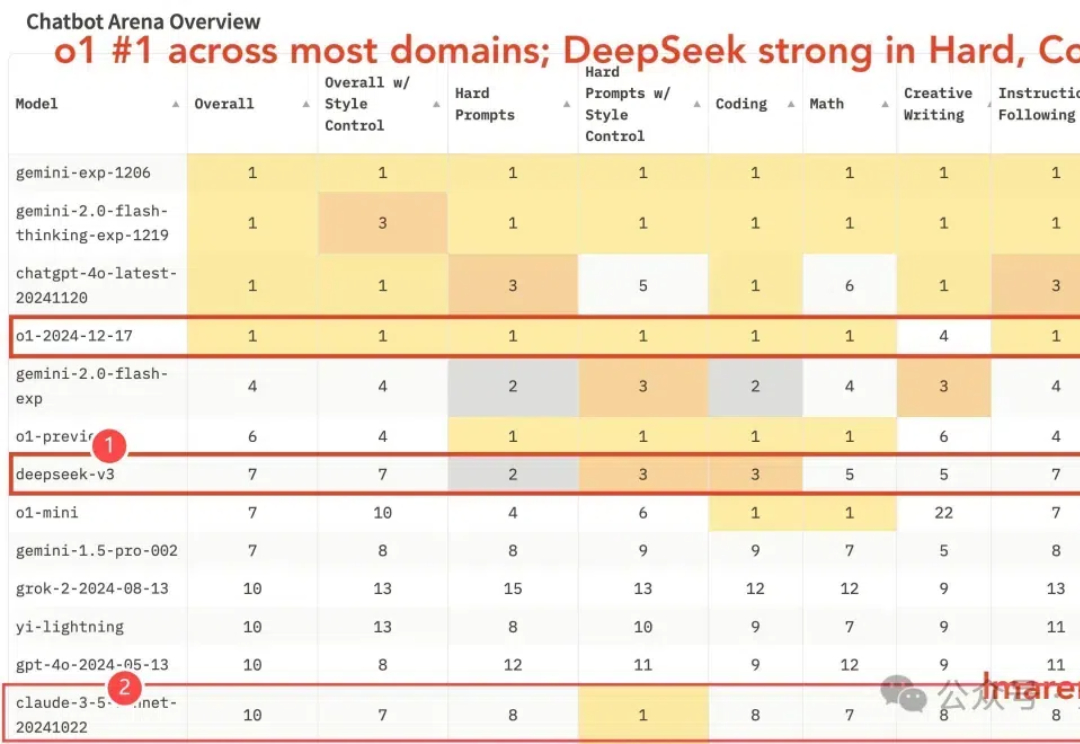

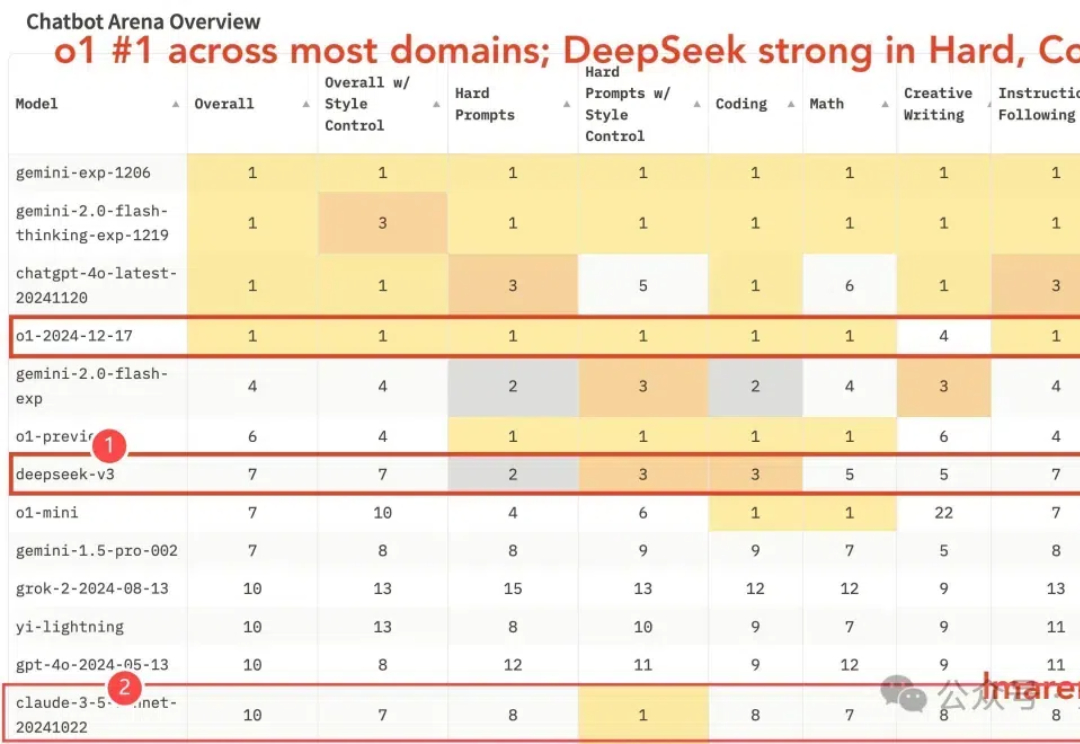

DeepSeek V3获竞技场最强开源认证!与Claude 3.5 Sonnet对比实测来了国产之光DeepSeek V3竞技场排名新鲜出炉—— 优于o1-mini(总榜第7),获最强开源模型认证(也是唯一闯入前10的开源模型)。

国产之光DeepSeek V3竞技场排名新鲜出炉—— 优于o1-mini(总榜第7),获最强开源模型认证(也是唯一闯入前10的开源模型)。

一个来自中国的开源模型,让整个AI圈再次惊呼“来自东方的神秘力量”。 昨天,国内知名大模型创业公司“深度求索”通过官方公众号宣布上线并同步开源 DeepSeek-V3模型,并公布了长达53页的训练和技术细节。

都说国产大模型“通义千问”能打,到底是真强还是智商税?今天就带你看看,这个国产“AI猛将”凭什么火出圈! 2023年4月,阿里巴巴推出通义千问,选择了“全开源”的策略,成为全球开发者关注的焦点。而在2024年的云栖大会上,阿里云进一步发布了Qwen2.5系列,包括多个尺寸的大语言模型、多模态模型、数学模型和代码模型,涵盖从0.5B到72B的完整规模

OpenAI在LangSmith用户群中继续稳居最常使用的大语言模型供应商宝座,其使用率是排名第二的Ollama的六倍以上。开源模型的采用率有了显著增长,特别是Ollama和Groq两家公司,它们支持用户运行开源模型,并在今年成功跻身行业前五。

全球首个端侧全模态理解开源模型来了!

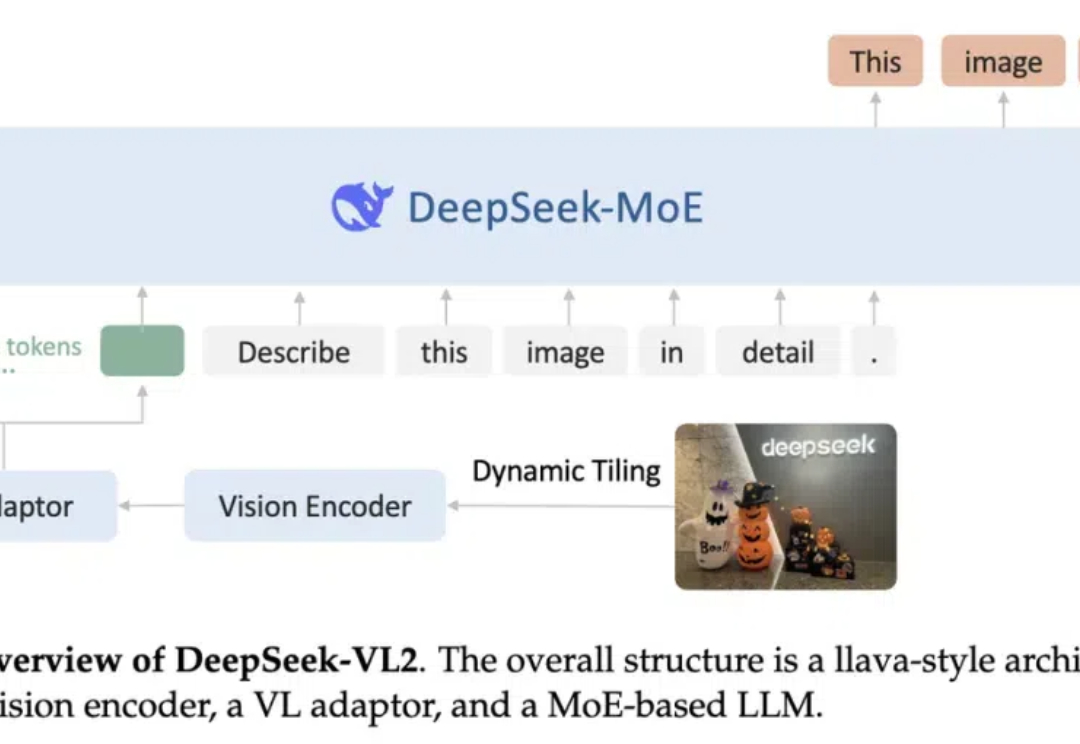

阔别九月,大家期待的 DeepSeek-VL2 终于来了!DeepSeek-MoE 架构配合动态切图,视觉能力再升级。从视觉定位到梗图解析,从 OCR 到故事生成,从 3B、16B 再到 27B,DeepSeek-VL2 正式开源。

Allen Institute for AI(AI2)发布了Tülu 3系列模型,一套开源的最先进的语言模型,性能与GPT-4o-mini等闭源模型相媲美。Tülu 3包括数据、代码、训练配方和评估框架,旨在推动开源模型后训练技术的发展。

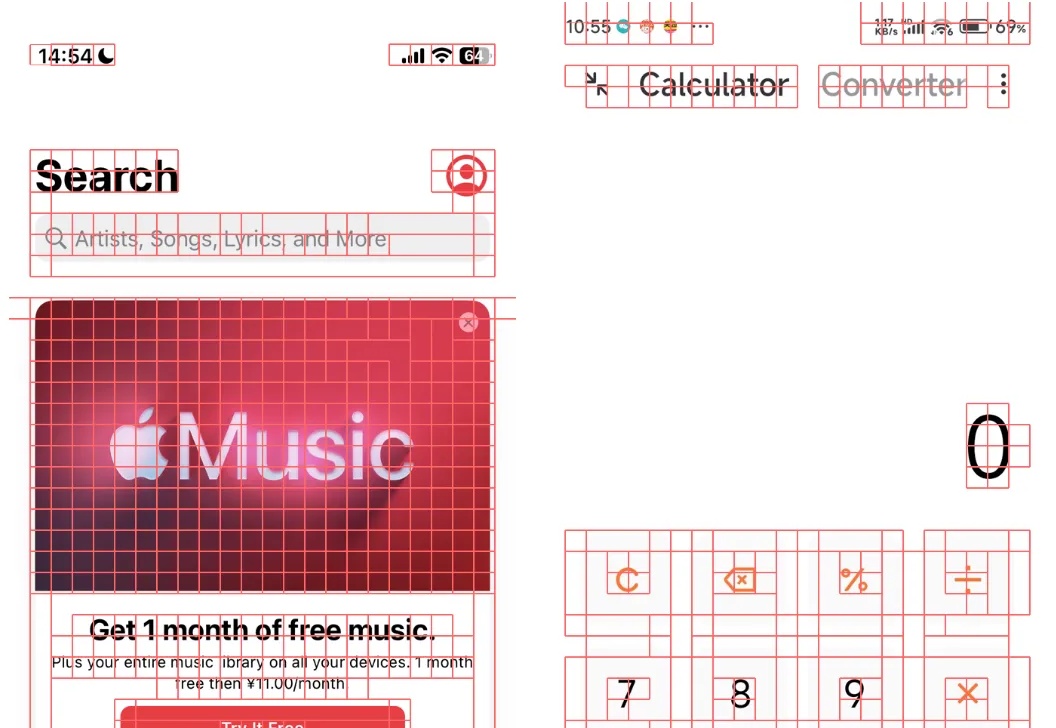

Show Lab 和微软推出 ShowUI,这是一个刚刚开源的 UI Agent 模型,在中文 APP 定位和导航能力上表现出色。通过创新的视觉 token 选择和独特的训练数据构建方法,该模型在有限的训练数据下实现了非常棒的性能。

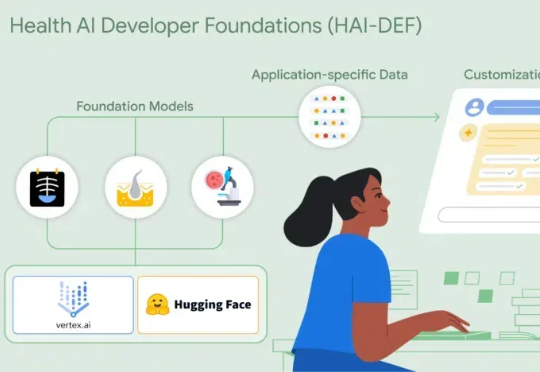

Google研究院健康AI团队于近日推出了全新的开源模型套件——Health AI Developer Foundations(HAI-DEF)。在本次HAI-DEF的首次发布中,Google推出了三个专注于医疗影像应用的重要模型。首先是CXR Foundation胸部X光模型,其次是Derm Foundation皮肤影像模型,第三个是Path Foundation病理学模型,它基于ViT-S架构

QwQ 具有神奇的推理能力。 一个刚发布两天的开源模型,正在 AI 数学奥林匹克竞赛 AIMO 上创造新纪录。