AI竟会看Prompt下菜!Vibe coding普通人vs程序员,剑桥最新报告

AI竟会看Prompt下菜!Vibe coding普通人vs程序员,剑桥最新报告您有没有发现一个奇怪的现象:同样是Vibe coding,有些人轻松拿到完整的Flask应用,有些人却只得到几行if-else语句?剑桥大学计算机科学与技术系的研究者们最近发布了一项研究,用科学的方法证实了我们的直觉——AI确实会"看人下菜碟"。

您有没有发现一个奇怪的现象:同样是Vibe coding,有些人轻松拿到完整的Flask应用,有些人却只得到几行if-else语句?剑桥大学计算机科学与技术系的研究者们最近发布了一项研究,用科学的方法证实了我们的直觉——AI确实会"看人下菜碟"。

作为一个专注用AI解决具体场景问题的自媒体小博主,每一个场景我一般都搓一个提示词出来,随着覆盖的场景越来越多,我的提示词库也变得越来越庞大。

在计算机科学领域,有一句英文谚语——「Garbage in, Garbage out」。

还记得DeepSeek-R1发布时AI圈的那波狂欢吗?"提示工程已死"、"再也不用费心写复杂提示了"、"推理模型已经聪明到不再需要学习提示词了"......这些观点在社交媒体上刷屏,连不少技术大佬都在转发。再到最近,“提示词写死了”......现实总是来得这么快——乔治梅森大学的研究者们用一个严谨得让人无法反驳的实验,狠狠打了所有人的脸!

现在市面上有46种Prompt工程技术,但真正能在软件工程任务中发挥作用的,可能只有那么几种。来自巴西联邦大学、加州大学尔湾分校等顶级院校的研究者们,花了大量时间和计算资源,调研了58种,整理了46种,最终筛选测试了14种主流提示技术在10个软件工程任务上的表现,用了4个不同的大模型(包括咱们的Deepseek-V3),总共跑了2000多次实验。

反正只要是苹果的一定会有很多人跟风,所以这个效果在接下来的一段时间你一定会频繁的看见,或者被要求使用。这里藏师傅也是一上午探索了一下如何将液态玻璃效果融入到网页生成的提示词里面,没想到真让我搞了个差不多的出来。

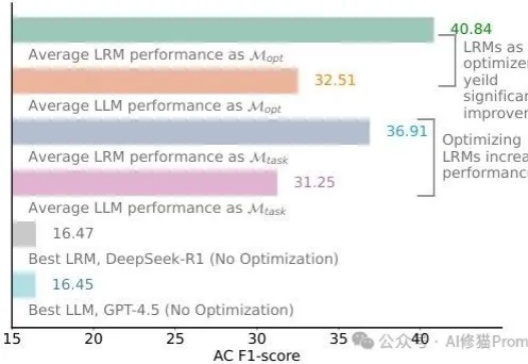

宾夕法尼亚大学沃顿商学院生成式AI实验室刚刚发布了两份重磅研究报告,通过严格的科学实验揭示了一个令人震惊的事实:我们可能一直在用错误的方式与AI对话。这不是胡说八道,而是基于近4万次实验得出的硬核数据推理的结论。

谷歌旗舰视频模型Veo 3上线不到一个月,各种玩法层出不穷。 这不,玩法再升级,只需添加一个提示词“360°”就能解锁3D世界!

企业级低代码开发平台Superblocks 的 CEO 布拉德·梅内塞斯认为,下一批价值十亿美元的创业点子几乎就藏在眼前:现有 AI 独角兽企业所使用的系统提示词中。

昨天YC一个访谈《State-Of-The-Art Prompting For AI Agents》,专门讲他们投资的一家客服公司,公开了他们提示词的写法,这应该也属于第一家吧。