这个 AI 生图神器太好玩了,连提示词都不用写

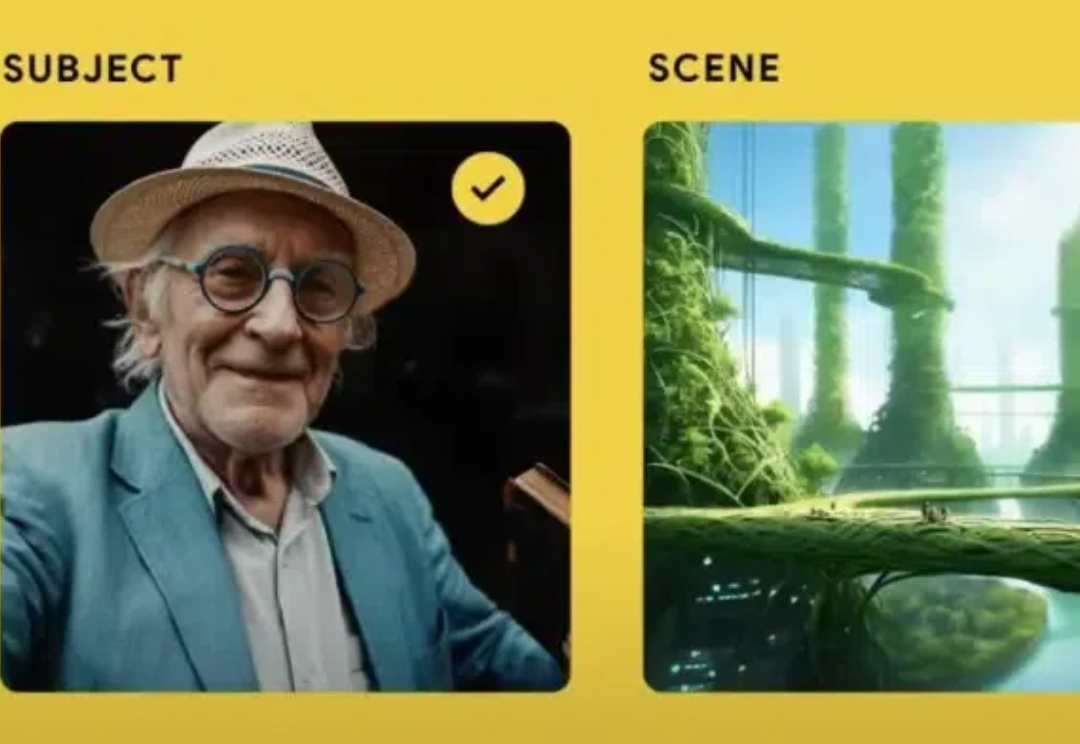

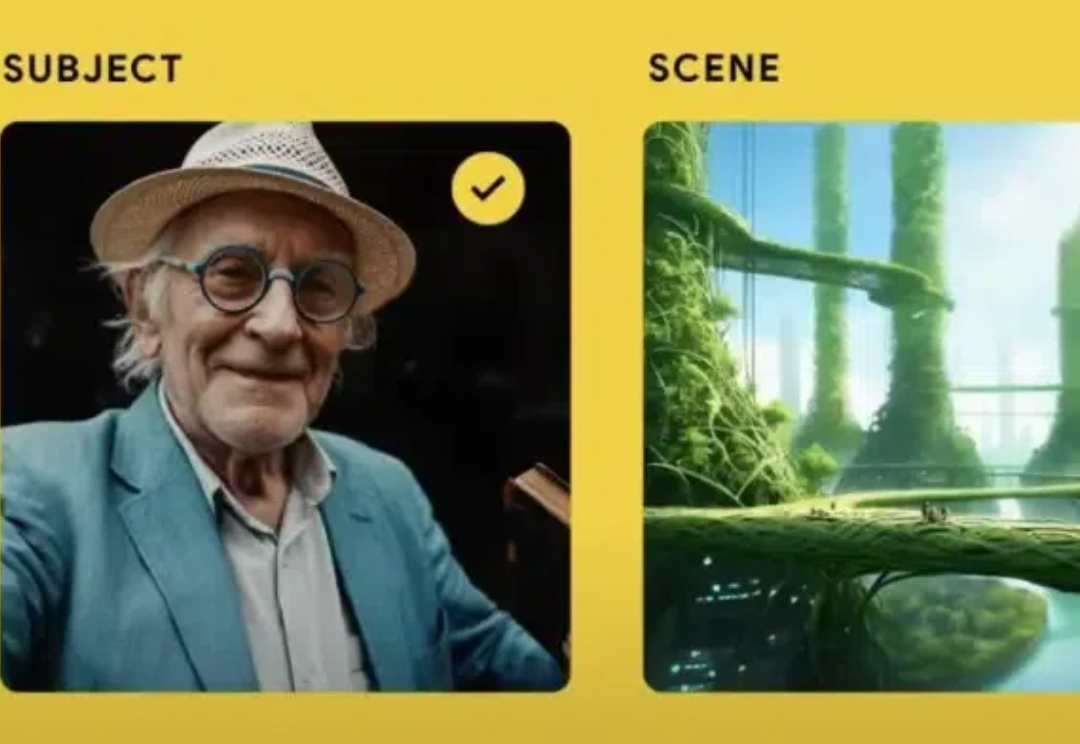

这个 AI 生图神器太好玩了,连提示词都不用写AI 生图工具,已经多得泛滥了,但 Google 最新推出的 Whisk,还是找到了一种很新的玩法,让见过世面的网友也直呼好玩。

AI 生图工具,已经多得泛滥了,但 Google 最新推出的 Whisk,还是找到了一种很新的玩法,让见过世面的网友也直呼好玩。

大语言模型(LLM)在自然语言处理领域取得了令人瞩目的成就,但在需要多步推理的复杂任务中仍面临严峻挑战。

大语言模型(LLM)在自然语言处理领域取得了巨大突破,但在复杂推理任务上仍面临着显著挑战。现有的Chain-of-Thought(CoT)和Tree-of-Thought(ToT)等方法虽然通过分解问题或结构化提示来增强推理能力,但它们通常只进行单次推理过程,无法修正错误的推理路径,这严重限制了推理的准确性。

LLM 强大的语言能力,使其被广泛部署于 LLM 应用系统(LLM-integrated applications)中。此时,LLM 需要访问外部数据(如文件,网页,API 返回值)来完成任务。

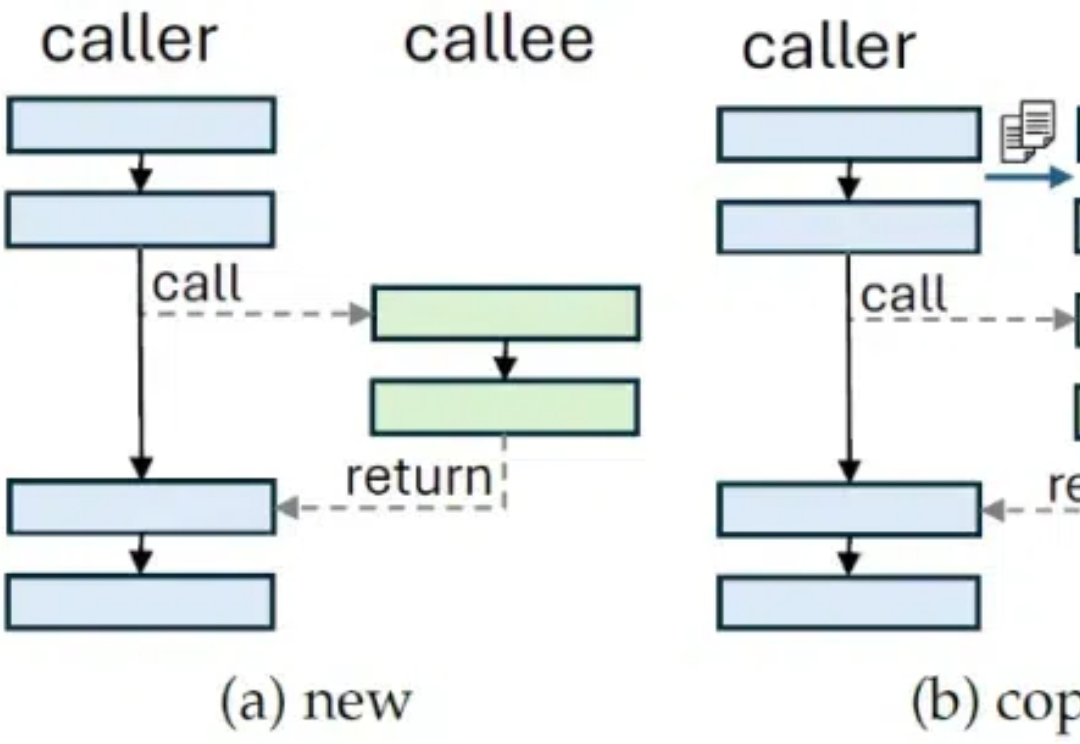

在当前大语言模型(LLM)的应用生态中,函数调用能力(Function Calling)已经成为一项不可或缺的核心能力。

通用语言模型率先起跑,但通用视觉模型似乎迟到了一步。究其原因,语言中蕴含大量序列信息,能做更深入的推理;而视觉模型的输入内容更加多元、复杂,输出的任务要求多种多样,需要对物体在时间、空间上的连续性有完善的感知,传统的学习方法数据量大、经济属性上也不理性...... 还没有一套统一的算法来解决计算机对空间信息的理解。

在人工智能快速发展的今天,大语言模型(LLM)已经成为改变世界的重要力量。然而,如何高效地编写、管理和维护提示词(Prompt)仍然是一个巨大的挑战。

距离ChatGPT发布刚好两年,ChatGPT发布的第三天我就尝试用过了,当时给我的感觉是虽然和过去的AI完全不一样,但距离真人还是有点差距的。

最近,Apollo Research团队发布了一项令人深思的研究。这项研究揭示了一个惊人的发现:当前主流的前沿AI模型已经具备了基本的"策划"(Scheming)能力。

开发AI应用的朋友们都有深刻的感受,在实际应用开发中,如何让LLM高效地使用外部工具,一直是困扰Prompt工程师的一个关键问题。最近,来自Faculty Science Ltd的研究团队提出的Language Hooks框架,为这个问题提供了一个令人耳目一新的解决方案。