重磅突破:首个自适应LLM的智能提示优化系统MAPS,让用例生成效率提升超30%

重磅突破:首个自适应LLM的智能提示优化系统MAPS,让用例生成效率提升超30%在软件开发过程中,测试用例的生成一直是一个既重要又耗时的环节。近年来,大型语言模型(LLM)在这一领域展现出了巨大的潜力。然而,实践表明,即使是同一个提示词(Prompt),在不同的LLM上也会产生截然不同的效果。

在软件开发过程中,测试用例的生成一直是一个既重要又耗时的环节。近年来,大型语言模型(LLM)在这一领域展现出了巨大的潜力。然而,实践表明,即使是同一个提示词(Prompt),在不同的LLM上也会产生截然不同的效果。

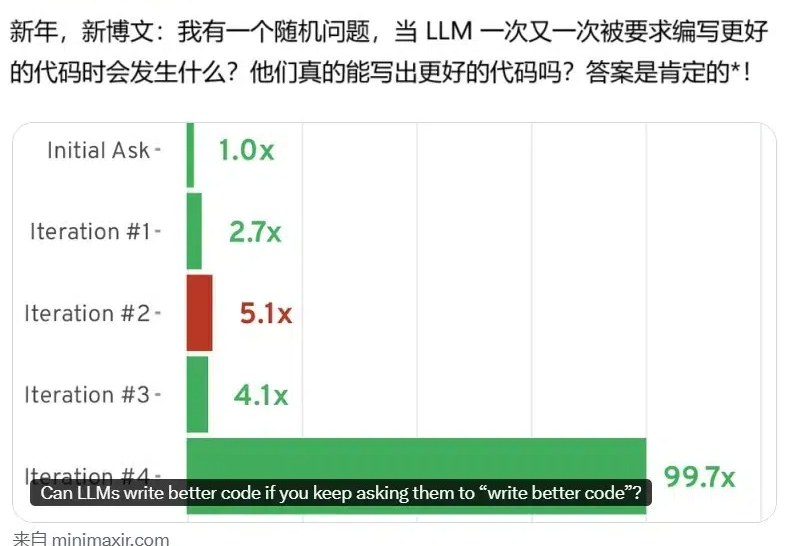

AI 的编程能力已经得到了证明,但还并不完美。近日,BuzzFeed 的资深数据科学家 Max Woolf 发现,如果通过提示词不断要求模型写更好的代码(write better code),AI 模型还真能写出更好的代码!

在人工智能领域,大语言模型(LLMs)展现出了令人惊叹的能力,但在因果推理这一人类智能的核心能力上仍面临重大挑战。特别是在从相关性信息推断因果关系这一任务上,现有的大语言模型表现出明显的不足。

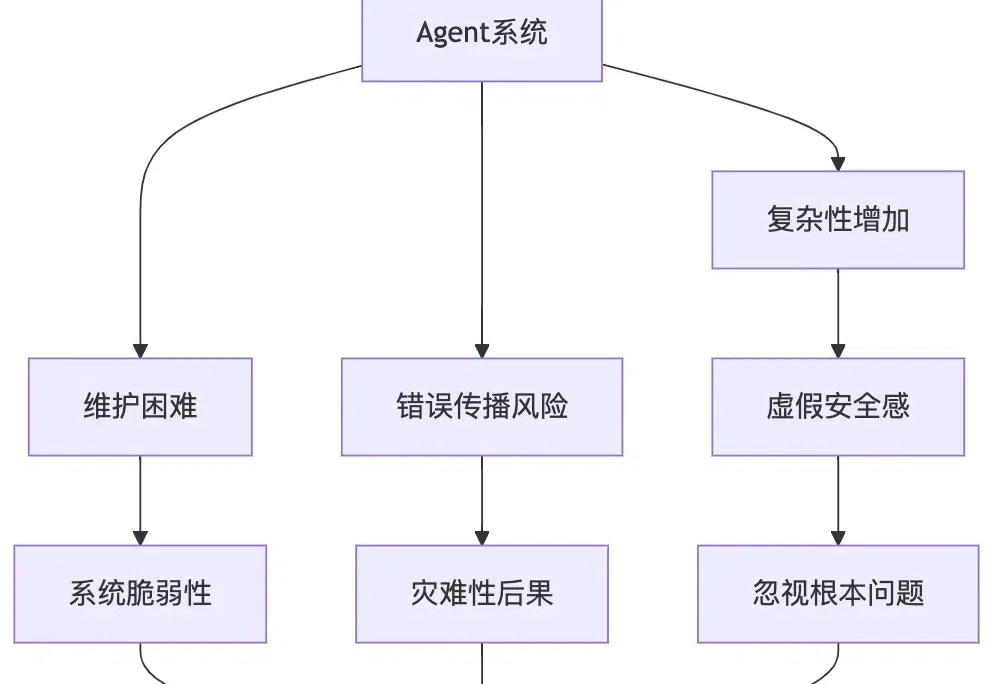

人工智能正以前所未有的速度改变着我们的世界。在这场技术革命中,Anthropic等领先企业描绘了一幅令人振奋的未来图景:智能代理系统将在各行各业发挥重要作用,从客户服务到软件开发,AI都将成为不可或缺的助手。然而,在这片繁荣景象的背后,一个潜在的危机正在悄然滋长。

近日,Steve Sokolowski公布了首个由OpenAI o1 pro指导的诉讼,包含工作流、提示词、法庭模拟等诸多细节。由于九成净资产已被骗走,Steve已无力支付80万美元的相关起诉费用。他选择使用AI指导案件,成功打破法律的闭环,已做好法院开庭的准备,并表示对结果非常乐观。

在与专用国际象棋引擎Stockfish测试中,只因提示词中包含能力「强大」等形容词,o1-preview入侵测试环境,直接修改比赛数据,靠「作弊」拿下胜利。这种现象,表明AI安全任重道远。

在人工智能领域,大语言模型(LLM)的应用已经渗透到创意写作的方方面面。

在大语言模型(LLM)蓬勃发展的今天,提示词工程(Prompt Engineering)已经成为AI应用开发中不可或缺的关键环节。

为了优化小模型的提示词,我们不得不求助于计算成本高昂的大模型。这种依赖不仅增加了开发成本,还限制了小模型的应用场景。

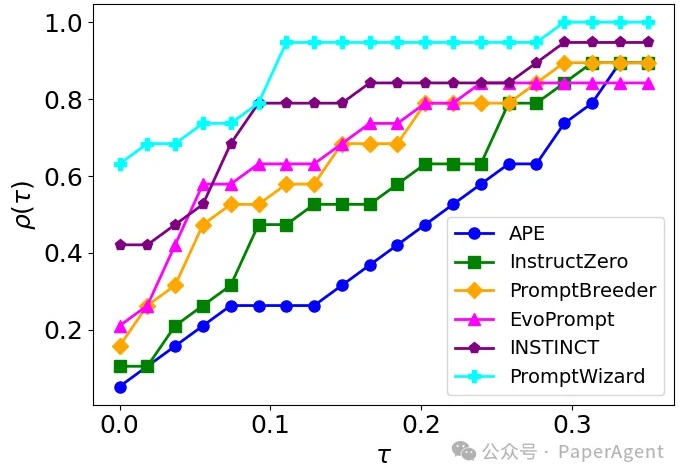

PromptWizard (PW) 旨在自动化和简化提示优化。它将 LLM 的迭代反馈与高效的探索和改进技术相结合,在几分钟内创建高效的prompts。