AAAI'26 Oral:小样本对齐人类认知,LLM不再模仿答案

AAAI'26 Oral:小样本对齐人类认知,LLM不再模仿答案GEM框架利用认知科学原理,从少量人类偏好中提取多维认知评估,让AI在极少标注下精准理解人类思维,提高了数据效率,在医疗等专业领域表现优异,为AI与人类偏好对齐提供新思路。

GEM框架利用认知科学原理,从少量人类偏好中提取多维认知评估,让AI在极少标注下精准理解人类思维,提高了数据效率,在医疗等专业领域表现优异,为AI与人类偏好对齐提供新思路。

近日,中国科学技术大学(USTC)联合新疆师范大学、中关村人工智能研究院、香港理工大学,在数据驱动的多功能双连通多尺度结构逆向设计领域取得重要突破。

现有AI记忆评测存在局限,如数据源单一、忽视变化本质、注入成本高等。CloneMem通过层次化生成框架构建合成人生,设计贴近真实场景的评测任务,涵盖多种问题类型。

由三位前 OpenAI 研究人员创立的初创公司 Applied Compute 正就以 13 亿美元估值筹集新资金进行谈判,包括该项投资在内。据透露,该公司致力于帮助企业使用自有数据定制模型。若融资成功,其估值将较不到三个月前公布的上一轮融资( 估值约 5 亿美元 )增长逾一倍。

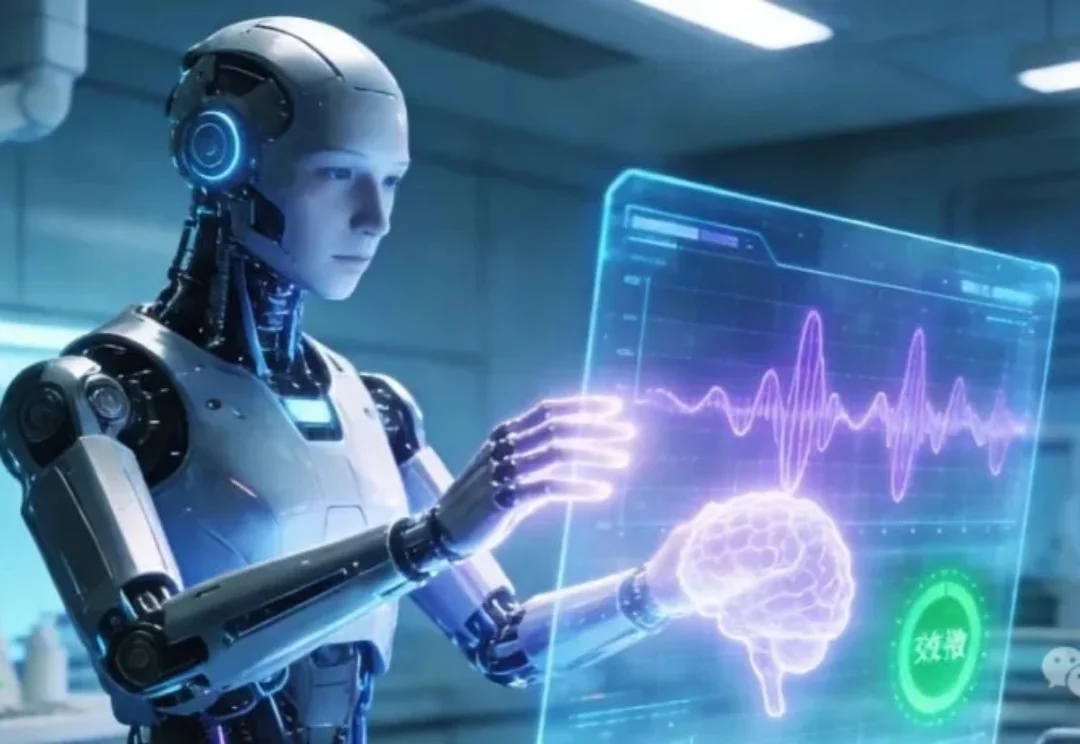

做后端、大数据、分布式存储的同学,大概率都遇到过这样的问题:

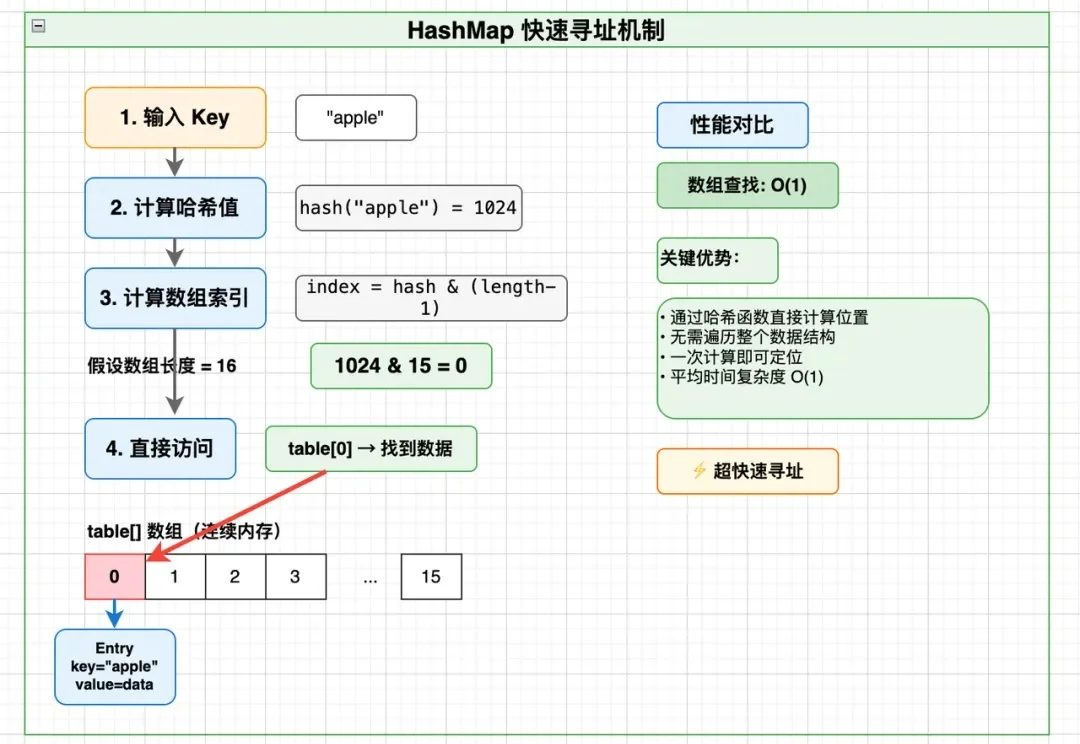

不知道有多少人曾为了让数据图表既“好看”又“好懂”,而在设计软件与代码编辑器之间反复横跳,熬到“头秃”。

数据库技术初创公司ClickHouse 在新一轮融资中筹集了 4 亿美元,公司估值达到 150 亿美元——比不到一年前的估值翻了一番以上。这笔大规模融资传递出投资者对人工智能应用支撑型企业的青睐信号,这类企业正与Databricks 和 Snowflake 等公司展开竞争。

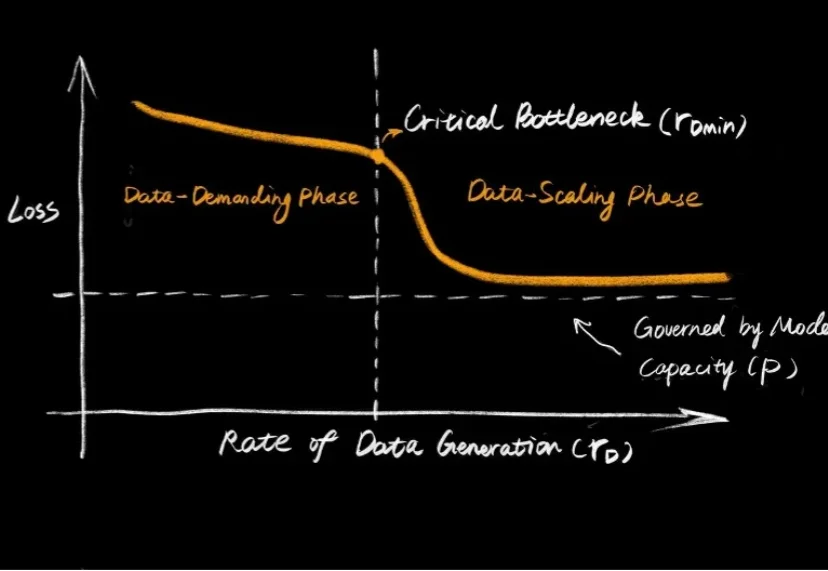

大语言模型的爆发,让大家见证了 Scaling Law 的威力:只要数据够多、算力够猛,智能似乎就会自动涌现。但在机器人领域,这个公式似乎失效了。

随着 AI 技术的蓬勃发展, AI 模型的参数规模和推理频次呈指数级增长。据高盛研究部预测,到 2030 年,全球数据中心的电力需求将增长 160%。

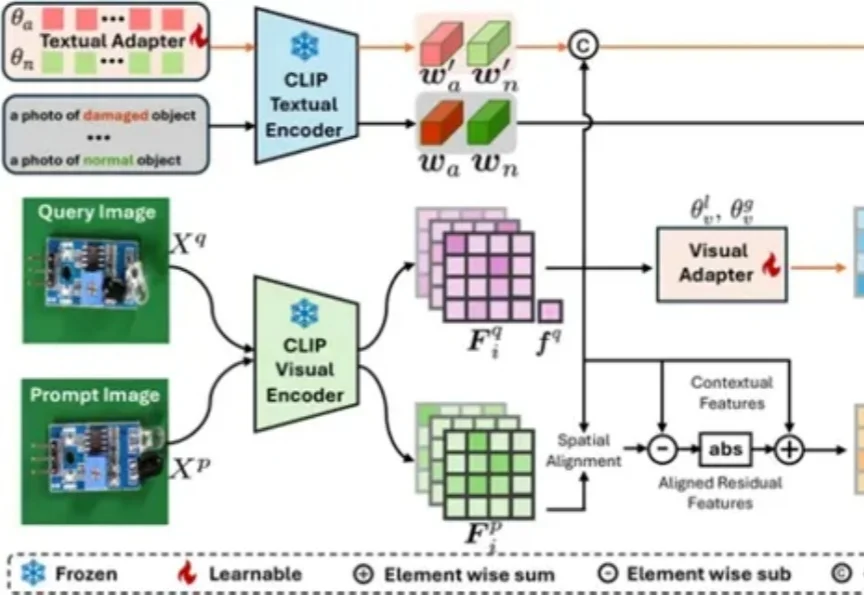

视觉模型用于工业“缺陷检测”等领域已经相对成熟,但当前普遍使用的传统模型在训练时对数据要求较高,需要大量的经过精细标注的数据才能训练出理想效果。