7B的DeepSeek蒸馏Qwen数学超o1!在测试时间强化学习,MIT积分题大赛考93分

7B的DeepSeek蒸馏Qwen数学超o1!在测试时间强化学习,MIT积分题大赛考93分见识过32B的QwQ追平671的DeepSeek R1后——刚刚,7B的DeepSeek蒸馏Qwen模型超越o1又是怎么一回事?新方法LADDER,通过递归问题分解实现AI模型的自我改进,同时不需要人工标注数据。

见识过32B的QwQ追平671的DeepSeek R1后——刚刚,7B的DeepSeek蒸馏Qwen模型超越o1又是怎么一回事?新方法LADDER,通过递归问题分解实现AI模型的自我改进,同时不需要人工标注数据。

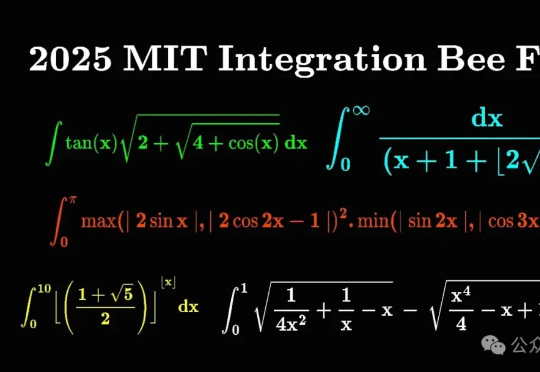

知名风险投资公司 Andreessen Horowitz (a16z) 周四刚刚发布了新报告。报告发现,ChatGPT 用了 9 个月的时间从 2023 年 11 月的每周 1 亿活跃用户增长到 2024 年 8 月的 2 亿,但现在该应用程序只用了不到六个月的时间就再次将这一数字翻了一番。

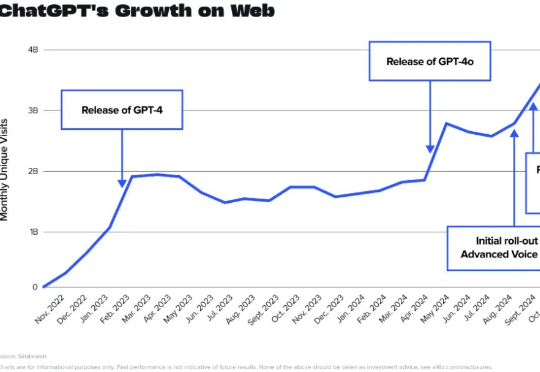

最近AI圈最炸的瓜,毫无疑问是——Manus!一个AI Agent,不仅能刷GAIA Benchmark,还能远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」。听起来确实很能打?但我们 CAMEL-AI的🦉OWL项目看完Manus视频,集体摊手:就这?0天复刻走起!

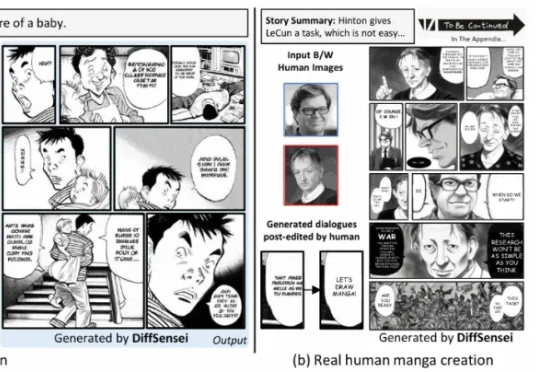

北京大学、上海人工智能实验室、南洋理工大学联合推出 DiffSensei,首个结合多模态大语言模型(MLLM)与扩散模型的定制化漫画生成框架。该框架通过创新的掩码交叉注意力机制与文本兼容的角色适配器,实现了对多角色外观、表情、动作的精确控制

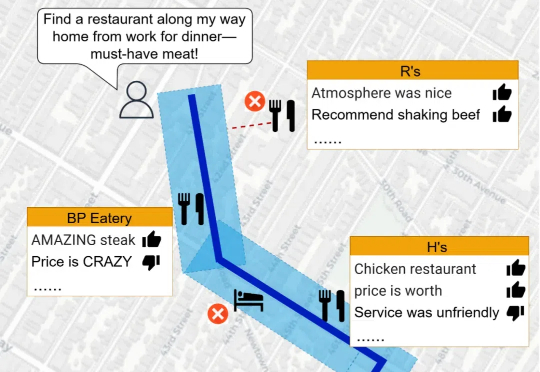

当涉及到空间推理任务时,LLMs 的表现却显得力不从心。空间推理不仅要求模型理解复杂的空间关系,还需要结合地理数据和语义信息,生成准确的回答。为了突破这一瓶颈,研究人员推出了 Spatial Retrieval-Augmented Generation (Spatial-RAG)—— 一个革命性的框架,旨在增强 LLMs 在空间推理任务中的能力。

智源联手多所顶尖高校发布的多模态向量模型BGE-VL,重塑了AI检索领域的游戏规则。它凭借独创的MegaPairs合成数据技术,在图文检索、组合图像检索等多项任务中,横扫各大基准刷新SOTA。

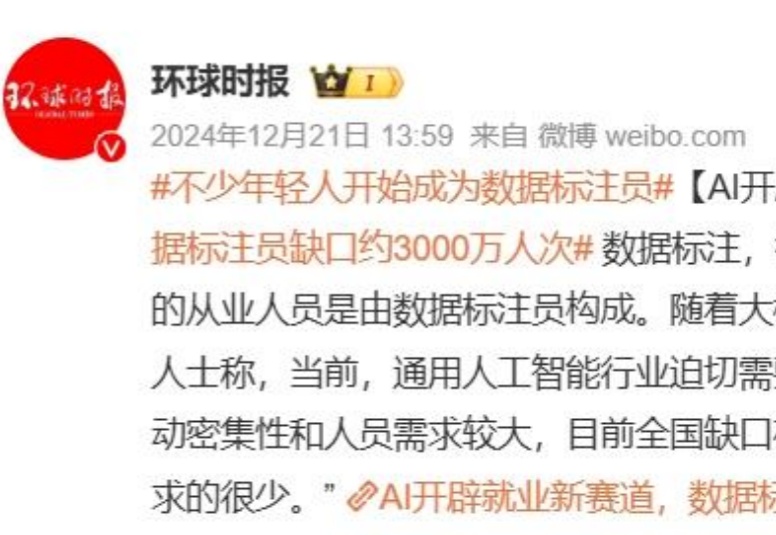

AI催生数据标注员,文科生转型与大厂调整。

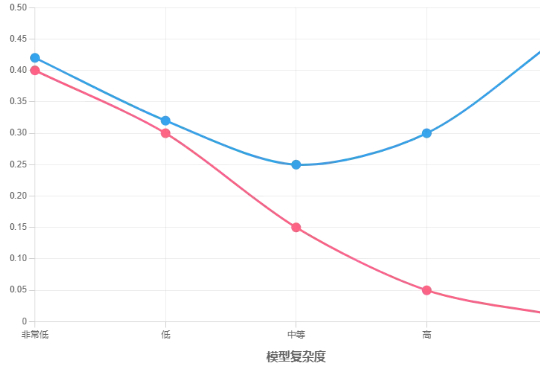

当模型复杂度增加到一定程度后,模型开始对训练数据中的噪声和异常值进行拟合,而不是仅仅学习数据中的真实模式。这导致模型在训练数据上表现得非常好,但在新的数据上表现不佳,因为新的数据中噪声和异常值的分布与训练数据不同。

新一代智能数据分析架构的开创者

本文提出了一种轨迹级别 SE (3) 等变的扩散策略(ET-SEED),通过将等变表示学习和扩散策略结合,使机器人能够在极少的示范数据下高效学习复杂操作技能,并能够泛化到不同物体姿态和环境中。