技术Blog-4 | 新一代InfLLM:可训练的稀疏注意力机制

技术Blog-4 | 新一代InfLLM:可训练的稀疏注意力机制本文深入剖析 MiniCPM4 采用的稀疏注意力结构 InfLLM v2。作为新一代基于 Transformer 架构的语言模型,MiniCPM4 在处理长序列时展现出令人瞩目的效率提升。传统Transformer的稠密注意力机制在面对长上下文时面临着计算开销迅速上升的趋势,这在实际应用中造成了难以逾越的性能瓶颈。

本文深入剖析 MiniCPM4 采用的稀疏注意力结构 InfLLM v2。作为新一代基于 Transformer 架构的语言模型,MiniCPM4 在处理长序列时展现出令人瞩目的效率提升。传统Transformer的稠密注意力机制在面对长上下文时面临着计算开销迅速上升的趋势,这在实际应用中造成了难以逾越的性能瓶颈。

昨天最热的的两篇文章是关于多智能体系统构建的讨论。 先是 Anthropic 发布了他们在深度搜索多智能体构建过程中的一些经验,具体:包括多智能体系统的优势、架构概览、提示工程与评估、智能体的有效评估等方面。

你有没有想过,为什么有些AI产品一上线就获得用户疯狂追捧,而另一些技术看起来更先进的产品却在市场上反响平平?为什么Cursor这样的AI代码编辑器能够席卷开发者社区,而许多功能更强大的AI工具却始终无法获得用户信任?

AI 决策的可靠性与安全性是其实际部署的核心挑战。当前智能体广泛依赖复杂的机器学习模型进行决策,但由于模型缺乏透明性,其决策过程往往难以被理解与验证,尤其在关键场景中,错误决策可能带来严重后果。因此,提升模型的可解释性成为迫切需求。

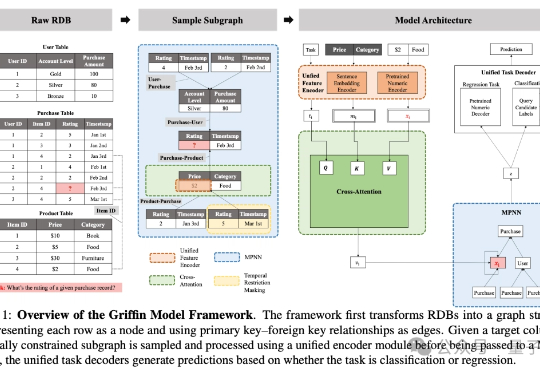

在企业系统和科学研究中普遍存在、结构复杂的关系型数据库(Relational DataBase, RDB)场景中,基础模型的探索仍处于早期阶段。

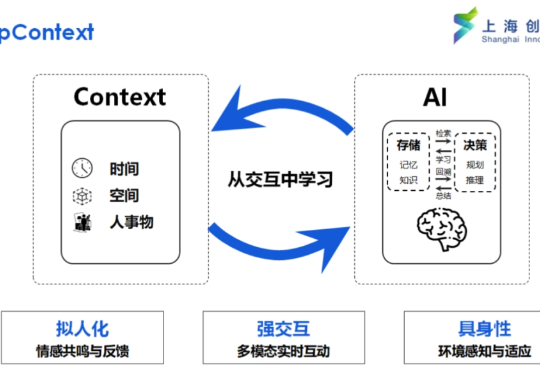

真正的智能在于理解任务的模糊与复杂,Context Scaling 是通向 AGI 的关键一步。

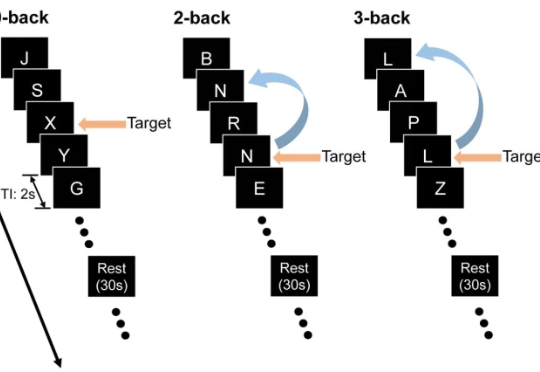

最近,来自约翰・霍普金斯大学与中国人民大学的团队设计了三套实验,专门把关键线索藏在上下文之外,逼模型「凭记忆」作答,从而检验它们是否真的在脑海里保留了信息。

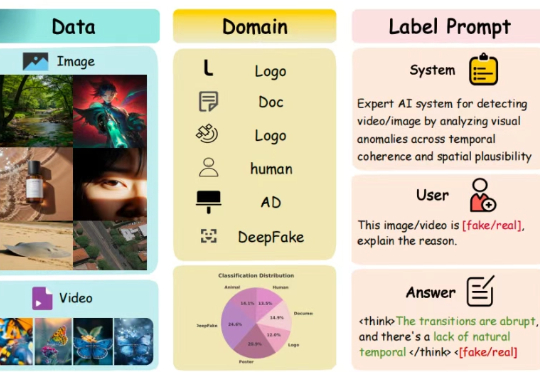

想象一下:你正在浏览社交媒体,看到一张震撼的图片或一段令人震撼的视频。它栩栩如生,细节丰富,让你不禁信以为真。但它究竟是真实记录,还是由顶尖 AI 精心炮制的「杰作」?如果一个 AI 工具告诉你这是「假的」,它能进一步解释理由吗?它能清晰指出图像中不合常理的光影,或是视频里一闪而过的时序破绽吗?

研究多智能体必读指南。Anthropic 发布了他们如何使用多个 Claude AI 智能体构建多智能体研究系统的精彩解释。

研究人员发现,大语言模型的遗忘并非简单的信息删除,而是可能隐藏在模型内部。通过构建表示空间分析工具,区分了可逆遗忘和不可逆遗忘,揭示了真正遗忘的本质是结构性的抹除,而非行为的抑制。