美国恐惧:冷战2.0将至,中国开源模型大爆炸临近!LeCun:DeepSeek只是卷王副产品

美国恐惧:冷战2.0将至,中国开源模型大爆炸临近!LeCun:DeepSeek只是卷王副产品如今,美国AI社区许多人已公认:接下来几个月,中国将会出现一波开源AI模型的浪潮!很多业内人士和大V干脆陷入了「冷战2.0」恐慌,呼吁要开放无限的能源、无限的算力和更简单的立法。LeCun则表示,DeepSeek击败美国,其实不过是中国内部竞争的副产品而已。

如今,美国AI社区许多人已公认:接下来几个月,中国将会出现一波开源AI模型的浪潮!很多业内人士和大V干脆陷入了「冷战2.0」恐慌,呼吁要开放无限的能源、无限的算力和更简单的立法。LeCun则表示,DeepSeek击败美国,其实不过是中国内部竞争的副产品而已。

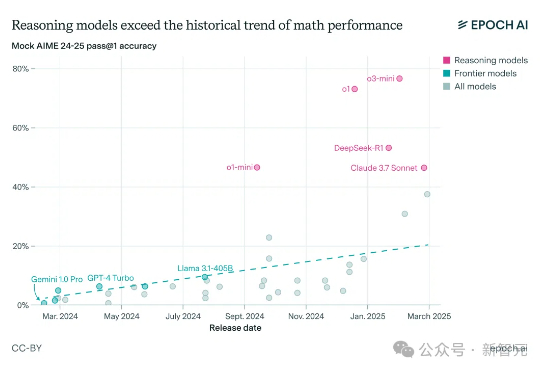

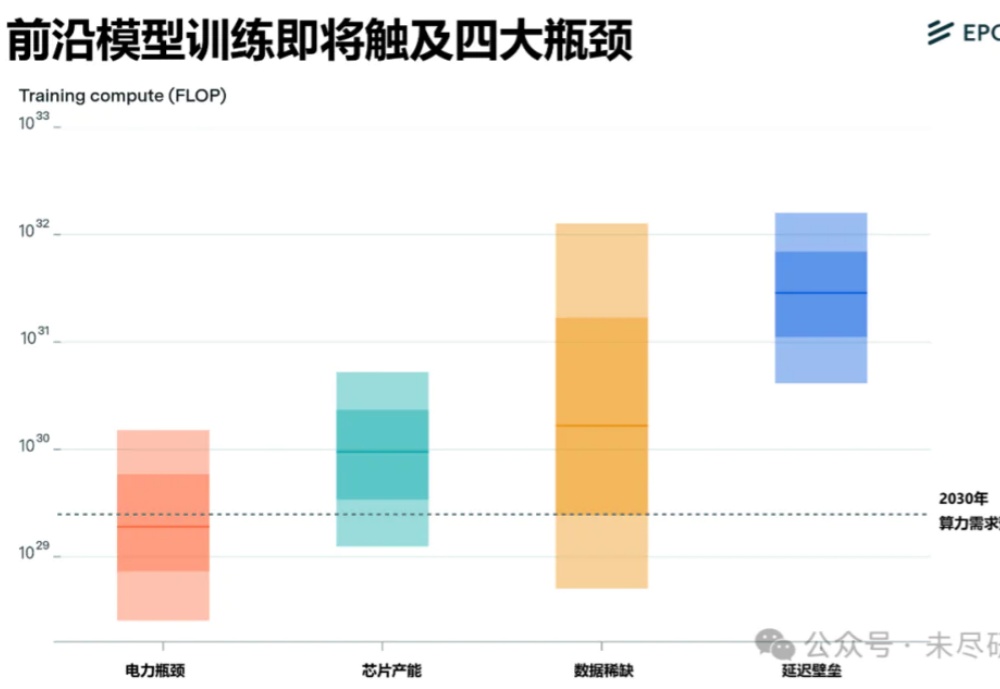

Epoch AI高级研究员预测:2030年实现人类水平的AI的可能性至少10%。他认为AI从监督学习到GenAI,模型范式转变迅捷,预测AI只能从第一性原理出发。参考人类大脑,他估算了发现人类水平的AI需要的算力,得到相关结论。

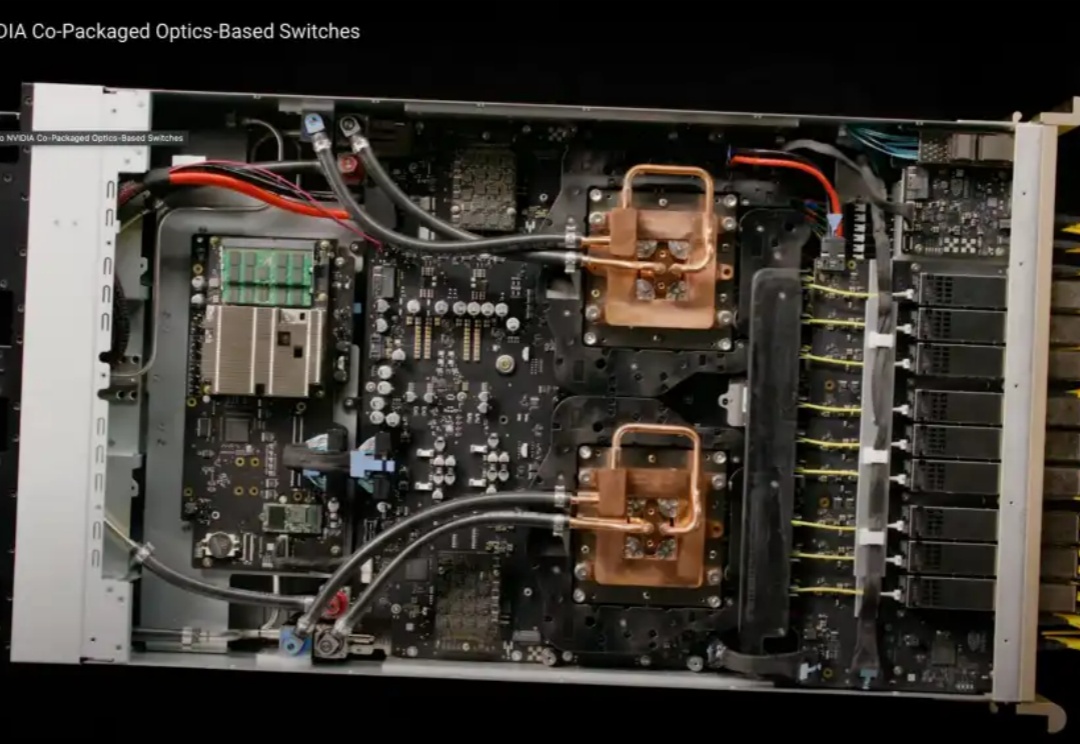

在GTC2025大会上,NVIDIA依旧延续着“算力的故事”。如果AI的发展依旧遵循着scaling law(规模定律),那么这个故事还能继续讲下去。

杰文斯悖论不是天然成立的。在AI的叙事中,要让算力用得越多,就要让算力变得更便宜,也要让AI更有用、好用。兑现杰文斯悖论已经成为了英伟达的命门,黄仁勋要在本届GTC上,让市场再次相信他。

ChatGPT等AI模型爆发式增长引发关键问题:这场AI革命需要消耗多少能源?本文探究数据中心在乡村地区的快速扩张,以弗吉尼亚州为例,揭示研究者如何通过供应链分析和直接测量两种方法估算AI能耗。

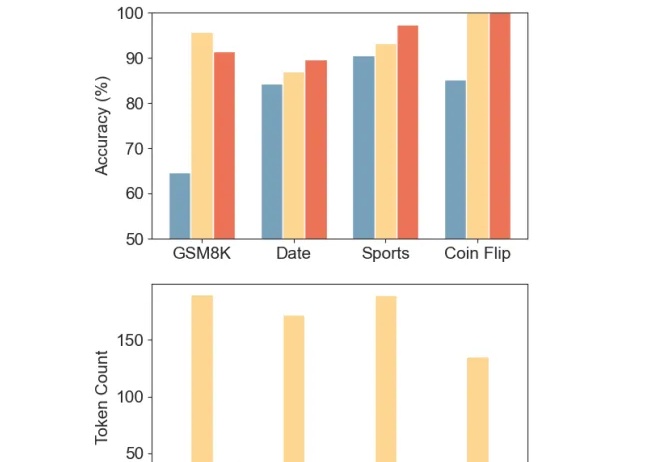

推理token减少80%-90%,准确率变化不大,某些任务还能增加。

如日中天的AI,在两会上稳稳占据C位。雷军的“终端标准”、周鸿祎的“安全即服务”、刘庆峰的“算力突围”、齐向东的“纵深防御”……这些大佬们的提案看似分散,实则暗藏一条清晰的主线:

大家好,很高兴在这里向各位介绍我们的产品 Free QWQ。这是世界上第一个完全免费、无限制、无需注册登录的分布式 AI 算力平台,基于 QwQ 32B 大语言模型提供强大的 AI 服务。

仅仅过了一天,阿里开源的新一代推理模型便能在个人设备上跑起来了!昨天深夜,阿里重磅开源了参数量 320 亿的全新推理模型 QwQ-32B,其性能足以比肩 6710 亿参数的 DeepSeek-R1 满血版。

人类实现AGI之前,在技术、商业、治理方面仍然存在诸多问题——“人与AI能否共处” “算力叙事是否依然奏效” “开源有多大商业价值”等,腾讯科技策划《AGI之路》系列直播,联合合作伙伴,特邀专家、学者直播解读相关议题,对齐AGI共识,探寻AGI可行之路。