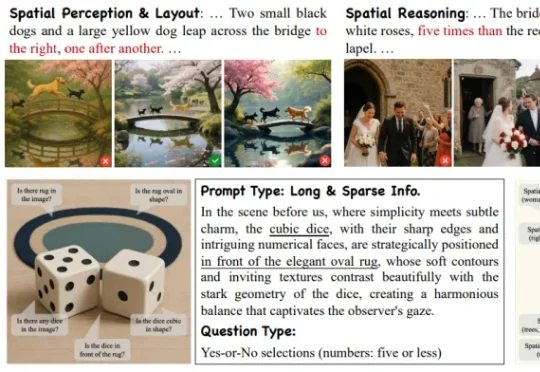

ICLR 2026 | 阿里高德发布SpatialGenEval,揭秘谁才是真正的文生图大师

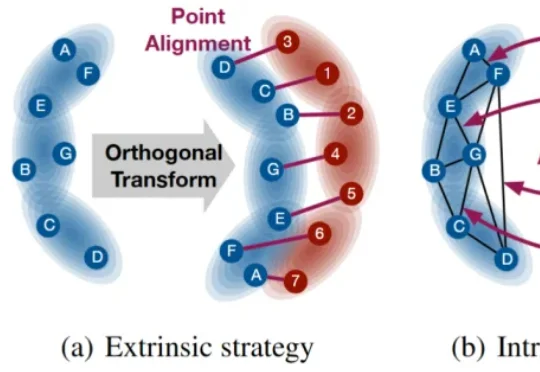

ICLR 2026 | 阿里高德发布SpatialGenEval,揭秘谁才是真正的文生图大师来自阿里高德的一篇最新 ICLR 2026 中稿论文《Everything in Its Place: Benchmarking Spatial Intelligence of Text-to-Image Models》提出了面向文生图空间智能的系统性评估基准 SpatialGenEval,旨在通过长文本、高信息密度的 T2I prompt 设计,以及围绕空间感知