四大巨头的AI绘图模型综合评测 - 写在Meta Imagine上线后

四大巨头的AI绘图模型综合评测 - 写在Meta Imagine上线后AI绘图作为跟大语言模型并驾齐驱的最成熟的模态之一。

AI绘图作为跟大语言模型并驾齐驱的最成熟的模态之一。

LAMM (Language-Assisted Multi-Modal) 旨在建设面向开源学术社区的多模态指令微调及评测框架,其包括了高度优化的训练框架、全面的评测体系,支持多种视觉模态。

人话科普ChatGPT和大语言模型。全世界都在讨论ChatGPT,你却搞不懂?

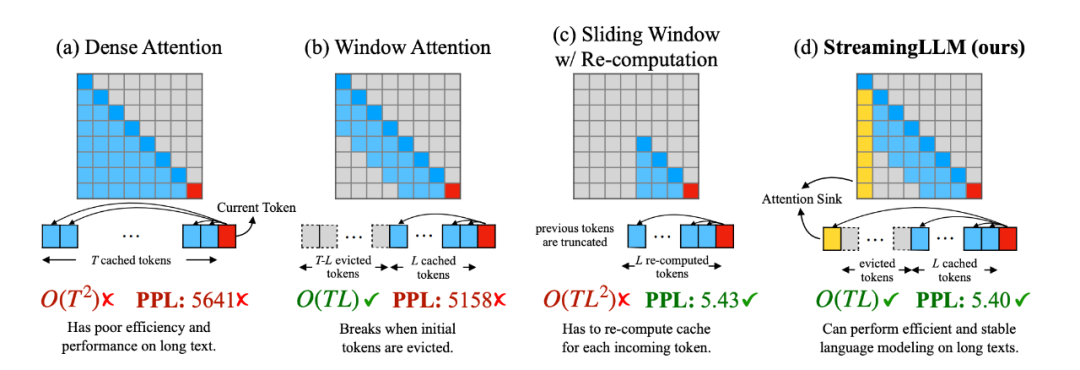

在大型语言模型(LLM)的世界中,处理多轮对话一直是一个挑战。前不久麻省理工 Guangxuan Xiao 等人推出的 StreamingLLM,能够在不牺牲推理速度和生成效果的前提下,可实现多轮对话总共 400 万个 token 的流式输入,22.2 倍的推理速度提升。

语言模型究竟是如何感知时间的?如何利用语言模型对时间的感知来更好地控制输出甚至了解我们的大脑?最近,来自华盛顿大学和艾伦人工智能研究所的一项研究提供了一些见解。

起底大模型捧红的23家独角兽,大语言模型、垂直行业应用狂吸金。生成式AI这把火在资本市场越烧越旺。

2023 年是当之无愧的「AI+大模型」之年,以 ChatGPT 为代表的生成式 AI 的神速进展,让人们甚至认为大语言模型已经有资格被称作「世界模型」——人工智能从未像今天这样离「神性」如此接近。

作者重点关注了基于 Transformer 的 LLM 模型体系结构在从预训练到推理的所有阶段中优化长上下文能力的进展。

大型语言模型(LLM)虽然在诸多下游任务上展现出卓越的能力,但其实际应用还存在一些问题。其中,LLM 的「幻觉(hallucination)」问题是一个重要缺陷。

华为盘古系列,带来架构层面上新!量子位获悉,华为诺亚方舟实验室等联合推出新型大语言模型架构:盘古-π。