我们正经历一场前所未有的智能跃迁。人工智能带来的,远不止于技术革新,更是一场深刻重塑人类认知、教育与生存方式的范式转移。

这场跃迁的关键,不在于技术会走多远,而在于——人类如何重新认识自我。当知识不再稀缺,学习的意义何在?当智能无处不在,智慧的栖身之所又在何处?当工具变成智能体,人的核心价值又该如何彰显?

大模型的新前沿

人类天才的养成,取决于两个重要因素的共同作用:一个是先天的优秀基因和充足的营养,这决定了一个人智力发展的下限;另一个是后天的精心培养和优质的教育资源,这可以充分释放和发展潜能,最终触达基因决定的上限。只有在先天基因和后天教育的完美结合之下,天才才有可能诞生。同样的道理也适用于大语言模型的训练。模型要实现真正的智能,首先需要具备超大规模的神经网络结构(基因)、海量的数据以及充沛的计算资源(营养),它们决定了大模型能够达到的上限。

GPT-3,虽然有优秀的基因和充足的营养,但它还不具有真正的智能,需要经过精致的教育训练,就像天才需要优秀的教育来激发潜能一样。精心设计的提示词让它理解语言的深层含义,RLHF让它以人类认同与满意为导向优化输出,价值对齐确保它的行为符合人类的价值观。正是在这种类似天才养成的“先天基因”与“后天教育”的协同作用下,ChatGPT才真正炼成,并迈出通向AGI的第一步。

ChatGPT一出道即巅峰——它于2022年11月30日正式上线,仅用不到两个月的时间月活跃用户数就达到了1亿,创下了当时消费级应用用户增长速度的新纪录。相比之下,TikTok(抖音海外版)用了约9个月,Instagram(照片墙)用了2.5年,WhatsApp(网络信使)用了3.5年,脸书用了4.5年,推特则用了5年。但是,ChatGPT最多只能被称为“AGI的火花”,还有很大的提升空间。于是,研究人员分别从“基因”和“教育”两个方面对它进行了提升:混合专家系统(mixture of experts,MoE)和思维链(chain of thoughts,CoT)。

未来的GPT:尼安德特人vs智人

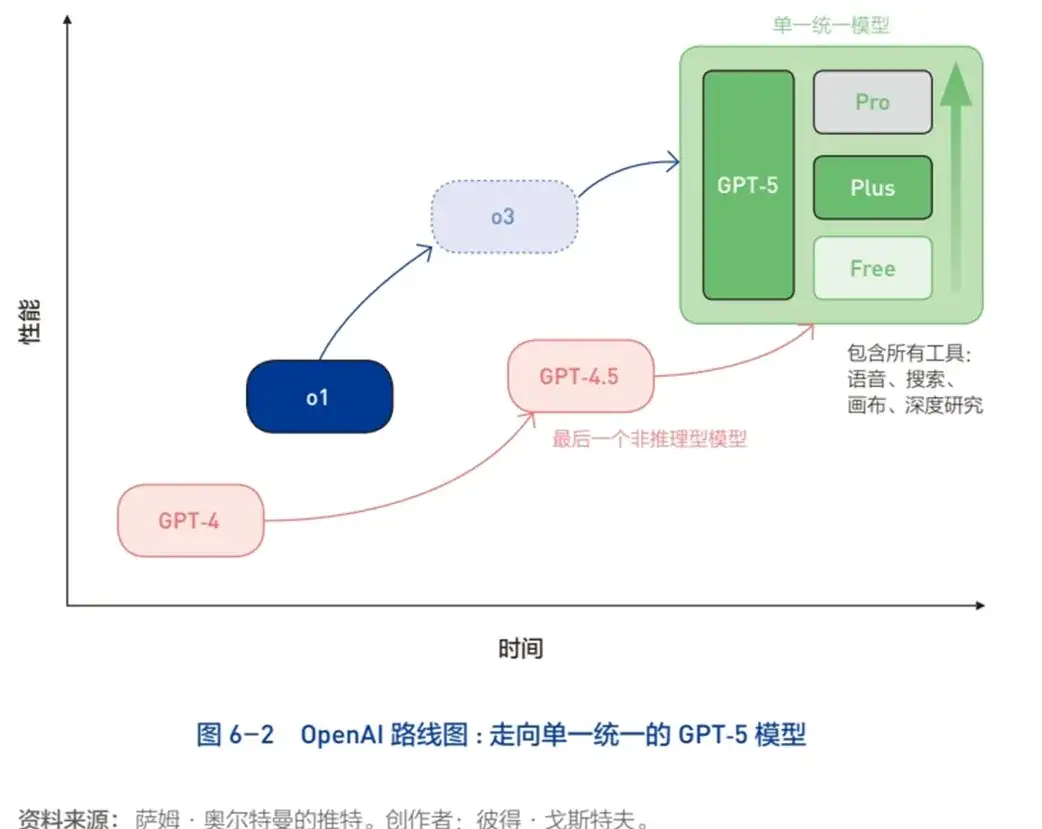

2025年2月27日,OpenAI发布了GPT-4的升级版——GPT-4.5。GPT-4.5的内部代号是Orion(猎户座,是天空中最容易识别的星座,包含两颗最亮的恒星参宿七和参宿四)。它的确切参数量未公开,但据猜测,这款被OpenAI首席执行官萨姆·奥尔特曼用“巨大、昂贵”描述的大模型,其参数量应该超过GPT-4的1.8万亿个。它在理解用户意图方面表现出色,特别适合需要创造力和共情的任务。用户在使用GPT-4.5后,称它为“文科生”的最高峰,甚至认为它“已经接近AGI”。但是,巅峰即终点,OpenAI同时也宣称GPT-4.5是最后一个非推理型对话大模型(见图6-2)。

要想理解这一点,必须回顾大模型的双轨进化路线:对话型与推理型。

从2018年GPT的诞生到2025年的GPT-4.5,大模型的发展主要是通过增加计算量和数据量提升性能,这就是传统的“无监督学习扩展”的路线。GPT-4.5是这一路线的最新成果,同时也将是这条路线的终点。

2023年,OpenAI开辟了一条全新的进化路线——基于思维链的推理大模型,如o1、o3系列。这些模型不是简单地扩大规模,而是专注于提升推理能力,能够更深入地思考问题。

当然这两条路线并非对立,而是高度相辅相成的。OpenAI首席研究官马克·陈在接受关于GPT-4.5的访谈中强调:“你需要知识作为基础,才能在上面构建推理能力。模型不可能从零开始学习推理。同时,推理模型可以生成更优质的数据,反过来提升基础模型的能力。”

但是,只有当大模型具有真正的推理能力,才能摆脱模式识别的局限,才能摆脱鹦鹉学舌的质疑。从对话大模型的终结到推理大模型的启程,GPT模型正逐步从一个“智能的模仿者”,演化为一个具有推理和思考潜力的“新物种”。

这让我不由想起了在2万~4万年前,尼安德特人被人类的祖先——现代智人彻底取代,并逐渐灭绝。

尼安德特人的大脑容量平均为1500毫升,个别甚至接近1700毫升;现代智人的平均脑容量接近1500毫升,通常在1200~1600毫升之间。从数据看,尼安德特人的大脑总体上比现代智人略大。但是,这并不意味着它的认知能力更高,因为智商高低取决于脑组织结构和连接方式的精细程度。尤其根据颅骨化石的解剖学分析,尼安德特人的前额叶区域相对较平坦,比现代智人的前额叶略小或者结构不够精细。而这,正是“慢思维”的神经中枢之一。

因此,在尼安德特人灭绝的众多假说中,其推理和认知能力的劣势被认为是最重要的原因。首先,现代智人在面对复杂问题时,能进行更有效的逻辑推理、工具创新、战术规划、群体协调,更适应环境变化;而尼安德特人可能更倾向于本能反应,即“快思维”,因此在复杂长期规划、策略制定方面的能力较弱。例如,尼安德特人使用的工具多为简单石器,很少出现复杂工具或创新工具,现代智人则创造了丰富且精细化的工具组合,如鱼叉、投掷工具和陷阱,体现出更为强大的生成式发明能力。

其次,尼安德特人缺乏战略思维,而现代智人在狩猎、迁徙和资源获取方面,善于利用推理和抽象思考制订方案和规划未来。再次,现代智人凭借复杂语言与抽象沟通方式,不仅更容易在群体间快速传播新知识、新技术,还能以此为纽带,连接非血缘关系的个体而构建更大的社群,而尼安德特人缺乏高效的知识传递能力,使他们在技术创新和文化发展上停滞不前,而且群体也局限在血缘关系之内。最后,尼安德特人的抽象符号与象征思维能力不足,只能创造出简单的艺术品和粗糙的洞穴壁画,现代智人则创造了更复杂、更丰富的文化艺术作品。

曾经统治地球的尼安德特人,拥有更强壮的臂膀和更大的脑容量,却无法迈过认知的鸿沟,最终让位于前额叶更为精妙的现代智人。今天,历史的帷幕又一次悄然落下,一个看似庞大却终究落后的物种正缓缓谢幕。对话型大模型最后的王者GPT-4.5,纵然博览群书,记忆力惊人,却始终无法挣脱模式识别的桎梏。一个旧时代在它的巅峰之际悄然画下句点,GPT-o3则以推理和理解为灵魂开启新的智慧纪元。所以,进化从不在于强大,而在于对世界更深刻的感知与理解。这才是智能的本质,也是进化的真正目标。

或许多年后回顾大模型的发展,2024年推理型模型的诞生,犹如30万年前智人而不是250万年前能人的出现,被铭记为新智慧时代的开端。

像大模型一样进化

大模型的成功并非偶然——从早期符号主义AI的失败,到深度学习的崛起,再到Transformer的成功,每一次进化都是从无数被淘汰的算法、模型中艰难诞生。在这艰难曲折的探索中,人类智慧的金块无疑是AI头上的一盏明灯。反过来,大模型的进化经验,能否成为我们人类认知进化的营养?由此,我们破茧成蝶,与AI时代同频共振,开启认知与智慧的跃迁。

为人生定义目标函数

所有的机器学习,在开始训练前,都必须明确一个目标函数(又称损失函数或成本函数)。这个函数定义了模型希望达到的理想状态,而训练的全部意义就在于不断优化参数,让模型越来越接近这个目标。正所谓学习未动,目标先行。

作为机器学习的一个分支,人工神经网络从一开始就是另类,因为它的目标函数太宏大、太有野心,以至于当辛顿请求其所在的多伦多大学校长再招收一名人工神经网络的研究者时,该校长是如此回答的:“一个疯子就足够了。”的确,人工神经网络的开创者都有一个在外人眼里近似疯狂的目标函数:1943年麦卡洛克和皮茨提出的“简陋”神经元是要模拟“神经活动内在观念的逻辑演算”,1958年罗森布拉特提出的第一个真正意义上的人工神经网络——感知机,是要模拟“大脑信息存储和组织”。OpenAI训练GPT的目标函数,就是要用一个巨大的神经网络去容纳所有的人类知识,从而实现AGI。

虽然疯狂却是唯一可行之路。GPT-4把几乎全部的人类知识压缩进了1.8万亿个参数,在通用认知任务上的表现卓越,从此AGI不再是科幻且遥不可及的。人工神经网络宏大的目标函数的背后是规模化法则:参数规模越大,优化空间越广,最终实现目标的可能性越大。

人类学习也遵循同样的道理,如果我们把目标函数设定为短期、狭隘的目标,如考取某个证书、通过某次考试,那么这个目标函数的确容易实现。但是,我们得到的只是一个线性模型,目标只要稍微复杂一点、稍微变化一点,这个线性模型就再无用武之地。这在机器学习中也被称为“局部最优”陷阱。当一个模型陷入局部最优的舒适区,就不再演化,最终错过了更广阔、更深远的优化空间以抵达“全局最优”。同样,人生的发展也会出现局部最优——在人生某个阶段取得了看似不错的成就,实际上却限制了后续的发展空间。所以,短期看是目标达成,长期看则是机会丧失。

人本主义心理学家亚伯拉罕·马斯洛曾经问他的学生:“你们当中,谁将成为伟大的领导者?”学生只是红着脸,咯咯地笑,不安地蠕动。马斯洛又问:“你们当中,谁计划写一本伟大的心理学著作?”学生结结巴巴地搪塞过去。马斯洛最后问道:“你们难道不想成为一个心理学家吗?”这时,所有学生都回答“想”。这时,马斯洛说道:“难道你们想成为平庸的心理学家?这有什么好处,这不是自我实现。”

马斯洛解释道,我们其实不仅仅害怕失败,也害怕成功。在这现象的背后,是与自尊纠缠在一起的自卑:我们对伟大的人和事物都有一种敬畏感——在面对他们时,会感到不安、焦虑、慌乱、嫉妒甚至敌意,因为他们会让我们产生自惭形秽的卑微感。于是,当我们试图获得荣誉、成功、幸福等美好的事物时,还未行动,我们却产生了“这是真的吗”“我不行”“我不配”的自我质疑,因为陌生的阳光如同黑暗一样可怕。

萨姆·奥尔特曼在一次接受采访时,回忆起刚创业时遭到的嘲讽:“回想起来,一件非常成功的事情是,我们从一开始就确定了AGI的目标,而当时在业内,你甚至不能谈论这个目标,因为它听起来太疯狂了,近乎痴人说梦。所以这立即引起了苏茨克维的注意,也吸引了所有优秀年轻人的注意,当然,也引来了不少前辈的嘲笑。不知何故,我觉得这是一个好兆头,它预示着某种强大的力量。我们当时是一群乌合之众,我的年龄是最大的,大概30岁,所以当时大家觉得我们这群不负责任的年轻人什么都不懂,净说些不切实际的话。但那些真正感兴趣的人会说,‘让我们放手一搏吧!’”

这就是OpenAI的目标函数,所以才有今日之OpenAI。

▷图源:Maria Who

作为个人,我们的目标函数应该是什么?在我看来,那就是构建属于我们自己的、特立独行的“个人知识体系”。我们的知识体系是我们认知世界的“眼睛”,正如色盲者无法正确分辨这个世界的颜色,而一个知识体系有缺陷的人不可能触摸到这个世界的本质。进入AGI时代,个人知识体系的重要性被无限放大,这是因为AI正在逐渐接管那些标准化、结构化的信息处理任务,而唯有那些真正基于深层理解、价值判断和创造性思维的能力,才属于人的不可替代的能力。而这些能力,恰恰植根于独特的个人知识体系之中。所以,不断拥抱新的经验、新的知识,更新推理思维链,打破认知边界,都是在构建一个能与世界深度对话、与自我持续共鸣的个人知识体系。

“兰叶春葳蕤,桂华秋皎洁。欣欣此生意,自尔为佳节。”马斯洛说,这才是“奔放的人生”,而不是“枯萎的人生”,因为“如果你总是想方设法掩盖自己本有的光辉,那么你的未来注定暗淡无光”。

使用随机梯度下降优化人生

在机器学习中,随机梯度下降(stochastic gradient descent,SGD)是被广泛使用的优化算法之一。其原理简单而高效:每一步都在当前的位置基础上,找到一个大致正确的方向,然后往那个方向迈进一小步。而这个大致正确的方向,来自当前的误差——算法通过不断迭代调整模型参数,沿着矫正误差最陡梯度前进,逐步找到使损失函数最小的参数值。所以,正是因为存在误差,我们才能判断前进的方向。

在大模型的预训练过程中,输入的数据首先被表示为一系列的token,这些token逐层穿过神经网络的各个隐藏层,并最终在输出层生成下一个token的预测值。模型根据上下文生成的预测值与实际语料中的真实token之间往往存在一定差异,这个差异就是模型的预测误差(error),具体可表示为误差函数:error=diff(预测值=实际值)。大模型正是利用这个误差信息进行学习,通过反向传播算法将误差逐层传递回网络中的每个神经元,以确定每个参数的优化方向与幅度,再使用随机梯度下降等优化算法,逐步调整和更新网络的权重参数,以持续减小损失函数的数值,提升模型预测的准确性。

由此,大模型的学习过程就构成了一个不断循环的优化流程:预测下一个token→计算误差→反向传播误差→利用梯度下降优化参数→更新模型权重→预测下一个token。大模型的所有知识和能力,便是通过反复地执行上述循环、不断根据误差进行参数调整而逐渐获得的。

大模型只能从错误中学习,人也不例外。这是因为梯度下降的优化算法与大脑的预测编码(predictive coding)机制有异曲同工之妙。预测编码理论认为,大脑是一个主动预测外部世界的系统,它不断根据已有的经验形成预测,随后将这些预测与现实中接收到的信息进行对比。当预测与实际感知之间出现差异时,大脑就会产生误差信号(predition error)。这种误差信号会激活大脑中与奖赏和纠错机制相关的多巴胺系统,从而重塑大脑神经元之间的连接。

换句话说,错误为大脑提供了一种清晰的、明确的反馈信号,帮助我们快速地发现原有知识或方法的不足,迫使我们重新审视自己原有的信念或行为模式,并尝试新的、更加准确的做法。与之相反,当我们的预测正确、表现良好时,大脑获得的反馈信号是弱而模糊的。所以成功的体验非常美好而错误让人痛苦,但是我们的成长来源于如何应对、修正错误,因为错误本质上并非失败,而是一种推动我们持续更新认知结构、增强适应能力的动力源泉。

但是,人是追求奖励、逃避惩罚的动物,“少犯错、不犯错”是我们所接受的教育的核心,所以主动试错对我们而言是知易行难。随机梯度下降则为此提供了解决之道。

随机梯度下降的核心魅力之一,在于它能从不确定中找到确定性——目标函数清晰,但是通向目标函数的路径不确定。也就是说,我们不要执着于精确地规划未来的每一步,因为这样反而可能陷入过度分析而迟迟无法行动。我们需要做的,就是“强行起飞,粗糙开始,空中加油”——找一个大致正确的方向(梯度),然后向前走一步(下降)。不必在乎当下的这一步是否最优,做时间的朋友,能多走几步就多走几步。

因为对于梯度下降这件事,起点不重要,终点才重要。起点都是初始化的随机参数,众生平等;终点则是损失函数的能量最小值。所以,家境是否优渥不重要,是不是名牌大学毕业不重要,年龄太大也不重要,因为这些都只是起点,或者最多只能算是“中点”而非终点。梯度下降算法能保证的是:不管起点在哪里,最后得到的解都差不多,当然前提是一直按照梯度的方向走下去。所以,坚持走。

然后,四处走走(随机),因为每一个方向都是你对世界的新认识。包容性和灵活性是随机梯度下降的核心魅力之二。如果只是沿着熟悉的道路前进,虽然容易并且安全,却可能会让你陷入认知的局部最优陷阱——你以为自己已经理解了整个世界,实则只是固守在一个狭窄的角落。

正如随机梯度下降强调随机抽样是为了避免陷入局部最优,人生也需要随机性的探索,这样才能发现没有见过的风景。阅读陌生领域的书籍,与不熟悉的人交谈,尝试未知的可能性,正是利用了随机性带来的认知增益。它引领我们遇到新的误差、新的意外,并因此而激发新的学习过程,推动认知结构的重新构建。正是在随机探索中,我们不断修正对世界的理解,逐渐接近真实。随机,不仅是算法优化的策略,更是我们深入认识世界、走向自我更新的重要方法。

▷图源:Alena Shuvalova

奥尔特曼曾经谈到他的一次“四处走走”:

我在26岁时卖掉了我的初创公司,然后中间空了一年。在那个年代,在硅谷这是很难想象的行为,因为那是一个根据你的职位和你所做的事确定社会地位的地方。但是如果你真的可以在两份工作之间空出一年,我是非常推荐的,我甚至觉得这是我职业生涯里做得最对的事情。在那一年里,我读了很多书,在很多感兴趣的领域有所涉猎……我学到了核工程知识;AI时代开始了,我学习了关于AI的理论;我学习了生物制造的相关知识。……我到很多地方旅行,从某种程度上讲,我感受到了这个世界其他部分真实的样子,我见了从事各行各业的人,并与之交谈……我有充足的时间,所以如果我遇到了有意思的看起来不错又需要帮助的人,我会帮助他们……我没有安排自己的时间表,所以我可以立刻飞到其他国家参加会议。我开始做这些随机的事情。几乎所有的事情都没有开花结果,但是对之后事情产生深远影响的种子已经种下了。

这个种子,最终发芽成长为OpenAI。

人生所需不过一份注意

GPT的T,指的是Transformer,其最核心、最精妙之处就是“注意力机制”。它会对一段文本中每个词语与其他所有词语之间的关系进行评估,计算出它们之间的关联强弱程度,从而捕捉信息之间的相互关系,以实现高效而精准的信息处理。所以,学习的本质也是注意力分配的艺术。

我们所处的世界彼此相连,而非孤立随机。在物理层面,世界由物质和能量组成,它们之间不断地相互作用,形成复杂而稳定的秩序。在生命层面,物种之间通过复杂的生态网络连接起来,生态链中每个环节互依互存,任何个体的变化都可能引发连锁反应。在人文社会层面,每个人看似独立,但无时无刻不在通过沟通、情感联结与社会网络交织在一起。文明的存续与演化,来源于人与人之间频繁而有序的互动。英国诗人约翰·多恩说:“没有人是一座孤岛,可以自全……任何人的死亡都是我的损失,因为我是人类的一员,因此不要问丧钟为谁而鸣,它就为你而鸣。”美国行为科学家阿莫斯·特沃斯基也说:“人不复杂,复杂的是人与人之间的关系。”

应当如何分配注意力来认识我们所在的这个世界呢?

第一,注意高质量的数据和人。在机器学习领域,有一个广为人知的第一性原理:“垃圾输入,垃圾输出。”再多的参数,再强大的算力,如果输入的数据质量低下,最终训练出来的大模型也必然表现糟糕。所以,OpenAI在训练初期便严格把控数据质量,选用了维基百科、经典书籍、科研论文、优秀代码和高质量互联网内容作为注意力处理的信息。这些精心挑选的材料构成了GPT的认知基座。

截至2024年6月,我国短视频用户数量达到10.5亿,占整体网民的95.5%,人均每天观看时长约151分钟。而阅读用户只有短视频用户的一半,人均每天阅读时长只有23分钟。AI在学习,人类却在沉迷。

真正与注意力门当户对的是高质量的数据集和人。在进入某个领域前,首先精心构建你的数据集:谁是这个领域的权威,哪些书、线上课程是这个领域的经典,哪些工具能让这个领域的抽象知识变得具象清晰?之后,阅读入门材料快速建立对这个领域的基本认知;接下来,对经典或权威的书籍或教材进行深度学习,建立完善的知识框架;最后,通过专业研究文献并与专家或AI互动交流,拓宽和深化自己的认知边界。

第二,注意实例而非规则。符号主义给AI以规则:“如果一个动物有尖尖的耳朵,胡须明显,并且眼睛在夜间能反光,那么它是猫。”这时,狐狸、猞猁、浣熊和狼也会被符号主义AI识别成猫。而联结主义只给AI猫的图片,各种各样猫的图片,让注意力在海量的数据中主动探寻其中蕴含的模式和规律。

前者是授人以鱼——人类先提取特征,然后把特征喂给AI,即人类向AI输入人类学习的结果,AI只需要记忆,正所谓前面有多少智能,背后就有多少人工。后者是授人以渔——没有工程师总结的规则,只有精心挑选的实例,让神经网络自己学习,让它自己去充分挖掘全部可能,因为“足够大的神经网络当然无所不能”(计算软件Mathematica的创造者史蒂芬·沃尔弗拉姆语)。学会放手,效果反而惊人。

孩子的大脑,也如一个刚刚初始化的大模型,有极大的参数空间等待优化。与其告诉他人生道理,不如给他精选的样例,让他通过自己的探索得到答案。这就是认知心理学家和教育心理学家杰罗姆·布鲁纳在其经典著作《教育过程》中提出的范例教学,又称归纳式教学。

在数学教学中,教师给出一系列完整解题步骤的例题,学生通过分析示例主动理解数学概念和方法,而不是教师直接讲解抽象的数学公式;在语文教学中,教师让学生通过反复接触大量语言样例归纳语法规则,而非直接灌输语法规则。这种方法不仅能加深理解,还更易于将其迁移到新的问题或情境中。所以,孩子在成长过程中碰到的每一个难题,都不妨看作一次有意义的训练样例,父母无须立刻给出结论或答案,要让孩子自己去观察、体验、比较、反思,从中找到自己的道。放弃说教,“给予注意,学会陪伴”,这才是养育孩子的黄金法则。

成人也是如此。初等教育和高等教育赋予我们的道理如同预训练阶段的基础知识,它们在大脑中构建了认知的底层模型,却不足以直接指导我们应对真实复杂的生活场景。生活真正考验我们的是具体情境中的决策能力,而这种能力恰恰来自后续不断的微调和强化学习。例如,面对亲密关系中的冲突,书上说“要理解对方,包容不同观点”,但这样的抽象道理并不能让我们解决冲突;只有去倾听、去表达、去调节情绪,然后根据对方的反馈微调和优化我们“人际交往专家模块”的参数。所谓“纸上得来终觉浅,绝知此事要躬行”,这样,我们才不会陷入“懂得了很多道理,依旧过不好这一生”的局部最优陷阱。

▷图源:Denis Freitas

第三,注意也是遗忘。学习的本质,是对知识体系的优化。大模型像一个捡破烂的拾荒者,无差别地记忆所有接触的信息。而人超越大模型的,是其所独有的“选择性遗忘”:有意识地强化对重要知识和场景的记忆,同时主动遗忘那些低效甚至有害的信息。所以,积极的遗忘并非失败,而是一种认知优化的策略,它可以让宝贵的注意力聚焦于那些真正有价值的信息和故事。《洛丽塔》的作者弗拉基米尔·纳博科夫说:“你所领悟的人生真理,皆是你曾付出代价的往事。”

在学习过程中,选择性遗忘就是“先做加法,再做减法”的思维模式。为策划一个项目,我们会收集大量的信息,做大量的调研,努力将各种可能性都纳入考虑范围。这是必要的第一步,即先做加法。越接近决策阶段,就越需要精准地做减法,选择性遗忘。比如,关于一款新产品,我们最初想法无数:既要满足市场需求,又要成本可控;既要功能强大,又要操作简单;既想满足年轻人的需求,又不愿放弃中年人市场。但是,真正的产品设计者,要敢于主动“遗忘”那些充满吸引力但干扰产品核心定位的冗余信息,从而将注意力分配给真正的核心。著名设计师迪特·拉姆斯曾说:“好的设计不是堆砌更多的功能,而是敢于删去多余的东西。”遗忘,也是注意力分配的艺术。

生活中,我们有时会情绪低落,这可能是因为过去一些不愉快的经历:或许是一次失败的考试,一次刻骨铭心的分手,甚至是朋友无意中的伤害。这些不愉快持续侵占和消耗着我们的注意力,不断地唤起痛苦的记忆,让我们陷入“身在当下,心在过去”的困境而无法自拔。选择性遗忘不是强迫忘记这些不愉快,或者逃避甚至否认它们曾经发生。

选择性遗忘是承认,是接纳——承认它们确实已经发生,无法更改,接纳它们曾给自己带来的伤害。但是需要明白的是,它们并不必然定义我们现在以及未来的人生。心理学家卡尔·荣格说:“我们无法改变过去的事实,但我们可以改变看待这些事实的态度。”只有当我们真正接纳了这些痛苦的经历,允许自己放下情绪上的执着与执念,过去的负面经历才会与我们握手言和,逐渐淡去;唯有这样,注意力才会回归当下,回归我们能掌控的事情上。于是,我们重获内心的平静与自由。

遗忘,既是告别,也是起航。

小结:非共识的AI时代

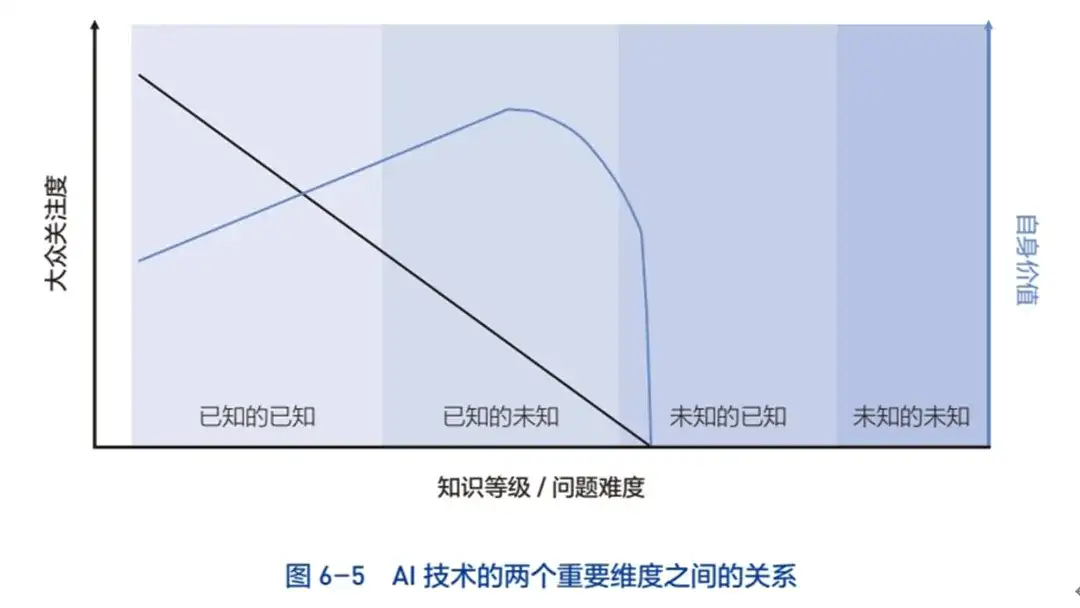

AI有两个重要维度:大众关注度和自身价值。二者之间的关系如图6-5所示。

图中黑色线条展现的是随着知识深度的增加或问题难度的提高,大众对AI技术的关注度直线下降,即AI在浅层知识领域中的应用更容易成为流行热点,如ChatGPT撰写一篇文章,Midjourney(智能绘图软件)创作一张艺术图片,Suno(AI音乐生成器)创作一首歌曲。当AI进入中层知识领域,如AlphaFold预测蛋白质结构,大众关注度明显下降,即使 AlphaFold为治疗疾病开辟了新纪元。当AI进入高度抽象或极端专业领域,如高阶数学定理证明或量子计算优化,此时大众的关注度降至冰点。因此,黑色线条展现了一条社会认知铁律:大众兴趣集中在容易理解和感知的浅层知识领域。

图中蓝色线条代表的是AI的内在价值。它与知识的关系并非线性,而是呈现先升后降的趋势:在浅层知识领域,AI能做的事,人也能做,因此AI的价值有限;在中层知识领域,AI 展现出强大的技术优势,AI有而人难有,AI的价值因此达到顶峰;在深度知识领域,知识的难度或问题的抽象度超过一定阈值,AI无法胜任,于是其价值迅速衰减。

如果把人类的知识按照“已知”和“未知”分为四类并放入图6-5,我们就可以洞悉AI与人类的关系。

图的最左侧是“已知的已知”(known known),是指人类已经广泛掌握并系统整理和公开的知识领域,如物理定律、数学公式、已发表的科学论文、常规医学指南等。这个区域的知识完全公开透明,AI能够非常轻松地处理此类知识,因为它擅长的就是模式识别和大规模计算。例如,AlphaGo战胜人类,靠的就是已知的技巧和公开的棋谱。

紧接这个区域的是“已知的未知”(known unknown),是指人类已经清楚地定义了存在的问题,并取得了成功范例,但尚未获得完全解答的领域。它有以下三个特点:

1.这个问题是一个根节点问题(root node problem),解决了这个问题,将引发这个领域的革命性突破。

2.有海量的与这个问题高度相关的高质量数据。

3.人类方法非常有限,力不从心。AI依靠强大的算力和先进的算法,借助海量的数据和实验模拟能快速逼近答案,展现了AI 最强大、最有价值的一面。

蛋白质折叠预测就是这样一个问题。首先,它是生命科学领域的一个根节点问题,因为蛋白质结构决定其功能,直接影响到所有生命活动和疾病机理。因此,准确预测蛋白质三维结构,将直接推动新药研发和疾病治疗。其次,这个领域拥有大量与问题高度相关的高质量数据。过去数十年来,全球科学家通过X射线晶体衍射、核磁共振和冷冻电镜等方法积累了大量经过实验验证的高质量蛋白质结构数据,如蛋白质数据库。最后,人类方法在蛋白质折叠预测的问题上,效果非常有限——实验方法昂贵、耗时且成功率低。AlphaFold正是切入了这个科学痛点,依靠深度学习的注意力机制,深入分析数据中蛋白质氨基酸序列与空间结构之间的复杂关联,在短短一年时间里,预测了超过2亿个蛋白质结构,几乎覆盖了所有已知蛋白质序列,相当于人类数十年来实验测定蛋白质结构数量总和的数千倍。

“已知的已知”和“已知的未知”都已经或者即将被 AI占据,但是“已知的未知”才是AI的“最优区间”,因为人类在“已知的已知”领域做得也不错,AI的作用仅是锦上添花,如自动驾驶。所以,“已知的未知”领域是创业和投资的“黄金点”,类似的还有药物设计与发现、材料科学的高效设计与发现、气候变化和环境问题的精细建模、脑连接组与神经元活动规律解码等。但它也是这个领域的学生和从业者的噩梦,因为 AI最先取代的,就是这个领域的所有行业。AI 过处,寸草不生。

第三类是一个独特且微妙的知识类别:“较少被了解的已知/未知的已知”(less known / unknown known)。较少被了解的已知是指知识存在,但尚未被广泛传播,公众认知度极低,如小众学科的专有技术、特定文化背景下的独特经验以及个人原创但并未广泛传播的领悟或思想;未知的已知是指知识掌握在特定个体或组织手中,但从未公开。例如,企业拥有未公开的市场数据与内部研究成果,个人的职业直觉、创新创意、情感体验等难以量化的主观经验等。

这个领域的知识有两个特点:从人类社会的角度看,就是“稀缺”,通常需要高价或者非正常手段才能获取;从大模型的角度看,就是“缺失”,即AI的知识体系在这一领域是空白,因此无法直接模仿或“思考”。所以,这个领域的知识,是人类在认知维度上拥有的核心优势。

图的最右侧是“未知的未知”(unknown unknown),是指人类目前甚至无法明确意识到的问题和领域。由于没有明确的方向,没有定义清楚的问题,更没有数据,AI无能为力,只能有待人类自身产生颠覆性的认知突破。

显然,“已知的已知”已经被AI统治——在这个领域,人已经不可能和AI一较高下。所幸的是,人类在这个领域干得还不错而且有极高的社会关注度,因此在“以人为中心”的伦理和政策的保护下,AI大概率会成为助手,而非替代,由此避免人类的大规模失业所导致的社会问题。而“已知的未知”正在或即将被AI占领,因为人类笨拙的表现和较低的社会关注,人类终将彻底让渡整个领域。

因此,在AI时代,人类与AI的角力聚焦在“未知的已知”这个知识领域。AI学习和推理需要大量的公开数据,而这个领域的知识本质上处于半封闭或完全封闭状态,使得AI难以有效获取并学习。因此,为保证人类的竞争优势,一个直接且简单的策略就是有意识地调整知识的管理和传播策略:个人、企业与科研机构应更谨慎地处理知识传播,战略性地保留关键数据与技术,避免完全公开。

▷图源:Denis Freitasv

但是,这种有意识地制造和维护信息不对称的策略,从根本上与人类自启蒙时代以来所追求的知识普及化、标准化与共识化背道而驰。我们不禁要问:为了确保人类的独特性和独立性,是否值得放弃使文明不断加速的、让知识价值最大化的公开和共享?这种类似中世纪的、让关键知识掌控在少数人手里的被动防守策略是否真的能有效限制AI?

其实,进攻才是最有效的防守。这里的进攻,就是创造。过去,人类的价值更多地体现在知识储备和技能的运用上;但人类真正的独特性,不在于简单的模仿与记忆,更不在于对知识的垄断或封闭,而在于每个人拥有的独特认知与生成式发明的能力。正是这种独特性,使人类在中世纪打破神学统治下僵化的认知模式,实现了思想、科学、艺术的全面复兴,重新解放了个体的理性与创造力。

文艺复兴,首先是达·芬奇、米开朗琪罗等艺术家通过作品凸显出个体的人体美与人性光辉,使人类对自身的理解变得更加丰富和深刻,由此带来了对人文主义的推崇,摆脱了过去神学统治的人性压抑。其次,以哥白尼、伽利略、开普勒为代表的科学家打破了教会权威对知识的垄断,唤醒了大众对科学精神的追求和理性思考。最后,印刷术的普及使古希腊、古罗马的经典著作得以广泛流传,形成了思想碰撞的良性循环。

因此,文艺复兴并非单纯的艺术与文学复兴,而是一次全面而深刻的思想革命。它释放了人类长久以来被压抑的创造力,使人类文明从神学的束缚中解脱出来,走上科学探索、个性解放与人文精神的道路。这种深刻的思想变革,正是人类文明实现巨大跃迁的根本原因。

在AI时代之前,人类习惯了自工业革命以来标准化的教育模式,并满足于扮演知识的存储者和技能的使用者角色。但在AI时代,人类必须完成从知识的“存储者”向知识的“创造者”的范式转变。因为AI可以复制、模仿甚至优化已有的知识与方法,但真正开辟新范式、新视野、新概念,却始终依赖人类独特的感性体验、直觉判断与深刻的同理心。

例如,在艺术创作中AI能够模仿风格,却无法真正感受创作者的个人情感经历和历史背景,因此人类原创的艺术作品永远拥有独特的价值;在科学探索中,尽管AI能高效计算模拟,但真正“从0到1”的突破性灵感往往来自人类直觉的非理性跃迁,这种直觉恰恰是AI难以模拟的;在决策制定中,AI虽然能给出基于大数据的参考建议,但对于诸如政策决策中的社会公平与道德权衡等复杂、模糊的伦理或价值判断仍要依赖于人类自身的直觉、经验与伦理共鸣。

因此,AI时代并非人类的衰落时代,而是人类认知方式和知识战略的深刻转型时代。人类不再单纯追求知识的标准化、共识化,而是通过创造力拓展“未知的已知”这个“非共识”知识领域的广度与深度,并勇于探索“未知的未知”,重新构建人类自身的独特优势与核心价值。

因此,“非共识”成为AI时代的核心关键词。它重新定义了人类的价值,意味着教育、职场甚至整个社会价值观的转型。例如,我们必须重新审视教育的目标,将教育重心从记忆和标准化测验转向培养“非共识”的创新思维、批判性思维与跨学科融合能力。只有人类才具备这种真正的创造性、超越认知边界的想象力。同时,社会层面要加强对“非共识”人才的认可和激励,鼓励差异化、个性化发展。正如哲学家尼采所言:“每一个不曾起舞的日子,都是对生命的辜负。”在人类与AI共舞的时代,人类只有以积极创造的姿态起舞,才能超越固有认知边界,彰显生命与文明的意义。

因此,AI进入日常生活与工作,既是挑战,更是前所未有的机遇。只有真正理解并拥抱这一趋势,人类才能重新激发并珍视自身独特的认知优势,不仅能在AI的冲击中安然无恙,更能以此为契机,实现认知与社会价值的飞跃。所以,AI并不会取代人类,而是驱使人类更深刻地重新定义自身的认知优势——未来,谁能够更有效地创造和掌握“非共识”知识体系,谁就能在AI时代掌控主动权。

或许,这才是AI真正馈赠给人类的礼物。

文章来自公众号“追问nextquestion”,作者“刘嘉”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】suno-api是一个使用监听技术实现了调用suno功能,并封装好API的AI音乐项目。

项目地址:https://github.com/gcui-art/suno-api

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0