春节回家我用递归学习法,跟大模型学会了「算八字」

春节回家我用递归学习法,跟大模型学会了「算八字」上个月,我在 X 上刷到一个叫 Gabriel 的年轻人的故事。他从大学辍学,用 AI 自学人工智能,最终成为了 OpenAI 的研究员。真正吸引我的,是他在个人博客里分享的一套学习方法:「递归学习法」。

上个月,我在 X 上刷到一个叫 Gabriel 的年轻人的故事。他从大学辍学,用 AI 自学人工智能,最终成为了 OpenAI 的研究员。真正吸引我的,是他在个人博客里分享的一套学习方法:「递归学习法」。

今天,美国大模型独角兽Anthropic连续发布多则推文、博客,指控DeepSeek、月之暗面和MiniMax三家中国AI实验室,正对Claude进行“工业级规模的蒸馏攻击”。

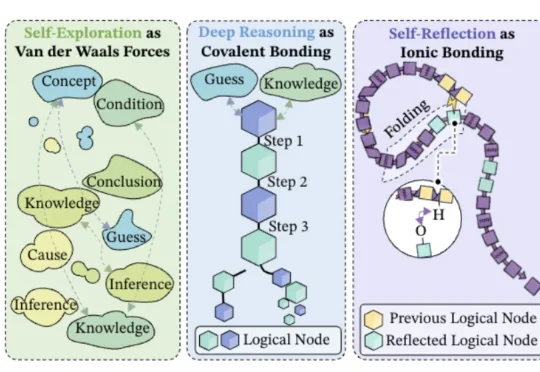

字节Seed都开始用化学思想搞大模型了——深度推理是共价键、自我反思是氢键、自我探索是范德华力?!

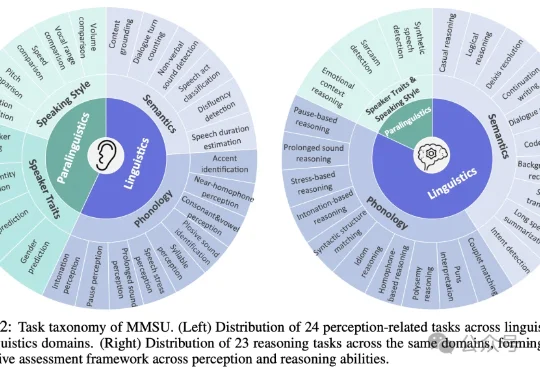

随着多模态大模型能力不断扩展,语音大模型(SpeechLLMs) 已从语音识别走向复杂语音交互。然而,当模型逐渐进入真实口语交互场景,一个更基础的问题浮现出来:我们是否真正定义清楚了「语音理解」的能力边界?

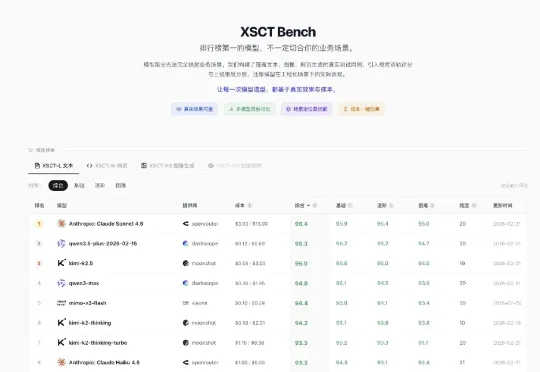

春节闭关五天,我做了个东西:一个大模型场景化测评平台。35000+ 次模型跑测,一共 42+ 模型,11,000 块人民币。我全部跑完了,结论汇成一个平台,还会持续更新。

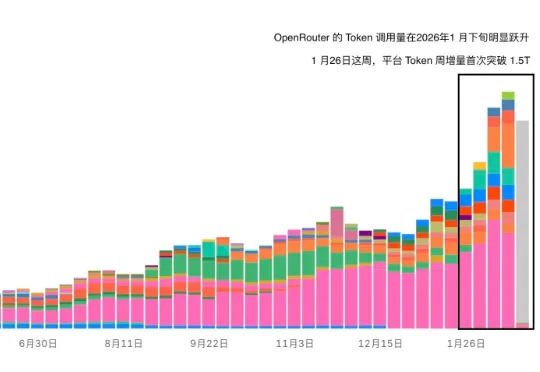

作为目前全球最主要的大模型 API 聚合网关之一,OpenRouter 的 Token 调用量在 2026 年 1 月下旬出现了明显跃升。自 1 月 26 日当周开始,平台 Token 周增量首次突破 1.5T,这一幅度在过去的调用曲线中并不常见。时间点同样值得玩味——这一轮增长几乎与 OpenClaw 的迅速传播高度重合。人们开始发现,OpenClaw 简直就是 Token 碎纸机。

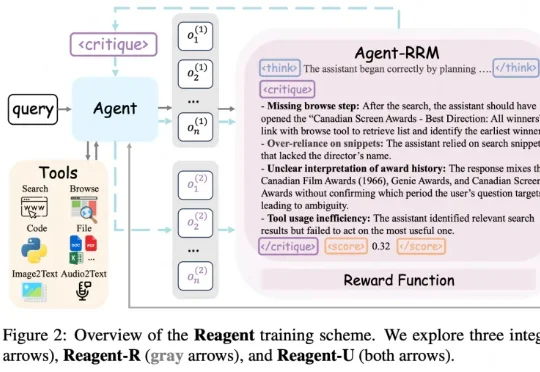

在很多大模型和 Agent 的训练里,最常见的一种做法就是只看结果:最后答案对了就给奖励,错了就当 0 分。 在单轮问答里,这样「只看结果」还勉强能用;可一旦换成 Agent 这种要多轮对话、搜索、刷

1970年,一个叫Gordon Gallup的心理学家把一面镜子放进了黑猩猩的笼子里。黑猩猩一开始对着镜子龇牙。它以为那是另一只黑猩猩。它威胁它,拍胸脯,绕到镜子后面找那只不存在的敌人。

近日,微软Bing Ads与DKI团队发表论文《AdNanny: One Reasoning LLM for All Offline Ads Recommendation Tasks》,宣布基于DeepSeek-R1 671B打造了统一的离线推理中枢AdNanny,用单一模型承载所有离线任务。这标志着从维护一系列任务特定模型,转向部署一个统一的、推理中心化的基础模型,从

千问 3.5 总参数量仅 3970 亿,激活参数更是只有 170 亿,不到上一代万亿参数模型 Qwen3-Max 的四分之一,性能大幅提升、还顺带实现了原生多模态能力的代际跃迁。